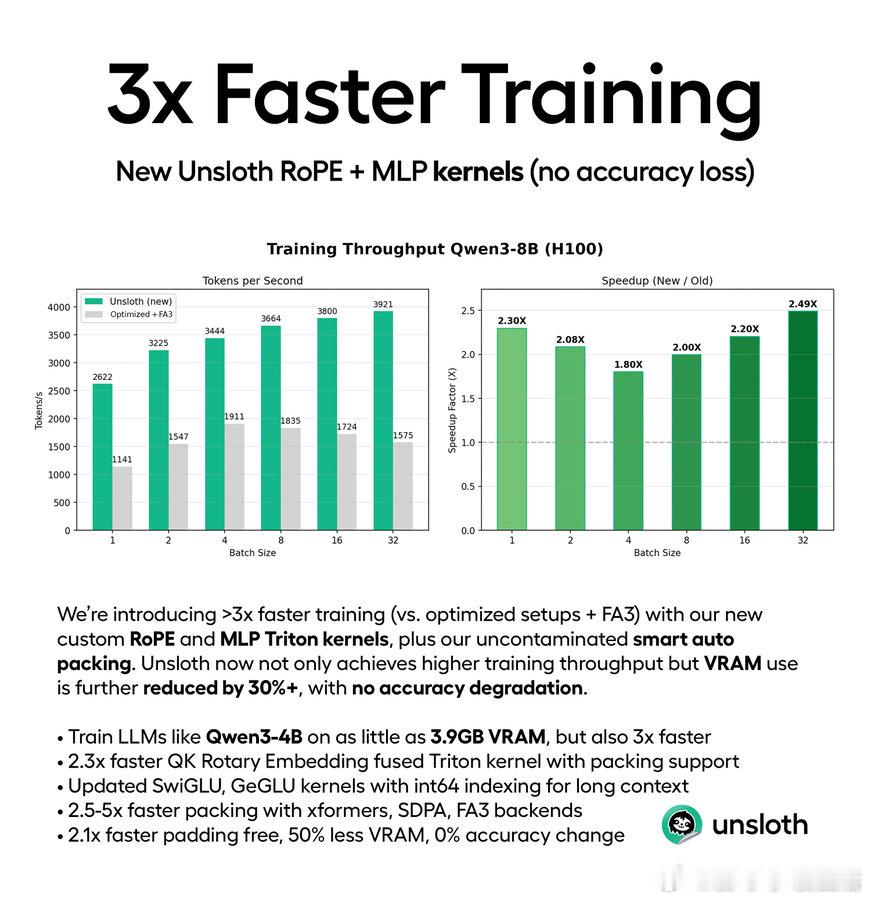

Unsloth AI 推出新型 RoPE 和 MLP 核,实现大语言模型训练速度提升3倍,且无精度损失。通过 Triton 内核和智能自动打包技术,训练效率大幅提升,同时显著降低30%显存占用。以 Qwen3-4B 为例,仅需3.9GB显存就能完成3倍加速训练,极大降低了硬件门槛。这意味着,用户可以用更低成本、更短时间完成模型微调和强化学习,助力开源生态快速发展。Unsloth AI 还提供100多个免费笔记本,支持本地运行多种开源模型(如Llama、OpenAI gpt-oss、TTS等),极大方便了开发者和研究者。针对初学者,推荐从 Llama-3.1-8B (instruct) 入手,使用至少100条问答对进行微调,配合官方指南,涵盖用例选择、数据集准备、模型部署等全流程,降低学习门槛。社区反馈热烈,有人称赞速度突破惊人,有专家质疑为何不直接用更大上下文窗口硬提示,还有人关心能效表现及非语言模型的应用潜力。整体来看,这套方案不仅提高效率,更推动了AI民主化,让更多人能轻松参与大模型训练。关键启示:优化底层核算与数据打包,才能真正释放硬件潜能,缩短训练时间,降低成本,从而激发更广泛的创新和应用。未来AI发展,效率与可及性同样重要。docs.unsloth.ai/new/3x-faster-training-packing这不仅是技术突破,更是推动AI普惠的重要一步。让我们期待更多类似的创新,真正实现人人可参与、人人可用的大模型时代。