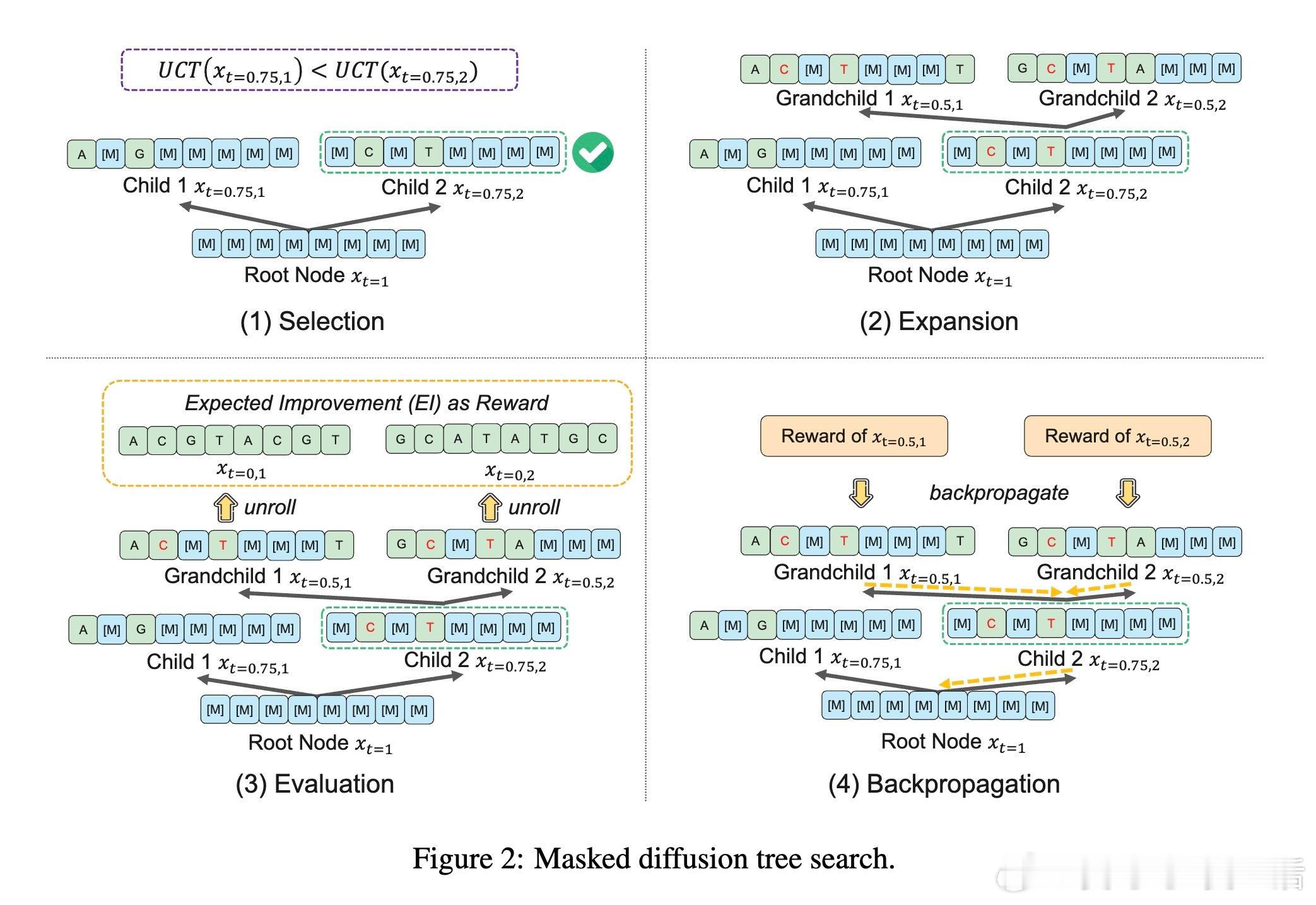

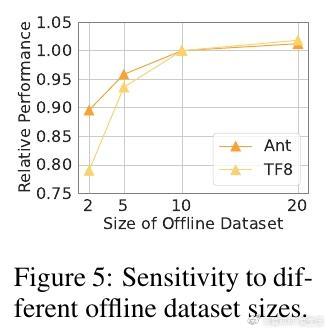

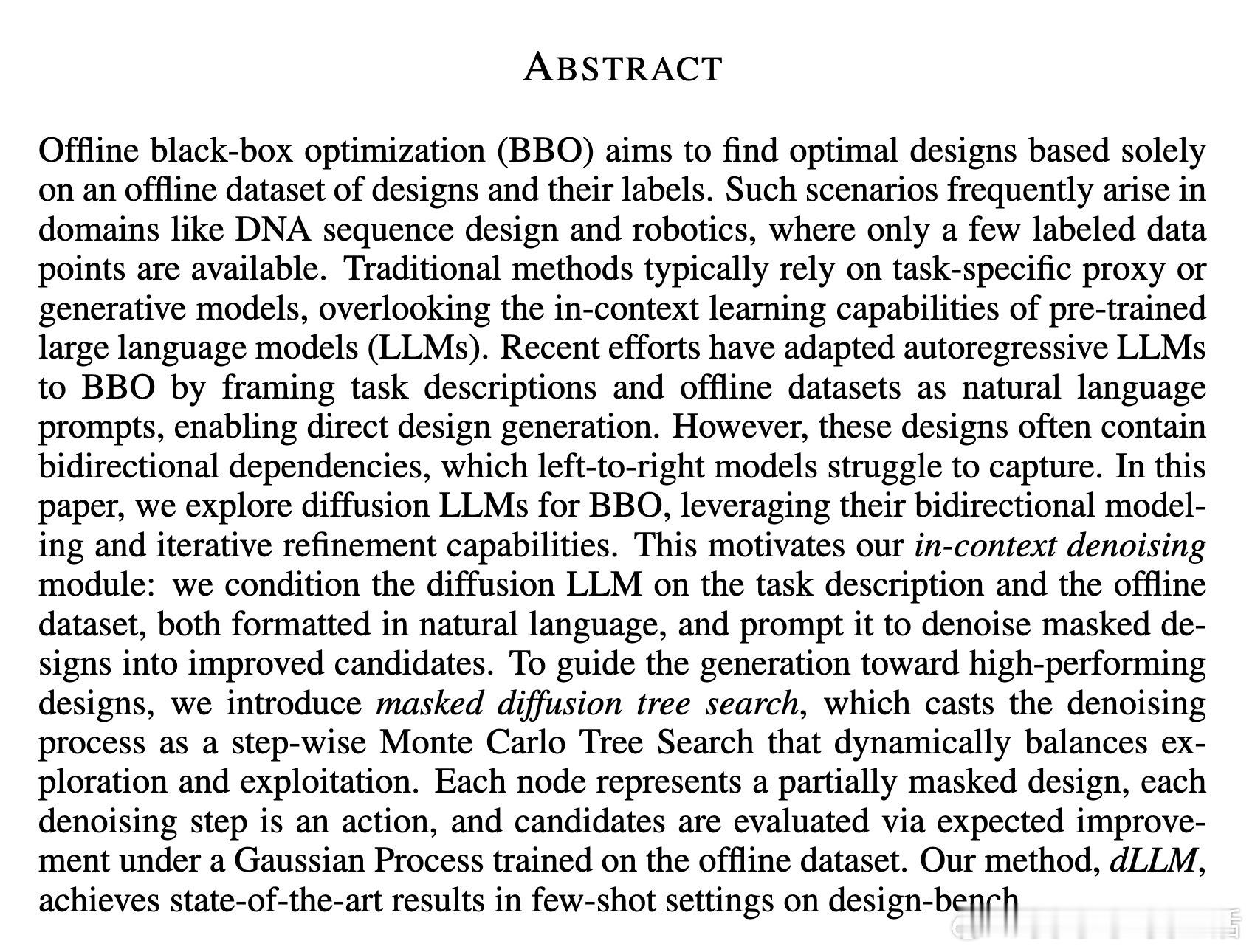

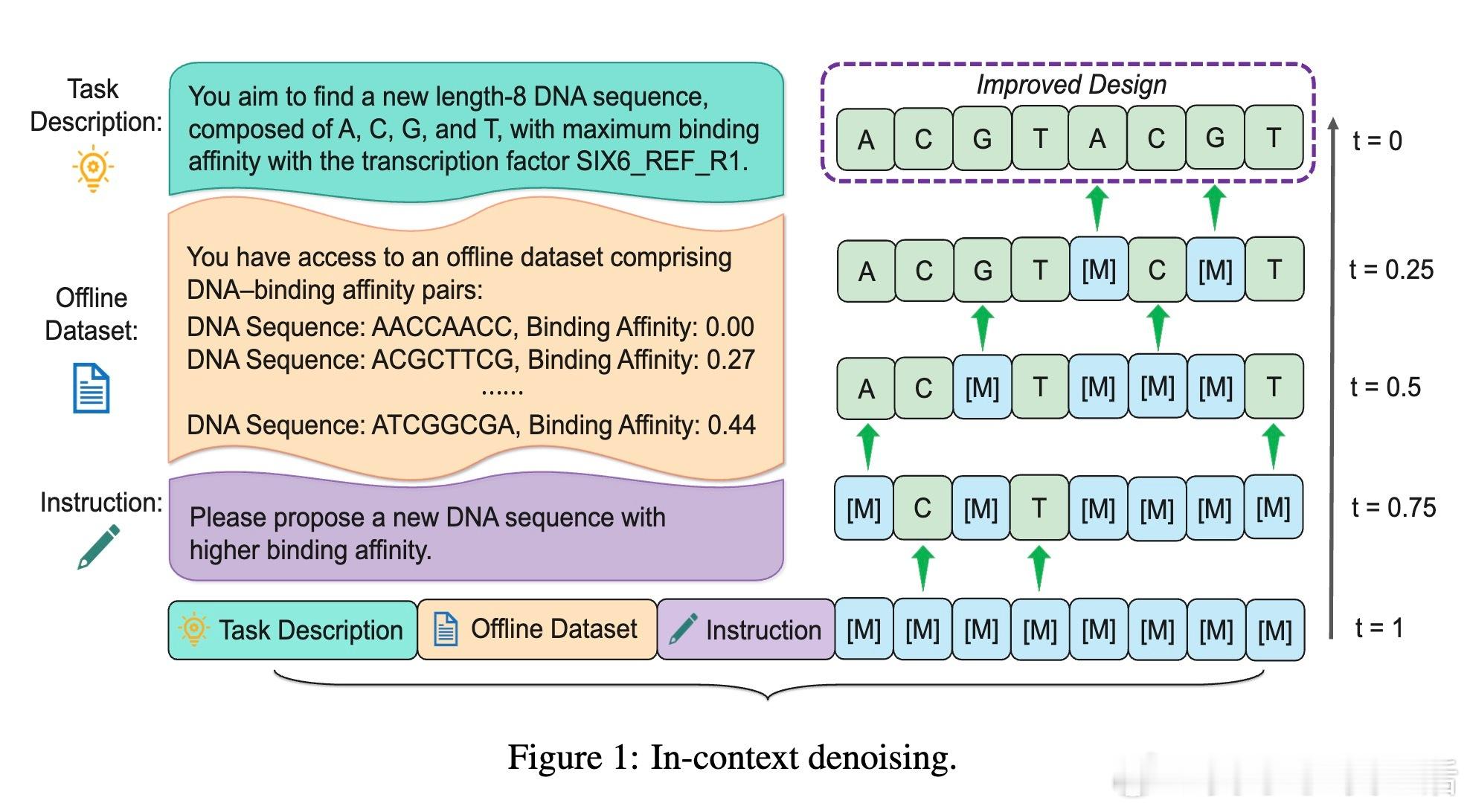

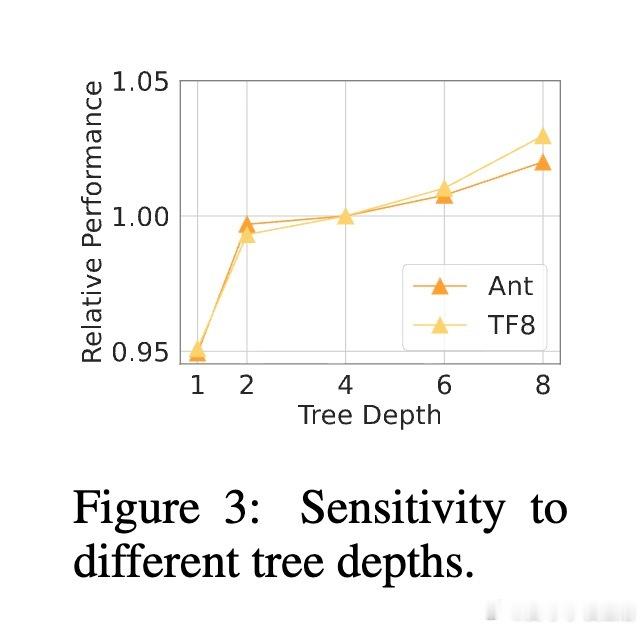

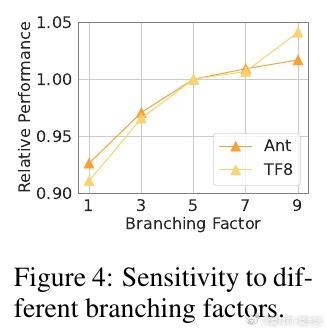

[LG]《Diffusion Large Language Models for Black-Box Optimization》Y Yuan, C (Sam)Chen, Z Sun, D Zhang... [McGill & MILA - Quebec AI Institute] (2026) 这篇研究揭示了扩散大语言模型(Diffusion LLMs)在黑盒优化(BBO)领域的巨大潜力。以下是核心研究成果的深度整理:在DNA序列设计、机器人形态优化等领域,我们往往面临离线黑盒优化的难题:只有少量已知的实验数据,且无法进行实时在线评估。传统的自回归模型(如GPT系列)在处理这类任务时存在天然短板,因为设计任务(如DNA序列)往往具有双向依赖性,即序列中间的某个单元不仅受前文影响,也受后文制约。针对这一痛点,本文提出了dLLM方法,将扩散大语言模型引入BBO领域。核心机制与深度洞察1. 从自回归到双向建模传统的左到右生成方式难以捕捉复杂设计空间中的全局依赖。扩散模型通过迭代去噪的过程,能够同时考虑序列的上下文信息。这种双向建模能力让模型在处理高维、复杂的优化任务时更加游刃有余。2. 提示词驱动的上下文去噪dLLM并不需要对模型进行昂贵的微调。它巧妙地利用了预训练模型的上下文学习能力,将任务描述、离线数据集和优化指令封装在自然语言提示词中。模型通过观察已有的设计案例及其评分,学习如何将一个全掩码或部分掩码的设计方案,逐步精炼为更高性能的候选方案。3. 掩码扩散树搜索(MDTS)这是本研究的神来之笔。单纯的去噪可能缺乏方向感,研究者引入了蒙特卡洛树搜索(MCTS)来引导生成过程。- 选择:利用UCT算法在探索新方案与利用已知好方案之间取得平衡。- 扩展:利用扩散模型生成多样化的子节点。- 评估:引入高斯过程(GP)作为代理模型,通过预期改进(EI)准则为每个候选方案打分。- 回传:将奖励信号反馈至搜索树,动态优化后续的搜索路径。实验结论与启发在Design-Bench基准测试中,dLLM在Ant/D’Kitty机器人形态优化以及TF8/TF10 DNA序列设计任务上均取得了SOTA性能。深度思考:- 规模化的新维度:除了增加模型参数,dLLM展示了通过增加推理时计算(增加树深度或分支因子)也能显著提升优化性能。- 语义引导的力量:实验证明,明确的任务描述能显著提升生成质量。这说明大模型不仅是在做数值拟合,更在利用其预训练阶段积累的跨领域常识来辅助设计。dLLM的成功标志着大语言模型正从单纯的文本生成器进化为通用的科学优化器。在数据稀缺的科研场景下,这种结合了扩散模型双向建模与树搜索启发式探索的方法,为药物发现和工程设计开辟了新路径。arxiv.org/abs/2601.14446