[LG]《A Theory of Universal Agnostic Learning》S Hanneke, S Moran [Purdue University & Technion and Google Research] (2026)

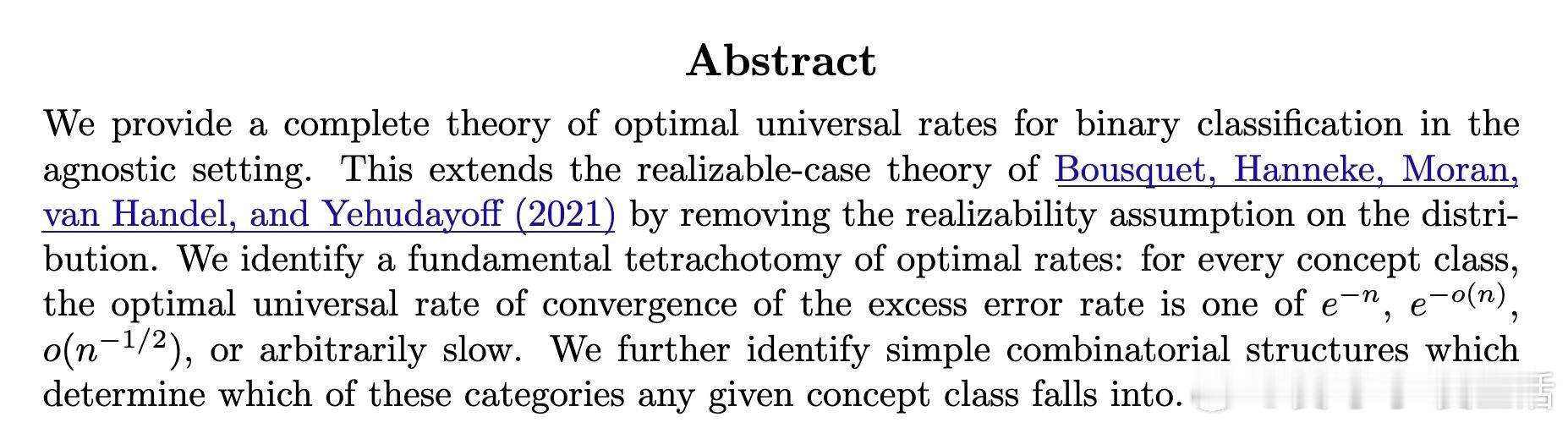

机器学习的终极目标,是让算法在面对任何未知的分布时,都能以尽可能快的速度收敛。长期以来,统计学习理论主要聚焦于一致收敛率,即在最坏情况下的表现。本文将这一视角推向了更深层的普适性。

这篇论文构建了一套完备的普适不可知学习理论。它不仅打破了传统理论的局限,更揭示了学习速度与假设空间复杂度之间隐藏的四重奏关系。

1. 从二分法到四分法的进化

在经典的VC理论中,学习速度往往呈现出一种简单的二分法:要么以n的负二分之一次方速度收敛,要么根本无法学习。但在普适学习的视角下,当我们关注每一个具体的分布而非仅仅是最坏情况时,这种二分法被一种更精细的四分法所取代。

统计学习不应只是关于最坏情况的防御,更应是关于具体现实的洞察。研究发现,任何概念类的最优普适收敛率必然属于以下四类之一:指数级、近指数级、超根号级,或者极其缓慢。

2. 决定命运的组合结构

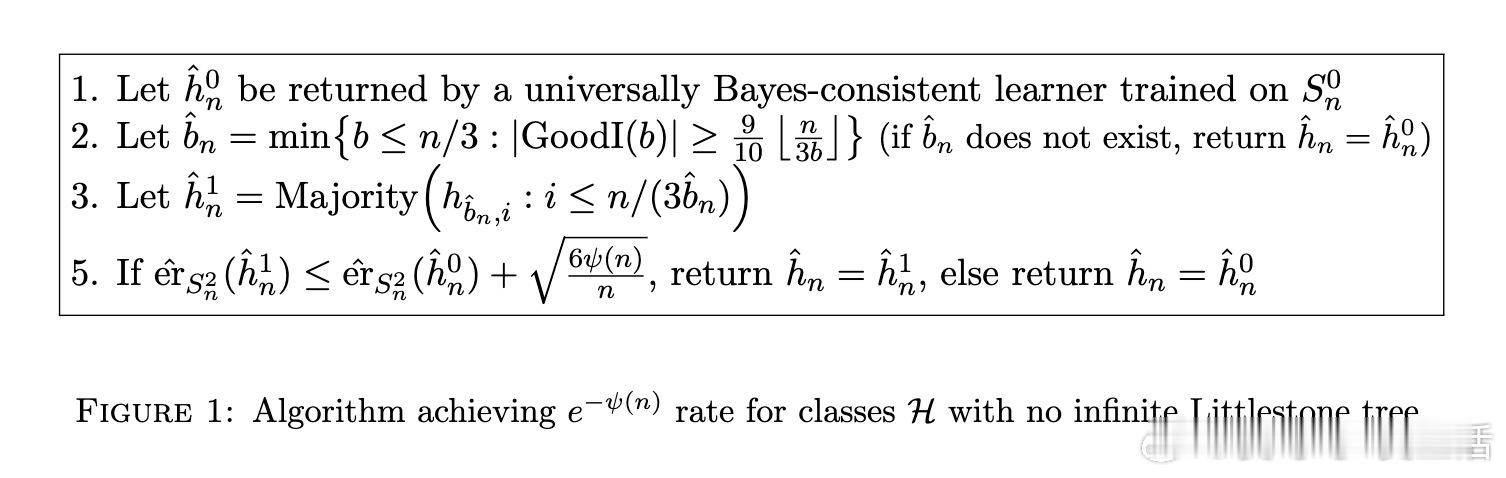

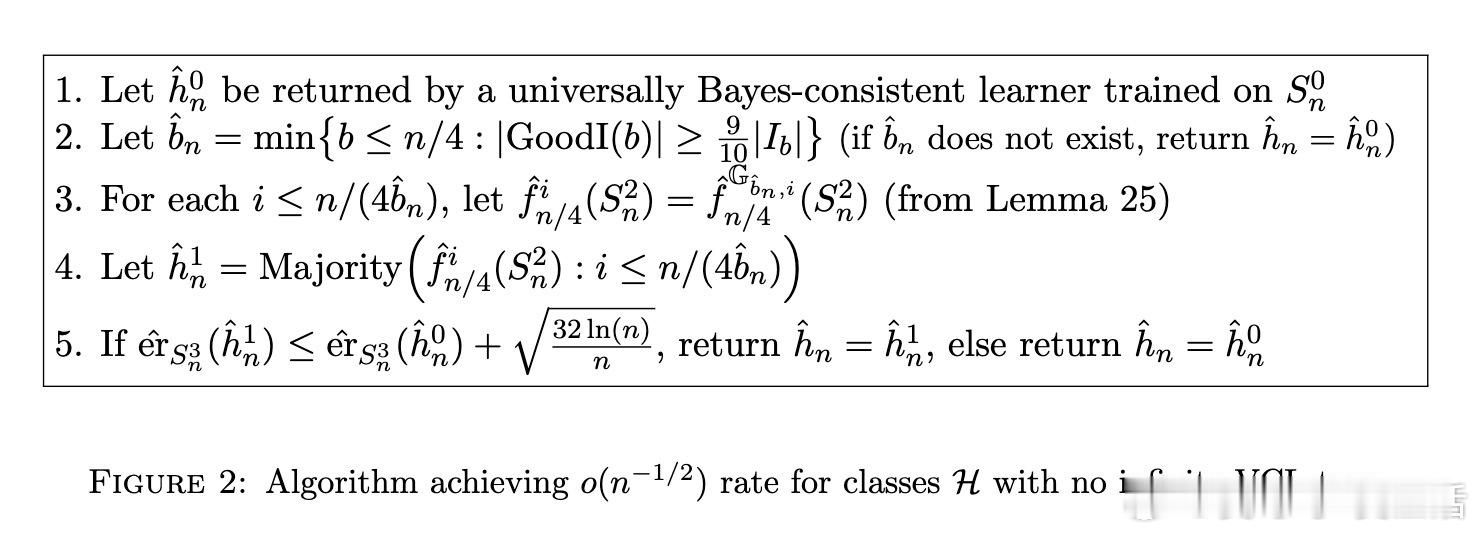

学习速度并非偶然,它是由假设空间的内在几何结构决定的。论文通过引入Littlestone树和VCL树等组合结构,精确划定了这四类收敛率的界限。

有限的概念类可以达到指数级收敛。不包含无限Littlestone树的概念类,其收敛率呈现近指数级。包含无限Littlestone树但不包含无限VCL树的概念类,收敛速度快于根号n分之一。一旦包含无限VCL树,学习速度将变得不可控地缓慢。

结构的简洁决定了认知的上限。这一发现将抽象的组合数学与具体的算法性能直接挂钩。

3. 跨越不可知学习的鸿沟

此前的研究大多基于可实现假设,即认为数据分布中存在一个完美的分类器。然而现实世界往往是嘈杂且不完美的。这篇论文最大的贡献在于,它去除了可实现性假设,在不可知学习的框架下重新定义了最优速率。

真正的智能,是在不完美的数据中依然能找到最优的收敛路径。作者通过博弈论中的Gale-Stewart游戏策略,设计出了能够自动适应数据复杂度的学习算法,证明了即使在没有先验分布知识的情况下,我们依然可以逼近理论上的最优性能。

4. 深度思考与启发

这项研究不仅是数学上的胜利,更是对学习本质的一次深刻反思。它告诉我们,学习的难度并不完全取决于数据量的多少,而取决于我们试图理解的对象在多大程度上允许被简化。

当我们在设计AI系统时,如果能识别出假设空间的这些关键特征,就能预判其在特定任务中的收敛潜力。这为算法优化提供了一套全新的坐标系,让我们从盲目的参数调整转向对模型结构的本质理解。

论文链接:arxiv.org/abs/2601.20961