作者|贾桂鹏

一直以来,创作3D内容是设计和开发视频游戏、增强现实、虚拟现实以及影视特效中最重要的部分。然而,3D生成具有独特而艰巨的挑战,这是图像和视频等其他生成内容所不具备的。

不过,在生成式AI爆发的当下,很多研究者开始尝试针对以上问题提出解决方案。日前,Meta发布了最新系统Meta 3D Gen (3DGen),其用不到一分钟的时间,就能直接从文本生成3D资产。

关于AI在3D创作技术的突破会不会加速这个行业的变革呢?或者说AI是不是又颠覆了一个行业?

3D内容行业的颠覆

当下,3D内容生产面临的最大难点是成本居高不下,据权威3D数据平台公司Sketchfab数据,3D模型成本在数百美元到数千美元间,生产所需时长从数小时到数天不等。不同的模型、不同的精细度、不同的生产方法,价格和生产时间均不一样。

围绕着3D内容生产技术,其中3D引擎和3D内容创作工具更是视为蓝海中的明珠。更具生产力、更低使用门槛的3D引擎和创作工具也成了广泛关注的焦点。面对全球数十万亿级3D内容市场,以及面临的技术、商业、成本难题,谁掌握了精度高、效率快、成本低的3D内容生产技术,谁就掌握了未来数字世界的生产能力。

而且,3D生成是一个非常耗费算力的过程,主要因为它涉及复杂的计算和大量的数据处理,如实时渲染、细节处理。并且由于算力不够,可能会导致生成速度非常慢。

另外,传统方法生成的3D资源通常难以实现逼真的照明和材质属性,从而限制了它们在专业工作流程中的实用性,

如果用户能够非常方便且高效地创造3D素材,至少将能大大改善VR内容缺乏的问题。如果素材的质量再能得到进一步的提高,生成的虚拟现实世界真的能够达到以假乱真的地步。

面对3D内容方面的发展壁垒,Meta发布了其最新的AI模型——Meta 3D Gen(3DGen),可在1分钟内生成高质量3D素材。

据Meta方面介绍,3DGen能够在不到1分钟的时间,根据文本提示词快速生成具有高分辨率纹理和材质贴图的3D内容。此外,它还能在同一3D形状的基础上调整纹理贴图,帮助创作者实现快速迭代。技术报告中称,专业3D艺术家在大多数类别中对该工具的评分都好于竞争对手,特别是对于复杂的请求。Meta表示,它的速度是同类系统的3到60倍。

科技旋涡认为,3DGen在更多场景的广泛应用将大幅提升相关专业人士的工作效率与创作质量,并将推动3D内容创作和应用领域的进一步发展。

Meta 3D Gen如何实现

Meta 3D Gen支持基于物理的渲染 (PBR),这是在实际应用中重新照明 3D 资产所必需的。此外,3DGen 还支持使用用户提供的额外文本输入对先前生成的(或艺术家创建的)3D 形状进行重新纹理化。

那么,3D Gen的运行原理是什么呢?

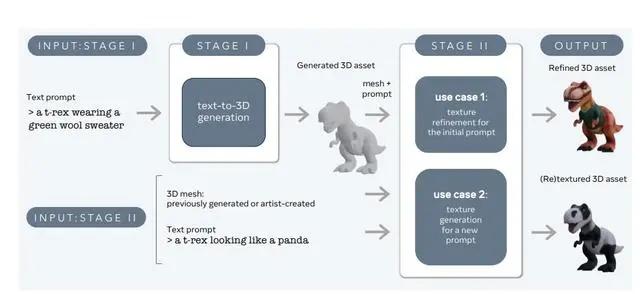

其实,Meta 3D Gen是一个两阶段的3D资产生成方法,它通过结合Meta 3D AssetGen和Meta 3D TextureGen两个关键组件,能够高效地创建具有高分辨率纹理和PBR材质的3D资产,其速度比现有解决方案快3至10倍。

其实现方法包括一个用于创建3D网格的组件(AssetGen)和一个用于生成纹理的组件(TextureGen)。

第一阶段在用户提示下创建初始3D资产,推理时间约为30秒。第二阶段基于第一阶段生成的资产和初始文本提示,生成更高质量的纹理和PBR贴图,推理时间约为20秒。第二阶段还可以从头开始为无纹理的3D网格生成纹理,推理时间约为20秒,但视觉效果通常更逼真。

而且,3DGen以AssetGen和TextureGen为基础,将3D对象的三个关键信息进行了很好的互补:视图空间(对象的图像)、体积空间(3D形状和外观)和UV空间(纹理)。

此过程从AssetGen开始,通过使用一个多视角和多通道的文本到图像生成器,生成关于物体的几个相对一致的视图。

接下来,AssetGen中的一个重建网络会在体积空间中提取出3D对象的第一个版本。此过程接着进行网格提取,建立对象的3D形状和其纹理的初步版本,这一系列步骤构成了从文本描述到3D模型的转换过程。

最终,TextureGen 件利用视图空间和UV空间生成的组合来重新生成纹理,提高纹理质量和分辨率,同时保持对初始图像的保真度。

Meta的3D Gen的潜在应用是巨大的。游戏开发人员可以用3D Gen快速制作游戏环境和角色原型,建筑可视化公司则只需要文本描述,就能生成建筑物整体和内部的详细3D模型,简化设计流程。目前来看,3D Gen还处于一个比较初级的阶段,经过发展之后,我们相信它将会对行业造成更大的冲击力。

写在最后

科技旋涡认为,Meta的这种新技术为3D模型在不同光照环境下的真实感呈现提供了可能,在3D图形、动画、游戏和XR等领域中具有巨大潜力,对上述行业甚至产品开发都会有长足的帮助,未来在3D内容领域会不会全面部署AI来完成任务呢?我们拭目以待。