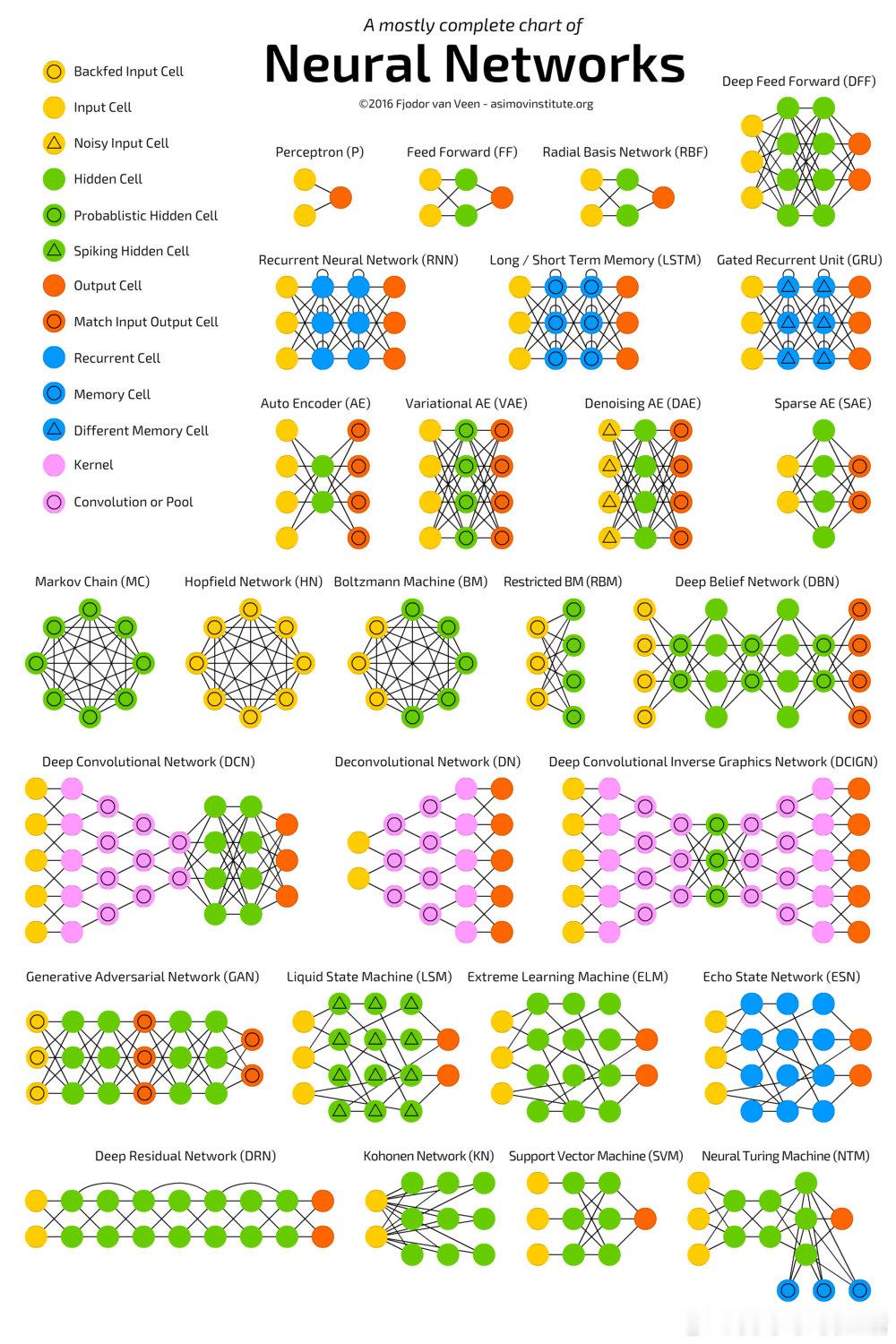

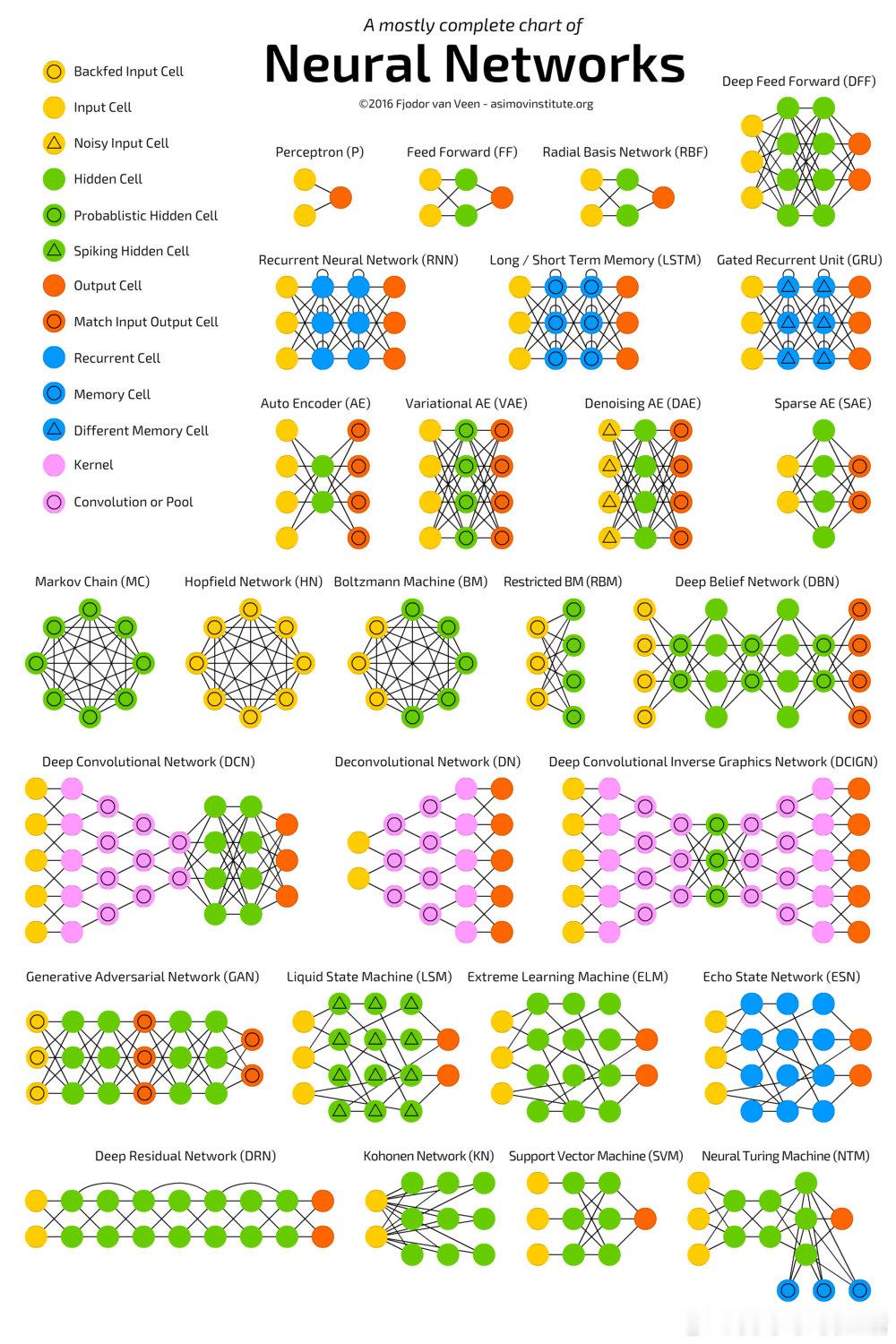

2016年的这张涵盖主要神经网络架构的综合图表,展示了从经典卷积网络到最新模型的发展脉络,虽然未包含2016年后兴起的Transformer结构,但依然是理解神经网络演变的绝佳起点。这份汇总不仅帮助我们理清各类网络的设计思路,也提醒我们“注意力机制”究竟为何如此重要——正如那句名言“Attention is all you need”。网络结构的多样性反映了AI领域持续探索的深度与广度,从卷积逆向图形网络到认知痛感调制的复杂神经结构,都昭示着未来研究的巨大潜力。

2016年的这张涵盖主要神经网络架构的综合图表,展示了从经典卷积网络到最新模型的发展脉络,虽然未包含2016年后兴起的Transformer结构,但依然是理解神经网络演变的绝佳起点。这份汇总不仅帮助我们理清各类网络的设计思路,也提醒我们“注意力机制”究竟为何如此重要——正如那句名言“Attention is all you need”。网络结构的多样性反映了AI领域持续探索的深度与广度,从卷积逆向图形网络到认知痛感调制的复杂神经结构,都昭示着未来研究的巨大潜力。

猜你喜欢

【2点赞】

【2评论】【22点赞】

【112评论】【44点赞】

【2点赞】

【66点赞】

【92评论】【102点赞】

【7评论】【49点赞】

作者最新文章

热门分类

科技TOP

科技最新文章