深入解析扩散模型本质,《Generative modelling in latent space》博客为理解扩散及潜变量生成提供系统框架:

• 现代生成模型多采用两阶段方法:先用自动编码器提取紧凑的潜变量(latents),再在潜空间进行生成,极大提升效率。

• 潜变量非随机变量,而是输入信号的确定性非线性映射,捕获感知相关信息,避免模型浪费容量在不可感知噪声上。

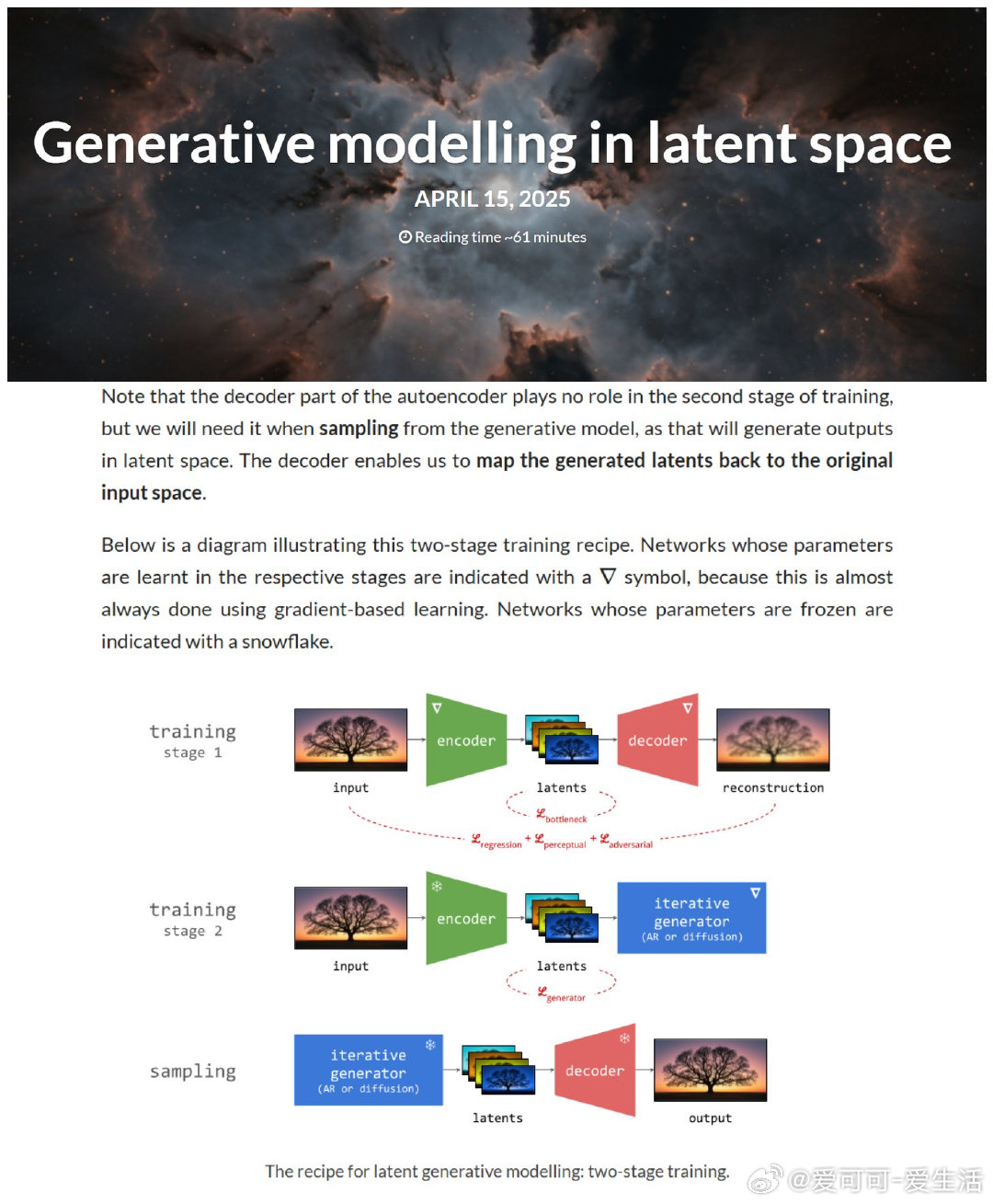

• 两阶段训练中,编码器参数冻结,生成模型(如自回归或扩散模型)专注潜空间建模,解码器用于最终采样输出。

• 损失函数结合回归、感知与对抗损失,兼顾重构质量与潜空间表达能力,体现了模型对纹理与结构信息的精细平衡。

• 潜空间设计需权衡容量(信息量)、策划(保留何种信息)与形式(信息呈现方式),保持拓扑结构以利用卷积、注意力等网络优势。

• 潜扩散模型结合了潜空间紧凑性与扩散模型优异生成能力,代表当前主流生成范式。

• 讨论了潜变量与传统VAE潜空间的区别,强调现代潜变量更像“高级像素”而非高层语义表达。

• 探索了潜空间的结构灵活性及对不同模态(图像、视频、音频、语言)的适应性,指出语言潜变量学习挑战更大。

• 作者认为端到端单阶段生成尚未成熟,潜空间生成因其计算高效性将继续主导一段时间。

这篇长文是理解扩散模型及其潜空间生成策略的权威指南,值得深读。详情👉 sander.ai/2025/04/15/latents.html

扩散模型 潜空间生成 自动编码器 生成模型 深度学习