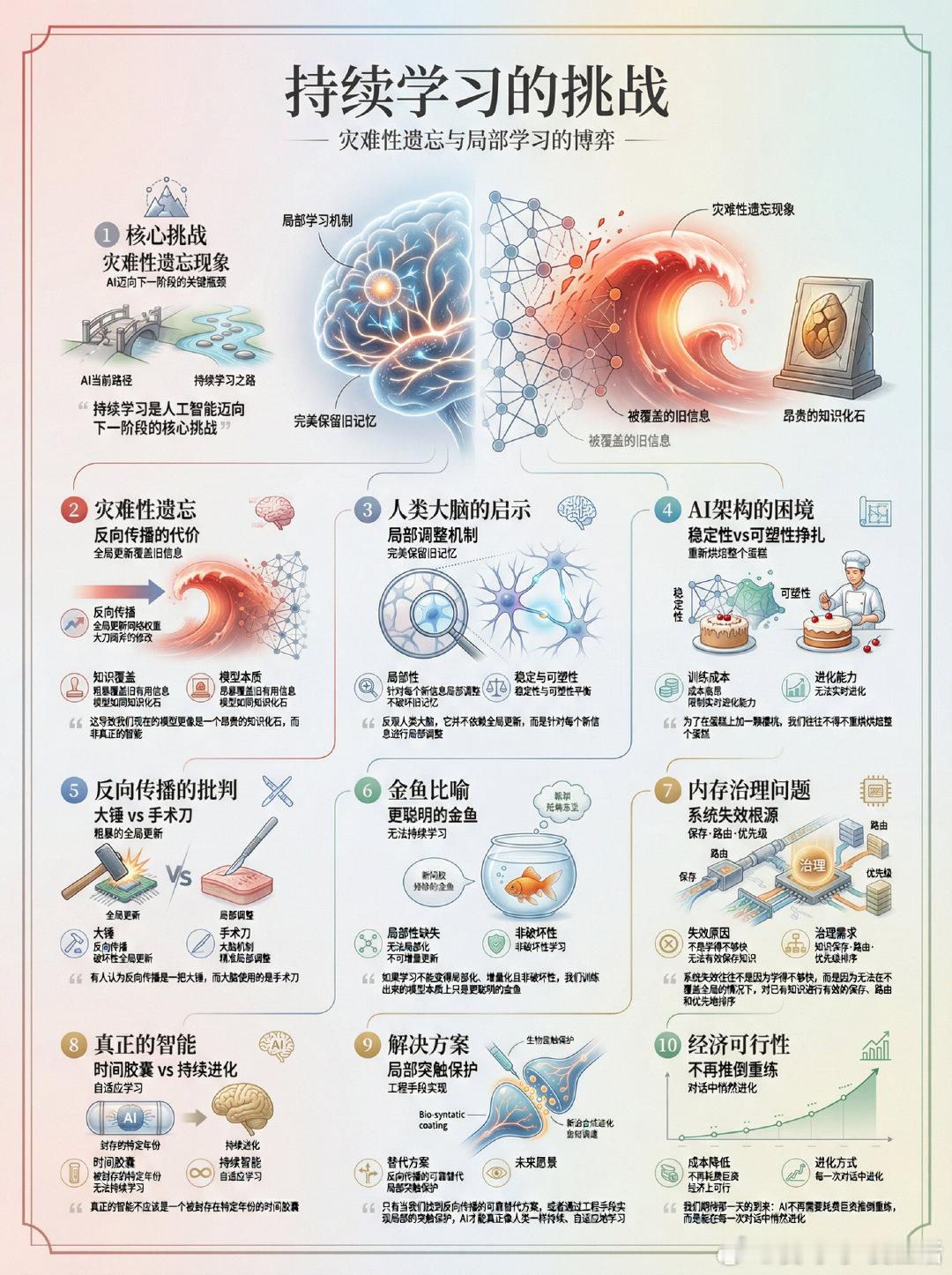

持续学习是人工智能迈向下一阶段的核心挑战。目前的深度学习网络普遍存在灾难性遗忘现象。每当新数据进入,反向传播算法就会全局更新网络权重,这种大刀阔斧的修改往往会粗暴地覆盖掉旧的有用信息。这导致我们现在的模型更像是一个昂贵的知识化石,而非真正的智能。反观人类大脑,它并不依赖全局更新,而是针对每个新信息进行局部调整。这种局部性让大脑能够在获取新知的同时,完美保留旧有的记忆。目前的AI架构在稳定性与可塑性之间艰难挣扎。为了在蛋糕上加一颗樱桃,我们往往不得不重新烘焙整个蛋糕。这种训练方式不仅成本高昂,更限制了AI的实时进化能力。有人认为反向传播是一把大锤,而大脑使用的是手术刀。在数学解决这个问题之前,神经科学或许能提供关键的启示。如果学习不能变得局部化、增量化且非破坏性,我们训练出来的模型本质上只是更聪明的金鱼。这不仅是一个训练难题,更是一个内存治理问题。系统失效往往不是因为学得不够快,而是因为无法在不覆盖全局的情况下,对已有知识进行有效的保存、路由和优先级排序。真正的智能不应该是一个被封存在特定年份的时间胶囊。只有当我们找到反向传播的可靠替代方案,或者通过工程手段实现局部的突触保护,AI才能真正像人类一样持续、自适应地学习。解决灾难性遗忘,不仅会让AI变得更聪明,更会让模型在经济上变得可行。我们期待那一天的到来:AI不再需要耗费巨资推倒重练,而是能在每一次对话中悄然进化。x.com/paraschopra/status/2002254911132872858