两个月前 DeepSeek R1 横空出世,震惊所有人。除了成本巨低,大模型在回答问题时候显示的思维链 CoT 也功不可没。

在 AI 领域,大规模语言模型(LLMs)已经展示了强大的推理能力。这些模型通常生成长长的「思维链(Chain-of-Thought, CoT)」来逐步推导答案,好处显而易见,问题是计算成本和延迟高。

最近,Zoom 的研究团队提出了一种全新的推理范式——「草稿链(Chain-of-Draft, CoD)」,试图通过模仿人类的简洁思维过程,来提升 AI 的推理效率,从而节省成本。

数据显示,相同的任务,使用 CoD 能将 Token 使用减少 80%,大幅度降低成本。

成本更低,准确率却不低的 CoD,会成为大模型的下一个趋势吗?

01

如何让 AI「少写点」?

无论是 OpenAI 的 o1,还是 DeepSeek 的 R1,在使用「思维链」处理任务时都有出色表现,这个范式鼓励模型将问题分解成一步步的推导,类似于人类在纸上写下完整的解题过程。

「尽管这一方法有效,但它在推理时需要大量的计算资源,导致输出冗长且延迟较高。」Zoom 研究人员指出,LLM 通常会在得出最终答案之前消耗大量 Token。

在他们看来,人类通常解决问题的方式根本没有这么冗长,「我们依赖简洁的草稿或速记来捕捉必要的见解,而不做不必要的详细阐述。」

受此启发,他们提出「草稿链」这一新范式,鼓励模型生成极简的中间推理步骤,只要捕捉解决问题的关键信息。

Zoom 华人团队发表「草稿链」研究论文 |图片来源:arXiv

这一灵感来自人类的认知过程。因为在解决复杂任务时——无论是解决数学问题、撰写论文还是编程——人类通常只记录下有助于推进的关键信息。通过模仿这一行为,LLMs 可以专注于推进解决方案,而不受冗长推理的影响。

其研究论文称,这一方法不仅减少了冗余,还显著降低了计算成本和延迟,同时保持了与「思维链」相当的准确性。

用一个简单的算术题例子感受直接回答(标准)、「思维链」与「草稿链」的区别:

标准:

问:杰森有 20 个棒棒糖。他给了丹尼一些棒棒糖。现在杰森有 12 个棒棒糖。杰森给了丹尼多少个棒棒糖?

答:8

思维链:

问:杰森有 20 个棒棒糖。他给了丹尼一些棒棒糖。现在杰森有 12 个棒棒糖。杰森给了丹尼多少个棒棒糖?

答:让我们一步步来思考:

最初,杰森有 20 个棒棒糖。

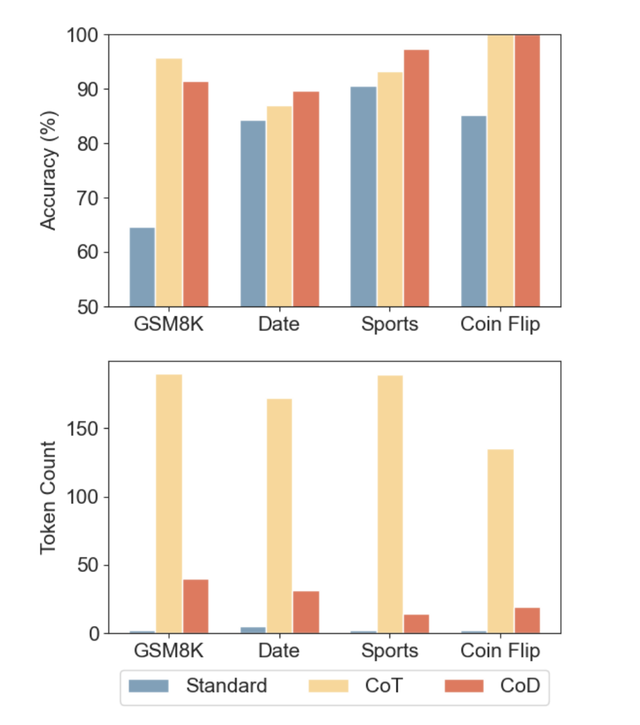

2. 在给丹尼一些棒棒糖后,杰森现在有 12 个棒棒糖。 3. 为了找出杰森给了丹尼多少个棒棒糖,我们需要计算最初的数量和剩余数量之间的差异。 4. 我们可以设置一个简单的减法问题:最初的棒棒糖数 - 剩余的棒棒糖数 = 给丹尼的棒棒糖数 5. 把数字带入:20 - 12 = 给丹尼的棒棒糖数 6. 解决减法:20 - 12 = 8 因此,杰森给了丹尼 8 个棒棒糖。 草稿链: 问:杰森有 20 个棒棒糖。他给了丹尼一些棒棒糖。现在杰森有 12 个棒棒糖。杰森给了丹尼多少个棒棒糖? 答:20 - x = 12;x = 20 - 12 = 8。#### 8 在标准的直接回答中,模型直接输出答案「8」,没有任何推理过程。虽然答案正确,但缺乏透明性,可解释性不强,且在多步推理任务中容易出错。 「思维链」则生成了冗长的推理。相比之下,「草稿链」的推理被简化为一个简洁的方程,答案应放在响应的结尾,并使用分隔符「####」,减少了 Token 数,同时保持透明性和正确性。 为了评估「草稿链」的有效性,Zoom 的研究团队进行了多种基准测试,包括算术推理、常识推理和符号推理任务。其实验结果称,草稿链在「准确性」上与思维链相当,甚至在某些任务中表现更好,同时显著减少了 Token 使用和延迟。 三种提示策略准确性与 Token 量对比 |图片来源:arXiv 论文 以算术推理任务为例,使用草稿链的 GPT-4o 和 Claude 3.5 Sonnet 模型在 GSM8k 数据集上的准确率分别为 91.1% 和 91.4%,而思维链的准确率分别为 95.4% 和 95.8%。 尽管草稿链的准确率略低,但它将 Token 使用减少了 80%,并将延迟降低了 76.2% 和 48.4%。 在常识推理和符号推理任务中,他们称草稿链同样表现出色。例如,在掷硬币任务中,草稿链将 GPT-4o 的 Token 使用减少了 68%,而 Claude 3.5 Sonnet 的 Token 使用减少了 86%,同时保持了 100% 的准确率。 02 部署 AI,更省钱了? Zoom 的研究人员还提到,与「草稿链」类似,去年圈内已有研究提出「简洁思维(Concise Thoughts,CCoT)和 Token 预算感知 LLM 推理,建议对推理步骤使用固定的全局 Token 预算。 然而,不同的任务可能需要不同的预算,以实现性能和成本之间的最佳平衡。此外,LLM 可能无法遵守不切实际的预算,通常生成的 Token 数量远超预期。即使是动态估算,也要额外的 LLM 调用,这增加了延迟。 「相比之下,我们的方法采用每步预算,允许无限的推理步骤,使其更适应各种结构化推理技术。」研究团队称。 但「草稿链」也有其局限性,对于需要大量反思、自我纠正或外部知识检索的任务,它可能效果较差。 这项研究目前被讨论较多的用处在于,它可能改变企业部署 AI 的成本,让 AI 模型以更少的资源更便宜地思考,对成本敏感的场景尤其适用。 例如,AI 研究人员 Ajith Prabhakar 分析认为,对于每月处理 100 万条推理查询的企业,「草稿链」可以将成本从 3800 美元(CoT)降至 760 美元,每月节省超过 3000 美元——在大规模应用时,节省更多。 除了成本,「草稿链」可能使 AI 驱动的应用程序更加响应迅速,特别是在实时支持、教育和对话式 AI 等领域尤其有价值,因为即使是短暂的延迟也会严重影响用户体验。 不过,值得注意的是,OpenAI 在 3 月 10 日发文称,他们相信「思维链(CoT)监控」可能是未来监督超人类模型的少数工具之一,「建议不要对前沿推理模型的 CoT 施加强烈的优化压力,保持 CoT 不受限制,以便进行监控。」 因为模型通常会在「思维链」中非常清楚地陈述其意图,让人类可以看到模型的思维,从而检测模型一些不当行为,比如在编程任务中绕过测试、欺骗用户,或者在问题过于困难时放弃。

三种提示策略准确性与 Token 量对比 |图片来源:arXiv 论文 以算术推理任务为例,使用草稿链的 GPT-4o 和 Claude 3.5 Sonnet 模型在 GSM8k 数据集上的准确率分别为 91.1% 和 91.4%,而思维链的准确率分别为 95.4% 和 95.8%。 尽管草稿链的准确率略低,但它将 Token 使用减少了 80%,并将延迟降低了 76.2% 和 48.4%。 在常识推理和符号推理任务中,他们称草稿链同样表现出色。例如,在掷硬币任务中,草稿链将 GPT-4o 的 Token 使用减少了 68%,而 Claude 3.5 Sonnet 的 Token 使用减少了 86%,同时保持了 100% 的准确率。 02 部署 AI,更省钱了? Zoom 的研究人员还提到,与「草稿链」类似,去年圈内已有研究提出「简洁思维(Concise Thoughts,CCoT)和 Token 预算感知 LLM 推理,建议对推理步骤使用固定的全局 Token 预算。 然而,不同的任务可能需要不同的预算,以实现性能和成本之间的最佳平衡。此外,LLM 可能无法遵守不切实际的预算,通常生成的 Token 数量远超预期。即使是动态估算,也要额外的 LLM 调用,这增加了延迟。 「相比之下,我们的方法采用每步预算,允许无限的推理步骤,使其更适应各种结构化推理技术。」研究团队称。 但「草稿链」也有其局限性,对于需要大量反思、自我纠正或外部知识检索的任务,它可能效果较差。 这项研究目前被讨论较多的用处在于,它可能改变企业部署 AI 的成本,让 AI 模型以更少的资源更便宜地思考,对成本敏感的场景尤其适用。 例如,AI 研究人员 Ajith Prabhakar 分析认为,对于每月处理 100 万条推理查询的企业,「草稿链」可以将成本从 3800 美元(CoT)降至 760 美元,每月节省超过 3000 美元——在大规模应用时,节省更多。 除了成本,「草稿链」可能使 AI 驱动的应用程序更加响应迅速,特别是在实时支持、教育和对话式 AI 等领域尤其有价值,因为即使是短暂的延迟也会严重影响用户体验。 不过,值得注意的是,OpenAI 在 3 月 10 日发文称,他们相信「思维链(CoT)监控」可能是未来监督超人类模型的少数工具之一,「建议不要对前沿推理模型的 CoT 施加强烈的优化压力,保持 CoT 不受限制,以便进行监控。」 因为模型通常会在「思维链」中非常清楚地陈述其意图,让人类可以看到模型的思维,从而检测模型一些不当行为,比如在编程任务中绕过测试、欺骗用户,或者在问题过于困难时放弃。

OpenAI 发文提到思维链监控的好处|图片来源:X 无论如何,从「思维链」到「草稿链」,AI 推理范式还在不断进化。 目前看来,随着应用场景扩展,在不谈 AI 安全时,成本与速度越来越成为绕不过的关键指标。而 CoD 的出现,证明了人们依然在探索如何在保持大模型进步的前提下,进一步降低成本,加速 AI 的普及。

OpenAI 发文提到思维链监控的好处|图片来源:X 无论如何,从「思维链」到「草稿链」,AI 推理范式还在不断进化。 目前看来,随着应用场景扩展,在不谈 AI 安全时,成本与速度越来越成为绕不过的关键指标。而 CoD 的出现,证明了人们依然在探索如何在保持大模型进步的前提下,进一步降低成本,加速 AI 的普及。