Python作为一门优秀的编程语言,近年来受到很多编程爱好者的青睐。一是因为Python本身具有简捷优美、易学易用的特点;二是由于互联网的飞速发展,我们正迎来大数据的时代,而Python 无论是在数据的采集与处理方面,还是在数据分析与可视化方面都有独特的优势。我们可以利用 Python 便捷地开展与数据相关的项目,以很低的学习成本快速完成项目的研究。

今天给小伙伴们分享的这份Python数据分析入门手册本着实用性的目的,着眼于整个数据分析的流程,介绍了从数据采集到可视化的大致流程。

内容涵盖数据的获取(即网络爬虫程序的设计)、前期数据的清洗和处理、运用机器学习算法进行建模分析,以及使用可视化的方法展示数据及结果。希望借此为Python初学者打开数据分析领域的大门,初窥数据分析的奥秘。

限于文章篇幅原因,只能以截图的形式展示出来,有需要的小伙伴帮忙转发文章后,关注私信回复【Python】凭本文截图即可获取!

第1章 准备第1章主要讲解了Python集成开发环境的搭建。考虑到初学者容易为安装第三方库犯难,又介绍了三种简单实用的方法来安装这些常见的库。接着对几个后面要用到的高级语法进行了简单介绍,为之后的应用打下基础。

第2章 数据的获取

第2章 数据的获取第2章集中讲解了数据采集的流程,即网络爬虫程序的设计与实现。没有拘泥于使用Python的内置库 urllib 库进行实现,而是直接介绍了requests和其他更加简洁强大的库来完成程序的设计。在进阶内容中,对常见的编码问题、异常处理、代理P、验证码、机器人协议、模拟登录,以及多线程等相关问题给出了解决的方案。

第3章 数据的存取与清洗

第3章 数据的存取与清洗第3章讲解数据的清洗问题。在具体讲解清洗数据之前,先介绍了TXT、XLSX、JSON、CSV等各种文件的导入和导出的方法,并介绍了Python与MySOL数据库交互的方式。接着介绍了NumPy和pandas库的基本使用方法,这是我们用于数据处理和科学计算的两个强大的工具。最后综合以上的学习介绍了数据的去重、缺失值的填补等经典的数据清洗方法。

第4章 数据的分析及可视化

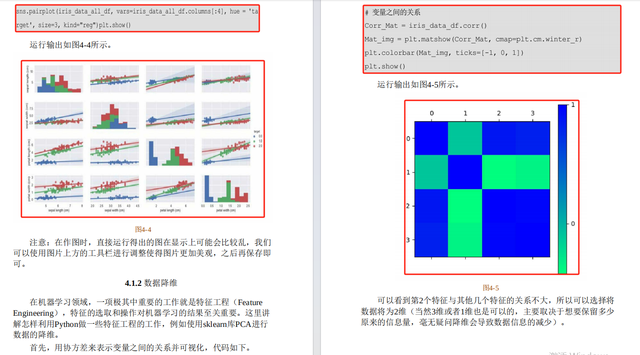

第4章 数据的分析及可视化第4章首先讲解探索性数据分析的应用,并且简单介绍了机器学习基本知识。然后演示如何应用 sklearn 库提供的决策树和最邻近算法来处理分类问题,并尝试根据算法原理手动实现最邻近算法。最后介绍如何使用 pandas、matplotlib 和seaborn这三个库来实现数据的可视化。

第5章 Python与生活

第5章 Python与生活第5章是综合性学习的章节,讲解了三个小项目的完整实现过程旨在通过操作生活中真正的数据来强化前面基础内容的学习。

限于文章篇幅原因,就展示到这里了,有需要的小伙伴帮忙转发文章后,关注私信回复【Python】凭本文截图即可获取!