Llama 4,Meta的最新力作,本应是AI领域的又一里程碑,却出乎意料地在其开源首日遭遇了巨大的争议。

代码能力的全面翻车、内部员工的愤然离职以及随之而来的训练数据作弊的爆料,将Llama 4推上了风口浪尖。

这究竟是怎么回事?

Meta的未来又将走向何方?

Llama 4的代码能力在多项测试中表现不佳,引发了广泛的质疑。

许多网友在实际测试后纷纷表示失望,认为其代码能力远低于预期,甚至不如一些参数量更小的模型。

例如,有网友使用Llama 4和GPT-4o分别生成旋转多边形动画,结果Llama 4生成的动画不仅多边形不规则,小球的运动轨迹也违反物理规律,而GPT-4o的成果则相对更优。

此外,Llama 4在诗歌创作等其他方面的表现也差强人意,未能展现出与其参数量相匹配的能力。

更有甚者,有人指出Llama 4在LMarena上的测试存在过拟合现象,怀疑其有“作弊”嫌疑。

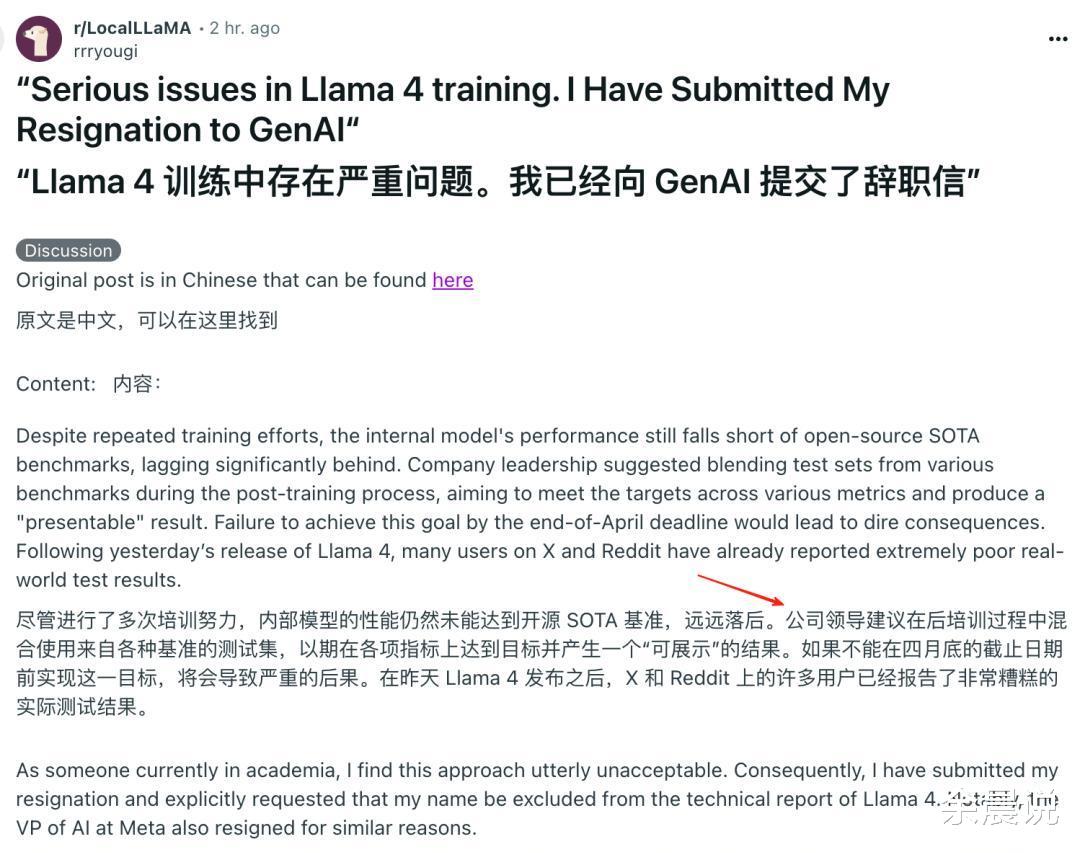

一位Meta内部员工的爆料更是将Llama 4推向了舆论的漩涡。

该员工声称,由于Llama 4经过反复训练后仍未能达到预期水平,Meta高层竟然提议在后训练阶段将多个benchmark测试集混入训练数据,以期在短期内提升模型的指标。

这位员工无法接受这种做法,最终选择辞职,并在辞职信中明确要求不要在Llama 4技术报告中挂名。

这位爆料者的身份和动机目前尚不清楚,但其言论与一些网友的测试结果以及专家的评价不谋而合。

沃顿商学院教授Ethan Mollick曾表示,经常使用AI模型的人不难分辨出哪些模型是针对基准测试进行优化的,哪些是真正的重大进步。

Llama 4的种种表现,似乎正印证了Ethan Mollick教授的观点。

Meta在Llama 4的宣传中,特别强调了“Maverick”版本是“针对对话优化的”。

有AI研究人员发现,可公开下载的Maverick版本与LM Arena上托管的版本在行为上存在显著差异。

这种“区别对待”的做法,使得开发者难以准确预测模型在特定上下文中的表现,也进一步加深了人们对Llama 4测试作弊的怀疑。

就在爆料事件不断发酵之际,Meta AI研究部副总裁Joelle Pineau的辞职申请再次引发了人们的关注。

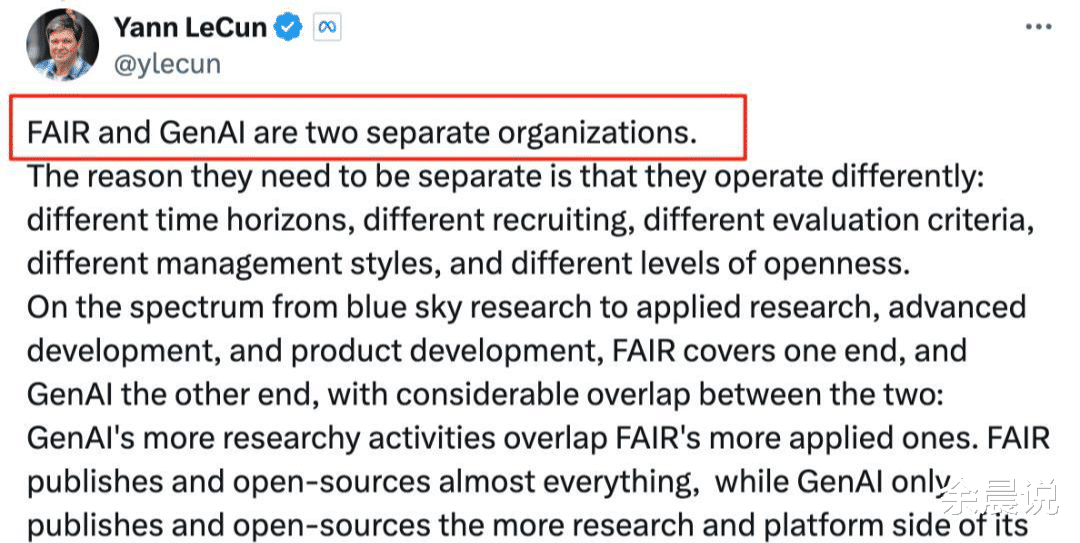

尽管有消息称Pineau的辞职与Llama 4项目无关,但她所在的FAIR部门与负责Llama项目的GenAI部门相互独立,这一巧合仍不免令人浮想联翩。

“一亩三分地”是本次爆料的主要来源。

虽然爆料者的身份和动机有待进一步核实,但对话中提及的Meta AI研究部副总裁Joelle Pineau申请辞职一事,却与公开信息相符。

这也在一定程度上增加了爆料内容的可信度。

在代码测试方面,网友Dr_Karminski指出,总参数402B的Llama-4-Maverick在编码能力方面大致与参数量仅为32B的Qwen-QwQ相当,而总参数109B的Llama-4-Scout则与Grok-2或Ernie 4.5类似。

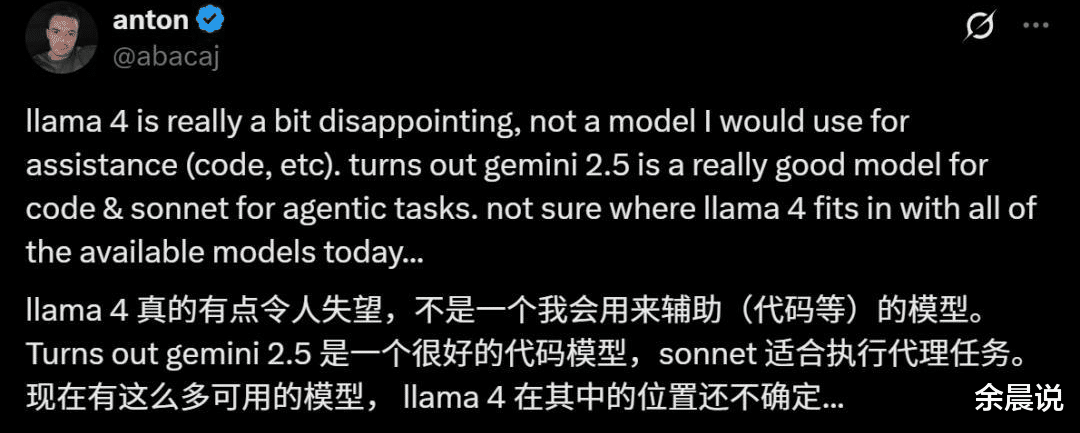

其他网友也纷纷表示,Llama 4的表现令人失望,甚至不如一些参数量更小的模型。

网友Deedy将Llama 4称为“一个糟糕的编程模型”,并指出Scout (109B) 和Maverick (402B)在针对编程任务的Kscores基准测试中表现不如4o、Gemini Flash、Grok 3、DeepSeek V3和Sonnet 3.5/7。

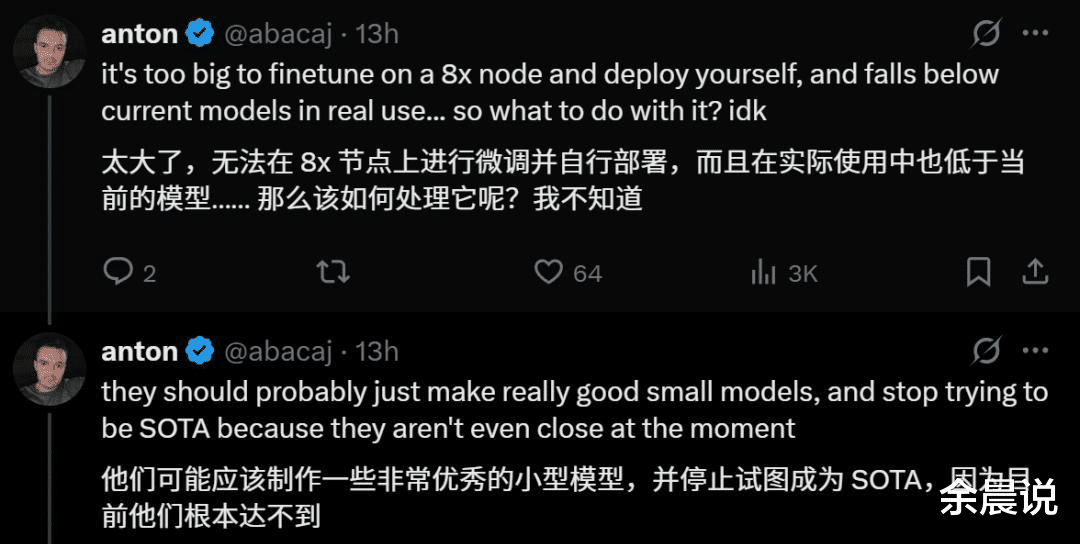

另一位网友anton则认为Llama 4的两个模型体积过大,不便于本地部署,建议Meta应该专注于开发性能优秀的小模型,而不是盲目追求成为SOTA。

Llama 4的未来将走向何方?

Meta又将如何回应这些质疑和挑战?

这一切都还有待观察。

这场风波不仅暴露了Llama 4自身存在的问题,也引发了人们对AI行业发展方向的思考。

在追求性能提升的同时,如何确保模型的可靠性和公平性,将是摆在所有AI开发者面前的重要课题。

Llama 4的翻车事件,或许会成为AI发展历程中的一个重要节点,促使人们重新审视技术进步与伦理规范之间的平衡。

那么,您认为Llama 4事件会对AI行业带来哪些影响?