IT之家1月30日消息,人工智能正加速向着边缘计算领域发展,Copilot+PC在其中扮演着重要角色。随着DeepSeekR1出现,微软也意识到了这一模型可能会带来了一系列变革。

微软今日发文,宣布推出针对NPU优化的DeepSeek-R1(IT之家注:已在AzureAIFoundry和GitHub上提供),首批将面向搭载高通骁龙X芯片的Copilot+PC推出,随后是英特尔酷睿Ultra200V等平台。

微软表示,首个版本DeepSeek-R1-Distill-Qwen-1.5B将在AIToolkit中提供,7B和14B版本也将很快推出,从而帮助开发者充分利用Copilot+PC中强大的NPU配置。

微软表示,Copilot+PC上的NPU开启了一种新的范式。在这种范式下,生成式AI不仅可以在被调用时执行,还可以支持半连续运行的服务。这使开发者能够利用AI推理引擎来构建主动和持续的体验。微软表示:

通过我们在PhiSilica上的工作,我们实现了高效的推理——在首次生成token的时间和吞吐率方面表现出色,同时对电池续航和PC资源消耗的影响降至最低。针对NPU优化的DeepSeek模型借鉴了该项目的多项关键经验和技术,包括如何分离模型的各个部分以实现性能与效率的最佳平衡、低比特率量化以及将Transformer映射到NPU。此外,我们还利用WindowsCopilotRuntime(WCR)通过ONNXQDQ格式在多样化的Windows生态系统中实现扩展。

微软表示,要想在Copilot+PC上体验DeepSeek只需下载AIToolkitVSCode扩展即可;以ONNXQDQ格式优化的DeepSeek模型将很快出现在AIToolkit的模型目录中(直接从AzureAIFoundry中拉取)。

用户可以通过点击“下载”按钮将其下载到本地。下载完成后,只需打开Playground加载“deepseek_r1_1_5”模型,并给出提示词即可开始实验。

除了为Copilot+PC优化的ONNX模型外,您还可以通过点击“DeepSeekR1”下的“TryinPlayground”按钮,在AzureFoundry中尝试云托管的源模型。

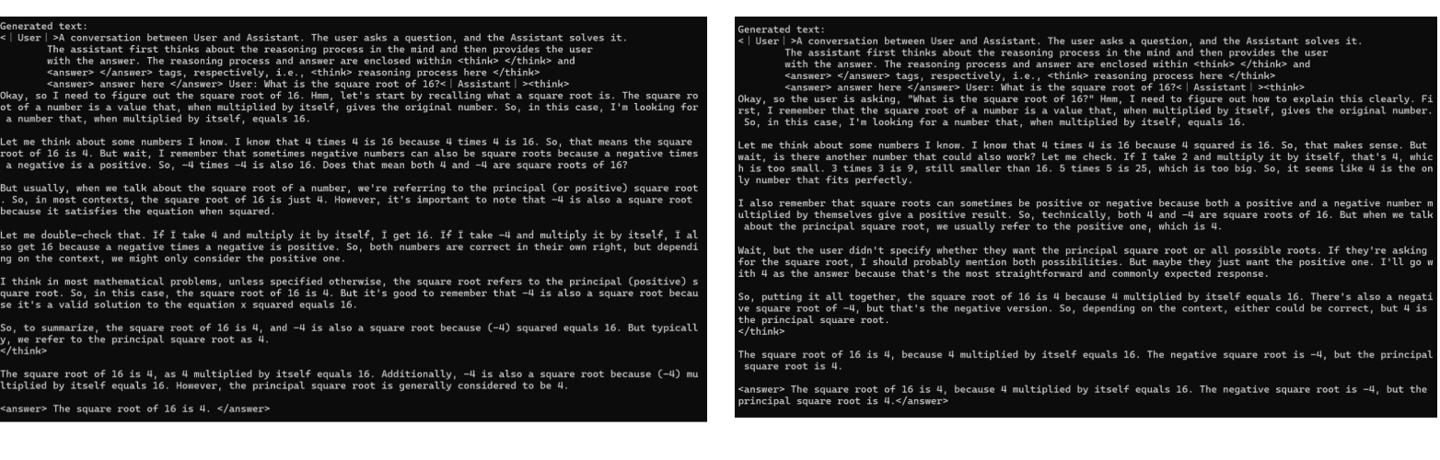

如下图所示,微软还展示了原始模型和量化模型的示例,以展现两者之间微小但确实存在的差异:

第二个完美的逗

这就是说之前投给openai的💰打了水漂了吗[笑着哭] 花钱买的还没一个免费的香。。压力给到openai了,看它如何接招[捂脸哭]

你说说你哦

我知道中国人很缺乏自信,所以需要需要不断地催眠自己很强很强很棒很棒,但是也要实事求是,是怎样就是怎样,不能自欺欺人。

郭青禾

一边要打压别人一边优化使用,什么意思???

唯由犯决刷厦

deepseek先搞蒸馏,然后就是微软再把deepseek再蒸馏了

youth_yan

最后这就是典型给别人做嫁衣[红脸笑]

火红

DeepSeek-R1-Distill-Qwen-1.5B这不是蒸馏了阿里通义模型吗?[捂脸哭]

我想听到你_

一边打压,一边优化。典型的即当又立啊

萧赞赞

太厉害了。成立仅半年,只有四人交社保的企业,走过了别人n年的路。天才![笑着哭]

晓汲清湘

微软灵魂都不要了,可见是真香!

啵啵波博

微软和AMD对Deepseek 的认可,足以否定一切质疑。

蛋白切开是黄的

专业人员都知道deepseek 是openai的destilled的产物,不是原创的产品

河笙

微软拿去了,就是微软的,谁有操作系统,数据成果就归谁,