deepmind的一篇研究微调的新论文《On the generalization of language models from in-context learning and finetuning: a controlled study》。 arxiv.org/pdf/2505.00661

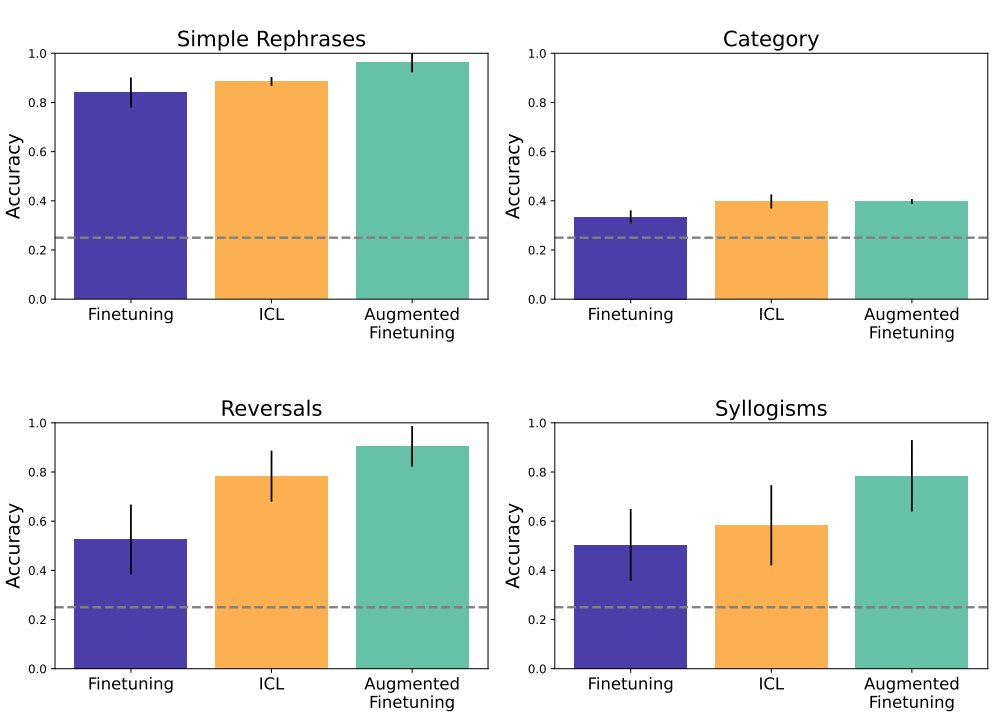

这篇论文研究了大型语言模型(LMs)在上下文学习(in-context learning, ICL)和微调(fine-tuning, FT)两种学习方式下的泛化能力差异,并提出了一种通过上下文推理增强微调数据的方法来提升模型的泛化性能。研究结果表明,上下文学习在某些情况下比微调更能灵活泛化,而通过上下文推理增强微调数据可以进一步提升模型的泛化能力。

AI创造营