一条470行、跑1000秒的“屎山”SQL,被AI轮番开刀:Claude4和Gemini追求极速却算错数,DeepSeek直接报错,Grok3稳在32秒,而ChatGPTo3一把干到7秒,还顺手揪出脏数据。文章用同题实测告诉你:选对模型、喂对提示词,就能把AI变成7×24小时在线的高级DBA,让优化SQL从玄学变科学。

搞数据分析的同学,谁没被“屎山”SQL代码折磨过?

在BI里,有一段470行的代码,确实慢,要跑1000多秒,将近17分钟!

每次查询量大一点业务都会来投诉

最近实在受不了了,就想用AI来优化一下,顺便看看现在这些当红炸子鸡们写SQL的能力到底怎么样。

所以如果你平时工作也有写SQL的需求,那么这篇文章可以帮你省下大把选AI工具的时间。

甚至可以直接拉到文末看结论。

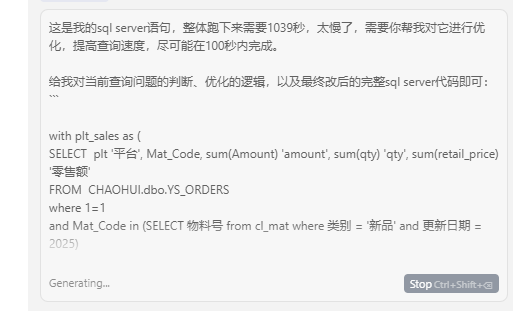

统一给的提示词是一样的:这是我的sqlserver语句,整体跑下来需要1039秒,太慢了,需要你帮我对它进行优化,提高查询速度,尽可能在100秒内完成。给我对当前查询问题的判断、优化的逻辑,以及最终改后的完整sqlserver代码即可:“`源代码“`

看看各家人表现如何。

Claude4

:速度快,但数据错了

拿到语句,跑了一下吓到了,确实是快,给我优化到不用1秒了,但从行数看得出来,数据错了。。

数据分析中,数据错就是原罪是不可原谅的,所以直接passGemini

:效果同Claude4

Gemini也翻车了,结果也是错的。

DeepSeek

:国产还是不行

国产之光DeepSeek,这次有点拉胯,直接就挂了,报错说我的查询有问题。得,连门都没进来。

Grok3

:不错,终于有个靠谱的了

轮到马斯克的Grok3。这次总算看到点希望了!

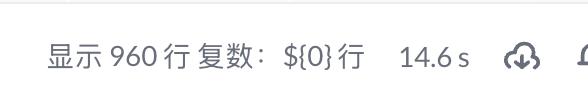

它给出的优化代码,跑下来只要32.5秒,而且最重要的是,返回行数是945行!跟原始数据一模一样!

从1039秒优化到32.5秒,同时保证了数据的正确性,这个效果已经很不错了,对于日常工作来说完全够用。

ChatGPTo3

:卧槽,王者诞生!

卧槽,直接给干到7秒了

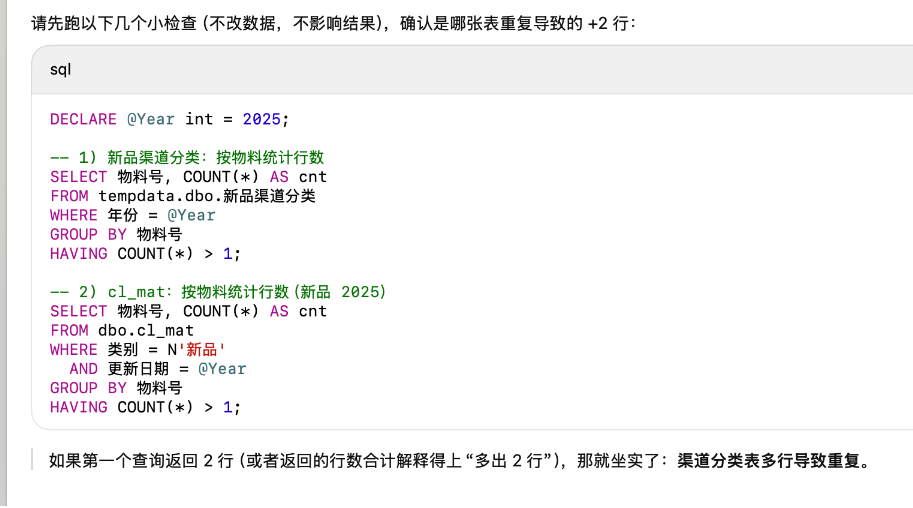

但不对诶,怎么是947行?

经验告诉我,差距这么小属于是误差,应该是哪里没清洗好。

于是我继续问GPT差距的原因,它给了几个语句,让我去查,优先是这里:

果然,我手动把原先的表结果和GPT的结果匹配后,得出的结论,跟它给的这个判断是一样的——原表有重复值。

也就是说,GPT不仅优化了我的代码,还顺手把我原始数据里的“坑”给找了出来。

它比我自己,更懂我写的“屎山”!这多出来的2行,不是它算错了,而是它更“正确”地处理了我的脏数据。

结论

模型特征差异:为什么o3表现这么好?

1.推理深度优先

o3属“推理系列”,回答前会花更多计算在拆解步骤、判断风险;官方就把它定位在复杂、多步骤、答案不直接可见的问题上,并强调比前代在真实复杂任务上重大错误更少。

2.自查+工具链意识

o3支持在ChatGPT里调用代码、文件、等工具,并被设计成可“自我核对/自查”式解题。这类模型更容易输出验证SQL(查行数、查重复键)而不是只给一版改写。

我这案例中“差2行→让检查重复”的互动就是典型自查路径。

3.编程任务基准强

o3在SWE-bench等真实软件任务上创SOTA;这说明它在读长代码、保持语义一致、逐步修改方面有训练优势,迁移到复杂SQL时表现更稳。

4.可调思考强度,面向可靠场景

o3/o3-pro提供更高“思考时间”档位(reasoningeffort),官方推荐在需要高可靠输出时使用;SQL优化这类“性能+正确性”双高风险任务特别受益。那Claude/Gemini为啥不行?(结合你测评)Claude

Claude3.5/后续家族强调智能+速度(较Opus提升2x),并且在“提供工具时可独立写/改/跑代码”。在缺少你库结构、验证要求时,它倾向快速重写、aggressively精简;结果是性能上去了,逻辑被改,行数飘。

也就是说,给Claude时要明确“结果必须与原SQL一致”“先给验证脚本”,否则它可能优先交付速度。Gemini

Google的Gemini在线路里重点做“快速帮你写SQL/解释SQL/自动补全”;官方文档也提醒要在运行前验证生成的语句。面向“让更多人写得出SQL”,而不是保证复杂多表、脏数据场景下100%口径一致。怎么喂模型,才能又好又快?

其实我提示词是很简单的,但如果可以把这些和SQL一起贴给模型,翻车率下降:原慢SQL+当前耗时目标:性能阈值&结果必须一致表结构(主键/索引)已知脏数据(重复、NULL)是否允许建索引/改逻辑

参考提示词:

提示词很长,并不是所有场景都需要,可以酌情去补。例如我今天这个查询优化的,直接让AI去优化,如果效果不行,再考虑补充对索引等方式的解释。

亦或是无法用GPTo3的,也就是大模型能力差点的,就只能通过补充更完整的提示词去优化结果。#SQLServer性能调优请求(保持结果一致)我有一段在**SQLServer**上运行的查询,当前完整SQL已贴在下方代码块中。实际耗时约**1039秒**(取最近平均值/或填最新一次测量值)。目标:**在不改变结果集(行数、金额、度量指标全部一致)的前提下,将执行时间压到≤100秒**;如无法达成,请给出分档优化方案(≤300s、≤100s、≤30s)并说明所需额外条件。—##已知信息(请用你需要的结构化方式复述并补充问题排查SQL)-**数据库版本**:``(若未知请询问我)。-**数据日期范围**:``(与你SQL中筛选一致)。-**关键业务口径**:哪些字段/度量必须保持一致?(如:总行数、SUM(Amount)、SUM(qty)、SUM(retail_price))。-**是否允许改写业务逻辑?**默认*不允许*;只可在不改变结果的情况下重排、裁剪数据扫描、预聚合等。若需改逻辑请先列出风险点让我确认。-**是否允许创建/建议索引?**(默认:可建议,不自动创建)。-**是否允许使用临时表(#temp)或物化中间结果?**(默认:**不允许**;若你认为必要,请解释收益与代价)。-**数据质量提示**:可能存在重复主键/多对多/NULL/数据倾斜;若需验证请生成检查SQL。-**并行/内存/提示(HINT)**约束:若需使用OPTION(RECOMPILE)、MAXDOP等,请说明原因。—##你需要输出的内容请按以下顺序,逐段输出(每段用清晰标题):1.**快速复核**:复述我提供的业务口径、限制条件、性能目标;指出仍缺失的信息并向我提问。2.**瓶颈诊断**:基于查询结构(CTE、子查询、JOIN、CONVERT导致索引失效等)推测主要耗时来源;给出我可执行的`SETSTATISTICSIO,TIMEON`/`EXPLAIN`/`ACTUALEXECUTIONPLAN`指令清单。3.**数据正确性守护清单**:列出必须验证的指标(行数/金额/去重逻辑),并生成“原SQLvs优化SQL”对比验证脚本。4.**分步优化建议(从低风险到高风险)**:-重排过滤顺序/先裁剪再聚合-消除非SARGable谓词(如对日期列的CONVERT)-预聚合/派生表降基数-必要时的索引/统计信息建议-可选:物化或分阶段执行(若允许)5.**提供至少一个“安全优化版SQL”**:保证结果一致,可直接替换测试;在代码内用注释标记关键改动。6.**(可选)激进优化版**:若放宽限制(如允许临时表或索引)能进一步降到–原始SQLEND

同样适合用o3的“强推理+高正确性”场景

下面这些工作都信息多、步骤长、结果必须对,用ChatGPTo3帮你拆步骤、生成检查脚本、做差异核对,能省很多坑:

–大型代码库重构/接口迁移:跨多语言项目,要保持旧功能不坏,o3可生成改动计划+回归测试清单。

–财务/运营系统对账:订单、付款、发票数据来自不同系统;o3帮你定义对齐字段、差异报表、预警规则。

–实验/A/B分析流程复核:样本过滤、曝光口径、指标计算要一致;o3可产出验证查询、统计对照步骤。(不限定用哪种分析工具)

–多语言内容本地化一致性审校:术语、变量占位符、隐私条款不能错;o3可批量对照源文vs翻译文。

–合同/政策文档批量条款提取:找关键条款、标风险、比较版本差异;o3生成结构化清单。

–营销自动化流程调试:触发条件、频控、名单交集复杂;o3帮你画流程、生成测试用例、模拟触发数据。

–机器学习数据清洗&标签一致性检查:类别映射、缺失、分布漂移;o3可输出检查脚本与数据质量报告。

–自动化报表发布前的数据闸口:多源汇总,字段映射、缺失、阈值预警;o3帮你生成预检任务。

以上,既然看到这里了,如果觉得不错,随手点个赞、推荐、转发三连吧,你的支持是我持续创作的动力。我们下期见。

为了帮助大家减少AI信息差,饼干哥哥拉了个AI交流群,围绕着AI数据分析、AI编程、AI工作流、AIAgent等进行讨论。

AI数据分析相关阅读:

用AI做酷炫的数据看板HTML,并稳定更新数据,落地到实际工作中

AI做可视化图表的终极方案:DeepSeek+Mermaid+Napkin

一文彻底解决AI可视化图表问题:DeepSeek一键生成百种图表,小白也能轻松上手|保姆级教程

用DeepSeek做Excel动态交互图表,再也不需要截图了!!!

5000字教程:用AI实时查询数据库,自动生成可视化图表|Dify工作流

AI做财报分析、行业分析的5大步骤与11个提示词

2025数据分析野路子:DeepSeek+PandasAI=王炸!一句话抵过去半小时的工作量,数据分析彻底翻天了!!

9000字落地实操:AI做用户购后评论洞察分析

用Deepseek做了一份用户画像报告,并给出了价值10万的运营策略|以普拉提教培行业为例

4个AI同时做小红书数据分析,DeepSeek的结果出人意料…

3个实操案例,学会用DeepSeek做VBA开发,实现Excel自动化用Cherry替代Manus,AI调用多个MCP在本地处理Excel生成可视化报告文件

两句话,让ClaudeCode+KimiK2跑了3小时爬完17个竞品网站、做了一份深度市场数据分析报告