文/王新喜

deepSeek的横空出世,让全球科技界至今仍在惊叹,ChatGPT首席执行官奥尔特曼首次承认,DeepSeek可与ChatGPT相媲美。DeepSeek也引发众多国家的嫉妒与恐慌,试图联手封杀屏蔽。在早前,DeepSeek出现颠覆了市场将高性能GPU视为AI赛道核心的传统认知,导致高性能GPU垄断者的英伟达率先被市场看空,美国科技股暴跌,美方股市损失累计超过十万亿人民币。

老美自然不甘心,加紧对deepSeek的封锁,联手意大利、澳大利亚、日本、印度等盟友禁止使用。法国和印度这对"新搭档"还专门搞了个人工智能行动峰会,给AI的发展定规矩。

致命软肋仍在,英伟达股价过山车

国外多国试图屏蔽DeepSeek,但在国内的一系列布局在快速推进,各大厂商纷纷接入deepSeek,目前接入DeepSeek的中外企业已达数百家,国内云服务、互联网、手机、芯片、金融、医疗、汽车等行业都在上线和部署DeepSeek。

但一个新的问题随之而来,如今许多上线DeepSeek的平台显示服务器繁忙,原因是,平台提供的算力跟不上飞速增长的用户需求。

因为现阶段用户使用 DeepSeek-R1 的主要途径无外乎云服务及“本地部署”,但官网服务器频频宕机、个人部署多为参数量缩水 90% 的蒸馏版。因此,一般用户要想在普通硬件上运行起真正的 DeepSeek-R1 满血版非常难,而租赁服务器的成本就算是开发者也倍感压力。

有IT厂商对媒体称,其调用DeepSeek的平台在上线首日增加了上万个用户,服务器几乎崩溃,现有算力已经跟不上用户的需求。团队为缓解压力,不得不紧急调配更多英伟达GPU。

这种情况不止一家厂商,这导致,近期无论是高性能的H系列GPU,还是RTX 40系列的高端显卡,英伟达的GPU重新变得供不应求,英伟达股价也重新回暖。

要知道,DeepSeek的R1模型发布后,英伟达股价遭遇过去一年来最大跌幅17%,但自2月3日开始出现反弹,目前回升了13%。

DeepSeek的横空出世,让英伟达暴跌,但DeepSeek超乎异常的火爆,也重新带火英伟达GPU。

这意味着,应用层的狂欢,终究绕不开底层硬件的"卡脖子"危机。威力再强大的火器,若被他人掌控子弹,终究难逃受制于人的宿命。

这暴露出来的软肋是,即便通过算法优化将训练成本压到同类1/20,但H800集群的天价账单仍让企业倍感压力,仍在英伟达GPU的算力牢笼中挣扎!更残酷的是,现有架构下模型每升级一次,硬件投入就要翻倍,这场算力军备竞赛正吞噬大量利润空间。

如何打破这场算力牢笼,我们已经出现两把尖刀

加上英伟达高端GPU断供风险高悬,AI算力“卡脖子”问题始终是威胁中国科技产业的达摩克利斯之剑。然而,我们也没有坐以待毙,一场新的算力破局正在拉开帷幕。

DeepSeek越火爆,其模型的训练与推理对计算资源的需求就越庞大。目前,DeepSeek 在算力硬件方面多依赖英伟达 GPU 系列芯片,长期采购的成本资金压力大。另一方面,通用硬件如 GPU 虽在 AI 计算中广泛应用,但面对日益增长的复杂计算任务,逐渐暴露出成本效益比不高的问题。

这或许成为了 DeepSeek 决定自研芯片的重要导火索——目前,据知情人士透露,DeepSeek已在全国范围内广招芯片设计人才,剑指“算法-芯片-数据”三位一体的技术闭环。种种迹象表明,其自研 AI 专有芯片的计划已从设想迈向实质性推进阶段。

此外,DeepSeek已与华为昇腾、天数智芯等企业合作,通过底层框架绕开CUDA生态,推动国产芯片的框架优化和分布式训练适配,为国产芯片打破“软件枷锁”提供可能。而DeepSeek的开源策略与国产芯片的性价比优势形成共振。例如,摩尔线程的夸娥智算集群、燧原科技的推理芯片,均通过适配DeepSeek模型找到商业化突破口。

开发专有 AI 芯片,不仅将从硬件底层实现成本优化,也能够为 DeepSeek 模型提供更契合其计算需求的高效算力支持,并减少对外采购芯片的巨额开支,进一步降低运营成本。国产芯片厂商是否能从“陪跑”转向“领跑”!DeepSeek的自研芯片或将成为一把尖刀。

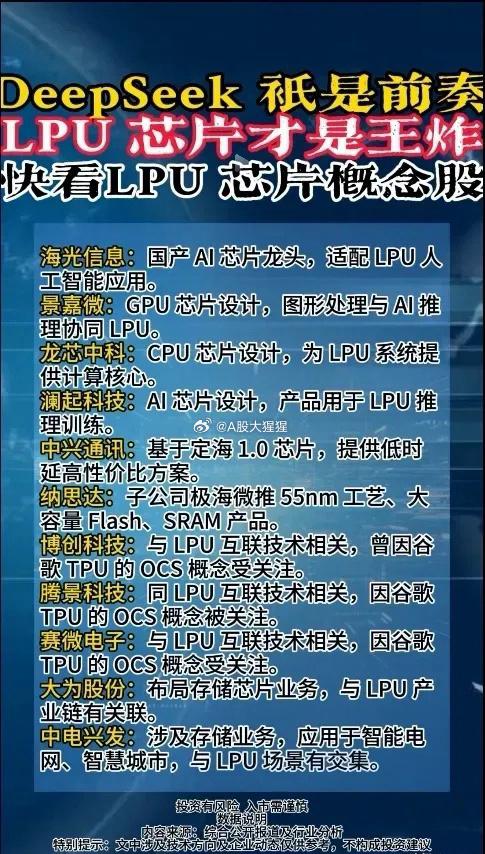

其次,打破算力牢笼,第二把尖刀是LPU。 LPU就是一种能提供超低延迟、超高数据吞吐量的芯片技术。中国工程师已瞄准这场算力战场的"诺曼底"!我国自主研发的LPU芯片即将强势登场。

与英伟达的GPU相比,LPU是专为AI推理所设计的芯片。首先,它的速度之快令人瞠目结舌,约为GPU的20倍,这得益于其独特的架构设计;其次,节能环保,能耗仅为英伟达的1/10,以一个中等规模的数据中心为例,若采用LPU替代英伟达GPU,每年的电费支出可能会降低数百万甚至上千万元。再次,其推理能力远超英伟达,直接将把推理成本砍至1/10,引爆百万亿级智能终端革命。

LPU,作为专为语言处理任务量身定制的硬件处理器,以其区别于传统 GPU 的创新架构、令人惊叹的性能表现和超低的成本优势,成为了 AI 领域的新宠。

像西测测试,它负责测试SRAM芯片,而SRAM是LPU的关键部件。 芯原股份直接参与LPU芯片的设计和开发,赚的是技术钱。 长电科技、通富微电这些封测企业,负责把芯片封装好,准备上市。还有那些存储芯片厂商,它们提供的SRAM,直接决定了LPU的性能。 AI芯片公司它们的产品可以加速LPU的运算速度。 总之,整个产业链都动起来了。

清华系企业"无问芯穹"用1块FPGA卡完成4块GPU的工作,推理成本暴跌90%,这意味着百亿参数模型将能跑在RTX显卡上,AI创作即将飞入寻常百姓家!

DeepSeek的闪电战只是序幕,LPU掀起的算力革命才是真正的主战场。当西方还在GPU赛道内卷时,中国已开辟出专用AI芯片的新大陆。

总的来说,DeepSeek火爆,英伟达回暖,国产算力供不应求,或只是短暂的算力困境,国内两把尖刀任何一把都有致命杀伤力:若 DeepSeek 成功推出自研 AI 芯片,将为 AI 应用提供更高效、经济的算力支持,有力推动 AI 技术在智能交通、医疗、金融等众多领域的落地应用,加速各行业的智能化升级进程。而一旦LPU落地,中国AI在未来3~5年实现算力自主,这种"应用突围+硬件换道"的组合拳,可能创造全新的奇迹,彻底打破算力囚牢困境,我们拭目以待。

作者:王新喜 TMT资深评论人 本文未经许可谢绝转载