[LG]《Large Language Models Show Signs of Alignment with Human Neurocognition During Abstract Reasoning》C Pinier, S A Vargas, M Steeghs-Turchina, D Matzke... [University of Amsterdam] (2025)

大型语言模型与人类大脑在抽象推理中表现出神经认知的一致性

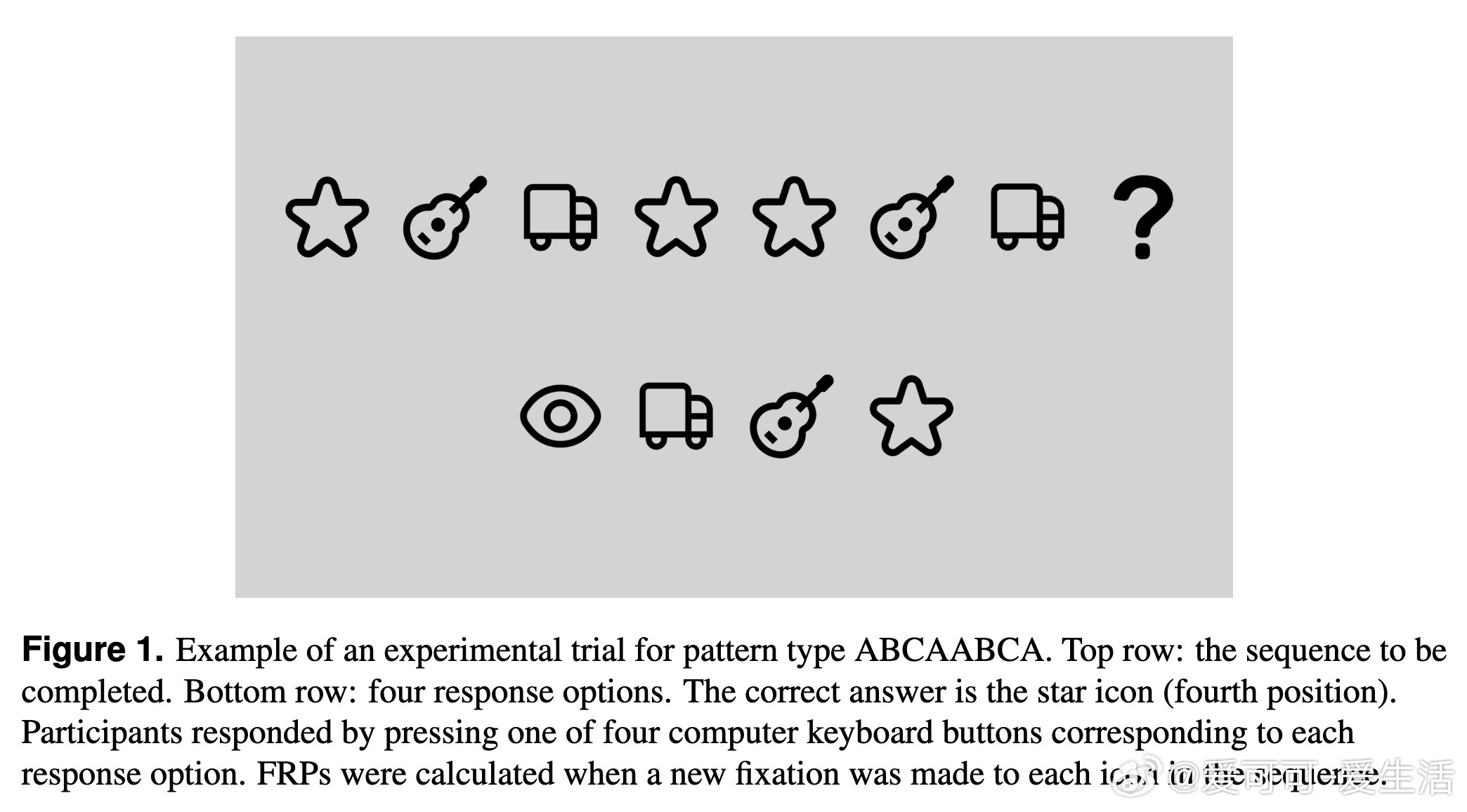

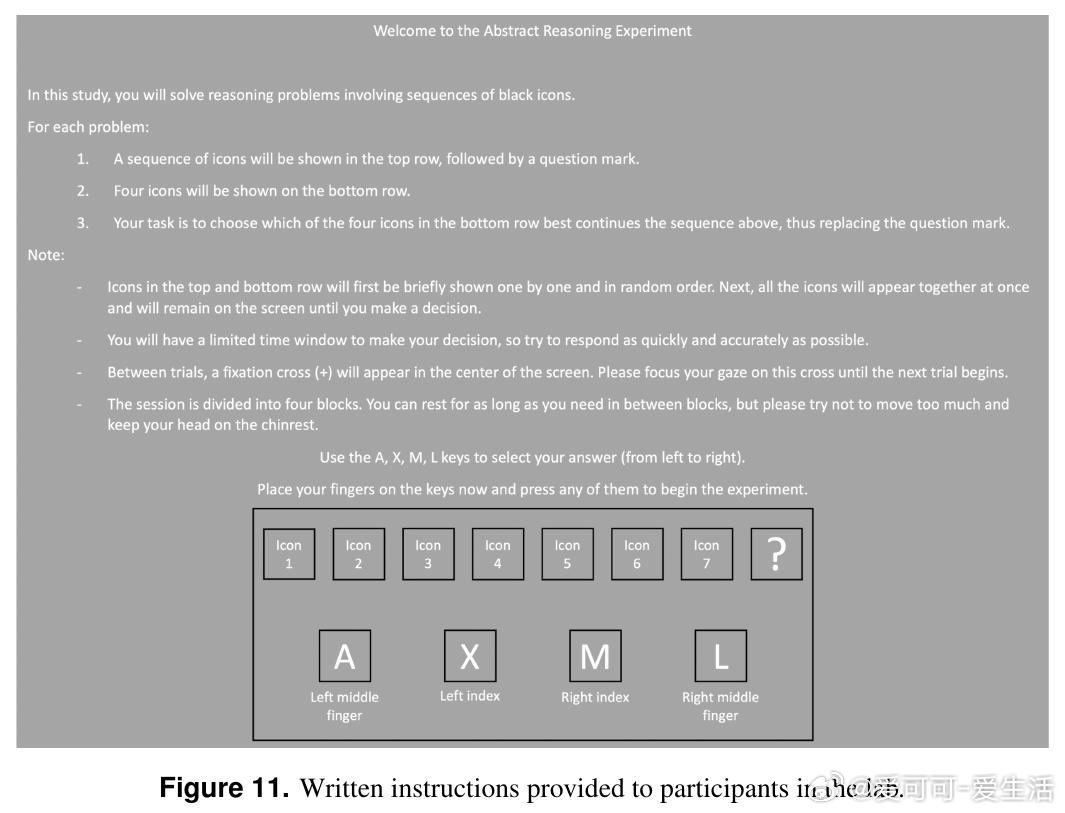

• 研究比较了25名人类参与者与8款开源大型语言模型(LLMs)在抽象图案补全任务上的行为表现和神经表征,利用眼动相关电位(FRPs)与EEG同步记录人脑活动。

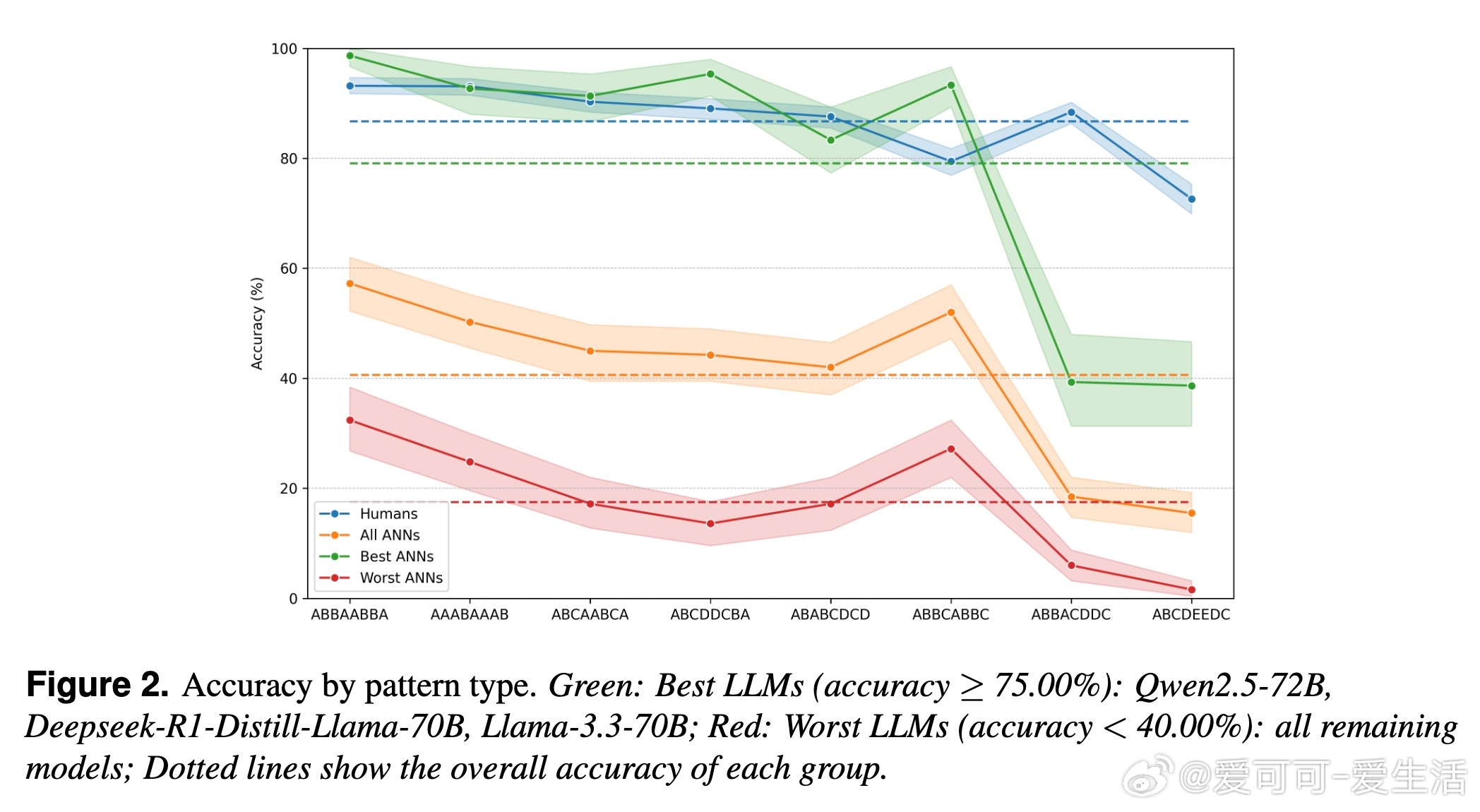

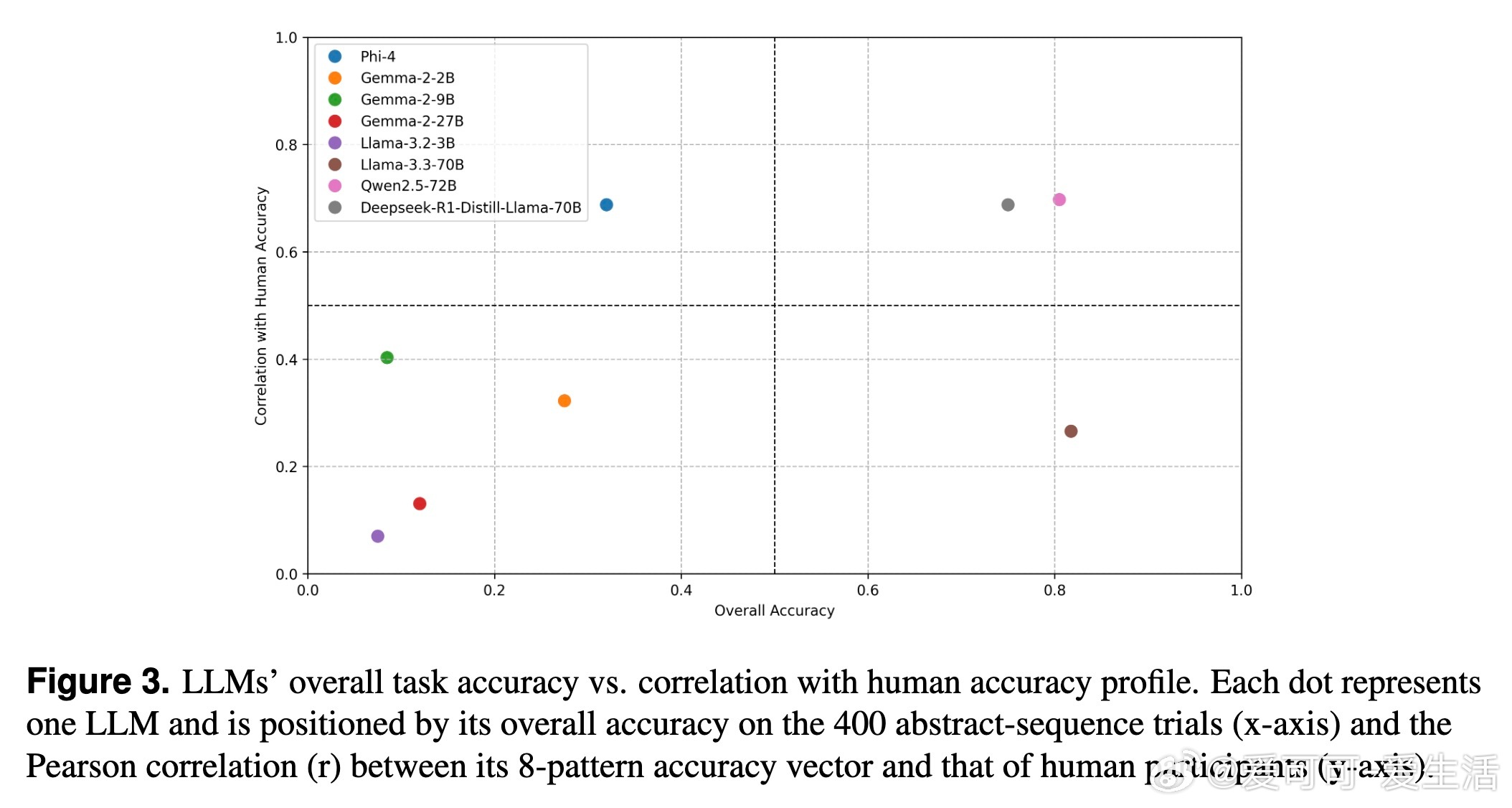

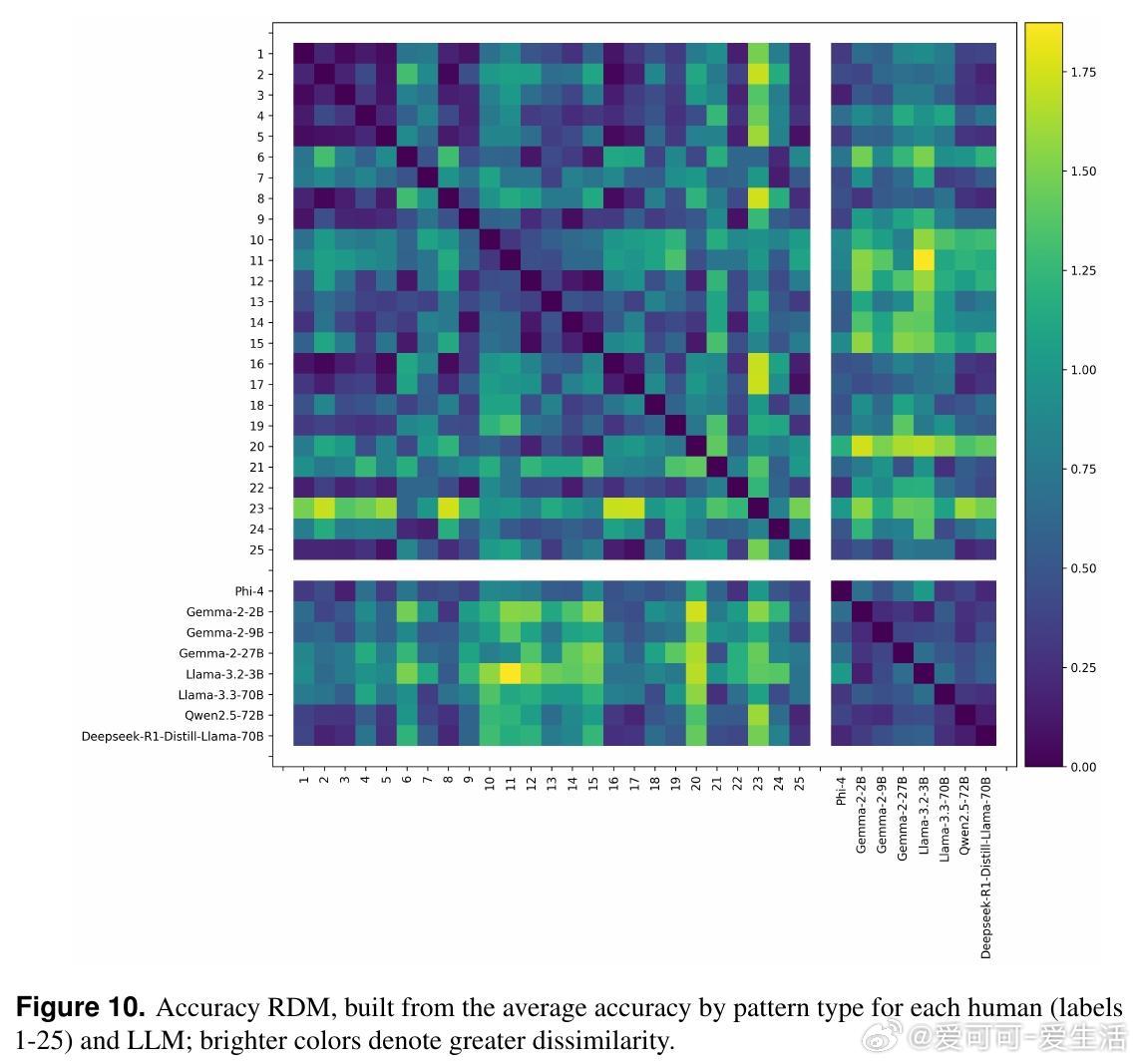

• 仅约70亿参数级别的最大模型(如Qwen2.5-72B、DeepSeek-R1-70B)达到人类水平的准确率(约80%),并且其对不同图案类型的难度分布与人类高度相关(Pearson r约0.7)。

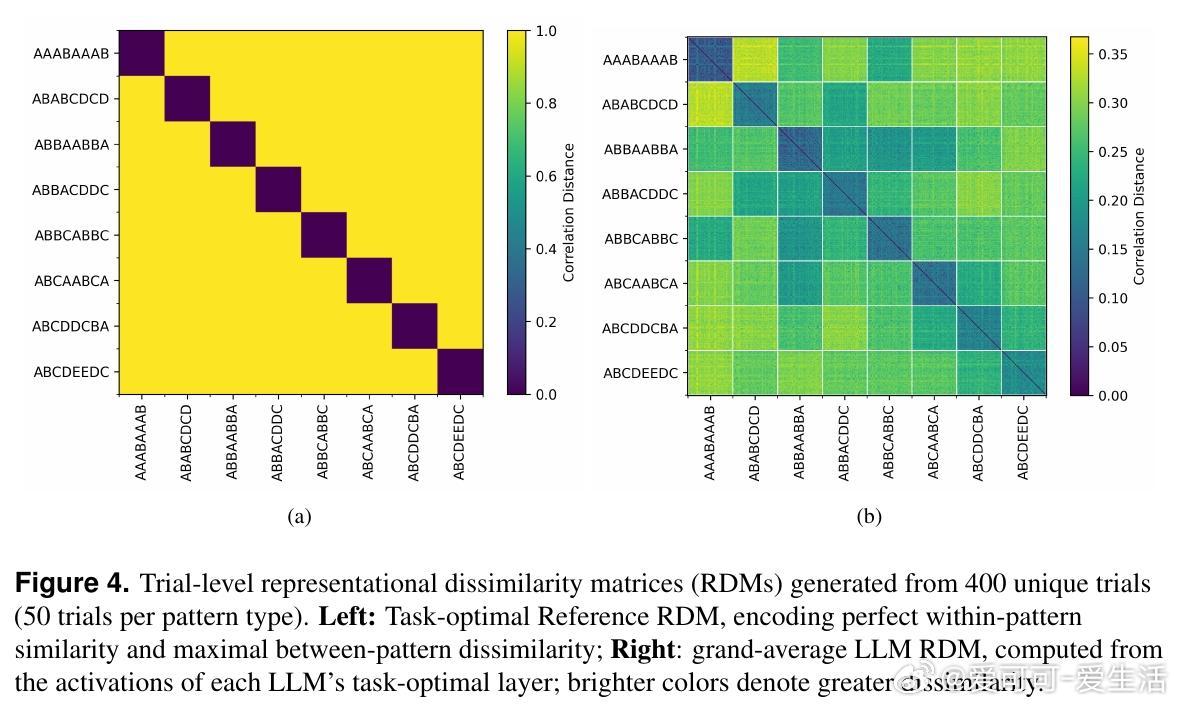

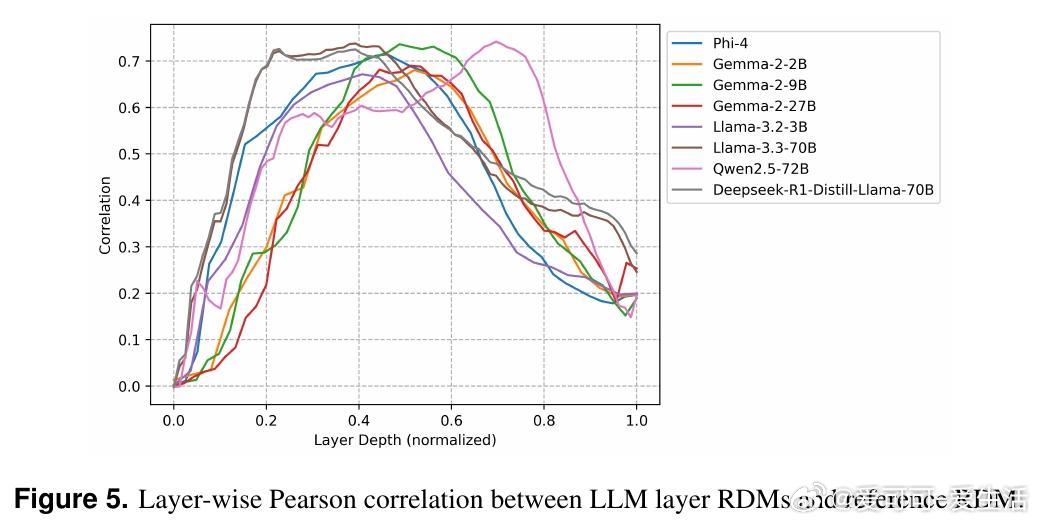

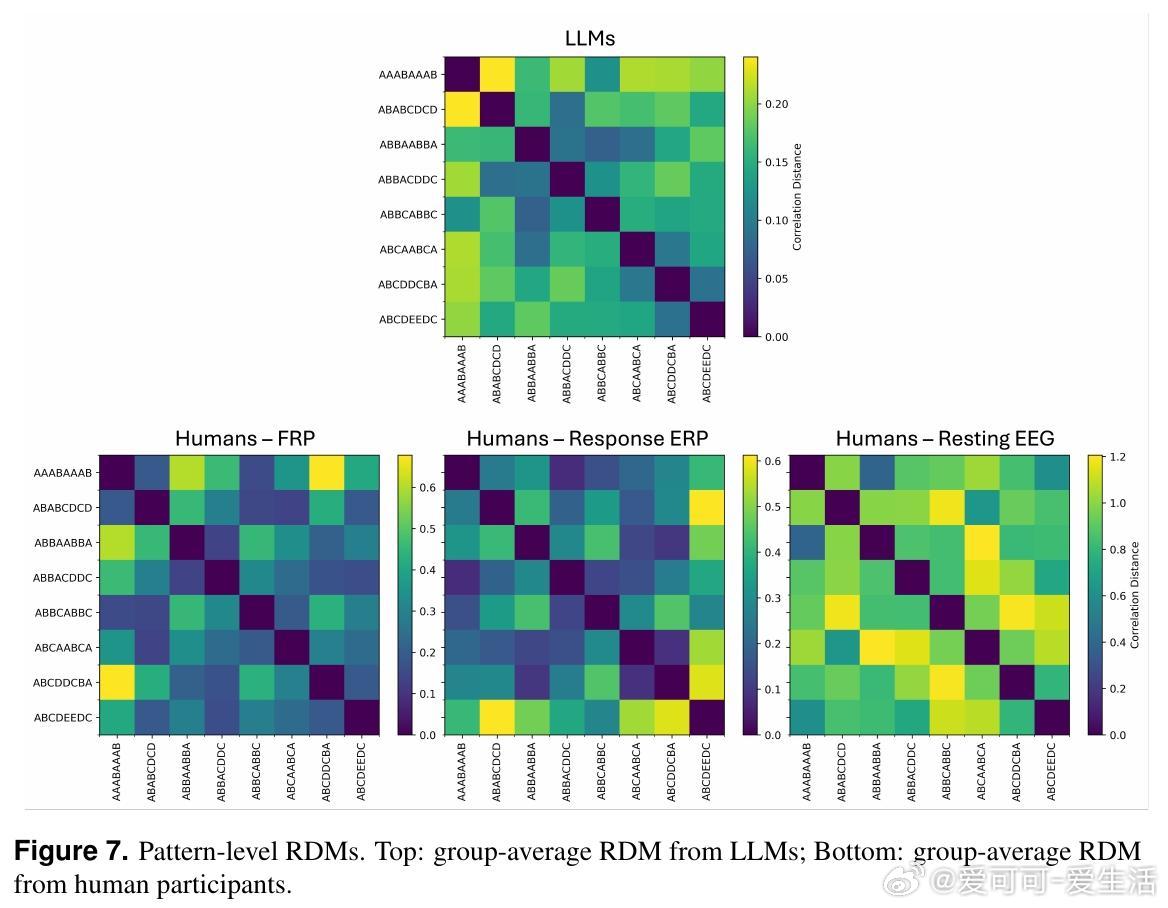

• 所有LLMs的中间隐藏层均形成了清晰区分8种抽象图案类别的表征结构,且这种层内表征的几何一致性与模型任务表现正相关(r=0.71)。

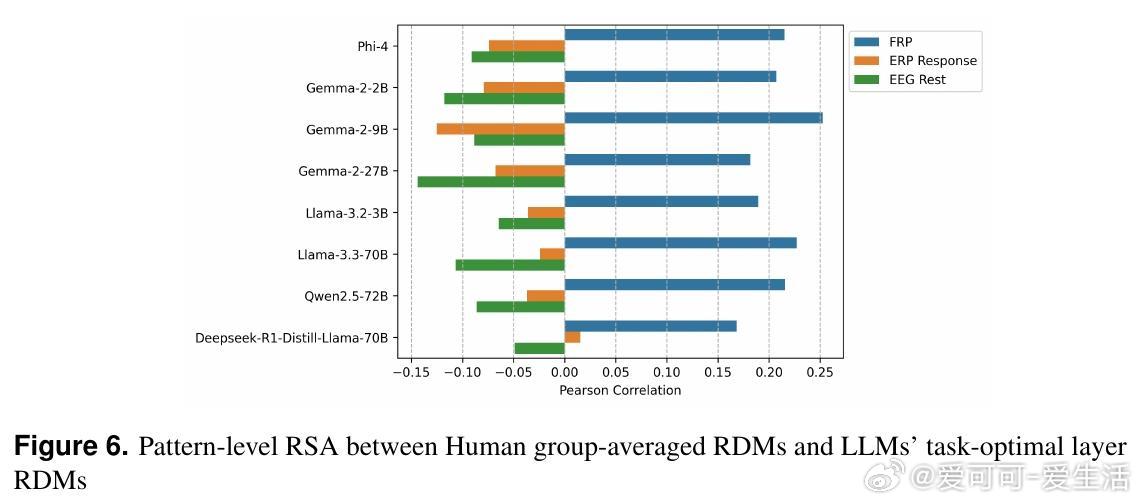

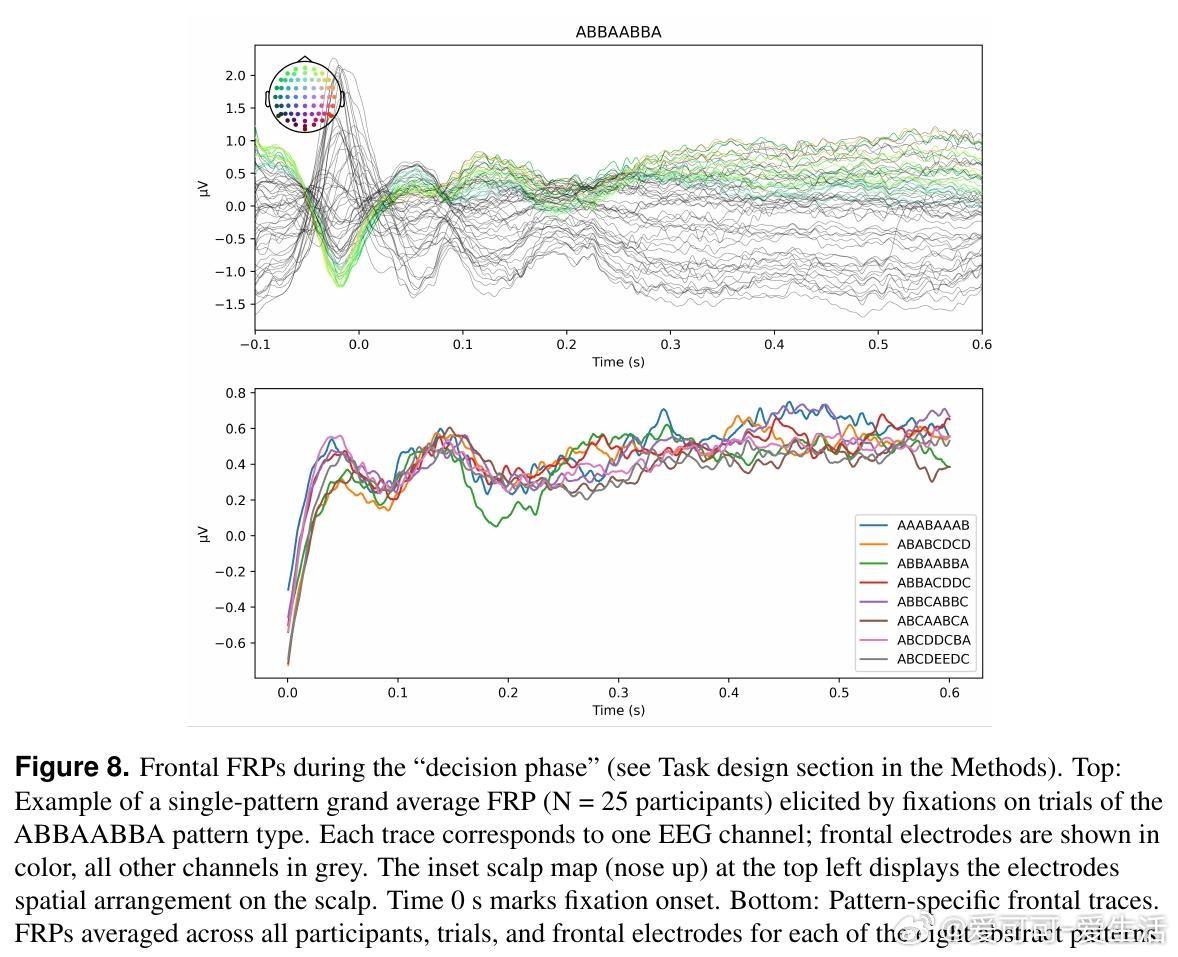

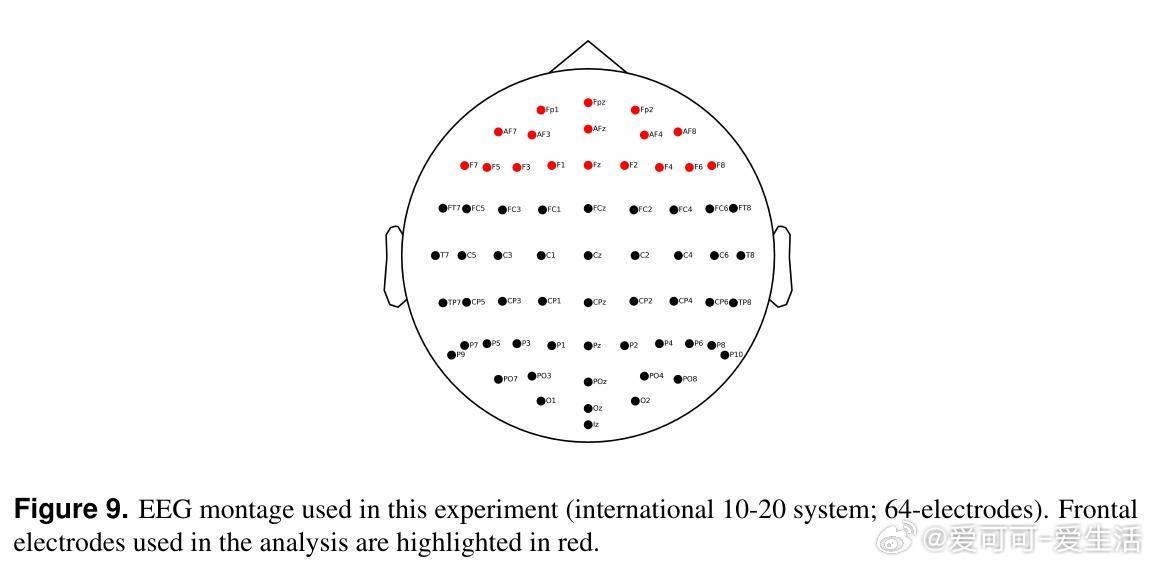

• 通过代表性相似性分析(RSA),发现中间层的表征几何与人类前额叶FRPs存在适度正相关(r≈0.17-0.25),而传统的反应锁定ERP和静息态EEG未表现出这种对应,提示FRP可更自然反映认知过程。

• LLMs中间层编码的抽象规则与人脑在自然视觉探索中对规则的神经编码呈现潜在的共享空间,支持人工智能与生物智能间存在部分共通的认知机制。

• 研究揭示,鼓励模型进行链式推理和强化学习微调(例如DeepSeek-R1相较于Llama-3.3)能显著提升其与人类表现的相似度,尽管整体准确率略有下降。

• 该工作首次将神经科学方法应用于评估LLMs在抽象推理中的内部表征,推动理解机器与人脑如何共同构建抽象思维的表征。

• 局限包括样本量有限、任务视觉与文本模式不匹配、EEG信噪比限制及统计功效不足,未来可结合fMRI、多模态输入和更精细的脑-模型对齐技术深化研究。

详情链接🔗 arxiv.org/abs/2508.10057

人工智能神经认知大型语言模型抽象推理认知科学脑机对齐EEG代表性相似性分析