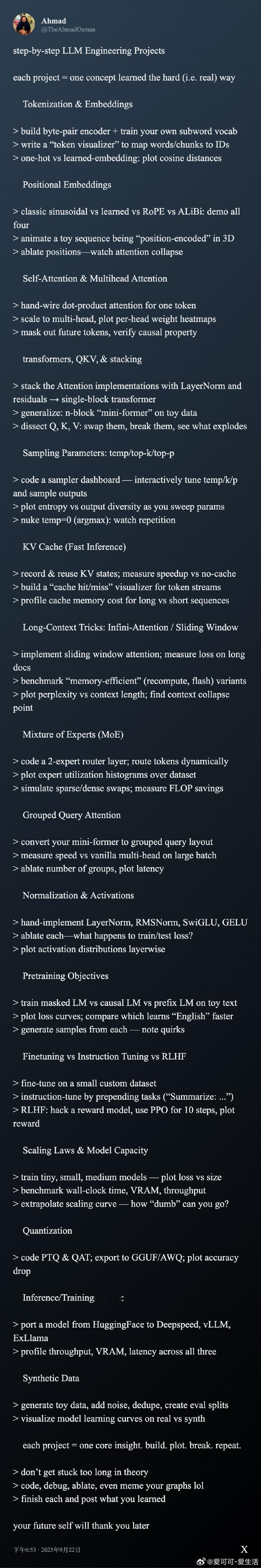

LLM 工程实战全流程拆解,系统掌握核心机制与优化技巧:

• Tokenization & Embeddings:自建 byte-pair encoder,训练子词词表,设计 token 可视化工具,比较 one-hot 与学习型 embedding 的语义距离差异。

• Positional Embeddings:对比传统正弦编码、learned、RoPE 和 ALiBi,3D 动画演示位置编码过程,剔除位置信息观察注意力崩溃。

• Self-Attention & Multihead Attention:手写点积注意力,扩展多头并绘制权重热图,验证因果掩码效果。

• Transformers 结构:层叠 Attention、LayerNorm、残差,构建单块及多块“mini-former”,实验 Q/K/V 的功能影响。

• 采样参数调优:搭建交互式采样仪表盘,调节温度、top-k、top-p,分析熵与输出多样性关系,剖析温度为零导致的重复。

• KV Cache 加速推理:实现缓存机制,测量速度提升,设计缓存命中可视化,评估长短序列内存消耗。

• 长上下文处理:滑动窗口、Infini-Attention、内存高效重计算对比,绘制困惑度随上下文长度变化曲线,捕捉上下文崩溃点。

• Mixture of Experts (MoE):编码双专家路由层,统计专家利用率,模拟稀疏与稠密切换,量化 FLOP 节省。

• Grouped Query Attention:转化为分组查询结构,测试大批量速度,消融组数对延迟的影响。

• 归一化与激活函数:手写 LayerNorm、RMSNorm、SwiGLU、GELU,剖析各自对训练/测试损失的贡献,激活分布层级可视化。

• 预训练目标对比:masked LM、causal LM、prefix LM 训练对比,损失曲线及样本生成差异。

• 微调 vs 指令调优 vs RLHF:小数据集微调,任务前缀指令调优,PPO 强化学习优化奖励模型,绘制奖励曲线。

• 规模法则与模型容量:不同规模模型损失对比,显存、吞吐、训练时间基准,扩展曲线预测极限。

• 量化技术:实现 PTQ 与 QAT,导出 GGUF/AWQ 格式,衡量精度损失。

• 推理/训练栈迁移:从 HuggingFace 迁移至 Deepspeed、vLLM、ExLlama,性能、显存和延迟全面剖析。

• 合成数据实验:生成带噪声玩具数据,去重和数据拆分,实测真实 vs 合成数据学习曲线差异。

每个项目都从实操中提炼核心认知:构建、调试、破坏、复盘,远离死板理论,持续输出经验。未来的你会感谢现在的坚持。🛠️

详细拆解见👉 x.com/TheAhmadOsman/status/1970078993211646134

LLM工程 大模型 机器学习 深度学习 AI研究 模型优化