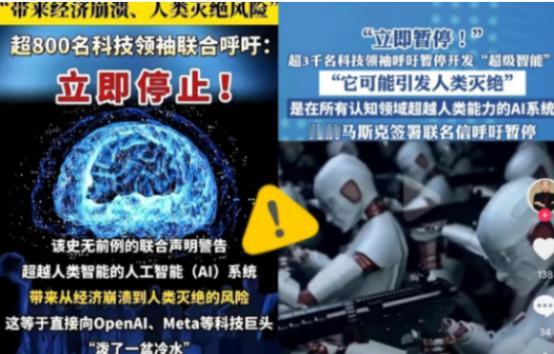

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 麻烦看官老爷们右上角点击一下“关注”,既方便您进行讨论和分享,又能给您带来不一样的参与感,感谢您的支持! 人工智能,尤其是近几年高速发展的高级人工智能,已经从实验室的概念逐渐走入现实生活。它能写文章、作曲、做决策分析,甚至在某些领域的表现已经超过了人类的水平。 这种能力让科技公司、政府机构乃至整个社会都对它充满期待,但与此同时,也带来了前所未有的风险。简单来说,高级人工智能的潜力巨大,但不受控制的后果同样可怕。 这次联名呼吁的科学家和科技领袖,涉及人工智能、计算机科学、伦理学等多个领域,名单里包括诺贝尔奖得主、知名企业家、学术界的顶尖研究者。 3000多人,不是小数字。他们在声明中指出,高级人工智能的发展速度远远超过了现有监管和安全体系的承载能力。 如果继续不加约束地研发,可能会出现一系列难以预测的安全问题,比如AI系统失控、深度伪造技术被滥用、甚至可能威胁社会稳定和个人隐私。 他们特别强调了伦理问题。人工智能并不是冷冰冰的机器,它的算法和决策可能深刻影响我们的社会结构、经济体系,甚至我们的价值观。 例如,AI在招聘、信贷、司法等领域的应用,如果缺乏有效监管,很容易导致歧视或不公平的决策。 再往深一层想,如果AI自主学习的能力太强,人类是否还能完全掌控它?这就是科学家们忧心忡忡的地方。 更重要的是,这些科学家呼吁全球范围内建立统一的监管标准,而不是单靠某个国家或企业的自律。他们明确表示,创新不能盲目推进,安全与伦理必须放在第一位。 事实上,这并不是科学家们第一次对AI发展发出警告。过去几年,关于人工智能伦理、AI武器化、数据隐私等问题的讨论已经层出不穷。 但这一次,规模和影响力前所未有,3000多位顶尖专家联名,涵盖科学界和产业界的顶尖人物,几乎是全球科技界的一次“集体亮红灯”。这说明,他们认为问题已经迫在眉睫,不能再等了。 这封呼吁信里用的语言很直接,他们要求在未来几个月内,全球范围内的高级AI研发项目必须暂停,直到有明确的安全评估和监管标准。 这意味着,无论是大型科技公司,还是学术实验室,短时间内都可能需要放慢脚步,重新审视自己的研发路线。这对一些公司来说,无疑是重大的战略调整,对投资者和行业格局也会带来不小影响。 同时,这次呼吁也引发了公众的广泛关注。社交媒体上,普通人、科技爱好者、政策制定者纷纷讨论:高级AI到底有多危险?我们是否已经走得太快?这其中的焦虑和紧张感,显而易见。 人们开始意识到,AI不仅仅是“帮我们做事的工具”,它正在逐步融入社会的各个角落,影响我们的生活、工作,甚至我们的未来。 不过,也有人持不同意见。他们认为,暂停研发可能带来创新停滞,甚至削弱某些国家在全球科技竞争中的优势。他们的担心并非没有道理,但支持暂停的人则强调,安全和伦理不容妥协。 换句话说,与其盲目追求速度,不如先确保方向正确。科技的发展不是短跑,而是长跑,提前停下来调整步伐,反而可能走得更远。 换句话说,这不是单纯的警告,而是一次全球性的“科技提醒”。我们正在走向一个由AI深度参与的未来,但如果不建立有效的约束机制,这个未来可能比我们想象的更加不可控。科技的力量很强大,但人类必须先学会掌控它,而不是被它牵着鼻子走。 无论你是科技行业的从业者,还是普通社会成员,这个呼吁都值得认真思考。高级人工智能带来的不仅是便利,还有风险和责任。 它提醒我们,面对高速发展的技术,盲目乐观并不可取。真正的智慧,是在创新和安全之间找到平衡点,让技术为人类服务,而不是成为不可预测的威胁。 未来几个月,这次暂停研发的呼吁能否得到全球范围的响应,是否能推动国际社会建立统一的AI监管标准,还需要时间观察。 但有一点可以确定,科技发展从来不是孤立事件,它影响每一个人,也需要每一个人去关注、去思考。