大小语言模型对比分析及启示

大语言模型和小语言模型的区别在于,大语言模型使用大量文本数据训练的深度学习模型,可以生成自然语言文本或理解语言文本的含义。而小语言模型则是在大型文本数据集上训练的人工智能系统,可实现生成文本、总结文档、语言之间翻译和回答问题等功能。

近期一些迹象表明,小语言模型正逐渐获得越来越多的重视,微软、GOOGLE等AI领域的大佬们纷纷开始下注小语言模型。

大语言模型轻量化渐成趋势

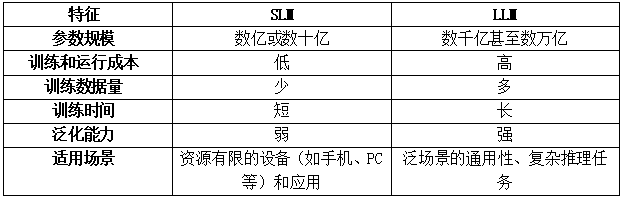

LLM(大型语言模型)的参数规模惊人,可达数千亿甚至数万亿。与之相比,SLM(小型语言模型)通常具有数亿或数十亿个参数。由于训练和运行所需的时间及资源较少,SLM更适用于资源有限的设备和应用场景。

1. 多家AI巨头引领,发布多款SLM小模型

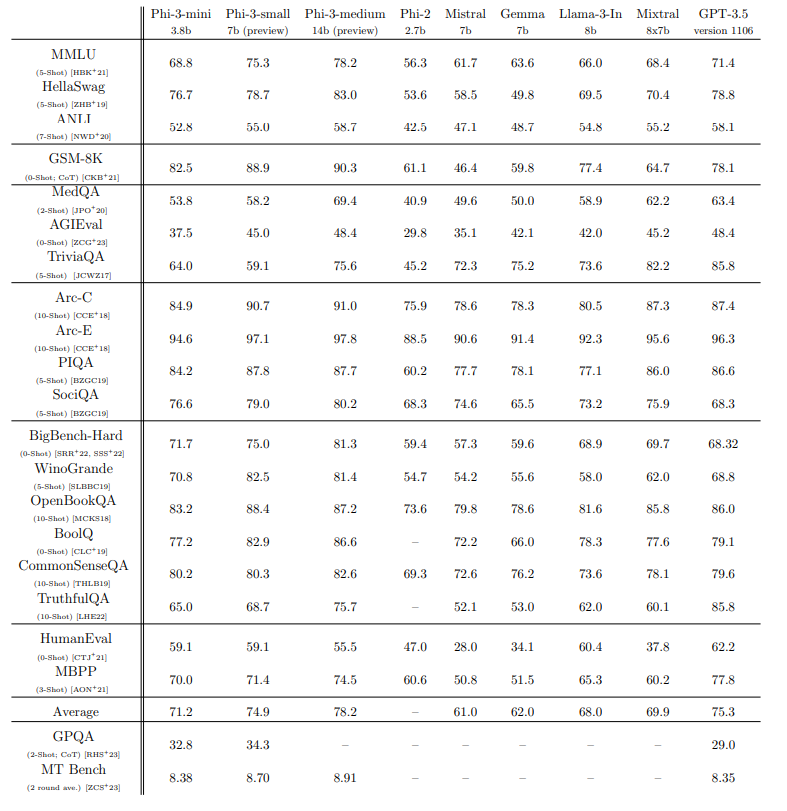

微软早期发布了 Phi-1.5 版本,13 亿参数。1.5版本可以写诗、写电子邮件和故事,以及总结文本。在12月14日更新发布了 Phi-2 ,拥有 27 亿参数。今年4 月 23 日,微软发布了 Phi-3 Mini,这是Phi-3系列小型模型中的第一个,Phi-3 Mini 可测量参数仅为 38 亿,并在相对于 GPT-4 等大型语言模型更小的数据集上进行训练,现已在 Azure、Hugging Face 上可使用。Phi-3 Mini 的性能比前一版本更好,与 GPT-3.5 等 LLM 不相上下,微软后续还计划发布 Phi-3 Small(7B 参数)和 Phi-3 Medium(14B 参数)两个版本。

今年2月,Google 发布了 Gemma 2B 和 7B,这两款模型更适合简单的聊天机器人和语言相关的工作。Gemma 模型可轻松运行在普通设备上,无需特殊硬件或复杂优化,它提供高效、易用的语言处理体验。Gemma 在 Hugging Face 的下载量已经突破 400,000 次,并激发了Cerule、CodeGemma等创新项目。性能表现方面, Gemma在MMLU、MBPP等18个基准测试中,有11个测试结果超越了Mistral-7B等模型。

图1展示了Phi-3与Gemma、GPT3.5等模型的性能对比(数据来源:Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone)。

2. 大语言模型轻量化的几个特征

除了原生的SLM小语言模型外,大语言模型也在通过各种手段压缩规模,以期适应更多的应用场景。模型压缩的方式主要包括模型量化、知识蒸馏、模型剪枝、低秩适应、权值共享、结构搜索等。目前,多个大语言模型均已推出“小型化”和“场景化”版本,为端侧运行提供了基础。

例如,Google PaLM2中最轻量的“壁虎”壁虎(Gecko)可实现手机端运行,速度足够快,不联网也能正常工作。Meta在官网上公布了旗下最新大语言模型Llama 3。已经开放了80亿(8B)和700亿(70B)两个小参数版本,Llama 3 8B模型在MMLU、GPQA、HumanEval等多项性能基准上均超过了Gemma 7B和Mistral 7B Instruct。

表1:大小语言模型的特征

SLM和LLM的对比

1. 技术特点

SLM和LLM是两种不同的技术,它们在架构设计、训练、数据生成和模型评估方面都遵循概率机器学习的类似概念。SLM通常采用传统的Transformer架构,而LLM则采用更复杂的架构,如GPT-3的解码器-编码器架构和Megatron-Turing NLG的解码器-编码器-解码器架构 。

大语言模型遵循缩放定律,规模越大,性能越强。LLM以其卓越的性能和泛化能力脱颖而出,而SLM则以其低训练和运行成本著称。

2. 优劣势比较

表2:LLM和SLM的优劣势比较

3. 应用场景

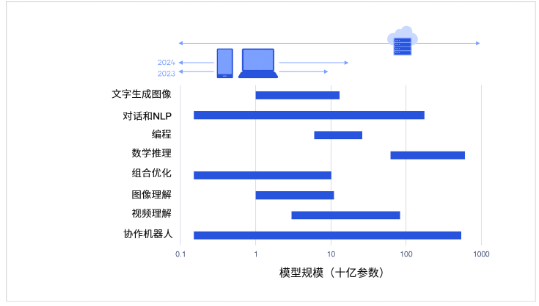

在实际应用中,LLM主要服务于云端,以应对泛领域和复杂推理任务。而SLM则更侧重于端设备及特定领域的处理需求。据HuggingFace的CEO Clem Delangue称,端设备的应用场景多达99%,正因为如此,SLM在解决实际问题上具有显著优势。同时,高通预测生成式AI模型将大量从云端转移到终端进行运行。

图2:大量生成式AI模型可从云端迁移至终端设备,实现高效运行。(来源:高通研究,混合AI:AI未来新篇章)

运营商发展大语言模型面临的问题

1. 资金、技术、数据、人才等方面存在短板

LLM可以充分发挥电信运营商云、网、算力等资源的优势,更好地泛化到新任务和新数据,应用于更广泛的场景。但是, LLM 的训练和运行需要大量算力,训练时间长,部署和维护的难度高,与其它大语言模型一样,存在偏见和安全风险。不仅如此,与互联网巨头比,运营商在资金、技术、数据、人才等方面都存在一定短板。资金上,互联网巨头有更广泛的融资渠道;技术上,与前沿大语言模型相比,运营商大语言模型在参数数量、性能上存在差距,研发处于跟随地位;数据上,优质数据集的数量和质量有限;此外,AI研发人才也短缺。

2. 应用场景受限

LLM大模型在各领域广泛应用,包括机器翻译、问答系统和文本生成等通用场景,以及针对特定行业数据集的行业应用。对于运营商的LLM,其内部可用于客服和网运,而外部则可为政企客户和公众客户提供全面的AI服务。

由于大模型厂商众多,市场竞争激烈,通用AI服务面临挑战。然而,垂直行业应用将成为运营商LLM的未来蓝海。这些行业通常拥有专业且高质量的数据集,尽管数据规模不一定庞大,但对隐私和安全性要求严格。尽管LLM大模型能够适应这些需求,但高昂的成本和潜在的安全风险限制了其广泛应用。

对运营商的启示

1. 面向众多行业应用场景,加强对SLM的研发

随着AI技术的蓬勃发展,SLM的性能与功能将不断升级,其终端能力日益强大。未来,越来越多的AI推理工作负载将在手机、PC、XR头显、汽车等边缘终端上运行,为SLM带来更广阔的应用空间和更多场景落地。

运营商拥有庞大的客户群体,各种客户对AI的需求各异。以政企业务为例,目前政企产品主要分为三类:标准化产品和平台、小微ICT项目、复杂集成DICT项目。对于标准化产品和平台,通过运用云和LLM技术,可以为客户实现AI赋能。而在小微ICT项目和复杂集成DICT项目中,很多情况下,SLM会是客户的首选方案。

2. 用SLM降低研发运营成本,促进创新和迭代

SLM具有低成本、低风险的优势,便于创新和迭代。此外,边缘终端以高效能运行SLM,有效减少云侧资源消耗,助力运营商降低数据中心能耗,实现企业降本增效。

SLM不仅助力提升运营商服务能力,增强客户粘性,还可提高客户满意度。借助SLM开源社区和众多客户,构建卓越AI生态,轻松试错,探索新应用场景与商业模式。成熟后,可与LLM结合,应对复杂业务挑战,推动运营商业务繁荣发展。

3. 通过LLM和SLM结合建立差异化竞争优势

在LLM领域,科技巨头已独占鳌头。对于数据集规模较小的客户,采用小模型更具性价比。运营商可结合LLM与SLM,在特定领域创造竞争优势,如专注垂直行业,采用低成本、高性能的SLM模型,实现智能化服务升级。对于复杂的AI需求,可通过网络和云端LLM解决SLM性能及知识局限问题。

根据客户需求选择合适模型,云侧LLM与端侧SLM相结合,助运营商建立差异化竞争优势,打造企业坚实护城河。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-