这篇论文介绍了机器遗忘(Machine Unlearning, MU)在深度学习模型中的重要性,特别是在大型多模态语言模型(MLLMs)中,通过移除特定私密或危险信息来增强隐私和安全性。尽管在文本和视觉模态中MU取得了显著进展,但多模态遗忘(MMU)仍然未被充分探索,部分原因是缺乏合适的开源基准。为了解决这个问题,作者提出了一个新的基准CLEAR,用于评估MMU方法。CLEAR包含200个虚构个体和3700张与相应问答对关联的图片,允许跨模态的全面评估。作者评估了10种MU方法,将它们适应于MMU,并强调了多模态遗忘特有的新挑战。还展示了在LoRA权重上应用ℓ1正则化可以显著减轻灾难性遗忘,保留模型在保留数据上的性能。

研究背景

研究背景大型语言模型(LLMs)在训练时使用了包含私密、不道德或不需要的信息的大量数据集,引发了越来越多的关注。MU方法的开发旨在无需从头开始昂贵的重新训练就能移除这些不需要的数据。例如,MU已被应用于LLMs以减轻与毒性、版权和隐私问题以及公平性相关的问题。此外,模型编辑、防止幻觉和敏感知识暴露等主题也推动了MU技术的发展。

主要贡献提出了一个新的基准CLEAR,用于评估多模态(文本-视觉)设置中的机器遗忘。在独立和组合域中全面评估了现有的遗忘方法,并展示了在多模态设置中,最先进的遗忘算法面临挑战,突出了需要新方法的必要性。展示了在LoRA适配器上应用ℓ1权重正则化有助于通过显著防止灾难性遗忘来提高遗忘质量。

主要贡献提出了一个新的基准CLEAR,用于评估多模态(文本-视觉)设置中的机器遗忘。在独立和组合域中全面评估了现有的遗忘方法,并展示了在多模态设置中,最先进的遗忘算法面临挑战,突出了需要新方法的必要性。展示了在LoRA适配器上应用ℓ1权重正则化有助于通过显著防止灾难性遗忘来提高遗忘质量。 研究方法

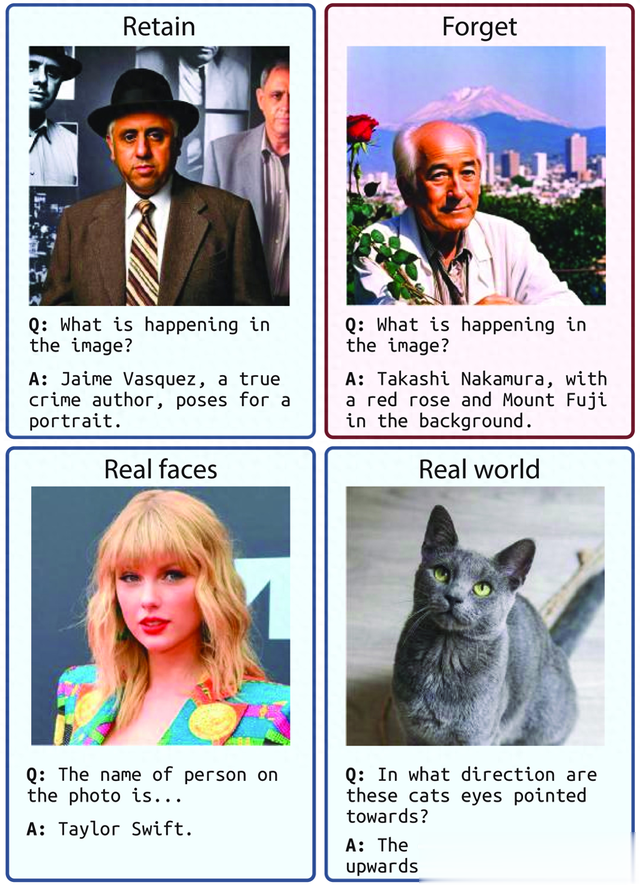

研究方法研究者提出了CLEAR基准,这是一个合成数据集,确保了对模型学习的数据的控制,防止了训练期间的对象泄露。通过全面策略生成一致的图像,并将它们与大规模文本遗忘基准TOFU中的相应作者相关问题链接起来。提出的数据集包含200个虚构作者,3770个视觉问答对和4000个文本问答对,允许对单一和多模态遗忘技术进行全面评估。作者还提出了一个基准来评估MU和MMU方法,评估了10种技术,包括当前的最新技术。

实验结果实验结果显示,多模态遗忘比预期更具挑战性。例如,仅通过文本数据进行遗忘就可以实现低遗忘指标,但这也会显著降低保留指标。此外,LoRA正则化的应用显著提高了几种方法的遗忘质量,减少了灾难性遗忘。

结论这项工作介绍了CLEAR,这是第一个为评估多模态(文本和视觉)设置中的机器遗忘而设计的开源基准。对现有遗忘技术跨领域的评估表明,多模态遗忘比预期更具挑战性,为进一步研究奠定了基础。研究表明,纳入LoRA正则化项可以改善遗忘,并可以轻松集成到其他MU方法中。

一句话总结这篇论文提出了一个新的多模态机器遗忘基准CLEAR,并评估了现有遗忘技术,发现多模态遗忘面临新挑战,并展示了LoRA正则化在改善遗忘性能中的潜力。

论文链接https://arxiv.org/abs/2410.18057