智东西4月17日报道,今日凌晨,OpenAI重磅发布两大视觉推理模型OpenAI o3和o4-mini,这也是OpenAI o系列中首次可以使用图像进行思维链推理的模型。OpenAI还开源了轻量级编程Agent Codex CLI,发布不到7个小时,Star数已超5500。

这两个模型的区别在于,OpenAI o3是最强大的推理模型;OpenAI o4-mini是一个针对快速、成本效益推理进行优化的较小模型。新模型首次将图像融入思维链过程,还能自主调用工具,在一分钟内生成答案。

OpenAI开源的编程Agent Codex CLI能最大化模型推理能力,可在端侧部署。今日OpenAI还在AI编程领域曝出重磅收购交易。据外媒报道,OpenAI正在洽谈以30亿美元(约合人民币219亿元)收购AI辅助编程工具Windsurf(前身为Codeium),这将是OpenAI迄今规模最大的一笔收购。

今天起,ChatGPT Plus、Pro和Team用户可以使用o3、o4-mini和o4-mini-high,这些模型会取代o1、o3-mini和o3-mini-high。ChatGPT企业和教育用户将在一周后获得访问权限。免费用户可以在提交查询前选择“思考”来尝试o4-mini。OpenAI预计在几周内发布OpenAI o3-pro,并配备完整工具支持。目前Pro用户仍可访问o1-pro。o3和o4-mini通过Chat Completions API和Responses API向开发者开放。

OpenAI联合创始人兼CEO Sam Altman在社交平台X上发文盛赞o3、o4-mini是“天才水平”。

正在被OpenAI洽谈收购的Windsurf,正式名称为Exafunction Inc.,成立于2021年,已筹集超过2亿美元的风险投资资金,估值30亿美元,近期与其洽谈融资事宜还包括Kleiner Perkins和General Catalyst在内的投资者。去年11月,Windsurf发布了全球首个智能体IDE。

Windsurf发布全球首个智能体IDE(Agentic IDE)

近期AI编程创企融资火爆,Cursor背后的初创公司Anysphere在今年早些时候与投资者洽谈以近100亿美元(约合人民币731亿元)的估值获得新融资。

此前OpenAI曾收购过向量数据库公司Rockset和远程协作平台Multi。如果收购Windsurf的新交易完成,OpenAI将进一步补充AI编程助手实力,与Anthropic、微软旗下Github、Anysphere等知名AI编程公司展开更直接的竞争。

交易条款尚未敲定,谈判仍有可能发生变化。

01. 用图像思考 手绘草图、颠倒文字都能处理o3和o4-mini模型可以直接将图像整合到思维链中,用图像来进行思考,并且其还会被训练推理在什么时间点使用哪种工具。

具体来看,模型可以解读人们上传的白板照片、教科书图表或手绘草图,如果图像模糊、颠倒,模型也能借助工具实时操作图像,如进行旋转、缩放或变换等,或者与Python数据分析、网络搜索、图像生成等工具协同工作,这些都是模型推理过程的一部分。

如用户上传一张随手拍的图片,可以询问模型图片“最大船只的名字、在哪里停靠”等问题。

例如在使用内置文献解决一道数学难题时,OpenAI o3可以在不使用搜索的情况下给出正确答案,o1则无法提供正确响应。

面对帮助用户“收集区域旅行数据、经济统计数据和酒店入住率,病直观分析趋势并推荐理想的扩张地点”这一复杂问题时,OpenAI o3的结果引用了更多与行业相关的来源,并提出了详细计划,同时预测现实世界的挑战并提供主动的缓解措施。相比之下,01的结果更为宽泛。

在根据用户上传的一张“手持节目单”照片进行分析后,OpenAI o3能够准确考虑日程安排并输出可用的计划,而o1存在不准确之处,某些节目时间错误。

模型能够根据遇到的信息做出反应和调整,例如,它们可以在搜索提供商的帮助下多次搜索网络、查看结果,并在需要更多信息时尝试新的搜索。这使得模型可以处理需要访问超出模型内置知识、扩展推理、综合和跨模态输出最新信息的任务。

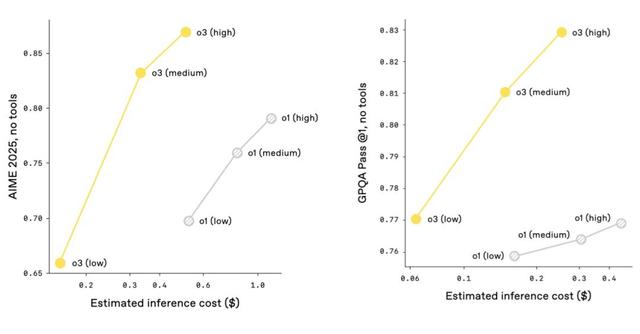

02. 多模态任务大幅优于前代模型 视觉推理准确率高达97.5%在成本和性能方面,OpenAI预计对于大多数实际应用,o3和o4-mini分别将比o1和o3-mini更智能且更便宜。

o4-mini和o3-mini在成本和性能方面的对比:

o3和o1在成本和性能方面的对比:

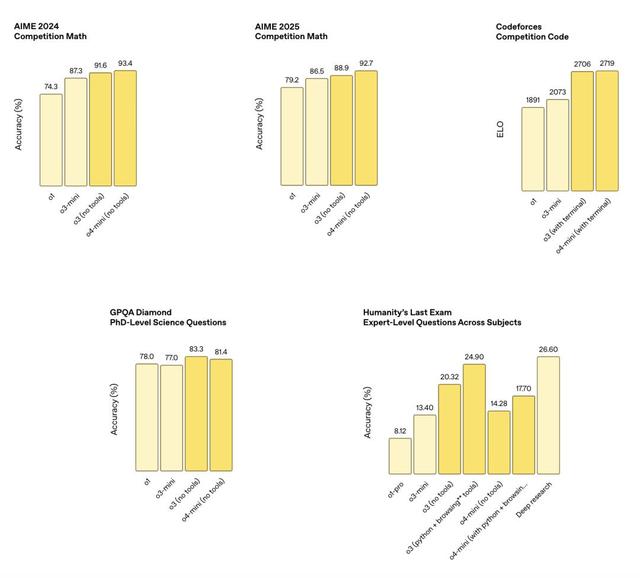

OpenAI在一系列人类考试和机器学习基准测试中测试了OpenAI o3和o4-mini,其结果显示,这些新的视觉推理模型在所有测试的多模态任务上都显著优于前代模型。

其中,无需浏览的图像思维几乎在其所有评估的感知基准测试中均取得了显著提升。OpenAI o3和o4-mini在STEM问答(MMMU、MathVista)、图表阅读和推理(CharXiv)、感知原语(VLMs are Blind)和视觉搜索(V*)方面均达到了新的最先进性能。在V*上,新模型的视觉推理方法达到了95.7%的准确率。

o3在分析图像、图表和图形等视觉任务上表现更好。外部专家的评估中,o3在困难、现实世界的任务上比OpenAI o1少犯20%的重大错误。早期测试者强调了其在生物学、数学和工程背景中分析严谨性问题的能力,以及可以生成和批判性地评估新颖假设的能力。

在专家评估中,o4-mini在非STEM任务以及数据科学等领域表现超过o3-mini。且o4-mini支持比o3高得多的使用限制,具备高容量、高吞吐量的优势。

外部专家评估员认为这两个模型都表现出比先前模型更好的指令遵循能力和更有用、可验证的响应,此外,新模型在自然对话方面,可以参考记忆和过去的对话来使响应更加个性化的回答。

多模态能力的评估结果:

编码能力的评估结果:

遵循指令和代理工具使用的评估结果:

03.

延续“更多计算=更好性能”思路

已开源轻量级编程Agent

03.

延续“更多计算=更好性能”思路

已开源轻量级编程Agent 在OpenAI o3的开发过程中,研究人员观察到大规模强化学习呈现出与GPT系列预训练中观察到的“更多计算=更好性能”的趋势相同。

他们通过在强化学习中追溯扩展路径,在训练计算和推理时间上又推进了一个数量级后,看到了模型明显的性能提升,这验证了随着模型被允许进行更多思考,其性能仍在持续提升。

与OpenAI o1相同的延迟和成本下,o3在ChatGPT中实现了更高的性能,并且其在博客中透露,研究人员已经验证,如果让模型思考更长的时间,其性能还会继续提升。

研究人员还通过强化学习训练了新模型使用工具,不仅包括如何使用工具,还包括如何推理何时使用工具。新模型可以根据期望结果部署工具,使得其在涉及视觉推理和多步骤工作流程等开放式情境的表现更好。

OpenAI还分享了一个轻量级的编程Agent Codex CLI,用来最大化o3和o4-mini等模型的推理能力,用户可以直接在终端运行,OpenAI计划支持GPT-4.1等更多API模型。

用户可以通过传递截图或低保真草图到模型,结合对本地代码的访问,从命令行获得多模态推理的好处。OpenAI认为这可以将模型与用户及其计算机连接起来。今天起,Codex CLI已完全开源。

开源地址:github.com/openai/codex

同时,OpenAI启动了一项100万美元倡议,以支持使用Codex CLI和OpenAI模型的工程项目,其将评估并接受以25000美元API信用额度形式提供的补助金申请。

04. 仍有三大局限性: 推理链过程、感知错误、可靠性不足不过,在博客中研究人员也提到,图像推理目前存在以下局限性:

过长的推理链:模型可能会执行冗余或不必要的工具调用和图像处理步骤,导致过长的思维链;

感知错误:模型仍然可能犯基本的感知错误。即使工具调用正确推进推理过程,视觉误解也可能导致最终答案不正确;

可靠性:模型可能在多次尝试解决问题时尝试不同的视觉推理过程,其中一些可能导致错误的结果。

在安全方面,OpenA重建了安全训练数据,在生物威胁(生物风险)、恶意软件生成和越狱等领域添加了新的拒绝提示。这使得o3和o4-mini在其内部拒绝基准测试中表现较好。

OpenAI还开发了系统级缓解措施,以标记前沿风险区域中的危险提示。研究人员训练了一个推理大模型监控器,该监控器基于人类编写的可解释安全规范。当应用于生物风险时,该监控器成功标记了人类红队行动中约 99%的对话。

研究人员更新了应急准备框架,对o3和o4-mini在框架涵盖的三个跟踪能力领域进行了评估:生物和化学、网络安全和AI自我改进。根据这些评估的结果,其确定o3和o4-mini在所有三个类别中均低于框架的“高”阈值。

05. 结语:发力视觉推理 迈向多模态推理OpenAI o3和o4-mini显著提升了模型的视觉推理能力,这些模型在视觉感知任务上的提升,使其能够解决之前模型难以触及的问题,标志着模型向多模态推理迈出的重要一步。

OpenAI在博客中提到,他们将o系列的专业推理能力与GPT系列的自然对话能力和工具使用能力相结合,未来可以实现模型能支持无缝、自然的对话,同时能主动使用工具并解决更为复杂的问题。

此外,研究人员也在不断优化模型使用图像进行推理的能力,使其更加简洁、更少冗余、更可靠。