11月27日消息,“大多数人不知道,关于Scaling Law的原始研究来自2017年的百度,而不是2020年的OpenAI。”

近日一则上述内容刷爆AI圈子,引发对百度研究能力的赞叹。

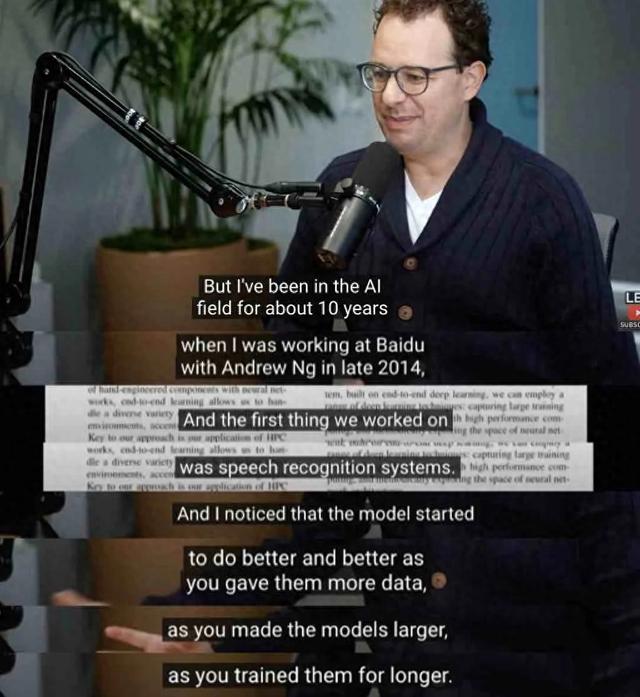

而事情的起因,则是Anthropic创始人Dario Amodei在一档播客节目中爆料:最早在百度工作时发现Scaling Law。

Dario Amodei是AI届的大牛,很多人知道他曾是OpenAI的初期员工,后来离开并创办Anthropic。事实上,Dario Amodei也是百度的“前员工”。

公开资料显示,Dario Amodei于2014 年 11 月至2015 年 10 月期间在百度工作,当时他在百度硅谷人工智能实验室(SVAIL)工作,致力于将深度学习模型扩展到大规模高性能计算系统。

再回到这则爆料中,这里先介绍一下Scaling Law(尺度定律):当模型的参数量、训练数据量和计算量增加时,模型的性能会按照一定的幂律关系提升。

如同芯片领域的从业者会以“摩尔定律”来理解、前瞻、指导芯片发展一样,Scaling Law被大语言模型(LLMs)研究者们认为是理解大模型发展的“金科玉律”,其重要性不言而喻。

这次Dario Amodei的爆料,可谓给Scaling Law的发现来了个“正本清源”,把百度推上了大模型研究先锋的位置上。

Anthropic创始人Dario爆出Scaling Law“正源”

今年11月12日,在Lex Fridman的播客节目中,Anthropic的联合创始人CEO Dario Amodei探讨了Claude、AI模型的扩展规律、AGI、AI未来等多个话题, 其中,在谈到大模型的扩展规律(Scaling Laws)与模型发展,他提到“他的观察最早来自于此前在百度工作时对语音识别系统的研究。”

Dario Amodei称,2014年与吴恩达在百度研究AI的时候,他就已经发现了模型发展的规律Scaling Law,“随着你给它们提供更多数据,随着你让模型变大,随着你训练它们的时间越来越长,模型的表现开始越来越好。当时我并没有精确地衡量,但我和同事们都非常非正式地感觉到,给这些模型的数据越多、计算越多、训练越多,它们的表现就越好。”

后来在Open AI的GPT-1的语言模型中得到了验证。他认为,随着模型变得越来越大,它们能够捕捉到更复杂的语言和认知模式,这一规律不仅适用于语言模型,还适用于图像、视频等其他领域。

随着Dario Amodei的爆料,更多行业人士扒出了关于Scaling Law起源的线索。

一位Meta研究员再次发布推文爆料:

"大多数人不知道,关于缩放定律的原始研究来自 2017 年的百度,而不是 2020 年的 OpenAI。

他们描述了模型参数和数据集标记对损失的影响。还对图像和音频进行了测试。

他们只是用 LSTM 代替了 Transformers,而且没有将他们的发现命名为“定律”。"

百度2017年论文被扒出一作研究被OpenAI 引用

上述推文将Scaling Law起源的讨论热度再度推高,有媒体人士跟帖贴出了百度在2017年发表的《DEEP LEARNING SCALING IS PREDICTABLE, EMPIRICALLY》论文。该论文详细讨论了机器翻译、语言建模等领域的Scaling现象。

图片来源:百度《DEEP LEARNING SCALING IS PREDICTABLE, EMPIRICALLY》

此前曾在Open AI工作,参与了GPT-3等重要项目开发的AI专家Gwern Branwen曾较早注意到了Scaling Law 。他经常提起:百度的这篇论文确实被忽视了。

这个故事还有后续。到2019年,百度的几位研究员Joel hestness、Gregory Diamos继续这项研究,再次发表了一篇论文《Beyond human-level accuracy: computational challenges in deep learning》。

而这篇论文,被OpenAI引述在其2020年的论文《Scaling Laws for Neural Language Models》中——这也是OpenAI举世闻名Scaling Law发现之作。

图片来源:OpenAI 论文《Scaling Laws for Neural Language Models》

扒到这里,Scaling Law原来源于百度的结论算是实锤了。

尽管外部对百度对Scaling Law的研究贡献因为爆料才刚刚被认知,对于百度而言可能“略感遗憾”。

不过也正是对Scaling Law的早期研究,让百度早在多年前就投入了AI大模型研究,并在2019年发布了第一代文心大模型——几乎与OpenAI处于同一时期。2023年,更是成为全球第一家推出生成式AI产品的科技大厂。