最让人担心的事情还是发生了?继频繁卡顿后,DeepSeek已暂停API服务充值通道。

01、DeepSeek暂停充值服务

一夜爆红后,新用户蜂拥而至,DeepSeek可能算力吃紧了。

近日,DeepSeek突然暂停其API服务充值,按钮显示灰色不可用状态。

随后,DeepSeek对此发表声明称,“当前服务器资源紧张,为避免对您造成业务影响,我们已暂停API服务充值。存量充值金额可继续调用,敬请谅解!”

此外,DeepSeek还提到,暂停充值是为了优先保障现有用户的使用体验,并非永久性决策。

DeepSeek的暂停充值消息一经发布,便引发了用户的担忧和讨论。

部分用户表示,此次事件可能会影响其业务的正常运行,尤其是那些依赖DeepSeek API进行开发和测试的企业。与此同时,也有用户对DeepSeek的未来表示乐观,认为其在优化算力资源后将能够更好地满足市场需求。

从市场角度来看,DeepSeek的暂停充值事件也引发了外界对其算力能力的质疑。有观点认为,DeepSeek可能需要借鉴OpenAI等大厂的经验,通过进一步扩展基础设施来应对未来的需求增长。

02、爆火后的算力压力

得益于其高性能的AI模型和广泛的市场推广,DeepSeek的日活跃用户数(DAU)在上线20天后突破了2000万,具体数字为2215万。这一数据在全球AI产品日活总榜中排名第二,仅次于ChatGPT的5323万日活用户数,同时超越了豆包的日活用户数1695万。

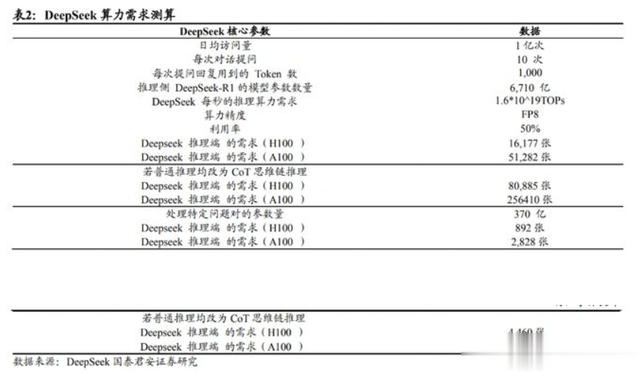

出色的数据表现显然会对算力造成压力,根据机构测算,假设DeepSeek的日均访问量为1亿次、每次提问10次,每次提问的回复用到1000个token,1000个token大概对应750个英文字母,则DeepSeek每秒的推理算力需求为1.6*1019TOPs。

在这种普通推理情境下, 假设DeepSeek采用的是FP8精度的H100卡做推理,利用率50%,那么推理端H100卡的需求为16177张,A100卡的需求为51282张。

DeepSeek有多少算力这个显然无法得知,但从“DeepSeek-V3模型在训练过程中使用了2048张H800 GPU,这些GPU的总计算能力为3.97 exaFLOPs(3.97百亿亿FLOPs)”“DeepSeek母公司幻方量化作为国内的私募资产管理巨头,早在2021年便储备了超过1万块英伟达A100/H100 GPU集群”等新闻线索中,可大致推测DeepSeek手上的算力。

与此同时,成本也会因为爆炸式增长的用户和合伙伙伴而出现压力,成本方面倒是可以参考“前辈”豆包。

2024年12 月18日,字节召开火山引擎Force 大会,火山引擎 CEO 谭待表示,截至目前,豆包大模型日均 tokens使用量超过 4万亿,发布7个月以来增长超过 33 倍。11月豆包MAU接近 6000万,在 AI 产品榜·全球总榜中仅次于ChatGPT 2.87 亿的 MAU。11月豆包的 MAU增速达 16.92%,考虑当前豆包增速,我们认为豆包在 2025 年的MAU 有望接近ChatGPT 达到2亿。

而根据上文对豆包 2025年MAU及日均 token 数的测算,机构为对豆包大模型算力需求(非字节全部业务算力需求)对应产业链各环节需求进行了测算——

豆包背后有字节跳动支持,DeepSeek作为一家初创企业,面对这样的成本,显然需要时间来获得融资和成长。

DeepSeek-R1的惊艳之处是通过重新设计训练流程、以少量SFT数据+多轮强化学习的办法,在提高了模型准确性的同时,也显著降低了内存占用和计算开销。Deepseek-R1提供了一种低成本训练的方法,而不是说只能通过低成本来进行训练。

反而通过优化,DeepSeek-R1可能实现了算力与性能的近似线性关系。每增加一张 GPU,模型推理能力可稳定提升,无需依赖复杂的外部监督机制。这一特性直接验证了“算力即性能”的 Scaling Law,为AI芯片市场及Allnfra市场提供了明确的增量需求逻辑。

从这个角度看,“成本创新”≠“削减算力”,DeepSeek强调的始终是“性价比”的训练路径,算法创新在AI大模型发展过程中的比重或话语权变重了而已。

而在这个变化过程中,单纯将算力和成本压力给到DeepSeek显然是不科学的,本地部署、边缘计算与混合云等方式才是激活DeepSeek潜力的有效手段。

03、DeepSeek本地部署热潮

·微软将很快把针对NPU优化的DeepSeek R1版本直接接入Windows 11 Copilot+ PC,让开发人员能够使用AI模型构建在设备上运行的AI应用程序;

·英特尔表示,DeepSeek目前能够在英特尔产品上运行,更可以在AI PC上实现离线使用;

·联想集团中国区市场部5日宣布,联想AIPC个人智能体“小天”已接入DeepSeek,提升了在专业领域语言处理、代码生成与编程、数学推理、多模态处理等方面的AI能力。

种种迹象表明,DeepSeek本地部署热潮已经来袭。

与云端部署相比,本地部署能够更好地保护用户数据隐私,同时提供个性化的定制服务。随着DeepSeek的兴起,越来越多的用户开始关注如何在本地部署这一强大的AI模型。

实际上,部署DeepSeek并不复杂。用户只需通过Ollama等支持多种大模型的平台,选择适合的DeepSeek版本进行下载,并在本地终端管理员中运行相应的代码即可完成部署。部署完成后,用户便可以通过网页或客户端与DeepSeek进行交互,享受其带来的高效与便捷。

DeepSeek的本地部署热潮对PC市场产生了深远的影响。随着AI计算的高算力需求不断增长,PC硬件的配置要求也在不断提高。特别是在处理32B及以上参数规模的DeepSeek模型时,需要24GB及以上的GPU配置以及更大的内存和散热系统。

这一趋势推动了PC硬件的升级换代,也加速了AIPC(人工智能个人电脑)市场的发展。据Canalys预测,到2025年,AIPC出货量将有望达到1亿台,占整体市场的40%。到2028年,出货量将达到2.05亿台,占比高达70%,年复合增长率(CAGR)将高达44%。这一系列数据表明,AIPC的市场潜力巨大。

此外,DeepSeek 支持消费级硬件(如 RTX 4090)和端侧部署,推动算力从集中式云向边缘侧迁移。硅基流动已基于华为昇腾算力支持 DeepSeek API,海光 DCU 适配其模型,预示混合云架构将成为主流。

04、点评:打破算力垄断

DeepSeek 通过算法优化(如动态注意力、多令牌预测)和工程创新(如MOE 负载均衡),以1/20 的训练成本实现与 GPT-40 相当的推理性能,验证了“轻量级颠覆”路径的可行性,随着时间的推移,相信当下的算力、成本压力都会过去。