3月18日,英伟达(NVIDIA)首席执行官黄仁勋在加利福尼亚州圣何塞举行的NVIDIA GTC会议上发表演讲时宣布,NVIDIA最新的GPU平台是Blackwell,包括AWS、微软和谷歌在内的公司计划将其用于生成人工智能和其他现代计算任务。

NVIDIA Blackwell体系结构

基于Blackwell的产品将于2024年末从NVIDIA全球合作伙伴那里进入市场。黄仁勋宣布了NVIDIA及其合作伙伴提供的一系列附加技术和服务,称生成人工智能只是加速计算的一个方面。

“当你加速时,你的基础设施就是CUDA GPU。”这里,他指的是英伟达的并行计算平台和编程模型CUDA。“当这种情况发生时,它与生成人工智能的基础设施是一样的。”

Blackwell支持大型语言模型训练和推理

黄仁勋说,Blackwell GPU平台包含两个芯片,通过每秒10 TB的芯片到芯片互连连接,这意味着每一侧基本上可以像“两个芯片认为是一个芯片”一样工作。它拥有2080亿个晶体管,使用NVIDIA的2080亿4NP台积电工艺制造。它拥有8 TB/S的内存带宽和20个pentaFLOPS的AI性能。

英伟达表示,对于企业来说,这意味着Blackwell可以对高达10万亿参数的人工智能模型进行训练和推理。

Blackwell通过以下技术得到增强:

第二代TensorRT LLM和NeMo Megatron,均来自英伟达。与第一代transformer引擎相比,计算和模型大小翻了一番的框架。具有本机接口加密协议的机密计算,可保护隐私和安全。一个专用的解压引擎,用于加速数据分析和数据科学中的数据库查询。关于安全性,黄仁勋说,可靠性引擎“对Blackwell芯片上的每一位内存和连接到它的所有内存进行自检,即系统内测试。就好像我们用自己的测试仪运送Blackwell芯片一样。”

Blackwell系列的GPU紧随Grace Hopper系列的GPU,后者于2022年首次亮相。NVIDIA表示,Blackwell将以比Hopper系列低25倍的成本和更低的能耗,在万亿参数LLM上运行实时生成人工智能。

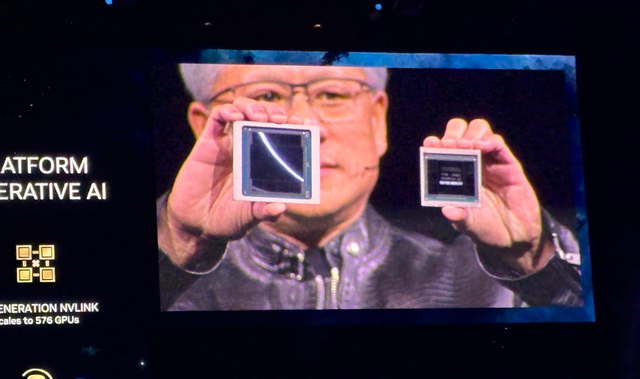

黄仁勋在NVIDIA GTC 2024上展示Blackwell(左)和Hopper(右)

NVIDIA GB200 Grace Blackwell超级芯片连接多个Blackwell GPU

除了Blackwell GPU,该公司还宣布了NVIDIA GB200 Grace Blackwell超级芯片,该芯片将两个NVIDIA B200 Tensor Core GPU连接到NVIDIA Grace CPU,为LLM推理提供了一个新的组合平台。NVIDIA GB200 Grace Blackwell超级芯片可以与该公司最新发布的NVIDIA Quantum-X800 InfiniBand和Spectrum-X800以太网平台连接,速度高达800 GB/s。

GB200将于今年晚些时候在NVIDIA DGX Cloud上以及通过AWS、谷歌云和Oracle云基础设施实例提供。

新的服务器设计展望万亿参数人工智能模型

GB200是最新发布的GB200 NVL72的一个组件,这是一种机架级服务器设计,将36个Grace CPU和72个Blackwell GPU封装在一起,可实现1.8 exaFLOP的AI性能。NVIDIA正在展望大规模万亿参数LLM的可能用例,包括会话的持久内存、复杂的科学应用程序和多模式模型。

GB200 NVL72结合了第五代NVLink连接器(5000根NVLink电缆)和GB200 Grace Blackwell超级芯片,提供了巨大的计算能力,黄仁勋称之为“一个机架中的exoflops AI系统”

“这超过了互联网的平均带宽……我们基本上可以把所有东西都发送给每个人。”他说。“我们的目标是不断降低计算的成本和能源——它们是直接相关的。”

顺便提一嘴,冷却GB200 NVL72每秒需要两升水。

下一代NVLink带来了加速的数据中心架构

第五代NVLink在多达576个GPU之间提供1.8TB/s的每GPU双向通信吞吐量。NVLink的这一迭代旨在用于当今最强大的复杂LLM。黄仁勋说:“未来,数据中心将被视为人工智能工厂。”

英伟达表示,预计思科、戴尔科技、惠普企业、联想和超级微将提供基于Blackwell的服务器,以及Aivres、ASRock Rack、ASUS、Eviden、富士康、GIGABYTE、英华达、Pegatron、QCT、Wistron、Wiwynn和ZT Systems。

包括工程模拟公司Ansys、Cadence和Synopsys在内的软件制造商将使用基于Blackwell的处理器来设计和模拟电气、机械和制造系统及部件。

Blackwell产品线由Nvidia AI Enterprise支持,这是一个生产级AI的操作系统,包括Nvidia-NIM推理微服务,以及企业可以部署在Nvidia加速云、数据中心和工作站上的AI框架、库和工具。