在深度学习领域,卷积神经网络(CNN)曾经是计算机视觉的代名词。自2012年AlexNet在ImageNet竞赛中取得突破性成功以来,CNN在图像识别、目标检测等领域掀起了一场革命。然而,纵观近年的顶会论文和研究热点,我们不得不承认一个现实:CNN相关的研究论文正在减少,曾经的"主角"似乎正逐渐淡出研究者的视野。这种变化绝非偶然,而是深度学习技术发展和应用需求变化共同作用的必然结果。本文将深入剖析CNN研究热度降温背后的深层原因,以及这一经典架构在新时代的发展方向。

CNN在处理图像的空间变换方面存在着根本性的局限。当图像中的物体发生旋转时,CNN需要通过大量的数据增强才能学习到这种变换关系。这一问题源于CNN的基本构造:卷积核在图像上滑动时,对空间结构的敏感性使得模型难以自然地获得旋转不变性。同样的问题也体现在尺度变化上,当物体大小发生显著变化时,CNN往往需要复杂的多尺度处理机制来保持识别性能。这些问题虽然可以通过技术手段来缓解,但解决方案往往会带来训练复杂度的显著提升和计算资源的额外开销。

CNN的另一个根本性局限在于其对图像全局信息的理解能力。卷积操作本质上是一种局部特征提取机制,每个卷积层只能看到其感受野范围内的信息。虽然通过叠加网络层数可以扩大感受野,但这种方式在捕获长程依赖关系时效率低下。例如,在需要理解图像中远距离物体之间关系的场景中,CNN需要通过多层网络的堆叠才能建立这种联系,这不仅增加了计算成本,还可能导致信息在传递过程中的损失。

这种局部性带来的问题在复杂场景理解任务中表现得尤为明显。当需要理解整个场景的语义关系时,仅依靠局部特征的累积往往无法有效捕捉到更高层次的语义信息。这也是为什么在一些需要全局场景理解的高级视觉任务中,pure CNN架构的表现往往不尽如人意。

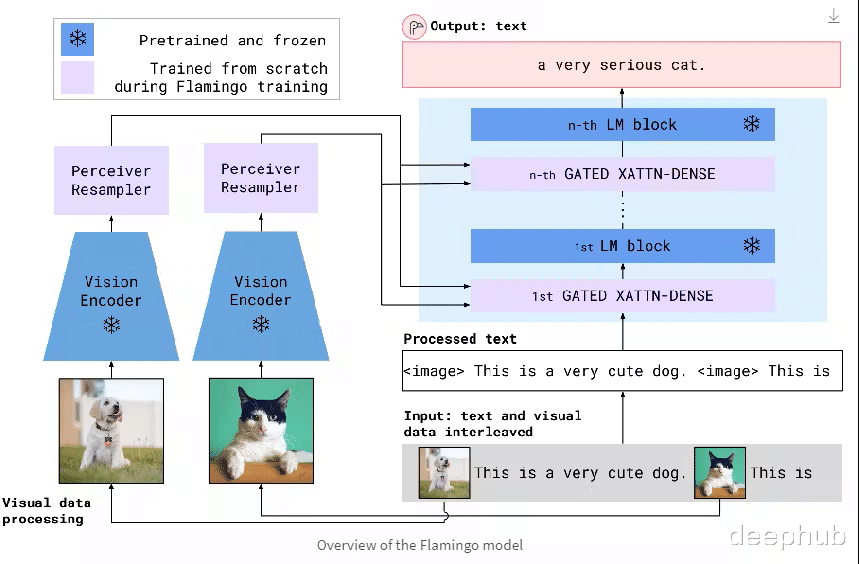

随着人工智能技术的发展,多模态处理能力日益成为核心需求。特别是在大语言模型蓬勃发展的背景下,跨模态理解和生成的需求急剧增加。在这种情况下,统一的模型架构能够带来显著优势:它可以简化模型设计,降低不同模态之间的对接成本,并且有助于实现端到端的训练过程。这种统一性需求正在推动研究者们寻找更适合多模态任务的网络架构。

从技术发展的角度来看,CNN相关研究的减少也反映了技术创新的自然规律。早期CNN在计算机视觉领域取得了巨大成功,但随着研究的深入,其固有局限性逐渐显现。研究者们在尝试克服这些局限性的过程中,不断探索新的架构设计,这是推动技术进步的必然过程。

3、CNN的未来发展方向尽管面临挑战,CNN在特定领域仍具有其不可替代的价值。未来的发展方向可能主要集中在以下几个方面:

首先,在特征提取效率方面,研究者们正在探索新型的卷积操作,试图在保持CNN局部特征提取优势的同时,提升其处理空间变换的能力。这包括设计新的卷积核结构,以及改进特征提取的方式。

其次,在实际应用层面,CNN正在向着更专门化的方向发展。针对特定场景的优化设计可以充分发挥CNN在局部特征提取方面的优势,同时通过专门的架构设计来规避其局限性。

最后,在与新型架构的协同方面,CNN也在寻找更好的融合方式。通过结合其他架构的优势,可以构建更加强大和灵活的混合模型,这可能是未来的一个重要发展方向。

CNN研究热度的降温反映了深度学习领域的自然发展规律。这种变化并不意味着CNN的价值降低,而是表明这项技术正在进入一个更加成熟和专门化的阶段。未来的发展趋势很可能是多种架构的协同演进,每种架构在适合自己的领域发挥独特价值。CNN在计算机视觉的某些基础任务中的优势仍然明显,关键是要找到合适的应用场景和结合方式。

在这个快速发展的领域中,保持开放和包容的态度,理性看待每种架构的优势与局限,才能推动技术的持续进步。CNN作为深度学习领域的重要组成部分,必将在这个发展进程中继续发挥其独特的价值。