AI已逐渐成为智能车企的重点研发方向。

2024年春节开工后,小鹏汽车CEO何小鹏就在内部信中强调,2024年公司要重点发展以智驾为核心的AI技术,为此将投入35亿元。

吉利汽车集团CEO淦家阅也在春节后的开工信中表示:“AI将成为智能汽车的分水岭,没有AI的只是出行工具,具备AI的才是智能伙伴。”

理想汽车则着眼长远,将企业愿景设置为“2030年,成为全球领先的AI企业”。不久前,理想汽车CEO李想在评论苹果“放弃造车聚焦人工智能”时表示:“汽车大获成功的必要条件仍然是人工智能。汽车的电动化是上半场,人工智能才是决赛。”

作为国内最早研究AI与智能驾驶的大型企业,百度也在3月25日的极越AI DAY上,讲述了自己是如何用AI改造智能驾驶的。

纯视觉智驾感知纯视觉的智驾感知系统是百度在AI方面的一大应用,在极越AI Day上,百度智能驾驶事业群组(IDG)首席研发架构师、IDG技术委员会主席王亮演讲的主题就是“用AI原生思维重构自动驾驶技术——极越纯视觉智驾技术实践”。

在2024年1月的极越汽车机器人进化日上,王亮就曾表示,长期来看,相比使用激光雷达的路线,纯视觉路线的演进速度更快、算法上限更高,所以百度会All in纯视觉路线。在这次的极越AI Day上,王亮再次强调了这一观点。

王亮表示,纯视觉路线演进速度更快、算法上限更高的本质原因是Scaling Law——指导AI研发的一条规律。具体内容简单来说就是:随着数据集、模型参数量和算力的增加,模型的性能会提高。纯视觉路线在数据与模型参数量方面存在优势,所以迭代的加速度会比激光雷达等主动光传感器更快。

具体来看,在模型参数量方面,由于车端的资源有限,车端各种模型的参数量总量也有上限,如果搭载激光雷达,激光雷达模型就会占用一部分参数量。所以在其他条件相同的情况下,去除激光雷达能让视觉模型的参数量有空间做得更大。

数据方面,800万摄像头采样点频是主流激光雷达的160倍,也是即将上市的旗舰激光雷达的20倍。同时,相比激光雷达点云图,图像的纹理、色彩信息量更丰富,蕴藏的环境信息量更大,算法有潜力获得更多信息,算法上限更高。以下图为例,从图像上算法才能识别红绿灯,才能知道行人拉着的箱子不是静止障碍物。

图片来源:极越汽车机器人进化日

但图像中巨大的信息量,也给百度的视觉算法造成了很大挑战,为了提取图像中的海量信息,也为了让模型掌握通用泛化的能力,去准确地识别信号灯、机动车、行人等各种物体,百度开发了一个视觉大模型——VTA(Vision Takes All)。

VTA视觉大模型VTA可以分为几个部分,第一部分是一个作为底座的基础大模型(Foundation Model)。开发这个基础大模型的目的是为了让VTA去积累知识,对世界的有充分的理解,这样VTA在后续解决专业问题时,就能拥有通用泛化能力。

这个基础大模型的训练可以分为两步。

步骤一是使用大量的自动驾驶数据,进行自监督训练。自监督训练的好处就在于不需要进行昂贵且耗时的数据标注工作。比如随机遮挡图像中的一部分,让模型去恢复。这就不需要标注图像信息,只需要评估恢复前后两张图像在亮度、对比度、结构信息等方面的相似度。

步骤二是用通用视觉任务进行训练,比如目标检测、景深估计等。

笔者推测,这里就使用了百度Robotaxi以及地图采集车的数据,比如可以先让基础大模型通过图像估计障碍物的距离,再用Robotaxi以及地图采集车上的激光雷达真值数据进行确认。

相比蔚小理在量产车型上使用的激光雷达,百度Robotaxi以及地图采集车上的激光雷达精度更高,得到的真值数据更准确,模型的训练效果就更好,这是百度在智能驾驶方面的数据优势。

VTA的第二部分是模型的四大核心能力,包括目标检测、实时建图、时序跟踪、场景理解能力。

有了这四大能力,基本可以得到智能驾驶需要的所有信息。比如目标检测能识别障碍物;时序跟踪能判断障碍物的速度;实时建图能获取环境信息;场景理解能弄清楚不同的环境信息意味着什么。

具体来看,关于这四大能力,VTA在实践中取得了一系列成果。

VTA的成果——占用网络OCC占用网络是VTA取得的一大成果。笔者认为,占用网络也是百度敢于在量产车上去除激光雷达的直接原因,因为理想状态下的占用网络可以替代大部分激光雷达的功能。

占用网络,是一种基于深度学习的三维重建方法。在汽车自动驾驶领域,最早是特斯拉在其2022年AI Day上介绍感知模块的更新时,提到了占用网络技术。

具体来看,占用网络可以利用摄像头拍摄的画面,把现实世界分割成无数个像素立方体,再预测每个立方体是空闲还是被占用,这样就可以获得「3D可达空间」与识别通用障碍物。

比如对于双节公交车,占用网络就能感知出公交车拐弯时准确的曲率。传统的目标检测感知模块就比较难处理这个问题,因为传统的目标检测只能使用1到2个长方体去拟合曲率,结果会不够准确。

图片来源:Tesla AI Day 2022

2024年2月,在极越的“占用网络上车”发布会上,王亮表示,占用网络可以把所有不规则物体体现出来,障碍物种类识别率可达到99%。即便车辆行驶路面出现“陌生物体”,不管系统此前是否认识这个物体,只要网格被该物体占据,车辆就能根据该物体占据网格的体积、运动状态等判定这条路是否可行驶。

在极越AI Day上,王亮预告了百度即将推出远中近三个占用网络模型,覆盖高速、城区、泊车全场景。

第一个是针对高速场景的远视距模型,前向视距达到200米,网格分辨率是0.4米,最高帧率30帧/秒。

第二个是针对城区道路的模型,前向视距为120米,但是网格更密集,分辨率为0.1米,最高帧率20帧/秒。

第三个是针对近距离泊车场景的模型,前向视距30米,网格分辨率0.05米,最高帧率10帧/秒。

这样针对不同场景的需要,推出不同视距、分辨率、帧率的模型,就能在提升感知效果的同时减少对算力的占用。

VTA的成果——视觉跟踪、场景理解视觉跟踪能力是VTA的另一成果。王亮表示,视觉跟踪能力就是在知道物体在三维空间中的位置后,再去得到物体运动的速度、加速度的能力。

百度用AI改进了视觉跟踪能力,将传统的Rule-based方法,改为Data-driven方法。

改进之后,一方面让系统对障碍物的速度估计更加准确。传统的方法做速度估计,是先估计两帧之间障碍物移动的距离,再把距离除以两帧之间的时间得出速度。但由于两帧之间的时间只有0.1秒,分母很小,所以距离估计稍有不准,就会造成速度的跳变。

使用Data-driven方法后,是用机器学习端到端地把障碍物的速度学习出来,速度的估计就比较准确且平稳。

图片来源:极越AI Day

另一方面,改为Data-driven方法后,百度的智驾系统还能拥有较长的记忆能力,在物体被遮挡时,可以持续跟踪障碍物,这样就能减少盲区的影响。

在2022年的Tesla AI Day上,特斯拉也展示了类似的跟踪被遮挡障碍物的能力。下图蓝色区域是摄像头的可视范围,我们可以看到在可视范围中出现的车辆就算被遮挡,系统还会估计其的三维位置,这同样需要速度估计能力和记忆能力。

图片来源:Tesla AI Day 2022

场景理解能力也是VTA的成果,它可以让系统更敏捷地应对突发事件。比如像人类一样快速地判断行人是会等红灯,还是会横穿马路;判断占道车辆是违停,还是在排队等红绿灯。但对传统算法来说,这些是比较难的问题,需要许多小模型和一堆的条件、假设、参数去做判断。

使用AI技术后,VTA网络就可以不靠条件、假设、参数,只需要学习连续的视频数据,就能理解很多道路参与者的意图。比如判断鬼探头车辆与行人的横穿意图,进行避让;通过打开的后备箱,判断车辆处于违停状态,做出绕行。

图片来源:极越AI Day

此前,特斯拉也展示过类似的场景理解能力。首先对于每一个位置,系统会生成语义信息,如路沿、行人、汽车,接着进一步将语义信息和3D信息融合,还原3D场景。比如可以感知下坡路的坡度,进而更精准地控制加减速。

图片来源:Tesla AI Day 2022

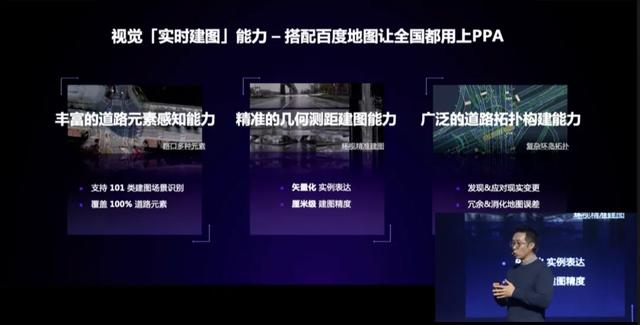

实时建图与LD地图最后是VTA的实时建图能力,这个能力搭配百度的LD(车道级导航)地图,可以大大加快极越PPA(点到点领航辅助)开城的速度。

笔者认为,VTA的实时建图能力中最重要的子能力就是几何测距建图的能力。VTA直接学习道路结构,就能输出完整的厘米级精度车道线,便于后续的建图。

图片来源:极越AI Day

LD地图是百度专为自动驾驶打造的地图,在高精地图的基础上去除了自动驾驶不必需的要素并降低精度。同时,百度还通过模型生成LD地图减少了大量生产成本。

百度副总裁尚国斌表示,在传统的高精地图生产流程中,95%以上环节都是由人来完成,所以成本非常高,很难提高更新频率。

百度的LD地图则是完全由视觉大模型VTA生成的。百度将数百辆地图采集车采集到的数据放入VTA,使用模型的检测、跟踪、理解、建图等能力,就能生成高置信度的LD地图,完成99%的地图生产工作,最后只用人去解决最后1%的质量问题。这就解决了高精地图无法大规模生产、高频率更新的问题。

图片来源:极越AI Day

目前,百度LD地图已经覆盖全国360万公里道路、360个地级市,同时可以做到一天新增生成一个城市的LD地图。

除了生产成本低外,相对于高精地图,百度LD地图增加了经验图层、安全图层、实时图层等,可以让智能驾驶更安全、舒适。

具体来看,经验图层有着百度地图上大量用户的真实轨迹数据,包括经验限速、经验轨迹、经验车道,可以让车辆智能驾驶时的速度、轨迹、车道选择更像人类、更合理。

安全图层,是百度对百度地图用户累计上报的2000万起事故进行分析,找到上万个高事故频率的匝道和路口,对这些区域进行深度测绘,让其精度和要素丰富度均高于高精地图,保障智能驾驶时的安全。

实时图层则提供红绿灯数据,目前覆盖了全国3000多个区县、约30万个路口的红绿灯。此外,百度地图每天数万次的施工、事故等动态事件的数据也会提供给实时图层。

有了实时图层后,百度的智能驾驶在安全方面可以提前变换车道避让事故、施工,在舒适方面也能根据红绿灯数据调整速度,减少红灯前的无效加速。

总结将2024年的极越AI Day与2022年的Tesla AI Day对照来看,可以发现百度在智驾感知方面的AI技术运用,有许多地方参考了特斯拉的思路,但百度也发挥拥有地图业务的优势,做出了创新。

虽然已经在智驾上实现全局端到端的特斯拉依然是全球智驾技术的引领者,但充分结合地图数据的百度,如果和特斯拉比较智驾体验,那么鹿死谁手也犹未可知。

所以笔者很期待特斯拉FSD能尽快在国内落地,在智驾领域与百度、华为、小鹏们同台竞技,看看到底谁更胜一筹。