Gitee AI 模型微调功能现已上线,欢迎扫描下方二维码加入微调交流群了解最新动态:

在深度学习领域,基础大模型以其强大的通用性广受关注。这些模型能够胜任大部分任务,生成内容丰富且符合语境的结果。然而,当面对特定的个性化需求时,基础大模型往往难以满足高精度要求,这就是**微调(Fine-Tuning)**发挥关键作用的地方。

微调的意义

微调的意义微调的核心价值在于将大模型的通用能力转化为定制化能力。大模型的训练基于海量数据,这赋予了它强大的通用知识,但对于特定领域的独特任务或个性化内容,通用模型可能表现欠佳。例如:

医疗影像分析通用的计算机视觉模型可以识别常见物体,但对医学影像(如 CT、MRI)的病灶检测却无能为力。通过微调,研究者利用标注好的医学影像数据(如肺癌、脑部肿瘤),将大模型优化成专用于病灶识别的工具,大幅提高诊断准确率。

品牌内容生成某些电商平台利用微调技术,将通用图像生成模型调整为专属品牌服务工具。例如,一些奢侈品牌通过微调模型,让其能够精准生成品牌特有的设计风格,用于营销海报和虚拟产品展示。

客户服务定制通用自然语言处理模型通过微调,能够适配企业内专用术语或行业语言环境。例如,保险行业的客户服务需要理解复杂的理赔规则和术语,通过微调,它可以准确回答客户的保险相关问题。

简单来说:大模型有「普遍性」,而微调赋予了它「专属性」。

微调的目标微调的目的简单明了:让模型更贴近特定应用场景的实际需求。

提升专属性能:通过微调,模型能够捕捉目标特征,生成更契合需求的结果。例如,生成特定人物肖像或精准的物体识别模型。扩展应用范围:微调后的模型不仅可以完成通用任务,还能胜任小众或专业领域的定制化工作。提高效率:与从零开始训练模型相比,微调大幅降低了时间和计算成本。例如,现有开源大模型如 Stable Diffusion 微调后可用于生成企业特定商品的高精度图片。微调其实并不复杂尽管微调听起来是一项复杂的技术,但得益于现有平台支持,这一过程已经变得越来越简单高效。用户只需准备合适的数据集,并按照规范流程操作,就能轻松完成一次高质量的模型微调。

如果你希望详细了解如何完成一次模型微调的工作,Gitee AI 恰好在近期开启了模型微调功能的内测,同时上线了模型微调的示例教程,展示了如何利用少量数据集完成特定目标的高效微调——

在 Gitee AI 上进行模型微调图像生成大模型已具备学习多种通用艺术风格与物体的能力,但难以理解特定人或事物的具体特征。通过微调功能,可以让模型记住并生成与某个特定对象一致的效果。

本文将以5张特定狗狗照片为示例,演示如何通过 GiteeAI 开箱即用的模型微调功能,让大模型「记住」目标狗狗的特点。

1️⃣ 创建微调任务在GiteeAI控制台的左边侧边栏找到模型微调。点击右上角 新建任务,填写任务名称,点击创建任务。

2️⃣ 数据集准备

2️⃣ 数据集准备数据集对微调效果有着决定性的影响,其内容通常包括原始数据和打标信息两部分。

数据集要求内容丰富:包含目标对象多个角度的图片格式支持:png、jpg、jpeg大小限制:单张最大5MB,总量不超过100张本次微调所采用的图片:

上传图片与打标将图片上传至微调任务中,点击上传图片,选择文件完成上传。

上传完成后,点击打标/裁剪按钮,系统将对图片进行自动标注。

点击图片,可在弹窗中删除无关标签或添加缺失的必要标签。

3️⃣ 配置训练参数

3️⃣ 配置训练参数任务创建后,进入任务设置页面,左侧 参数设置 包括模型选择、训练轮次、单张学习次数等,可根据需求灵活配置。以下两个选项是影响影响训练时间与效果的关键因素:

循环轮次: 决定了模型学习整个数据集的次数 (每轮保存一个 lora 模型)单张学习次数: 决定了模型在每个循环轮次中学习每张图片的次数 4️⃣ 开始模型训练

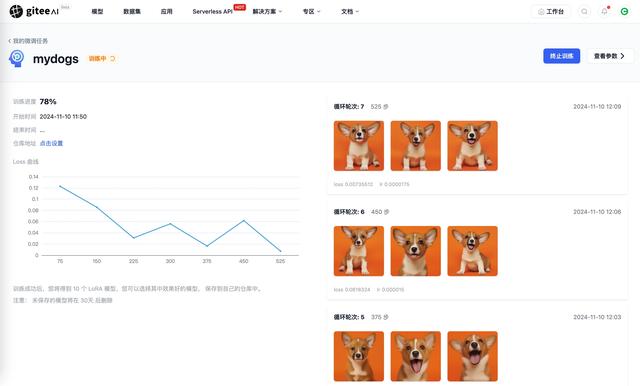

4️⃣ 开始模型训练点击页面右下角的开始训练按钮,任务将进入排队状态。系统分配资源后,将自动开始训练。

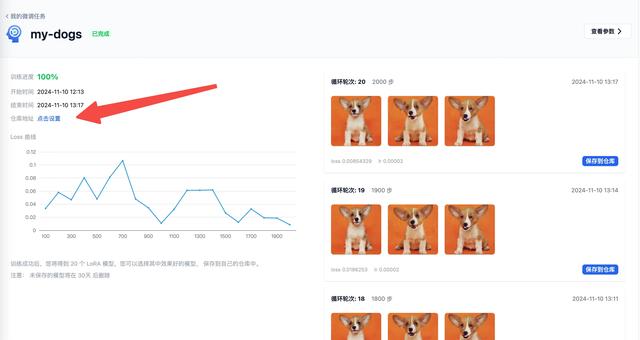

训练完成后,可查看包括模型loss值在内的详细结果。系统会为每个循环轮次保存一个模型,并生成3张效果图用于评估。

5️⃣ 保存训练的模型

5️⃣ 保存训练的模型完成训练后,选择保存模型的位置。点击设置,在弹出的选择框中指定已有模型仓库,或新建仓库以存储模型。

训练完成后,每个 循环轮次 都会得到一个 lora 模型,根据效果图挑选需要保存的lora模型,点击保存到仓库按钮,即可将模型存储到选定仓库中。

通过上述简单的操作流程,即使没有深厚的技术背景,也可以轻松完成模型的微调。不仅能够满足开发者的个性化需求,还能大幅提升模型在特定任务中的表现。

目前该功能已在 Gitee AI 上线,如果你也对模型微调感兴趣,欢迎扫描下方二维码加入微调交流群了解最新动态: