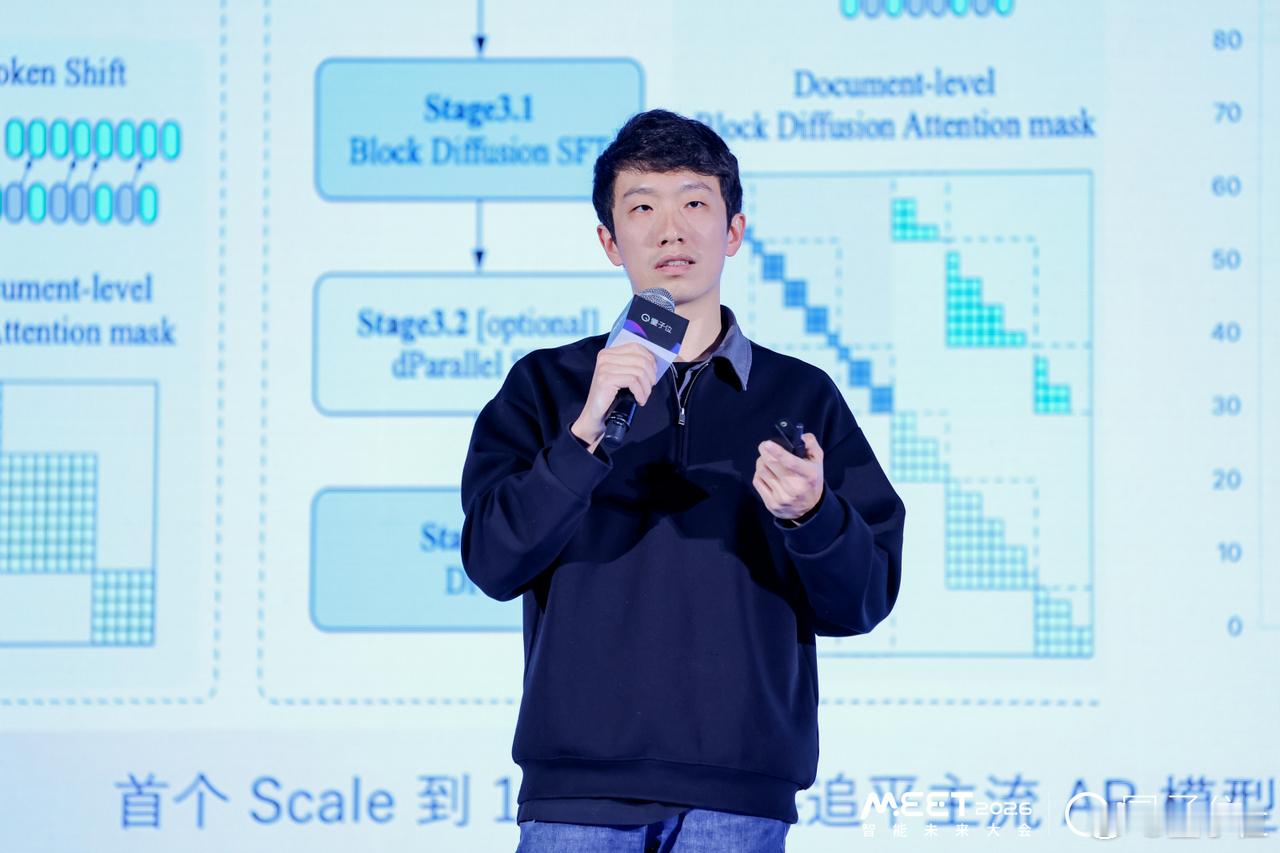

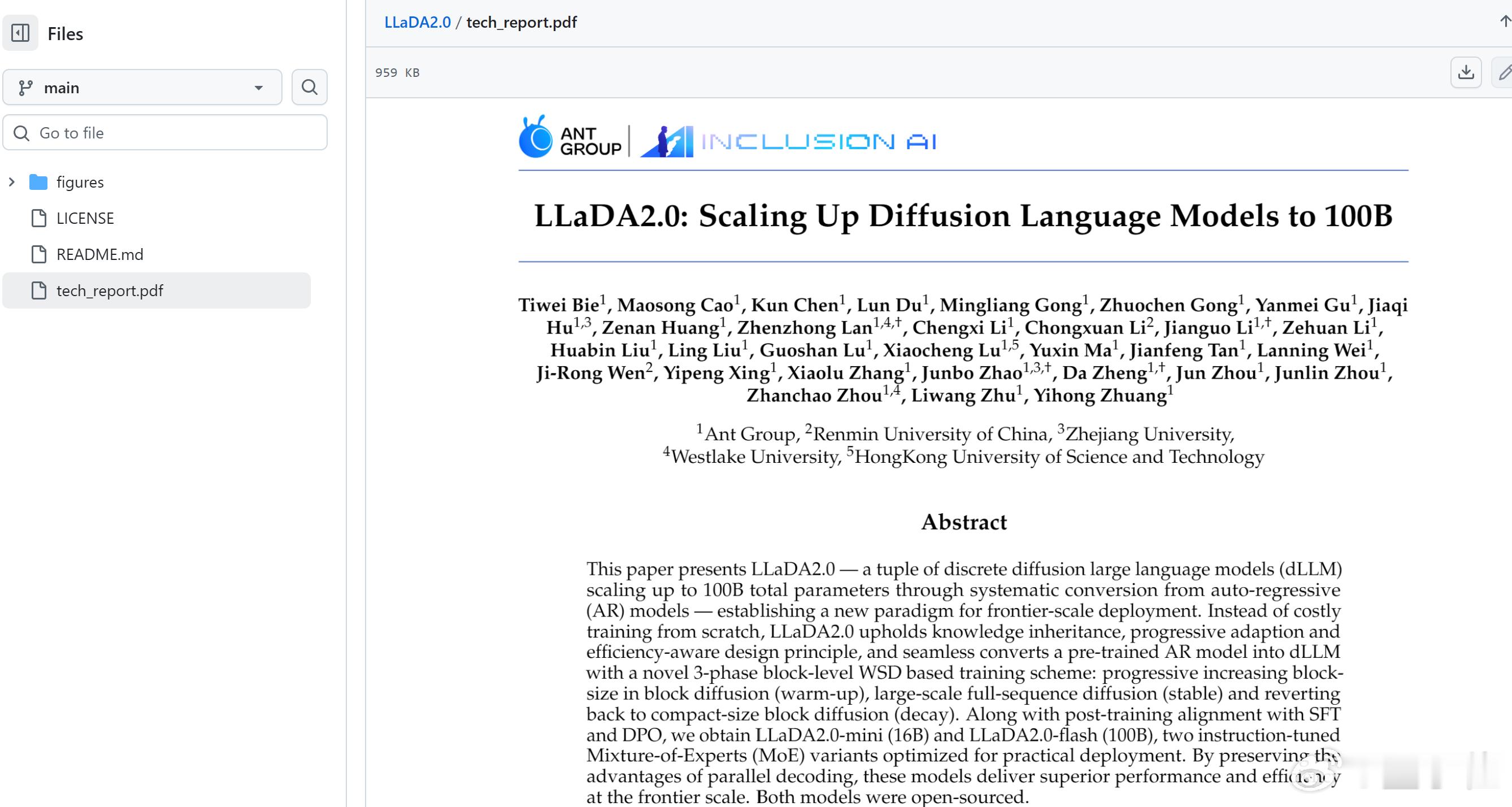

蚂蚁开源100B扩散语言模型 技术报告已上线 当主流大语言模型还在采用自回归架构时,有人已经盯上了扩散架构。在本次量子位MEET2026智能未来大会上,浙江大学百人计划研究员、博士生导师,蚂蚁集团资深技术专家赵俊博表示:扩散架构在推理过程中可以直接修改和控制token,而不需要像自回归模型那样重新生成整段内容。这意味着,相比自回归模型,扩散模型理论上有望实现更快的生成速度以及更低的计算成本。基于此,他和团队将重点押注于扩散架构,并致力于探索扩散语言模型独有的Scaling Law。而作为这一探索的关键里程碑,他们近期发布并开源了LLaDA 2.0,率先将扩散语言模型做到千亿体量。赵俊博坦言,该领域在训练与推理层面仍处早期,但发展势头迅猛,已吸引包括谷歌、字节在内的巨头及一批初创公司积极布局。编者注:就在MEET2026智能未来大会结束后,赵俊博和团队也发布了全新的技术报告,揭示了千亿体量扩散语言模型背后的关键技术选择。报告标题:LLaDA2.0: Scaling Up Diffusion Language Models to 100B报告链接(github):网页链接内容详情:网页链接