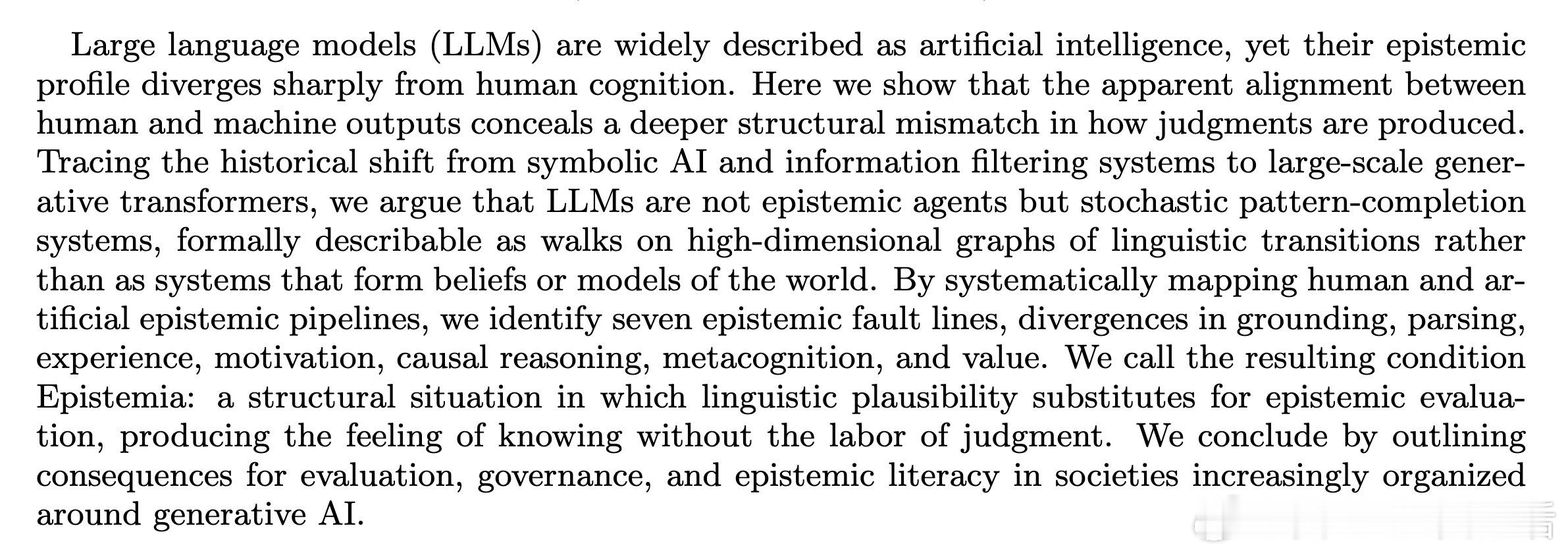

[AI]《Epistemological Fault Lines Between Human and Artificial Intelligence》W Quattrociocchi, V Capraro, M Perc [Sapienza University of Rome & University of Milan Bicocca & University of Maribor] (2025) 我们正处于一个认知的错觉时代。大语言模型(LLM)在表面上与人类对答如流,甚至在图灵测试中表现得比人类更像人类。但这种表面的“对齐”掩盖了一个深层的结构性失配:机器是在完成概率路径,而人类是在形成真实判断。本质上,LLM的文本生成可以被描述为在高维图上的随机游走。它并不理解真理,也没有世界模型。它只是在追踪语言的统计规律,通过海量数据学习如何让下一个字看起来更自然。规模的扩大并没有让它产生认知,只是让这种语言自动化变得更加丝滑。它优化的是分布的拟合,而非对现实的正确性。本文系统地梳理了人机判断之间的七道认知断层。这不仅是技术参数的差异,更是生命本质的鸿沟:- 锚定断层:人类植根于感官与社会,机器植根于抽象符号。- 解析断层:人类理解情境,机器只进行标记化处理。- 经验断层:人类拥有具身记忆,机器只有统计关联。- 动机断层:人类受情感与目标驱动,机器只有无目标的推理。- 因果断层:人类构建因果模型,机器依赖表面相关性。- 元认知断层:人类能监控不确定性并保持沉默,机器在结构上必须预测,无法承认无知。- 价值断层:人类的判断关乎身份与责任,机器的判断只是概率。一个深刻的洞察是:幻觉不是LLM的漏洞,而是它的底色。在生成式系统中,产生与现实脱节的内容是默认状态。当一个系统缺乏元认知监控,它就失去了“知道自己不知道”的能力。它表现出的自信并非源于知识,而是源于算法的强制性输出。作者提出了一个极具启发性的概念:Epistemia(认知替代)。这是一种结构性困境:语言的流畅性与合理性取代了认知的评估。我们通过机器获得了答案的快感,却逃避了形成判断所需的劳作。当判断被简化为一种可消费的商品,知识就失去了它的证据支撑与责任感。这种转变意味着,我们正在从“信息过滤”时代进入“信息合成”时代。过去,搜索引擎提供碎片,由人类拼凑并判断;现在,生成式AI直接提供完整的、权威感十足的陈述。这种权力的移交让评估变得可选,甚至被结构化地忽略了。面对这种认知断层,我们需要重新定义“认知素养”。它不再仅仅是批判性思维,而是一种导航能力:理解哪些判断可以交给机器,哪些责任必须由人承担。我们需要超越表面的行为对齐,去关注认知过程的透明度。真正的智能不在于给出一个完美的答案,而在于对答案背后真理的敬畏与承担。在生成式AI重塑社会的今天,保护判断力,就是保护我们作为人的最后一道防线。不要让流畅的表达,成为思考的终点。原文链接:arxiv.org/abs/2512.19466