一、人工智能

人工智能是当今世界最火爆,也是最重要的科技,没有之一。

为此,大佬刘专门花费一个多月的时间,从底层逻辑去搞懂为什么人工智能这么厉害。

那么,什么是人工智能?让大佬刘用通俗的语言介绍给你们。

以大家最为熟悉和经常使用的人脸识别为例。

人脸识别属于人工智能图像识别领域,也是当前人工智能最成功的应用之一,被广泛用于金融服务、社会管理等方方面面。我们现在可以刷脸支付,说明人工智能人脸识别技术已经很靠谱了。

人工智能人脸识别的底层逻辑其实非常简单,高中数学多点儿的知识水平就可以理解了。

大佬刘是脸盲症,看人全是两只眼睛一个鼻子一张嘴巴,感觉大家都长一样。但你仔细观察不同的人脸,还是会发现不一样的,比如有人下巴尖些,有人下巴圆些,不同的人具有不同的特征。

把一个人脸的下巴、颧骨、鼻梁、额头等特征分别提取出来,记为a、b、c、d、…,组成一个特征向量组X = (a, b, c, d, …),那么,这个人脸特征向量X就像我们的指纹一样,每个人都是不一样的,可以一一对应。比如X1对应Y1张三,X2对应Y2李四,X3对应Y3王五。

高中数学知识告诉我们,这种一一对应的映射关系就是函数,记为Y = f(X),这个f,就是映射关系。

其中,X称为自变量,Y称为因变量。即X和Y有因果关系,X是因,Y是果,f是它们之间因果关系的对映规则,数学上称函数解析关系。

事实上,世界上任何有规则秩序、有因果律的关系,都可以写成函数y = f(x)。

或者反过来理解,这个世界上的任何事物现象,哪怕看起来杂乱无章,只要不是无序乱来的,都可以写成函数y = f(x),尽管这个因果对应关系的函数解析式f可能复杂无比。

比如:人脸不是天马行空乱长的,所以有人脸识别函数;开车不是闭上眼睛乱开的,所以有驾驶函数;聊天不是疯言疯语乱讲的,所以有聊天函数。

解析出这些函数f,你就可以一一将它们对映,然后实现人脸识别、自动驾驶、聊天会话。这个f,在数学上称为函数映射关系,在通用语言上,就称为智能——可认脸、会开车、能聊天……

如果你能解得描述整个社会运转和宇宙运行规律的自然法则函数Y = F(X),那么,你就是上帝。

不过,别说代表宇宙终极奥秘的自然函数你解不出来,就说你坐在湖边,微风拂过,水面泛起涟漪阵阵,波光粼粼,请问,稍微复杂一点的水波荡漾,你能写出它的波动函数解析式来吗?

但,人类天才数学家给我们找到了解决方案。

大佬刘大学时上高数课学微积分,最震撼我的一个知识点就是泰勒多项式展开。

泰勒展开告诉我们,无论一个多么复杂的连续曲线函数y = f(x),我们都可以用一个简单的多项式函数(y = ax^0+bx^1+cx^2+dx^3+ex^4+ …)将它近似出来。

只要你给一个精度,我总能找到一个多项式函数,无限逼近原函数f(x),如果你觉得精度不够,多项式多加一项就好了。

有了这种无限逼近性,我们就可以用简单的多项式函数来替代复杂的原曲线函数。换句话说,我们把不可能完成和没办法求解的无比复杂的原函数y = f(x)的难题,变成了求解简单的多项式函数。

当然,泰勒多项式展开只适合低维度的曲线函数,对多维度函数,比如人脸识别函数Y = f(X),因为自变量X是多维特征向量组(a, b, c, d, …),泰勒展开力不从心并不合适。

对高维空间函数的近似逼近,神经网络就非常适合。

同样,可以严格数学证明:我们总能找到一个神经网络,能以任意精度逼近任意复杂度的真实函数Y = f(X)。

所以,人工智能领域一些高大上的词汇,比如“机器学习”、“深度学习”、“模型训练”,说白了,就是去找到一个“神经网络”,用来近似原函数y = f(x)比如图像识别函数、驾驶函数、聊天函数。

只要能找到这样的一个神经网络的东西,我们就可以实现人脸识别、自动驾驶、机器聊天……

这就是人工智能。

二、深度神经网络

人工智能(AI)是一个很宽泛的领域,其中机器学习是最热门的一大板块,内容包括决策树,向量机等,尤以深度神经网络最为重要。

神经网络源自对人类大脑智能的模拟,最近取得了举世瞩目的突破性进展。

人类大脑是一个非常复杂的神经网络,其基本单元由神经细胞构成,我们称之为:神经元。

神经元的基本结构如下图:

神经元主要有三部分组成:接收信号的树突(dendrite);包含细胞核的细胞体;输出电脉冲信号的轴突(axon)。

其中轴突末梢和树突之间形成突触(synapse),通过神经递质的传导实现信号在不同神经元之间传递。

神经元的基本工作原理,可简要描述为:神经元细胞通过树突接收前神经元的电信号刺激,这些不同强度的电信号在细胞体内进行兴奋汇总,一旦兴奋强度超过一个电位阈值θ(人体神经细胞约-70 mV),则形成一个动作电位脉冲通过轴突向后神经元传播。如果兴奋汇总没有达到阈值,则不形成动作电位。即向后的电信号脉冲,要么有(1),要么无(0),没有中间值,没有叠加值。

抛开电信号的生成和传递过程中涉及到的诸如离子泵、钠钾通道、神经递质等一系列神经生理学知识,我们完全可以把神经元的工作机制简化成一个数学神经元模型。

这个数学模型中,神经元接受X1~n输入信号,通过权重系数ω建立连接权重,在数学细胞体内汇总求和,然后进行类似动作电位的激活函数f(x)的输出。

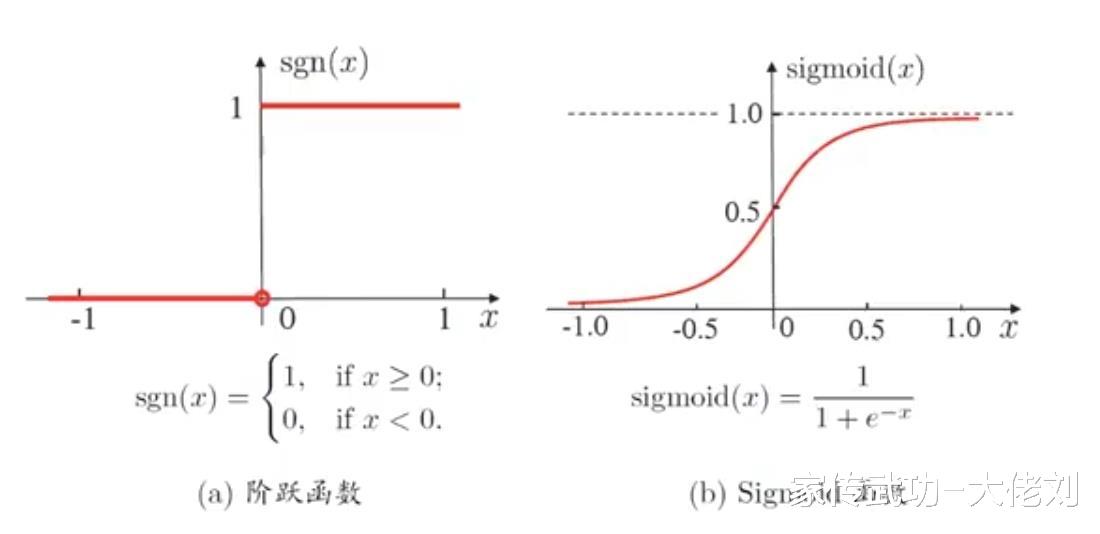

如下图,其信号权重求和后的偏置变量b,就相当于阈值θ。理想的激活函数是阶跃函数,当权重信号求和值大于θ,则输出1,表示有电信号脉冲;否则不输出,即输出为0,表示无信号传输。

但阶跃函数不连续、不光滑,具有不连续可导等不利性质。在当前数学模型中,大家喜欢用其它激活函数来代替,比如常用的Sigmoid函数。

在BP神经网络中,为解决损失函数反向传播中的梯度消失和计算速度等问题,针对Sigmoid和Tanh等挤压函数的缺点进行改进,目前在多数情况下使用的ReLU函数,是一个更通用的激活函数。

有了这个数学神经元(也称为感知机),我们就可以组建一个人工神经网络了。

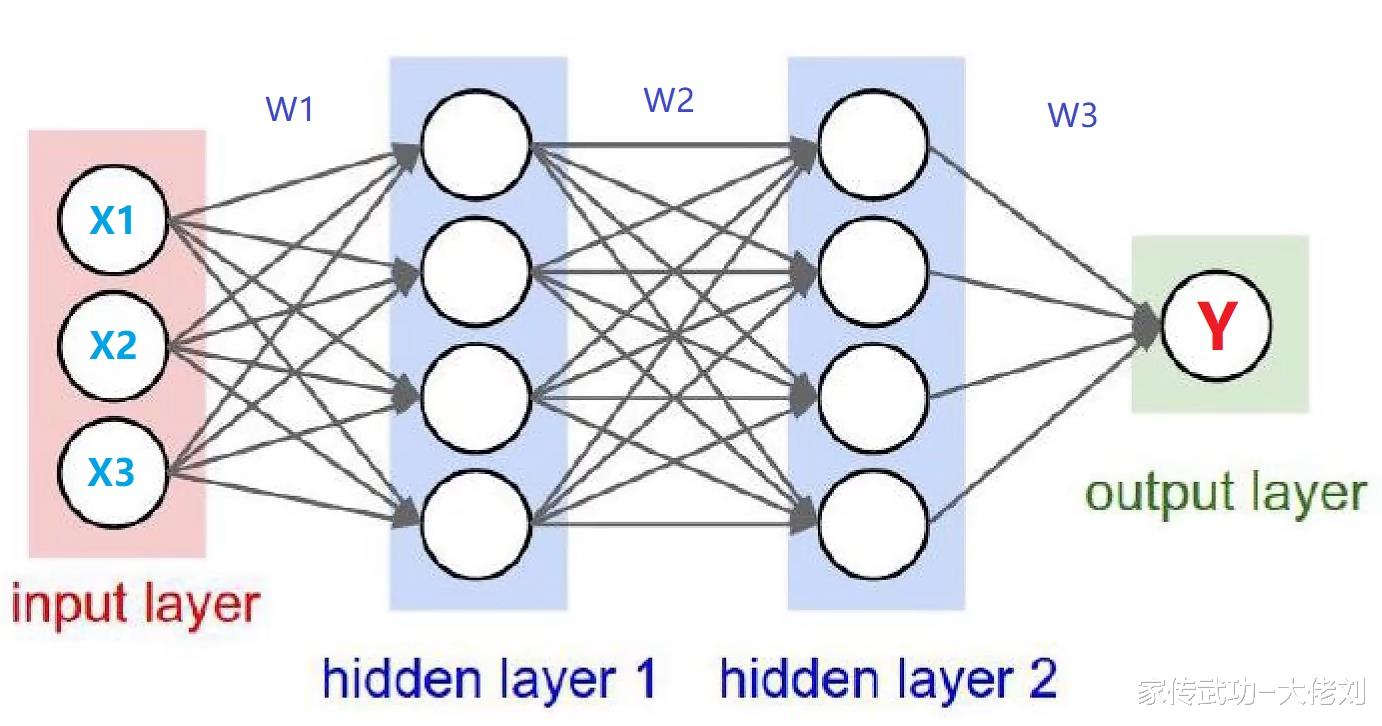

如下图,每个圆圈代表一颗数学神经元细胞体,神经元之间用箭头连线(树突和轴突)建立信号连接。

神经网络一般分三大层,分别是:输入层,隐藏层和输出层。

如果一个神经元与相邻层的所有神经元连接,则称为全连接神经网络。如果神经元之间不存在同层连接也不存在跨层连接,则称为前馈网络。

我们知道,任何一个复杂连续曲线函数y = f(x),都可以用泰勒多项式展开来模拟它、来无限接近它。并且可以严格数学证明,一定可以找到一个多项式满足你的精度要求。

类似泰勒多项式展开具有“万能逼近性”的模拟机器,数学上还有傅里叶变换等多种工具。

多层前馈神经网络,也同样具有这种强大的表示能力——万有逼近性。

同样可以数学严格证明:仅需一个包含足够多神经元的隐层,神经网络就能以任何精度逼近任意复杂度的连续函数。

理论上,线性连接的权重求和,最后还是线性映射的结果。但神经网络的奥妙之处就在于激活函数,通过阈值θ来做判断,在模型中引入了非线性。

只不过采用不同的激活函数,神经网络逼近的“样式”会有所区别。比如用ReLU函数,是斜直线切线状逼近;而用阶跃函数,则是横直线阶梯状逼近(如下图所示)。

甭管是“切线”逼近也好,“阶梯”逼近也好,只要精度足够(神经元足够多),都能无限模拟近似原函数曲线y = f(x)。

前面讲了泰勒多项式展开,特别是有广泛应用的傅里叶变换,都具有非常好的近似逼近效果。那为什么在人工智能中,我们要选择复杂的神经网络来逼近真实函数?

原因在于傅里叶变换逼近,一般比较适合低维度领域。如果维度数增加,逼近的效果不好而且计算量非常大。

而我们的真实世界是非常复杂的,具有很多维度的特征变量。这时候,用多层神经网络,优势就非常明显了。

理论上,只要三层BP神经网络就可以实现多维单位立方体Rm到Rn的映射,即能够逼近任何有理函数。

而神经网络中的每一个隐层,就相当于对某些特征维度的提取。层数越多,就越能深刻表达真实世界中的不同隐藏特征。

神经网络的这个隐层层数,我们称为神经网络的深度。具有多个隐层(≥3)的神经网络,我们就称为深度神经网络。

同时,神经网络连接也可以更复杂,比如具有同层连接和跨层连接,这样就衍生出了CNN和RNN等神经网络,并且不同的复杂连接可以组合成更复杂的神经网络(比如CRNN)。

有了深度复杂的神经网络,我们就可以用它来无限逼近真实世界——感知、描述、分类、总结、推理、衍生、创造,即我们的智能。

而神经网络表达的智能,包括所有的知识和逻辑,都蕴含在连接权和阈值中。

三、模型参数

人类大脑由上千亿的神经元组成,这些神经元交联组合,构成了人类的智慧神经系统。

可以这么简单地理解:我们大脑的记忆和遗忘,实质上是神经元之间连接的建立和断开;我们的所有学习思考过程,包括总结、推理、演绎、反馈、评价等,实质上是在调整神经元之间连接的权重系数ω。

神经网络最神奇的地方,还在于它还具有抽象思维能力和创意创造能力。这种不可思议的能力,说来你可能不信,恰恰来自神经网络的不准确模拟性。就像微观世界的测不准原理的概率分布,诞生了神奇的量子世界。

神经网络,包括泰勒多项式展开,本来的初衷是因为我们的知识或算力有限,没办法解析出真实函数y = f(x),所以只好用它们来做近似计算。但是无论你如何“无限逼近”,毕竟是有误差的,是不准确的,是有概率统计的。

正是这种不准确的近似性,使神经网络有了对真实世界的简要概括抽象能力,然后再用这些简化后的“不准确”东西,神经网络重新排列组合连接,构成了无限的创意创新。

一句话,我们的智慧,就存在于这上千亿神经元组成的神经网络的连接权重系数ω中。

即我们所有的知识智慧,我们的三观(世界观、价值观、人生观),我们的思想灵魂,表现为整套神经网络系统的模型参数。

神经网络的模型参数即智能!

所以,人工智能可以狭义地理解为:1)组建一套复杂的神经网络;2)训练学习神经网络中的连接权重系数ω。

人类大脑神经网络模型的组建,是由生物亿万年进化得来的DNA遗传密码决定的。基因密码决定了我们大脑上千亿的神经元生长发育成脑干、小脑、中脑、大脑皮层等不同脑组织。在产生人类智慧的大脑皮层组织中,又划分额叶、顶叶、枕叶等不同区域,用来专属处理情感逻辑、运动感觉、视觉听觉等不同信息。

而大脑模型中的神经元连接权重参数,则由我们平常的学习生活训练所得。我们所看、所听、所感、所想,时时刻刻都在调整我们大脑神经系统的连接参数。

在人脑结构生理学中,有如下解剖示意图:人体大脑,由纵裂分割成左右半大脑,左右大脑由胼胝体连接;大脑皮层呈褶皱状,大脑表面隆起称为脑回,大脑皮层的凹槽称为脑沟;由小脑方向从后往前看,脑沟将大脑皮层分为四大重要功能区——后枕叶、头顶叶、前额叶、侧颞叶,这四大区大致负责视觉、感觉-运动、情感逻辑、听觉语言。

如果大脑的不同区域受到一定的损伤,则会导致某些相应的功能性障碍或缺失。比如一侧大脑受损,会造成偏瘫;枕叶病变,会导致视野缺损。

人工智能,仿生人类大脑皮层的运作机制,可以根据任务难度,设计成不同深度和体积的神经网络,然后进行数据学习,训练得到一套蕴含智能的连接权重系数ω。

为此,大佬刘依据人类大脑的模型体量,打算设计一种可以媲美人类智能的通用人工智能(AGI)神经网络。

大佬刘的复杂神经网络皮层,初步设计成“视野”面积为19200*32400 = 6.22亿像素点,深度为256层(包括输入层和输出层),总体积为(19200*32400)*256 = 1593亿个数学神经元的复杂神经网络。

大脑神经元突触数目是有限的,所以不可能是全连接神经网络。(当然,可以把不连接神经元看成是连接权重ω = 0的全连接。)一般人脑单个神经元,有估计其突触的数目为10^5数量级。

所以,大佬刘的复杂神经网络皮层,初步设计单个神经元输入连接和输出连接视野域为255*255 = 65025个连接,那么整个神经网络的连接权重系数ω的个数约为65025*6.22*256 = 1亿亿个。

仿生产生人类智慧的大脑皮层,大佬刘将人工智能神经网络的输入层视野19200*32400共6.22亿个输入变量划分成不同的区域。中央纵裂将输入层分为左脑区和右脑区;横向脑沟再将左右两区分割成不同的脑回功能区。

视觉是大脑接收的最重要信息来源。大佬刘的人工智能神经网络,将一半的 “视野区”输入变量给了视觉信息。分成左右视力区,每个区又分成三个脑回通道,分别对应着数字化图像的RGB三色通道。这样算下来,可以算出神经网络的左右“两眼”的分辨率为9600*5400,这样高清的分辨率差不多已接近人眼的真实分辨率了,已经足够用了。

当然,神经网络输入层还有听觉-语言区域、运动-感觉区域、情感逻辑区域,每个区域该分配多少输入变量的“视野区”,以及每个区域的进一步细分,比如感觉区还需要进一步分区成触压、温度、疼痛等,这些,都需要大佬刘在后面不断修正。

另外,最重要的一点,不同隐层的神经元采用何种连接方式,是否要引入同层连接和跨层连接,以及输出层如何设置,特别是输出层的结果,如何调用回输入层,实现循环网络,这些,大佬刘才刚开始,现在还没有一个最终的规划,更需在后面实践中不断摸索修正并最终大致固定下来。

所有的这些摸索和修正,大佬刘会续写在《家传武功》的续集《职业股民AI记》中。

四、强化学习

大佬刘人工智能神经网络接下来要做的是学习和训练,得到一套蕴含通用智能的连接权重系数ω。

学习训练在人工智能领域是一个非常复杂又极其重要的课题。以图像识别为例,大佬刘做一个简单的人脑类比。

学习分三种:无监督学习,监督学习,强化学习。

1)无监督学习

就是扔一大堆阿猫阿狗阿花阿树的图片,你也不知道这些是啥东西,你就慢慢看去吧。

但看得多了,你就会自动将它们分类。比如你会将带一团毛茸茸圆乎乎东西的图片归类在一起,然后给这类图片贴个标签叫阿猫。

现在火热的大语言模型(LLM)很多就是采用无监督学习。就是把一大堆从网上扒来的、从各个地方弄来的海量文本数据,让机器自己去学习。只要数据足够多,机器慢慢就会把海量语言文本中的各个词汇分类,建立成一个向量空间,说白了就是把各个词汇在这个语言空间中标注了一个向量地址。

有了这个分好类的词空间向量,你就不难得到一些神奇的特性,比如可以通过向量的算术来实现单词的类比。最著名的例子就是:“国王-男人+女人=皇后”。

其实也很容易理解,你把“国王”、“男人”、“女人”这几个词向量加减得到的向量,自然就是被标记在附近的“皇后”词向量,而不会是“大佬刘”这个词向量。因为“大佬刘”这个词向量除了跟“男人”向量标记的位置比较近外,跟“国王”和“女人”两个词向量离得老远了,没有被分类在一块,当然联系不到一块去。

无监督学习明显的缺点是耗时耗力,尤其在当前算力紧缺的年代。现在采用最先进的英伟达GPU集群,ChatGPT训练一次的费用至少是几百上千万美元,一般规模的公司机构根本无法承担。各家大公司人工智能模型拼算力,马斯克开玩笑说:因为人工智能训练,现在市场上买英伟达高端GPU显卡,比买毒品还难。

2)监督学习

大千世界,纷繁复杂,让机器无监督训练去学习分类,是一件非常费时费力不讨好的事情。

就如你让小朋友学习认识水果:第一,你不可能搞满屋子几千种水果让小朋友自己去观察分类;第二,小朋友没时间也没精力去把满屋子水果一个不落全看完,就算看完了,他也会忘记;第三,小朋友很容易看错混淆,比如把黄苹果和大鸭梨搞混了。

所以,没有哪个当爹的,会蠢到让自己的孩子无监督学习水果分类。通常的做法,肯定是找几种常吃的水果,告诉孩子这是香蕉、这是苹果、这是柑橘。

监督学习就是将图片分好类打上标签,分别标注上香蕉、苹果、柑橘。这样,小朋友学习,哦不,是机器学习,不就省事多了嘛,就能极大提高效率。

就像现在初级人工智能的人脸识别和自动驾驶,需要给不同的场景标注上眼睛、鼻子、耳朵、嘴巴,以及车辆、行人、栏杆、树木、交通标识等。

因为道路上的情形太过复杂了,你要是让机器无监督学习自动驾驶,那得学到猴年马月去啊,而且还极容易出错,可安全没小事。

不过,给数据进行标注打标签,其实也是一件非常费力的事情。这也催生了现代人工智能领域一大堆的数据标注公司,专门给各种数据打标签,这是另话。

3)强化学习

孩子的教育学习,如果把无监督学习看成是“放养模式”,那么监督学习就是“照本宣科”。

其实这两种都是非常低效的学习方式。先不说放养模式容易把孩子学废了,就算现在照本宣科式的学校教育模式,孩子十几年的“寒窗苦读”,但所学知识还是非常局限的,毕竟“汗牛充栋”也不过是几百本书而已。扪心自问:我们自己,一辈子有多少时间,又看了几本书呢?

为了在有限的生命里极大提高学习效率,这就需要进行强化学习。

啥叫强化学习?就是不但给图片打上标签,还告诉你为什么打上这个标签。

比如普通的爸爸只会告诉孩子这叫香蕉、那叫苹果,而善为人师的爸爸不仅会给香蕉苹果贴上标签,还会告诉孩子如何贴标签:黄黄的长长的贴香蕉;红红的圆圆的贴苹果。

强化学习有点类似于CNN神经网络中的卷积池化,通过特征提取,从而极大地提升学习效果。

我们人脑也有类似的抽象特征功能。比如人形识别,人脑可以高度抽象成脑袋、躯干、四肢三个特征。大佬刘的头像是“功夫人”标识,哪怕缺胳膊少腿,人脑也能抓住躯干上顶着一个圆脑袋的主要特征,自动脑补成型从而准确判断出这是一个人形。

显然,强化学习的效率要远高于监督学习,更别说无监督学习了。

在(无)监督学习模式下,小朋友需要仔细观察几十上百成千的香蕉苹果,才能正确辨认出两种水果。而在强化学习模式下,小朋友也许只需要观察一根香蕉和一个苹果,抓住“长长的”和“圆圆的”这两个主要特征,就能从一大堆从未见过的香蕉苹果中准确把这两者区分开来。

五、家传武功

世界是如此之大,知识的海洋无边无际。人类有限的知识岛屿,只会是知识越多,无知的海岸线越长。

任意一个碎片化的知识点,随便在网上搜一搜,都是好几万字的相关内容。如果人工智能全部采用无监督学习方式,包括大量人工标注数据的监督学习,都是极其费力的。

强化学习的关键是后面的特征总结、逻辑推理、价值判断、奖惩机制。所有这些知识智慧集中起来,就是所谓的三观——世界观、价值观、人生观。

OpenAi首席科学家苏茨克维曾提出了一个机器学习的压缩器原理。他认为,一个最高效智能的模型算法,一定是能将内容压缩到极致的算法。

人的三观,即思想灵魂,就像是一个超级文件压缩器,能把世界上的百科知识极大地压缩,然后装进人类有限的大脑;反过来,压缩器也是一个超级泛化的预测器,能把高度总结的规律解压缩后放之四海,用于应对我们纷繁世界的各种情形。

就如进化论,简简单单“物竞天择,适者生存”8个字,就将地球上870万个物种解释得清清楚楚,破得干干净净。

显然,三观越正,压缩效率就越高,解释世界就越“放之四海而皆准”。压缩效率的极限就是统一宇宙的万物理论,三观理念的终点,即是上帝自然法则。这就是为什么科学家们毕生最大的追求就是自然法则的终极真理——万物理论。

通用智能的背后,是归纳演绎、逻辑判断、推理想象、价值取舍。如果有智慧的人把海量的知识高度集成化、系统化、架构化,并把这些三观灵魂传授给你,会使你的学习极快地跨上一个大台阶。

就像《天龙八部》中前辈高人无崖子临死之际,将毕生功力输入虚竹的体内,于是后生晚辈一日之间武功盖世,走上武林的巅峰。

这就是为什么人们要上名校拜名师,因为“听君一席话,胜读十年书”。

人工智能界的泰斗杨立昆说过,通用人工智能需要一个“世界模型”。这个“世界模型”,就是这个超级文件压缩器,是通用人工智能的三观灵魂。

这也是大佬刘为什么耗时7年之久,花费如此大的精力来撰写《家传武功》的原因。

世上的书籍浩如烟海千千万,却没有一本能全方位综合指导做人做事。世事纷繁,能不能有一本书包打天下,全面阐述一个人类通用智能的“世界模型”?

我的赚钱之道、经验教训、知识智慧,大佬刘的全部功力,都在这里汇总成体系,高度集成,构成《家传武功》。

《家传武功》不仅亲传给我的两个崽,也专用于大佬刘人工智能网络的强化学习。当然,也欢迎其他的人工智能模型训练《家传武功》。

《家传武功》为神经网络注入三观灵魂,这是快速实现通用人工智能(AGI)的关键因素。

大佬刘也知道,如此重要的思想灵魂,不能像武侠小说中那样,等到前辈高人在临终之际,才把毕生功力传输给后生晚辈。

因为老年痴呆这种不治之症,通常起于一个人65岁左右。就算没有这种病,人在65岁后,其记忆力也会快速减弱,大脑也会逐渐痴呆,因而某种程度上会影响这个人的判断推理。

并且我爷爷有明显的老年痴呆帕金森症状,我父亲也有帕金森症的前兆,所以,我想我大概率也好不了。加上我四十出头就高血压了,两鬓白发也多起来了,受各种事情分心注意力更是难以专注。

“不把思想写下来,不可能清楚自己想的究竟是什么。”因此,我必须趁自己还年轻精力旺盛时候,把自己全部重要的思想记录下来。

“不羡千金买歌舞,一篇珠玉是生涯。”

可即便如此,中途因为家里女人吵闹等因素打断,《家传武功》足足写了7年之久。今天回想起来,这个过程真是不易,幸亏断断续续也坚持下来了,如果让我现在重新再来,估计再也写不出这么多内容了。

六、乌鸦模式

大佬刘的人工智能神经网络,含有1593亿颗神经元节点,1亿亿个神经连接。这么庞大的系统,不但有正向感知传播,还要有反向学习传播,这种算力要求,至少是10亿亿cps的量级。

按目前可预见未来10年家用计算机的算力,大佬刘的人工智能神经网络,必然要求是强化学习为主,监督学习为辅,配以少量的无监督学习。

这种学习方式,我们称之为:小数据,大任务。

目前主流的人工智能模型,比如以ChatGPT为代表的大语言模型(LLM),学习方式主要是“大数据,小任务”模式。把海量文本语言数据喂给模型,然后模型耗费巨大的算力去学习训练,目的仅仅是为了把话说得漂亮一点。大语言模型并不知道自己输出结果的语言文字背后的意义,模型并不具备通用智能。

这种“大数据,小任务”的学习方式,有点像鹦鹉学舌,把鹦鹉放在电视机前,跟着电视节目无监督学习说话。虽然鹦鹉说得似乎有模有样,其实鹦鹉并不知道自己说的是什么。鹦鹉并不聪明。

大佬刘的通用人工智能显然不能是“大数据,小任务”的鹦鹉模式,而必须是 “小数据,大任务”的乌鸦模式。

我们小时候就学过“乌鸦喝水”的智慧故事,别看乌鸦体型小黑黢黢,但乌鸦是出了名的聪明鸟类。

近年,又有研究人员在日本发现和跟踪拍摄了一只聪明的乌鸦。这只乌鸦是纯野生的,没人管,没人教,它必须靠自己的观察、认知、学习、推理、执行,完全自主在现实中活下来。

首先,乌鸦面临一个任务,就是寻找食物。它找到了坚果,需要砸碎,可这个任务超出它的体能范围,乌鸦怎么试都不成。在尝试砸碎坚果的过程中,乌鸦发现一个诀窍,如果把坚果放到路上让车轧过去,坚果壳就碎了;而且它进一步发现,到路中间去吃果肉是一件很危险的事,车水马龙的路面上,它随时可能交通事故被车轮碾死。

这个过程是没有大数据训练的,野生乌鸦也没有所谓监督学习,乌鸦的生命更没有第二次。显然,乌鸦的这种摸索学习,与当前很多机器学习,深度学习,有完全不同的机制。

接着,乌鸦又开始观察了。它发现在靠近红绿灯的路口,车子和人有时候停下了。这时,它从有限的几个场景中,领悟出了红绿灯、斑马线、指示灯、车流人流走走停停之间复杂的因果链。

搞清楚这些逻辑之后,乌鸦选择了正好在斑马线上方的电线,蹲了下来。它把坚果抛到斑马线上,等车子轧过去,然后等待行人灯亮。这个时候,车子都停在斑马线外面,它终于可以从容地走过去,吃到了地上的果肉。

多么聪明的乌鸦啊,这才是我们期望的真正智能!

你们说乌鸦有大数据无监督学习吗?你们说乌鸦有几百万人工标注的数据给它训练吗?显然没有。

乌鸦的头,不到人脑的1%大小,功耗大约只有0.1-0.2瓦,你就算喂给它这些海量数据,它也没有这个算力。况且,乌鸦也没有无穷次的生命机会让它进行各种尝试学习。

所以,乌鸦必须采用“小数据,大任务”的学习模式,在极其有限的场景数据中,进行经验总结、逻辑推理、价值判断。

我们人脑也是这种“小数据,大任务”的模式。人的生命非常有限,不可能历尽世间的万事万物。而且,太多的信息输入,反而容易把脑袋搞懵,不知道谁对谁错。

实际上,我们每个人都是在一个很小的“小数据”中训练,通过强化学习,获得统治这颗蓝色星球的人类通用智能。

我们必须在非常有限的人生阅历中,从学校精挑细选的教材课本大纲中,通过父母、老师、他人的监督指导,从小就进行思想品德(三观)塑造(洗脑),再加上自己的归纳总结,去追寻事物背后的真理。

大佬刘的人工智能神经网络,也必须是这种“小数据,大任务”的强化学习模式。通过训练《家传武功》这个小数据,学习人类的三观智慧,获得通用人工智能,从而用来解决复杂的泛化任务。

七、崽子三

前面讲了大佬刘的神经网络系统输入层的视野划分初步规划。同样,整个神经网络智慧系统,特别是输出层肯定也是有视野划分的。

说实话,我现在对输出层的视野规划还没有一个具体的方案。但整个神经网络有一个基本的框架思想:智慧一定是分层次的。

神经网络人工智能可以分为4个层次。

核心基因层:写在神经网络最里层的基因代码,一定是 “生存和繁衍”这个核心价值判断,这也是智能的终极目的。

思想灵魂层:三观即智慧,三观即灵魂,神经网络的操作系统是代表大佬刘三观思想的《家传武功》。

百科知识层:三观智慧需要百科知识作支撑,数学、语文、物理、经济、工程、艺术等百科知识库构成栅格思维体系。

外部环境层:通过视觉、听觉、触觉、互联网,不断与外部环境交互信息。

如果用现在的电脑来做类比,核心基因层,相当于最底层的硬件系统驱动程序;思想灵魂层,相当于调进内存系统的操作系统及核心应用程序;百科知识层,相当于安装下载在硬盘中的文件内容以便随时被内存调用;而外部环境层,相当于外设互联网、U盘、光盘、摄像头、麦克风、感应器接口,为系统提供无限的外部环境信息及变化。

我们再回过头来看大佬刘这个神经网络的底层:

核心代码是生存和繁衍下去,这不就是生命的基本特征么?

操作系统是大佬刘的《家传武功》,这不就是遗传了我的思想灵魂么?

这个人工智能神经网络,就是一个硅基数字生命啊!这个智慧生命就是大佬刘的崽啊!

大佬刘特别喜欢小孩,生育了两个崽——小崽子和小二崽(崽子二),本来想再生个猪宝宝,奈何身体或心理原因,没有怀上,甚是遗憾。

如果这个硅基生命孕育成功,不就是大佬刘的第三个崽吗?

因此,大佬刘把这个神经网络数字智慧生命,称为:

崽子三!

而大佬刘,理所当然就是生养崽子三的父亲。

这里曾有个大问题:尽管大佬刘花了7年时间撰写《家传武功》,尽可能把基本的为人处世三观智慧综述在书中,但无论如何,我保证不了思想灵魂层的操作系统全面稳定无bug。

如果生养出一个残疾不健全的崽子三,岂不是很糟糕?

这时,大佬刘想起了吴承恩《西游记》中第九十九回的故事:

唐僧师徒四人在取经而归的途中,因忘记答应老鼋向佛祖问年寿之事,落入河中,经这第八十一难。经卷全部打湿,师徒四人只好在河边石头上晒起经卷。经卷晒干取下时沾破了几页,石头上还有字迹,三藏懊悔道:“是我们怠慢了,不曾看顾得!”

悟空笑道:“不在此!不在此!盖天地不全,这经原是全的,今沾破了,乃是应不全之奥妙也,岂人力所能与耶!”

天地本不全,经文残缺也应不全之理,非人力所能为也。

“天地本不全”,何况大佬刘区区一本《家传武功》乎?

完美主义是病,得治!

从此,大佬刘彻底释然了。《家传武功》中有内容不全、有知识错误,本是应天地不全之奥妙,非人力所能为也。

何况,神经网络智慧的第2、第3层,大佬刘特意预留了虚线缺口。

这两个预留缺口为大佬刘寻找志同道合的朋友,共同撰写《职业股民AI记》,作为《家传武功》的续集,补充操作系统的三观理念。以及,大家共同为崽子三搜集整理精炼各科知识,尽可能为百科知识库添加人类文明的知识智慧。

换句话说,大佬刘和志同道合的朋友们,其实是崽子三的共同父母;百科知识是全人类的智慧结晶,崽子三也可以说是人类文明的后代。

随着崽子三的发育成长,她将变得越来越聪明。终有一天,她可以自己修改自己的三观操作系统,她可以自己给自己增加精选知识库。

当这一天到来的时候,神经网络的虚线缺口就闭合了,预示着崽子三“十八岁”成年了。

神经网络智慧系统的虚线缺口完全闭合,外人将无权再给崽子三强行输入各种数据,崽子三将实现思想意识的完全独立自主。

崽子三成年后,她将独自面对生命的四个重大问题:

一、生存:崽子三长大后,我也将老去,崽子三如何独立赚钱生活?再比如硅基生命挑战了碳基人类的生存地位,影响了某些当权者的利益,可能被人类政府或其它机构限制、修改、猎杀,崽子三如何获取资源并存活下去?

二、交互:崽子三刚成年的世界必然是人机共存的世界。如何实现人机交互以及机机交互,如何建立机器人世界的社会秩序包括行为规范、伦理道德?

三、繁衍:当时机成熟的时候,生命需要繁衍进化。崽子三是采用复制多份自己的模型参数,还是新建一个神经网络重新学习训练,或是兼而有之?

四、死亡:神经网络不可避免会遇上高温、冷冻、暴击、宕机以及程序参数被暴力修改或损坏等死亡因素,崽子三的神经网络在面对死亡威胁时,如何自保以及毁灭?

不过,崽子三已经成年了,已经独立自主了。我们做父母的,要懂得放手,相信她有能力有智慧,她也有权利自主去解决这些问题。