作者|贾桂鹏

2月21日,有外媒报道,微软正在开发的一款新网卡即将面世,它可以提高其Maia AI服务器芯片的性能。据悉,微软首席执行官萨蒂亚·纳德拉(Satya Nadella ) 已任命网络设备开发商瞻博网络 (Juniper Networks) 联合创始人普拉迪普·辛杜 (Pradeep Sindhu) 来领导新网卡的工作。

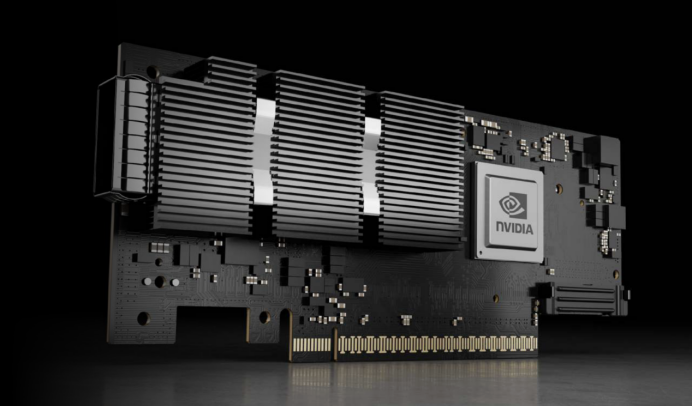

值得注意的是,微软这款新网卡类似于英伟达的ConnectX-7网卡,其目的不言而喻,就是极力摆脱微软对于英伟达的依赖。

其实,这已经不是微软在近期第一次踏足半导体领域了,在去年11月的Microsoft Ignite大会上,该公司就推出了两款定制设计的芯片。而此次,在短时间内再公开一款全新半导体产品,微软有何用意呢?对标英伟达,微软自研网卡

当下,网络技术和硬件设备的不断发展已经改变了数据中心的格局。随着虚拟化、微服务架构的不断激增,以及移动设备和云服务的高度利用率,网络工作负载的增加速度已经远远超过了传统数据中心CPU的处理速度。这使得寻找更高性能、更灵活性以及更强大功能的网络解决方案变得迫切。

这也意味着,网卡是数据中心的重要技术,它用于提高服务器的流量速度,有外媒表示,微软新网卡的推出可减少OpenAI用服务器训练AI大模型的时间。

此前,微软在其数据中心使用英伟达的AI芯片时,服务器需要传输OpenAI等AI开发客户所需的大量数据,可能因此过载,导致训练和推理要花费更多的时间,OpenAI的CEO Sam Altman也曾私下表达过对微软算力相比谷歌逊色的担忧。

据了解,微软在新网卡开发过程可能需要超过一年的时间,其成品类似于英伟达的ConnectX-7网卡,主要用于提高服务器的流量速度。

虽然微软全新网卡还未面世,但是我们也可以从ConnectX-7的性能上推测出它的能力。

NVIDIA ConnectX-7网卡提供最多4个连接端口和最高400Gb/s的吞吐量,可为云、电信、AI 和企业工作负载提供数据中心规模的硬件加速网络、存储、安全和管理服务。

ConnectX-7通过加速交换和数据包处理(ASAP2)、高级RoCE、GPUDirect Storage,以及用于TLS、IPsec和MACsec加密和解密的内联硬件加速等功能,为高性能网络解决方案赋能。

可以预见,如果要拥有更快的速度,微软的网卡一定会超过400Gb/s的吞吐量,甚至会超过500Gb/s,而且在加密和解密的功能上更具有竞争力。

针对于新网卡,微软发言人在一份声明中表示,作为微软Azure云基础设施系统方法的一部分,微软专注于优化堆栈的每一层,公司经常开发新技术满足客户的需求,包括网络芯片。

若微软开发网卡成功,这将是他们短时间内再次传达出与英伟达竞争的意愿。相比于此前的高调,微软这次似乎变得更务实。

微软开始布局半导体产业

去年11月中旬,微软推出两款高端定制芯片,为Azure服务,分别是微软的首款AI芯片Maia 100,以及英特尔CPU的竞品:基于Arm架构的云原生芯片Cobalt 100。

其中,Maia 100用于OpenAI模型、Bing、GitHub Copilot和ChatGPT等AI工作负载运行云端训练和推理。它采用台积电的5nm工艺制造,有1050亿个晶体管,比AMD挑战英伟达的AI芯片MI300X的1530亿个晶体管少约30%。

其实,在微软看来,芯片是云的核心,它们控制着数十亿个晶体管,处理流经数据中心的大量任务。这些芯片将安装在定制服务器主板上,放置在定制的机架内,可以轻松安装到现有的微软数据中心内。硬件将与软件携手合作,共同设计以释放新的功能和机遇。

对于微软自研芯片,元宇宙新声认为,他们最终目标是让Azure的硬件系统能够提供更好的灵活性,并且还可以针对功耗、性能、可持续性或成本进行优化。

事实上,长期以来,微软一直希望在其机群中找到X86架构的替代方案。

早在2017年,微软就表示其目标是让Arm服务器占其服务器计算能力的50%。几年前,微软凭借其“Vulcan”ThunderX2 Arm服务器CPU成为Cavium/Marvell的早期客户,当Marvell在2020年底或2021年初做出封存 ThunderX3的决定时,微软有望成为“Triton”ThunderX3后续CPU的大买家。

因此2022年,微软采用了AmpereComputing的Altra系列Arm CPU,并开始将其大量放入其服务器群中,但一直以来都有传言称该公司正在开发自己的Arm服务器CPU,Cobalt 100就成为了公司的答案。

虽然,微软自研芯片并没有最终成型,但其部分目的已经达成,那就是微软可以与芯片制造商英特尔、AMD和英伟达谈判以获得更好的定价。

其实,不仅仅是微软,大型科技厂商如谷歌、亚马逊等都在近年来推出自研芯片,在降低数据中心使用成本的同时还谋求在市场中更大的话语权。

科技巨头们的半导体梦

众所周知,英伟达在AI算力方面是当仁不让的强者,其A100/H100系列芯片也占据着算力天花板的位置,但很多用户都对于其高昂售价提出不满。因此,无论是为了降低成本,还是减少对英伟达的依赖、提高议价能力,科技巨头们都纷纷下场自研AI芯片。

其中,谷歌早在2013年,就已秘密研发一款专注于AI机器学习算法的芯片,并将其用在内部的云端计算数据中心中,以取代英伟达的GPU。这款自研芯片TPU于2016年公诸于世,可以为深度学习模型执行大规模矩阵运算,例如用于自然语言处理、计算机视觉和推荐系统的模型。实际上,谷歌2020年便已在其数据中心部署了AI芯片TPU v4。不过直到去年才首次公开了技术细节。

另一家科技巨头,亚马逊从2013年推出首颗Nitro 1芯片至今,其云服务业务AWS也是最先涉足自研芯片的云端厂商,已拥有网路芯片、伺服器芯片、人工智慧机器学习自研芯片三条产品线。AWS自研AI芯片版图包括推理芯片Inferentia和训练芯片Trainium。

2023年初,专为人工智慧打造的Inferentia 2发布,将计算性能提高了三倍,加速器总内存提高了四分之一,可通过芯片间的直接超高速连接支持分布式推理,最多可支持1750亿个参数,这使其成为大规模模型推理的有力竞争者。

亚马逊大力投资自研云端服务器芯片意味着云端服务器芯片的市场格局发生变化,通用的CPU和GPU无法覆盖整个市场需求。从技术层面上来说,随着深度学习神经网络模型对于算力的需求快速提升,这意味着将催生高性能计算芯片市场较快发展。

Meta直到2022年,还主要使用CPU和专为加速AI算法而设计的定制芯片组合来运行其AI工作负载,但CPU的效率往往不如GPU。后来Meta取消了于2022年大规模推出定制芯片的计划,转而订购了价值数十亿美元的英伟达GPU。

为扭转局面,Meta已经在开发内部芯片,并于5月19日公布了AI训练与推理芯片项目。据介绍,该芯片的功耗仅为25瓦,占英伟达等市场领先供应商芯片功耗的一小部分,并使用了RISC-V(第五代精简指令处理器)开源架构。

而电动车大厂特斯拉则立足于智能驾驶,目前已经推出了两种自研芯片,分别为全自动驾驶(FSD)和Dojo D1芯片。FSD芯片用于特斯拉汽车上的自动驾驶系统;Dojo D1芯片则用于特斯拉超级计算机Dojo芯片,它是一种通用的CPU,目的是加速特斯拉自动驾驶系统的训练和改进。

元宇宙新声认为,一方面,绝大多数公司的自研芯片,本质上是基于新场景的创新。比如大规模的虚拟化需求、AI需求,视频图片编解码需求。这种创新虽然离英伟达、英特尔等半导体巨头还有距离,但半导体行业是一个需要长期布局的产业,科技企业提早入局也将为之后的研发打下基础。

写在最后

当下,集成电路进入后摩尔时代,科技巨头们在芯片设计中面临的挑战逐渐增多。随着AI芯片性能需求加重,需要不断投入至先进工艺中,其带来的技术好处也不像之前那样的线性与直接。而且,功能的增加和对效能要求的提升,其在流片费用、设计复杂度以及开发周期等方面也面临越来越严峻的挑战。

元宇宙新声认为,对于参与其中的企业而言,其不仅要在系统应用方面加强顶层设计,增强算法到设计,以及算法、软件、架构、软硬件协同等各方面的优化和战略协同,而且还必须要从数字设计到物理实现,以及工艺封装等各个层面进行综合思考,统筹各种因素以求取最优解。而要达成这样的过程,必然需要花费很多的时间和资金投入,不是一个短期可以达成的目标。