摘要:我们针对服务器浸没式液冷实验台进行了深入测试,探究了不同室外温度和服务器发热功率对系统制冷PUE的影响。实验数据显示,该系统的制冷PUE值介于1.05至1.28之间,高效节能特点显著。

在室外温度高达39℃、负载功率为3.773kW的极端条件下,制冷PUE仍能达到优异的1.056。此外,本研究还发现,上海市数据中心全年平均制冷PUE值为1.060。值得一提的是,采用浸没式液冷技术的数据中心,其冷却系统能耗仅为传统精密空调的十分之一。

关键词:数据中心 浸没式液冷 制冷PUE 节能

工信部2019年数据显示,截至2017年底,我国数据中心机架规模激增33.4%,其中大型及以上数据中心增速更是高达68%。而据绿色和平组织与华北电力大学联合报告指出,2018年中国数据中心用电量已占全社会用电量的2.35%,预计未来五年还将猛增66%。值得注意的是,数据中心电能消耗中,冷却系统耗电约占四成。因此,减少冷却系统能耗成为数据中心节能减排的重中之重。

数据中心单机柜发热功率已超20kW,传统空调难以应对高功率及局部热点,能耗高且散热受限。浸没式液冷凭借卓越换热效率,有效应对挑战,被广泛应用。本文深入剖析其换热效能与节能潜力,助力数据中心绿色高效发展。

1 浸没式液冷实验台及实验方法

1.1 浸没式液冷实验台

浸没式液冷技术分为单相与两相两种,本研究聚焦于两相浸没式液冷,其中液体会在气液两相间转变。为测试其换热效率,我们精心搭建了实验台,配备了箱体、加热负载、冷凝盘管、风机、水泵及数据采集装置等核心设备。实验台配置详见图1。通过这一专业实验台,我们将深入探索浸没式液冷的性能表现。

实验台箱体及内部装置均置于室内环境舱,精确调控空气参数。室内环境舱内,箱体尺寸为0.4m×1m×1.4m,加热负载位于中下部,冷凝盘管位于上部。液体完全浸没加热元件,确保实验高效。箱体正面、右侧面及上表面采用透明材料,让实验人员轻松观察实验情况,确保实验过程清晰可见。

图2展示了3个模拟服务器的加热负载,相比服务器,其加热量更稳定。每负载可输出0至4kW热量,长度100cm,发热圆柱直径2.5cm,翅片直径5cm。图2直观呈现了模拟服务器的加热负载设计。

1.2 浸没式液冷实验方法

风机和水泵位于室外侧,设置风机频率为20Hz,水泵频率为20Hz。设置风机和水泵频率均为20Hz是由于实验配置的风机和水泵容量较大,而频率可调范围为20Hz到50Hz,通过预实验得到20Hz工况已能满足实验稳定运行。实验流程图如图3所示。

1)设置室外侧环境的温度,大约90分钟后温度稳定。

2)设置负载加热功率,等待进口水温、出口水温等参数稳定,大约30分钟后温度稳定。

3)记录数据,包括室内侧温度、室外侧温度、进水温度、出水温度、气体温度、液体温度、风机出风温度、风机功率、水泵功率、负载功率。每5分钟记录一次,共3次。

4)改变负载加热功率值,重复上述2、3步,如图3示粗箭头线。

5)改变室外侧温度,重复上述14步,如图3示细箭头线。

上海市年均高温(>35℃)天数达7.6天,极端高温可达40.2℃。本次室外温度测试覆盖9个关键区间,包括10℃至42℃,全面模拟上海市最不利天气条件,确保测试结果的全面性和准确性。

图3 实验流程示意图

1.3 实验仪器技术参数 表1为实验仪器技术参数表。

2 实验结果及分析

2.1 实验结果

本实验在不同室外温度下监测了风机、水泵及负载加热的功率。风机和水泵定频运行,功率分别稳定在145W和67W的低区间。在相同室外温度下,负载加热功率可实现0.8至3.8kW的灵活调节,满足多样化需求。

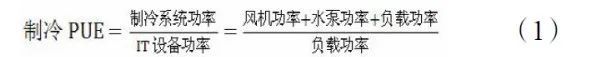

如图4所示,制冷PUE值在负载加热功率变化下保持在1.05至1.28之间,定义为制冷效率与总能耗之比。

图4显示制冷PUE值随加热功率和室外温度变化具有一致性趋势,即随负载加热功率上升而降低。最大PUE值1.270出现在室外30℃、负载0.895kW时;最小值1.056则在室外39℃、负载3.773kW时达到。这一数据揭示了制冷效率与环境条件及负载之间的密切关系。

图5展示了室外侧温度为42℃时,进口水温、出口水温、气体温度随加热功率的变化。随着负载加热功率的上升,进口水温从42.9℃升高到了44.7℃,升高1.8℃。出口水温从43.9℃升高到52.7℃,升高了8.8℃。

图5 室外侧温度42℃时,进口水温、出口水温、气体温度随加热功率的变化

2.2 全年制冷PUE计算

数据中心能耗涵盖IT设备、制冷、供配电系统及照明等,PUE计算公式精准反映能耗结构,助力绿色数据中心建设。

关于数据中心能耗的构成比例,学者做了大量的调查与研究。虽然研究结果中各部分占比不尽相同,但能耗构成种类及排序基本相同。根据文献[3-7]中数据中心的容量以及能耗构成比例可以得出,使用传统精密空调的数据中心总能耗中,IT设备能耗占比最高,约为56%。

图6 使用传统精密空调的数据中心全年能耗比例

本文阐述了在特定室外温度和负载加热功率条件下的制冷PUE。为全面评估数据中心能效,需采用全年制冷PUE指标,具体计算公式依据制冷PUE得出,详见下文。

根据上海市气象文件,我们将天气按温度划分为8个等级,与实验数据相匹配,具体为10、15、20、25、30、33、36、39℃。详细对应关系参见表2。

上海地区全年制冷PUE仅为1.060,较传统精密空调数据中心(PUE-1.609)显著降低,制冷能耗降幅高达90.2%,显著提升能效表现。

3 结论

本文通过对浸没式液冷实验台进行测试,得出以下结论:

1)在不同室外侧温度、相同的发热功率下,制冷PUE值基本相同。

制冷PUE随着负载加热功率上升而降低,趋势一致。其最大值1.270出现在室外30℃、负载功率0.895kW时,而最小值1.056则对应室外39℃、负载功率3.773kW。高效制冷,性能稳定,PUE值变化精准可控。

上海市某数据中心采用浸没式液冷技术,全年制冷PUE低至1.060,与传统精密空调相比,其制冷能耗锐减90.2%,节能效果显著。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-