普通人千万别在本地部署DeepSeek R1!

DeepSeek的服务器最近太忙了,为了能持续稳定地体验强大的DeepSeek R1,有的人想到了本地部署。

然而,虽然DeepSeek R1很强,但仅限于满血版671B的那个,本地很难部署满血版,能本地部署的蒸馏模型效果实在太差,参数越小性能越差。

比如,同样一个问题,我甩给只有80亿参数(8B)的DeepSeek R1,模型给出的回答让人不明所以。同样的问题甩给DeepSeek R1满血版,这简直就是呼兰附体了。

当然,尺寸大点的蒸馏模型效果会好些,但是就为了聊天而在本地部署,你要投入的成本实在太高了,关键它真的还不如免费体验个在线版。

所以我说,蒸馏的小模型完成点垂类简单任务还可以,但是让他跟你聊天,会直接让你丧失对DeepSeek的兴趣,普通个人千万别考虑本地部署!

18家公有云服务商,谁能拯救DeepSeek难民?

但是,面对“服务器繁忙,请稍后再试”的报错提示,大家都是DeepSeek难民。所以,就只能求助其他部署了DeepSeek的好心人了。

截至到2025年2月10日,我注意到有大概18家公有云厂商宣布支持DeepSeek大模型,其中包含多个推荐个人用户体验的在线云服务。

当然,不推荐的并不是云服务不好,只是对于不把DeepSeek用作生产力的个人用户而言,盲目付费不如免费尝鲜。

1,微软Azure

1月30日,微软Azure宣布DeepSeek R1上架Azure AI Foundry,用户可通过Azure AI Foundry模型目录的无服务器端点来使用。

尽管作为OpenAI的最大股东,但微软对DeepSeek的支持速度也毫不迟疑,很快就成了其企业级AI服务的一部分。

但是个人尝鲜不推荐,Azure的前端页面管理系统比较复杂,注册起来也比较麻烦。附相关链接:

https://azure.microsoft.com/en-us/products/ai-foundry

2,亚马逊云科技

1月30日,亚马逊云科技宣布Amazon Bedrock的自定义模型导入功能支持DeepSeek R1。

随后,DeepSeek-R1全系包括满血版都上架到了Amazon Bedrock Marketplace,同时也可以使用Amazon SageMaker JumpStart快速部署,可以用Amazon Bedrock导入自定义模型,也可以开启Amazon EC2的Trn1实例来部署。

虽然AWS的部署方案很多,使用逻辑也比Azure要简单清晰易懂,但仅推荐给不介意额外费用的用户。附相关链接:

https://aws.amazon.com/

3,英伟达NVIDIA NIM(推荐个人尝鲜)

2月1日,英伟达宣布6710 亿参数的 DeepSeek-R1 模型现已作为英伟达NIM微服务预览版在build.nvidia.com上提供。

DeepSeek-R1 NIM 微服务可以在单个英伟达 HGX H200 系统上每秒提供多达3872 Token,主打一个N卡强大。

推荐个人尝鲜免费试用,但我试了几次,就是速度没想象中那么快。直达链接:

https://build.nvidia.com/deepseek-ai/deepseek-r1

4,中国电信天翼云(推荐个人尝鲜)

2月1日,天翼云宣布接入DeepSeek。而后,天翼云“息壤”智算平台完成国产算力与DeepSeek-R1/V3的深度适配优化。用户可以选择用华为昇腾或英伟达的加速卡来部署满血版DeepSeek R1。

天翼云“息壤”智算平台同步推出DeepSeek-R1/V3系列模型的限时免费推理API服务,可以提供高稳定的生产级API。此外,注册用户也可以限时免费体验这款模型,说是能免费体验两周。

专业玩家,打算生产环境部署的,可以在这里体验尝鲜:

https://huiju.ctyun.cn/modelSquare/4bd107bff85941239e27b1509eccfe98?regionId=200000001852

没有技术基础的普通用户,更推荐点这个链接来尝鲜:

https://huiju.ctyun.cn/h5-web/experienceCenterH5/?regionId=200000001852

5,华为云&硅基流动(推荐个人尝鲜)

2月1日,华为云宣布与硅基流动合作,上线了基于华为云昇腾云服务的DeepSeekR1/V3推理服务,包括满血版的R1。因为DeepSeek官方越来越不稳,有几天我一直在用这个硅基流动。

硅基流动比较推荐尝鲜用户使用,用户界面比较友好,但是可能因为访问量比较大,有时候也会报错,这是体验入口链接:

https://cloud.siliconflow.cn/i/qzjHLbGi

6,腾讯云(推荐个人尝鲜)

2月2日,腾讯云宣布DeepSeek-R1可一键部署至腾讯云高性能应用服务(HAI)上,开发者仅需3分钟就能接入调用。随后在2月4日,腾讯云宣布TI平台支持DeepSeek全系模型一键部署(包括满血版),部分模型还可限时免费体验。

腾讯云不仅上线了DeepSeek-R1和V3原版模型的API接口,还将它们接入了大模型知识引擎,并支持联网搜索,帮助用户快速开发出集智能问答+知识管理+实时搜索于一体的AI应用。

腾讯云上的DeepSeek入口还挺多的,个人用户推荐在腾讯云TI平台上体验,不仅免费,也有对小白友好的页面,响应速度还特别快。附链接:

https://console.cloud.tencent.com/tione/v2

7,阿里云(推荐个人尝鲜)

2月2日,阿里云宣布PAI Model Gallery支持云上一键部署DeepSeek-V3、DeepSeek-R1,既有蒸馏版的,也有满血版的。

在该平台上用户可以零代码实现从训练到部署再到推理的全过程,简化模型开发流程。

2月9日,阿里云一站式大模型应用开发平台百炼上线DeepSeek-V3、DeepSeek-R1、以及蒸馏模型。所有用户均可直接使用这些模型。其中,DeepSeek-V3和R1满血版各提供100万免费tokens。

除此之外,阿里云的无影云电脑支持让用户访问云上运行的个人电脑,这台电脑预安装了Ollama运行模型蒸馏模型,让Chatbox作为对话客户端。如果打开右侧的侧载栏,也可以用到满血版的R1。

阿里云主要面向企业用户,没想到对个人用户也友好度也较高,既可以用无影云电脑(新用户有免费使用额度),也可以在百炼里进行在线体现(暂未上线),也值得尝鲜使用。

PAI Model Gallery入口链接:

https://pai.console.aliyun.com/#/quick-start/models

阿里云百炼入口链接:

https://www.aliyun.com/product/bailian

无影云电脑入口链接

https://www.aliyun.com/product/ecs/gws

8,百度智能云(推荐个人尝鲜)

2月3日,百度智能云千帆平台上架 DeepSeek-R1和 DeepSeek-V3模型,平台上除了提供模型资源,还匹配了数据加工、模型精调、模型评估、模型量化等工具,支持模型的自定义导入等多种功能。

百度智能云既能部署模型,也提供了免费的体验入口,用户界面也比较友好,响应速度也挺快。推荐体验尝鲜:

https://console.bce.baidu.com/qianfan/ais/console/onlineTest/LLM

9,中国联通联通云

2月3日,联通云星罗先进算力调度平台支持A800/H800/L40S等主流算力卡,适配了多规格DeepSeek-R1模型。用户可按需灵活选择、快速扩展,快速搭建DeepSeek-R1推理和微调环境。

联通云官网没有DeepSeek的显眼入口,寻觅到AI算力平台后,发现需要创建资源才有后续,而且还暂不清楚是否可以部署满血版的,但肯定是需要付费才能体验的。附相关链接:

https://console.cucloud.cn/

10,京东云

2月4日,京东云宣布言犀AI开发计算平台已经支持 DeepSeek-V3、DeepSeek-R1 满血版以及所有蒸馏小参数模型(DeepSeek-R1-Distill)的一键部署。京东云言犀AI开发计算平台还支持私有化部署及API快速集成。

京东云上没有提供体验入口,需要先创建实例才能使用,适合想付费体验的用户。相关链接入口:

https://www.jdcloud.com/cn/products/yanxi-cap

11,火山引擎(推荐个人尝鲜)

2月4日,火山引擎宣布将支持V3/R1等不同尺寸的 DeepSeek 开源模型,包括满血版的R1。目前有两种方式使用:

一是在火山引擎机器学习平台 veMLP 中部署,适用于自己进行模型定制、部署、推理的企业。另一种是在火山方舟中调用模型,适用于期望通过 API 快速集成预训练模型的企业。

上图是火山方舟模型广场体验满血版的DeepSeek R1,这里的使用体验很好,非常适合没有技术基础的个人用户尝鲜体验。体验入口:

https://www.volcengine.com/

12,青云科技CoresHub(推荐个人尝鲜)

2月4日,青云旗下AI算力云服务——基石智算CoresHub 正式上线 DeepSeek-R1 系列模型,用户可直接调用 DeepSeek 系列模型,也可以通过 AI 算力云提供的 GPU 在云端部署推理服务,按需使用算力。

CoresHub陆续上线了DeepSeek-R1 的四款蒸馏模型,Janus-Pro-7B 文生图模型以及满血版的671B的DeepSeek-R1,同时提供5000 万 token 免费用。

新人注册认证可获得一定的免费体验额度,可通过配置Chatbox客户端,调用基石智算 DeepSeek-R1的API进行提问对话。体验链接:

https://console.coreshub.cn/xb3/maas/global-markets/

本地安装配置教程:

https://docs.coreshub.cn/console/big_model_server/call_scenario/chatbox/

13,中国移动的移动云

2月5日,移动云宣布支持DeepSeek V1/V2/V3/R1,实现了全版本覆盖。同时,它不仅支持官方发布的多个蒸馏模型,也支持满血版的671B模型。

用户可在线体验这些模型,然后选择和部署对应版本的模型,也支持API调用。此外,移动云也支持模型蒸馏,智能体编排等功能。

但是,移动云的大模型服务平台仅对线下客户开放,线上用户暂时无法使用。所以,不推荐个人体验。相关链接:

https://ecloud.10086.cn/portal

14,无问芯穹

无问芯穹是最近刚发现的一家公司,旗下的智算云平台是核心产品之一,主要面向企业和开发者提供从算力、模型到应用的一站式服务。

无问芯穹提供了多个版本的DeepSeek,包括一个满血版的R1,此外还有通义千问和Llama等常见的模型。

可能是因为用户太多了,使用的时候也会遇到输出缓慢,还有限流的情况。个人用户也可以酌情考虑尝试一下:

https://cloud.infini-ai.com/genstudio/experience

15,并行科技

2月6日,并行科技宣布智算云平台(ai.paratera.com)已部署DeepSeek模型,开箱即用,支持多种产品形态,用户可选择以容器或者云主机的方式来进行体验。随后,又上线了满血版的DeepSeek R1。

值得注意的是,这里使用的GPU都是消费级的显卡,所以,每台主机每小时的费用并不高。还可以帮用户测试一下这个级别的显卡推理DeepSeek的效果。对于还是想本地部署蒸馏模型的小伙伴,也有参考价值。

https://ai.paratera.com/#/container/instance/add

16,中国电子云

2月7日,中国电子云CECSTACK智算云平台正式上线MoE架构的671B全量DeepSeek-R1/V3模型,以及DeepSeek-R1的蒸馏系列Qwen/Llama模型,并提供私有化部署方案。

中国电子云的人工智能算力平台支持DeepSeek系列大模型在昇腾、天数、沐曦及英伟达等算力平台的部署和使用。此外,中国电子云还提供大模型训练开发能力、大模型推理API服务以及大模型应用开发服务。

不过,中国电子云平台不支持用户自主注册,所以,个人用户使用起来会相对困难一点。相关链接:

https://www.cecloud.com/

17,国家超算互联网

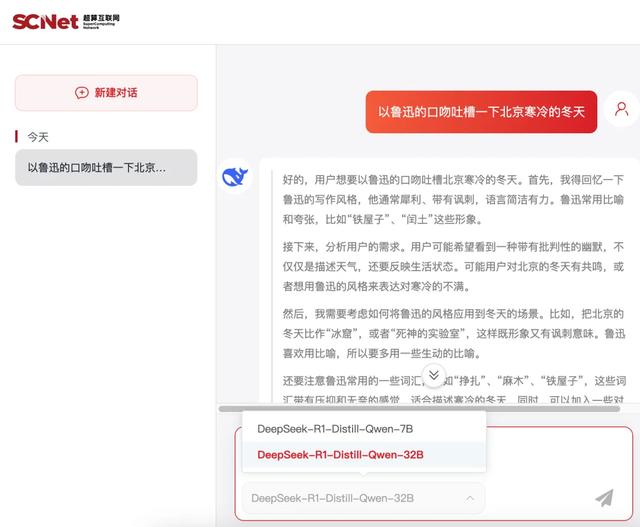

2月3日,国家超算互联网宣布上线DeepSeek-R1模型的蒸馏版,而后又于2月9日上线了满血版的R1,该平台还提供快速部署API调用及AI web应用服务。

除了付费创建资源部署以外,这里还提供了在线的免费体验服务。但美中不足的是,目前只提供最大32B的版本,虽然这比7B要强很多,但如果有满血版的还是用满血的比较好。相关链接:

https://chat.scnet.cn/

18,UCloud

2月3日,UCloud优刻得的算力共享平台优云智算先后上架了多个版本的DeepSeek模型。2月10日,UCloud优刻得模型服务平台UModelVerse上架DeepSeek-R1、DeepSeek-V3满血版模型。

DeepSeek满血版部署在UCloud智算中心中,并以API的调用方式对外提供服务,且支持海外地域访问。并且,还宣布了限时免费调用活动,用户在后台申请即可。相关链接:

https://console.ucloud.cn/modelverse/model-center

写在最后:

此外,除了用这些云厂商的服务,现在其实也可以用一些嵌入了DeepSeek的第三方服务,比如:

Perplexity(需要配置网络环境)、秘塔搜索、Cursor(是代码神器,也可以当聊天工具)、纳米搜索、Windsurf(是代码神器,也可以当聊天工具)。

以上就是我所知道的,关于如何普通个人如何使用DeepSeek R1的几种渠道。

最后劝一句,千万别为了本地部署DeepSeek R1去买高端显卡部署蒸馏模型,想要愉快地聊天,只能用在线的671B满血版。