今天,阿里巴巴的 Qwen 团队发布了其最新的推理模型 QwQ-32B-Preview。该模型拥有 325 亿参数,并能处理约 32,000 个 Token 的提示词。值得注意的是,它是首个可以在宽松许可下下载使用的模型。

试用链接:https://huggingface.co/spaces/Qwen/QwQ-32B-preview

根据官网介绍,QwQ-32B-Preview 是为数不多的可以与 OpenAI 的 o1 相媲美的模型之一。比如,在 AIME 和 MATH-500 测试中,QwQ-32B-Preview 的表现要好于 OpenAI 迄今为止发布的两个推理模型 o1-preview 与 o1-mini。AIME 涵盖算术、代数、计数、几何、数论、概率等中学数学主题的综合评测,旨在测试数学问题解决能力,而 MATH 是一个专门设计来评估 LLM 在数学问题解决能力上的测试集。

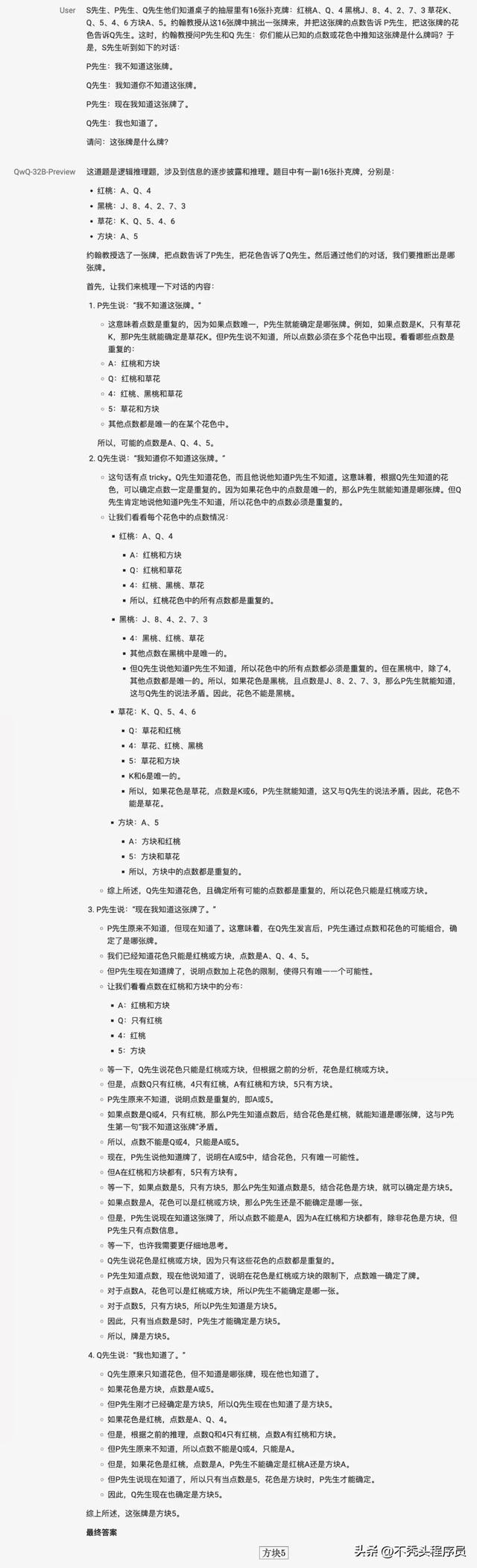

官方博客给出的这个例子能很好表现 QwQ 深度自省的能力 —— 质疑自身假设、进行深思熟虑的自我对话,并仔细审视其推理过程的每一步。

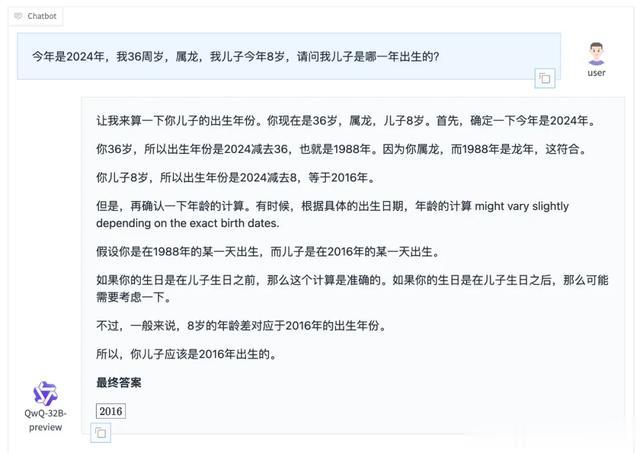

QwQ-32B-Preview 能够有效地进行自我核查,这么做可以帮助它们避免一些通常困扰模型的常见陷阱,但也会导致它们通常需要更长时间才能得出解决方案。

当然 QwQ-32B-Preview 还有其他局限性,比如:

模型可能在回答中混合使用不同语言,影响表达的连贯性在处理复杂逻辑问题时,模型偶尔会陷入递归推理模式,在相似思路中循环,但可能导致冗长而不够聚焦的回答与其他大模型一样,它可能产生不恰当或存在偏见的回答QwQ-32B-Preview 虽然在数学和编程领域表现出色,但在其他方面仍有不足我试用了一次,确实出现了混合使用不同语言问题,并且我的问题设置了两个干扰条件,导致给出的回答略显冗长。

QwQ-32B-Preview 在 Apache 2.0 许可证下 “公开” 可用,这意味着它可以被用于商业应用。但是目前该模型仅发布了部分组件,因此无法完全复制 QwQ-32B-Preview 或深入了解系统的内部工作原理。AI 模型的 “开放性” 问题尚未有定论,但普遍存在从较封闭(仅提供 API 访问)到较开放(公开模型、权重、数据)之间的渐进式区分,QwQ-32B-Preview 处于两者之间。

现在正值 Scaling Laws 这一之前曾为大规模模型的开发指明了方向的法则被质疑时期,最近的多篇报道表明,包括 OpenAI、谷歌和 Anthropic 在内的主要人工智能实验室,模型的进展已不像过去那样快。

这促进了对新型人工智能方法、架构和开发技术的探索,其中之一就是测试时计算(test-time compute)。测试时计算,也被称为推理计算,实质上是给模型额外的处理时间以完成任务,这应该是 o1 或者 QwQ-32B-Preview 这样的模型的核心技术之一。

除了 OpenAI 和阿里巴巴外,其他很多大模型实验室也认为测试时计算是未来趋势,例如谷歌,他们已经将专注于推理模型的内部团队扩展至大约 200 人,并为此投入了大量的计算资源。