尽管像ChatGPT这样的大型语言模型取得了显著的成功,但支持这些系统的人工神经网络(ANN)可能存在问题。

首先,人工神经网络非常耗电。其次,它们缺乏透明度,意味着这些系统如此复杂,以至于我们无法真正理解它们是如何工作的,以及为什么它们能如此有效地工作。这种复杂性使得人工神经网络很难通过类比进行推理,而类比推理正是人类的一种思考方式——用符号表示对象、概念及其之间的关系。这表明,当前的人工神经网络可能需要在某些方面进行改进,以解决这些问题。

人工神经网络的不足之处可能主要源于它们的基本结构和构建模块:单个人工神经元(individual artificial neurons)。每个神经元负责接收输入、执行计算并产生输出。现代的ANN是由这些计算单元构成的复杂数字网络,经过训练后可以完成特定任务。

然而,ANN的局限性很明显。举例来说,考虑一个用于区分圆形和正方形的ANN。一种实现方式是在输出层使用两个神经元,一个表示圆形,另一个表示正方形。如果你还希望这个ANN能识别形状的颜色(蓝色或红色),则需要四个输出神经元:分别表示蓝色圆形、蓝色正方形、红色圆形和红色正方形。随着需要识别的特征数量增加,所需的神经元数量也会相应增加。这意味着现有的ANN结构在处理更多特征时可能会变得更加复杂和低效。

我们的大脑感知自然世界的方式不可能是通过单个神经元来表示不同的信息。例如,我们不会在大脑中有一个专门用来检测紫色大众汽车的神经元。相反,大脑中的信息是由许多神经元的活动共同表示的。这意味着,感知紫色大众汽车的概念不是由一个神经元的活动来表示的,而是由成千上万个神经元的活动共同表示的。当这些神经元以不同的方式激活时,它们可以表示完全不同的概念,例如粉红色的凯迪拉克汽车。这种观点强调了大脑对信息编码的复杂性和多样性。

这是一种高维计算(hyperdimensional computing)。在这种方法中,每个信息片段(例如汽车的概念、品牌、型号或颜色等)都被表示为一个单一实体:高维向量(hyperdimensional vector)。

向量是一个有序的数字数组。以三维向量为例,它包含三个数字:三维空间中一个点的x、y和z坐标。高维向量(也称为超向量)可以是包含10,000个数字的数组,表示在10,000维空间中的一个点。这种方法涉及的数学对象和代数操作非常灵活和强大,有助于现代计算突破当前的局限,并推动一种新的人工智能方法的发展。

这预示着一个全新的计算世界。在这个世界里,计算过程将变得更加高效和稳定,同时,机器所做的决策过程将是完全透明的,使人们能够更好地理解和控制这些决策。

进入高维空间为了理解超向量如何实现计算,让我们回到红圆和蓝方形的图像。了表示变量(如形状和颜色)以及它们可能的值(如圆形、正方形、蓝色和红色),我们需要不同的向量。向量之间的独特性可以通过正交性(即相互垂直)来量化。在三维空间中,有三个相互正交的向量;而在10,000维空间中,有10,000个这样的向量。

然而,如果允许向量近似正交,那么高维空间中这种不同向量的数量会大幅增加。在一个10,000维空间中,有数百万个近似正交的向量。这意味着在高维空间中,有大量的向量可以用来表示不同的信息,从而为高维计算提供了基础。

现在,让我们创建独特的向量来表示形状(SHAPE)、颜色(COLOR)、圆形(CIRCLE)、正方形(SQUARE)、蓝色(BLUE)和红色(RED)。在高维空间中有很多可能的近似正交向量,因此你可以为这六个属性分配六个随机向量,它们几乎可以保证是近似正交的。这里的“近似正交”意味着这些向量之间的关系非常接近于正交(即相互垂直)。

在2009年的一篇具有影响力的论文中,加州大学伯克利分校红木理论神经科学中心的研究员Pentti Kanerva指出,制作近似正交向量的容易性是使用高维表示法的主要原因。这是因为在高维空间中,可以轻松地生成大量几乎正交的向量来表示不同的属性,例如形状和颜色。

这篇论文是基于20世纪90年代中期Pentti Kanerva和Tony Plate的工作。他们独立地开发了处理超向量(高维向量)的代数,并暗示了这种方法在高维计算中的潜在应用。给定形状和颜色的超向量,Kanerva 和 Plate 的系统向我们展示了如何使用特定的数学运算来操作这些向量。这些数学运算对应于用符号处理概念的方法。这意味着我们可以用这些数学运算来处理和操作不同概念,从而在计算中实现更高效、更透明的处理方式。

第一个操作是乘法,它是一种将概念组合在一起的方法。例如,将向量 SHAPE(形状)与向量 CIRCLE(圆形)相乘,将两者结合成表示“形状是圆形”的概念。这个新的“绑定”向量与 SHAPE 和 CIRCLE 都近乎正交。这里所说的“绑定”向量是指将两个向量(在这个例子中是形状和圆)通过某种操作(如乘法)组合在一起的结果。这个新的绑定向量与原始的 SHAPE 和 CIRCLE 向量近乎正交,这意味着它们之间的关系非常微弱,几乎独立。

绑定向量中的单个元素(形状或圆)可以恢复,这意味着你可以从绑定向量中提取原始的信息。从绑定向量中获取有关信息时非常重要。例如,在这个情景中,给定一个表示大众汽车的绑定向量,你可以对其进行解绑操作,从中检索到表示颜色的向量,即紫色。这使得你能够从组合的概念中提取和了解其各个组成部分。

第二个操作是加法,它用于创建一个表示概念叠加的新向量。例如,你可以将两个绑定向量,“形状是圆形”和“颜色是红色”,相加以创建一个表示红色圆形的向量。同样,叠加后的向量可以分解成其组成部分。这意味着,通过这种方法,你可以将不同的概念组合在一起,并在需要时将它们拆分开。

第三种操作是置换,它包括重新排列向量的各个元素。例如,如果你有一个三维向量,其值标为x、y和z,置换可能会将x的值移到y,y的值移到z,z的值移到x。Kanerva表示,置换允许构建结构并处理按顺序发生的事物。

考虑用超向量A和B表示的两个事件。我们可以将它们叠加成一个向量,但这会破坏关于事件顺序的信息。将加法与置换相结合可以保留顺序信息,然后通过逆转操作按顺序检索事件。

这三个操作共同构成了一种超向量的形式代数,允许进行符号推理。但是,包括Olshausen在内的许多研究人员对高维计算的潜力理解得很慢。他说:“它就是没法让人理解。”

高维计算的力量

在2018年,Olshausen的一名学生Eric Weiss展示了高维计算的一种独特能力。Weiss找到了一种方法,可以将一个复杂图像表示为一个单独的高维向量,该向量包含了图像中所有对象的信息,包括它们的属性,如颜色、位置和尺寸。

随后,更多的研究团队开始开发高维算法,以复制深度神经网络在大约20年前开始处理的一些简单任务,例如对图像进行分类。这意味着高维计算逐渐成为一个研究领域,并在处理某些任务时展现出潜力。

例如,考虑如何使用高维计算来识别手写数字。首先,算法从带有标签的手写数字图像数据集中提取特征,并为每个图像创建一个高维向量(超向量)。接着,它将所有表示 0 的图像的超向量相加,形成一个代表 0 概念的超向量。同样的方法应用于其他数字,最终创建了 10 个类别超向量,每个数字对应一个。

当给定一个未标记的图像时,算法会为这个新图像创建一个超向量,并将其与存储的类别超向量进行比较。这种比较可以确定新图像最接近哪个数字,从而实现手写数字识别。

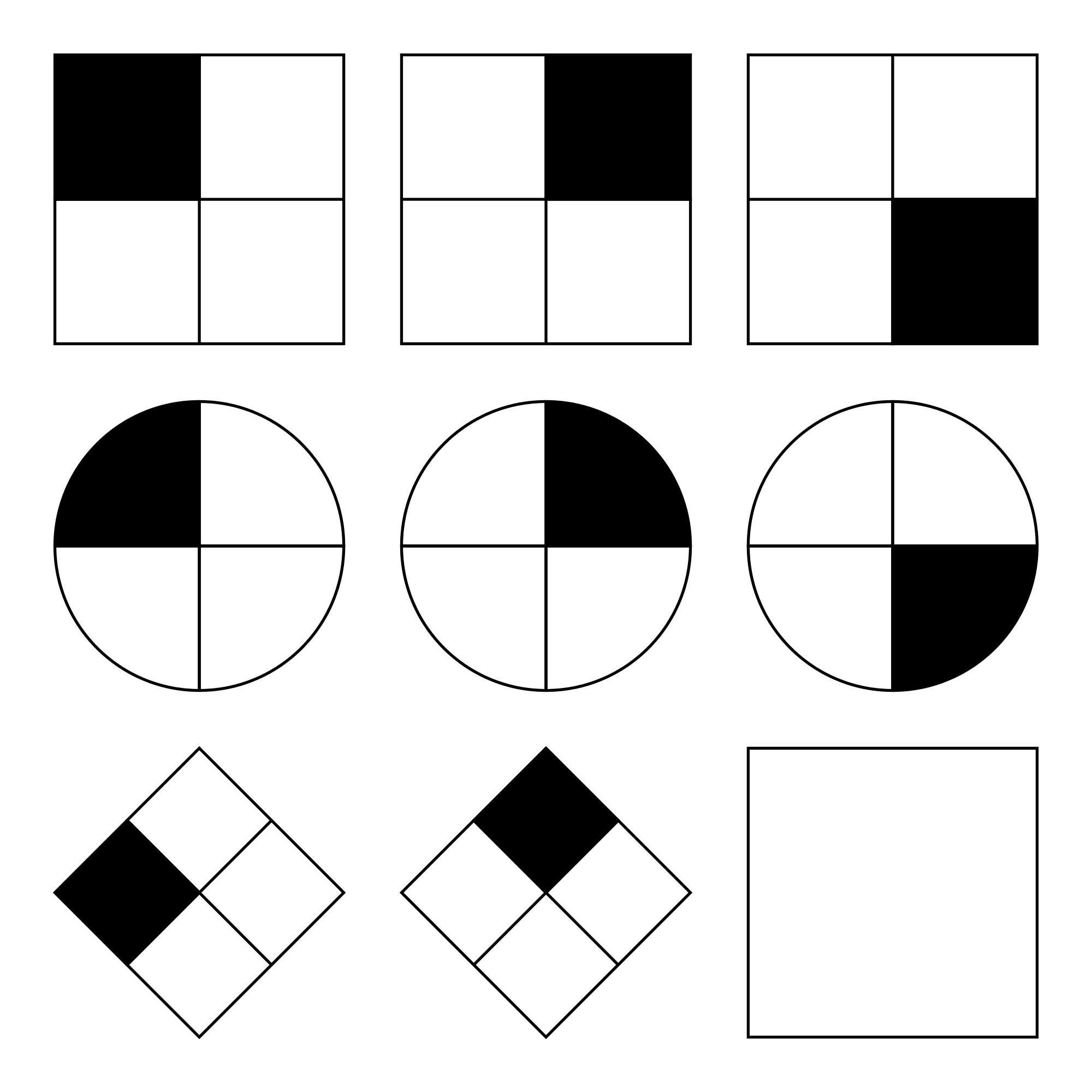

高维计算的优势在于能够通过组合和分解高维向量进行推理。最近的一个例子是2022年3月,IBM苏黎世研究中心的Abbas Rahimi及其同事成功利用高维计算与神经网络解决了抽象视觉推理领域的一个经典问题。这个问题对于普通的人工神经网络,甚至对某些人来说都是一个极具挑战性的问题。这个问题被称为渐进矩阵测试(Raven's Progressive Matrices),其任务是在一个3×3的网格中展示一系列几何图形图像。网格中有一个空白位置。参与者需要从一组候选图像中选择一个最适合填入空白位置的图像。

为了使用高维计算解决这个问题,该团队首先创建了一个高维向量字典,用以表示每个图像中的对象以及与这些对象相关的属性组合。然后,他们训练了一个神经网络,使其能够检查图像并生成一个双极高维向量(元素可以是+1或-1),这个向量尽可能地接近字典中高维向量的某种叠加。这样一来,生成的高维向量就包含了图像中所有对象及其属性的信息。通过这种方法,研究者们引导神经网络进入一个有意义的概念空间,从而使其能够理解和处理图像中的对象和属性。

当网络为每个上下文图像和每个候选空白位图像生成高维向量后,另一个算法分析这些高维向量,为每个图像中的对象数量、大小和其他特征创建概率分布。这些概率分布揭示了上下文和候选图像的可能特征,可以将其转换为高维向量,从而利用代数预测填补空白位的最可能候选图像。

他们的方法在一组问题上的准确率接近88%,而仅使用神经网络的解决方案准确率不足61%。这意味着他们的方法比仅依赖神经网络的方法更准确。另外,该团队还证明了对于3x3网格,他们的系统比使用符号逻辑规则进行推理的传统方法快了近250倍。这是因为传统方法在进行推理时,需要在庞大的规则库中搜索以确定正确的下一步,而他们的系统无需这样做,从而大大提高了计算速度。

一个有前景的开端高维计算不仅让我们能够符号化地解决问题,还解决了传统计算的一些棘手问题。当今计算机的性能在遇到随机比特翻转(例如,0变成1)等错误时,如果内置的纠错机制无法纠正这些错误,性能会迅速下降。此外,这些纠错机制可能会给性能带来高达25%的损失。

与传统计算相比,高维计算在面对错误时更有容错能力。即使高维向量遭受大量随机比特翻转,它仍然接近原始向量。因此,在出现错误时,使用这些向量进行的推理不会受到太大影响。已经证明,这些系统至少比传统人工神经网络具有10倍的硬件容错能力,而传统人工神经网络本身已经比传统计算架构具有更高的弹性。这意味着可以利用这种弹性来设计更高效的硬件。

高维计算的另一个优点是透明性:代数能清晰地解释系统为什么会选择某个答案。然而,传统的神经网络并没有这个特点。Olshausen、Rahimi等人正在开发一种混合系统,该系统中神经网络将物理世界中的事物映射到高维向量,接着高维代数就会接管处理。Olshausen表示,这种方式使得诸如类比推理这类问题变得容易解决。他认为,我们对任何AI系统的期望应该是能够像理解飞机或电视机一样去理解它。

所有这些优势都表明高维计算非常适合新一代极其稳固、低功耗的硬件。高维计算还与“内存计算系统”兼容,这种系统在存储数据的硬件上执行计算,而不是像现有的冯·诺伊曼计算机那样在内存和中央处理器之间低效地传输数据。

这些新设备中的一些是模拟设备,它们在非常低的电压下运行,这使得它们能效高,但也容易受到随机噪声的影响。在冯·诺伊曼计算中,这种随机性是一个难以克服的障碍。然而,高维计算可以克服这个障碍,突破这个限制。

尽管高维计算具有许多优势,如透明性、错误容忍性和适应性,但它仍处于初级阶段。现在,研究人员需要针对实际问题和更大规模的场景对其进行测试,以使其更接近现代神经网络的规模。面对大规模问题,高维计算需要非常高效的硬件。随着时间的推移,高维计算领域有望解决这些问题并揭示更多高维空间的秘密。目前,这只是使用向量计算的起点。