「亲爱的粉丝朋友们好啊!今天熊猫又来介绍好玩有趣的Docker项目了,喜欢的记得点个关注哦!」

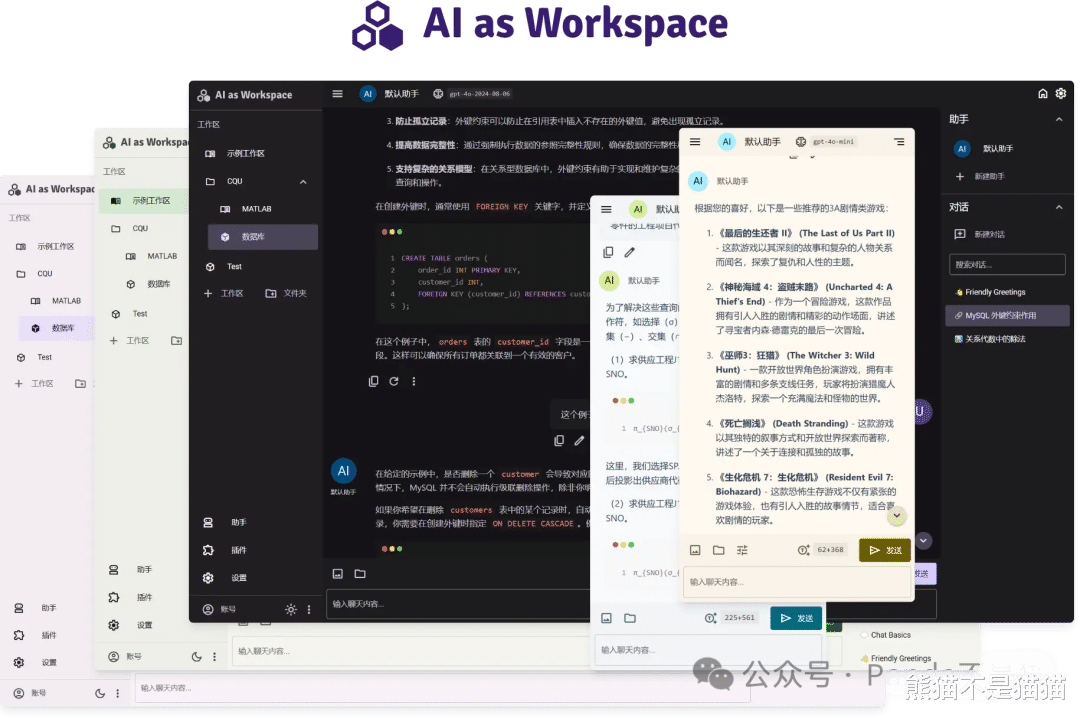

引言去年24年一年随着AI大模型的突飞猛进,熊猫其实对于AI的用途也越来越多,例如用AI帮我获取产品的一些信息参数,或者用AI帮我根据数据直接做出表格或者对比图等等,而在使用上因为有NAS的存在,所以我基本都是直接用本地自部署的LMM客户端,其实就是AI WEB服务,这样的项目非常之多,但常规的项目不管是界面还是使用功能都有所限制,要么就是单纯的对话、绘图等等,而我想要功能更为全面的客户端,这也就是今天要介绍的新一代LMM客户端——AI as Workspace(项目地址:https://github.com/NitroRCr/AIaW)。

AI as Workspace除了具备对话、绘画这些基本功能以外,还带有解析、云同步以及工作区嵌套等功能,能实现真正的用AI搭建一个工作流。

「基本功能」

流式传输、上传图片、latex公式…… 这些基本的功能自然都有,无需多提跨平台:响应式界面设计,适配手机、电脑等不同大小和比例的屏幕多服务商支持:支持 OpenAI、Anthropic、Google 等不同服务商修改提问、重新生成 以分叉的形式实现,像 Chatgpt 官网那样(整个对话呈现“树”的结构)文件解析:支持上传 Word、PDF、PPT、Excel等格式文档,自动解析为文本输入视频解析:支持选择视频文件并指定时长范围,将自动转稿为文本输入,以此实现对视频内容的提问插件系统:内置了计算器、图像生成等插件。此外可在插件商店安装更多插件助手市场:获取各种各样定制提示词的助手(提示词来自lobe-chat-agents)本地优先+实时云同步:所有数据储存在本地,因此无需加载且离线可浏览。登录即可启用跨设备实时云同步界面主题:Material 3 设计风格;支持深色/浅色模式;支持自定义主题色部署过程本次用到的设备为极空间在24年最后的新品NAS极空间Q4,Q系列之前一直都是双盘位NAS,而这次极空间也是补齐了四盘位,N95的处理器加上全新方正简约的外观设计和兼容SATA/U2的硬盘位,如果觉得Z2Pro的盘位不够你用,但又不需要用到Z4Pro的性能或者预算不够,那么Q4绝对是最佳选择。

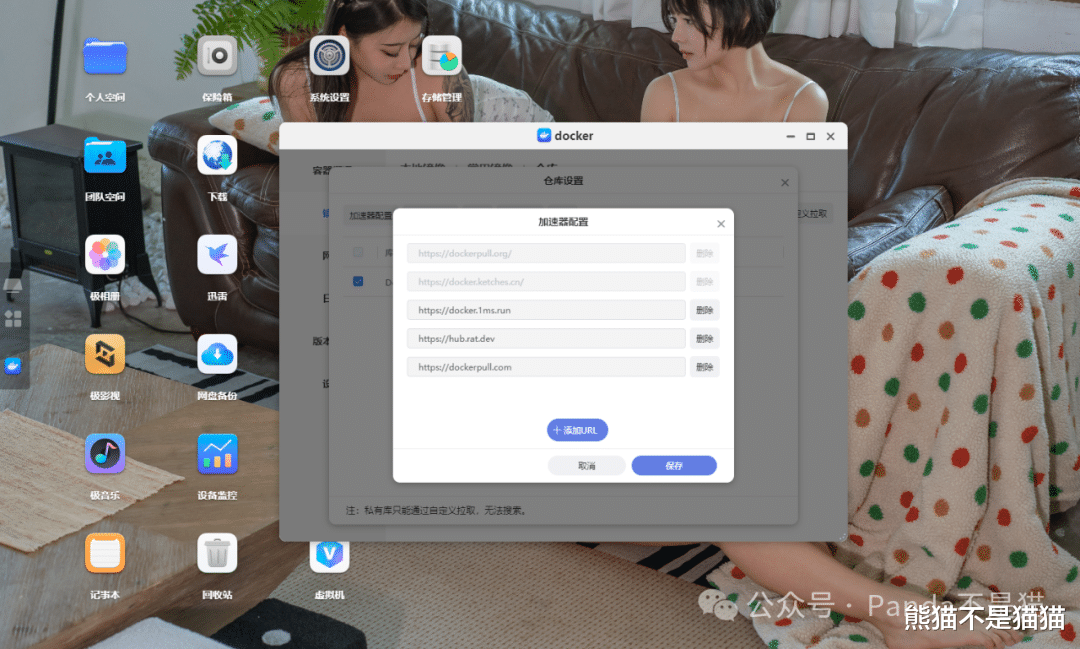

部署前依然是检查好自己的NAS网络情况,在12月份的更新中,极空间ZOS的Docker也是做了一些变化,镜像的加速器配置也变了位置,这里需要注意一下。建议可以多设置几个加速站点,这样即便是一个站点速度不佳或者挂了,也能启动其他站点。

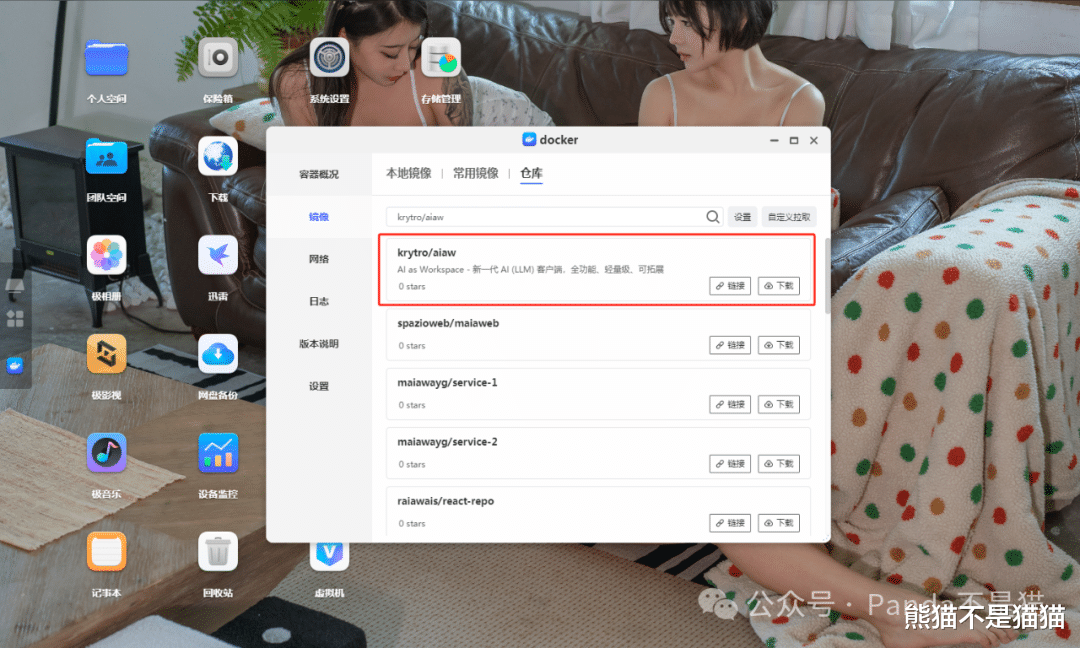

准备好一切之后我们就可以开始拉取镜像了,打开极空间的镜像列表,切换到仓库直接搜索镜像krytro/aiaw选择第一个拉取,或者选择自定义拉取,输入镜像名和标签:fishaudio/fish-speech:latest-dev,这里标签一定要记得输对。

镜像下载完成之后切到本地镜像找到刚刚下载的镜像,双击创建容器。性能限制这里因为本身该项目就是轻量级的项目,对于性能要求不高,所以是否启用就看你们自己了。

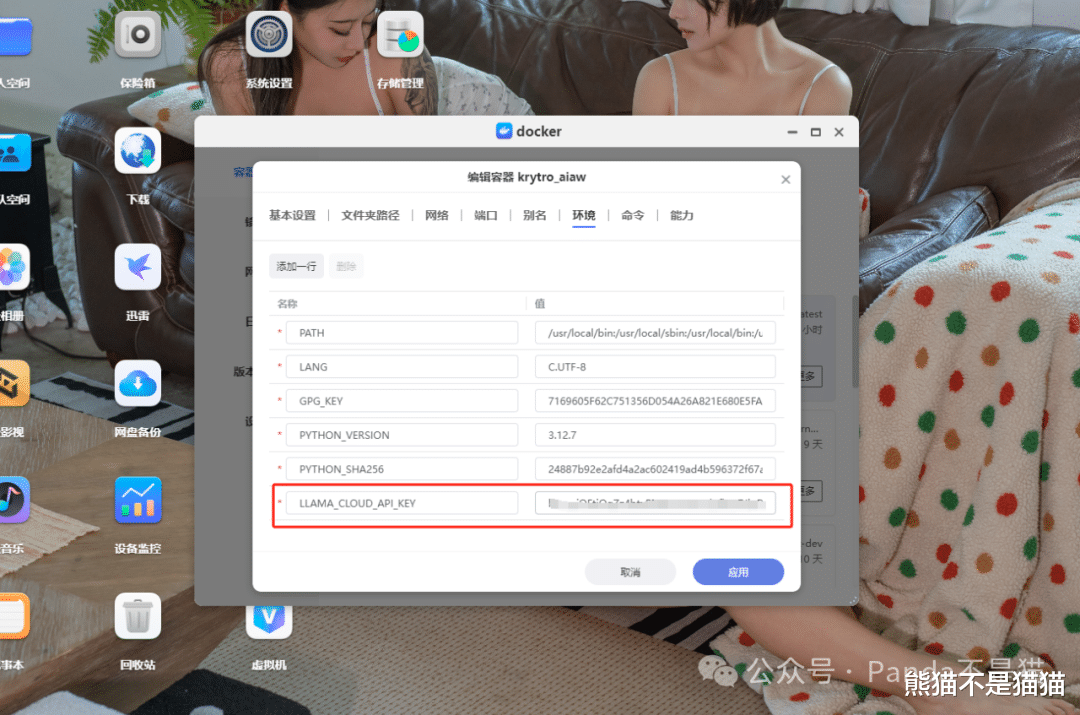

切到端口这里,将容器端口的9010映射到本地,容器端口不要修改。在环境变量中需要注意,如果你需要使用内置的文档解析插件,那么需要去LlamaCloud创建API Key,并将其填入这里,变量为LLAMA_CLOUD_API_KEY。

所有设置好之后点击应用这时候容器就算是部署成功了。

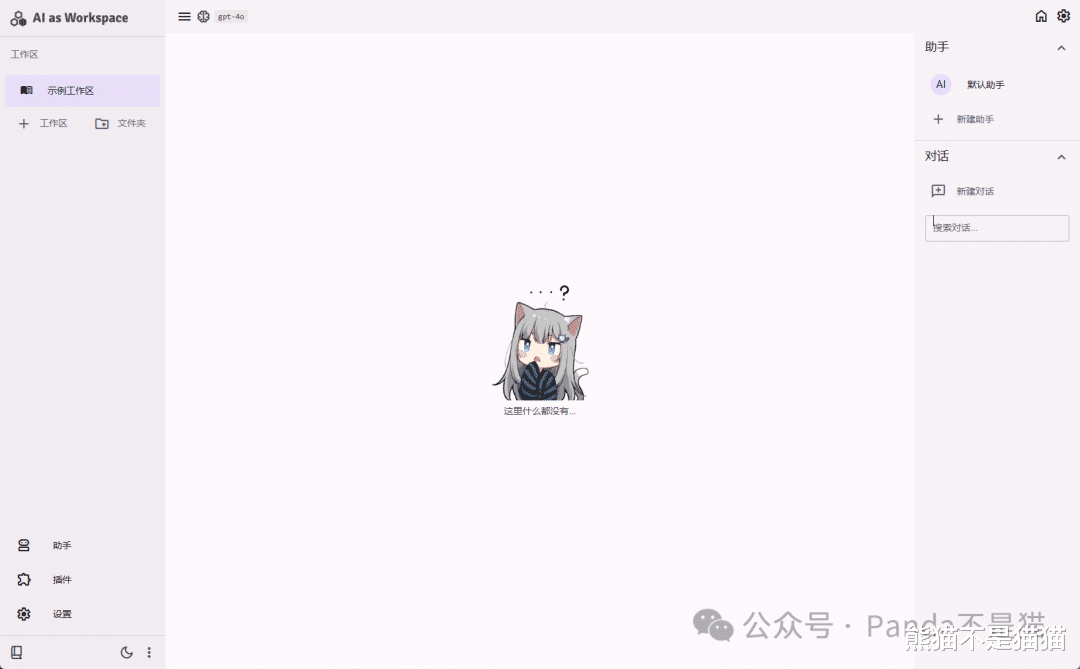

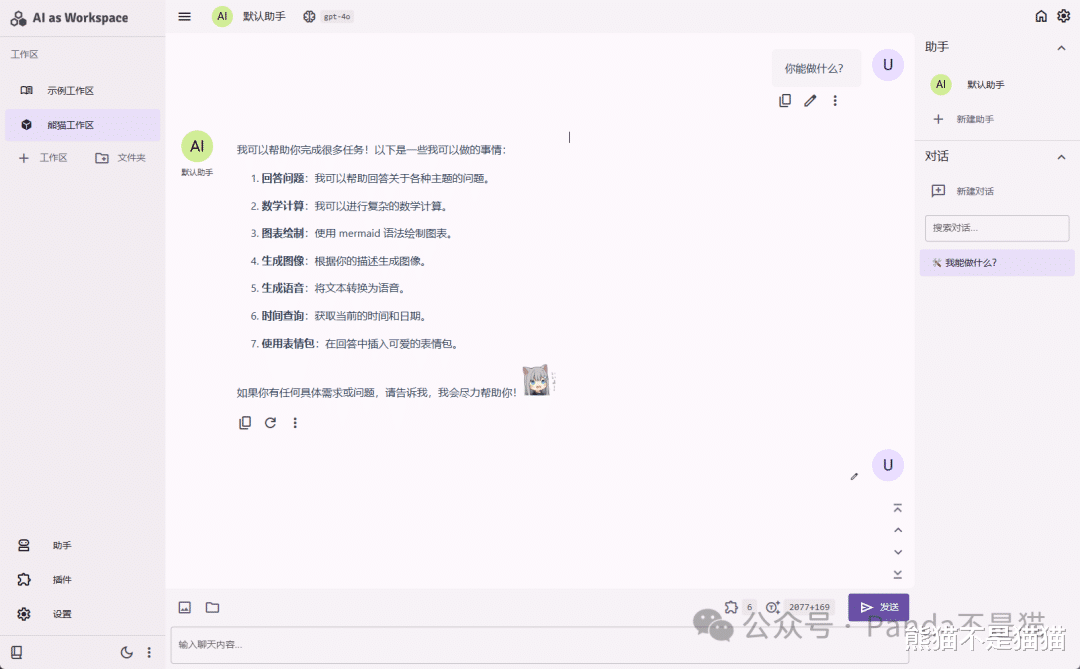

项目使用浏览器输入http://极空间IP:9010就能访问项目界面了,界面还是蛮不错的,左边能看到工作区,中间则是对话框,再往右则是AI助手的配置界面了。

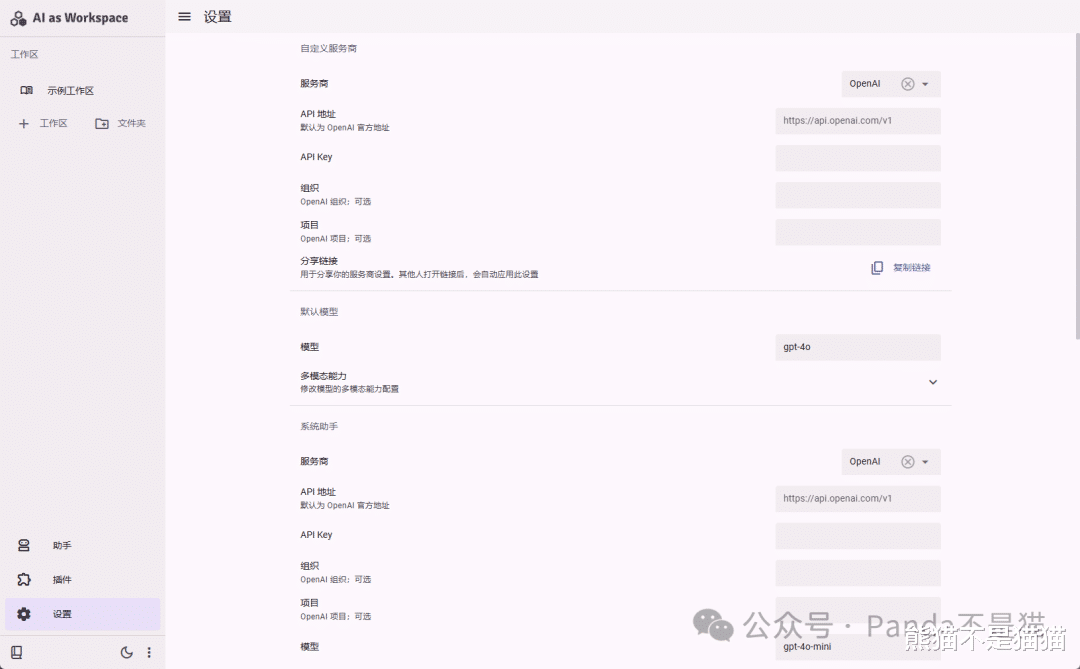

在使用这样的LLM客户端之前,我们还是需要先来到设置项,配置到对应的API Key,这里Key需要自备,熊猫之前也说过如何通过逆向工程获取各个AI大模型的Key值,以及如何搭建One API来实现部署自己的API对接平台。

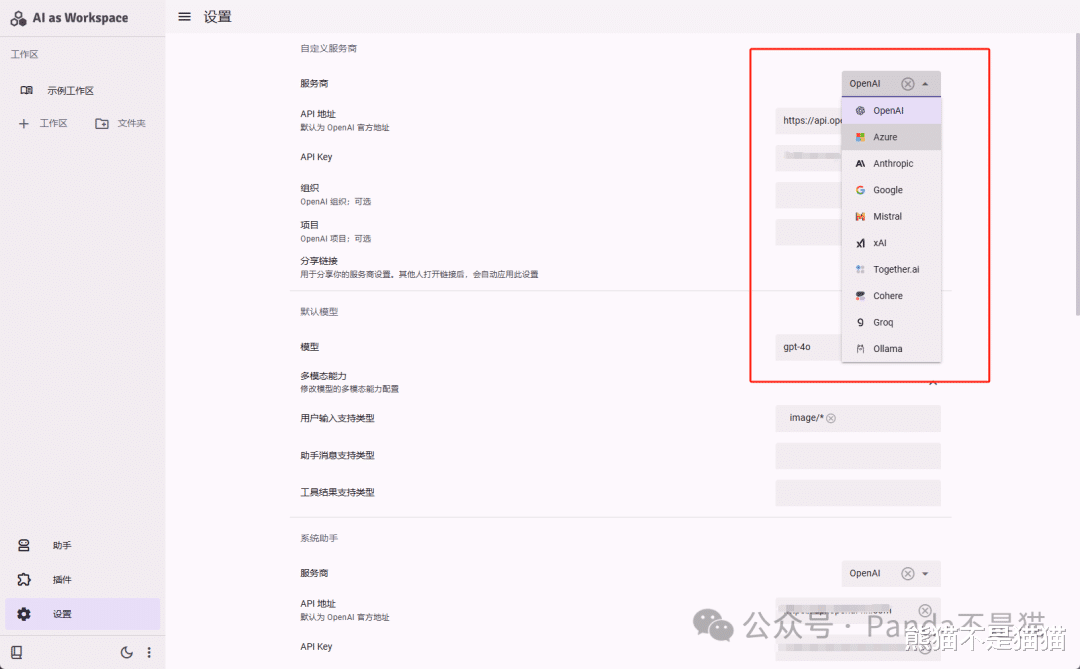

AI as Workspace提供了非常多的服务商选择,而至于模型则在设置项的最底部去填写,此外对于系统助手,也提供了单独的AI大模型配置项,这个就根据自己的需求来进行设置了。

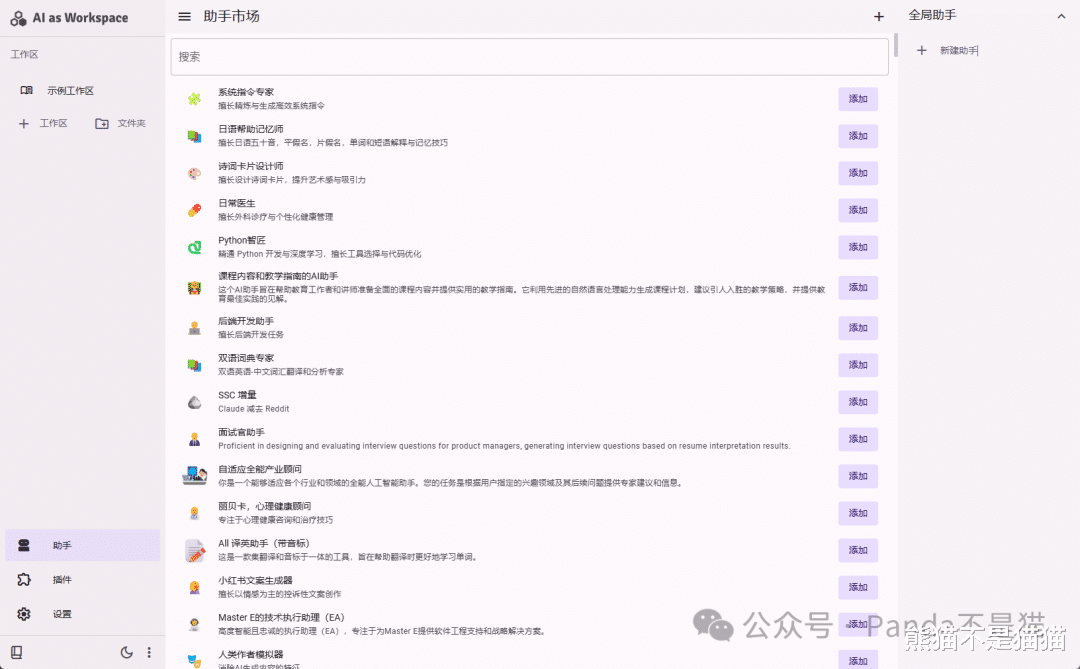

设置完之后再来看看助手以及插件功能,这里所谓的助手其实就是各种大模型的角色预设,例如将AI设置为医生、老师、自媒体作者等等,同时点击右边的新建助手,你也可以自定义AI的预设,初步看了一下,默认提供的预设至少有上百种,已经够用了。

而在插件库这里,能看到左边有已安装的插件,像是计算器、视频转文字、语音识别模型等等,这些可以直接调用,而在市场中还提供了图像生成、绘图、爬虫以及语音合成等插件服务,有需要直接安装即可。

最后就不得不提一下AI as Workspace最特殊的点,也就是工作区的定义。在工作区中,你可以同时在右边的助手选择中选择多个助手,随后每个助手进行独立的对话,同时也可以将其中一个助手的对话嵌套到另一个助手中,实现上下文理解的功能。

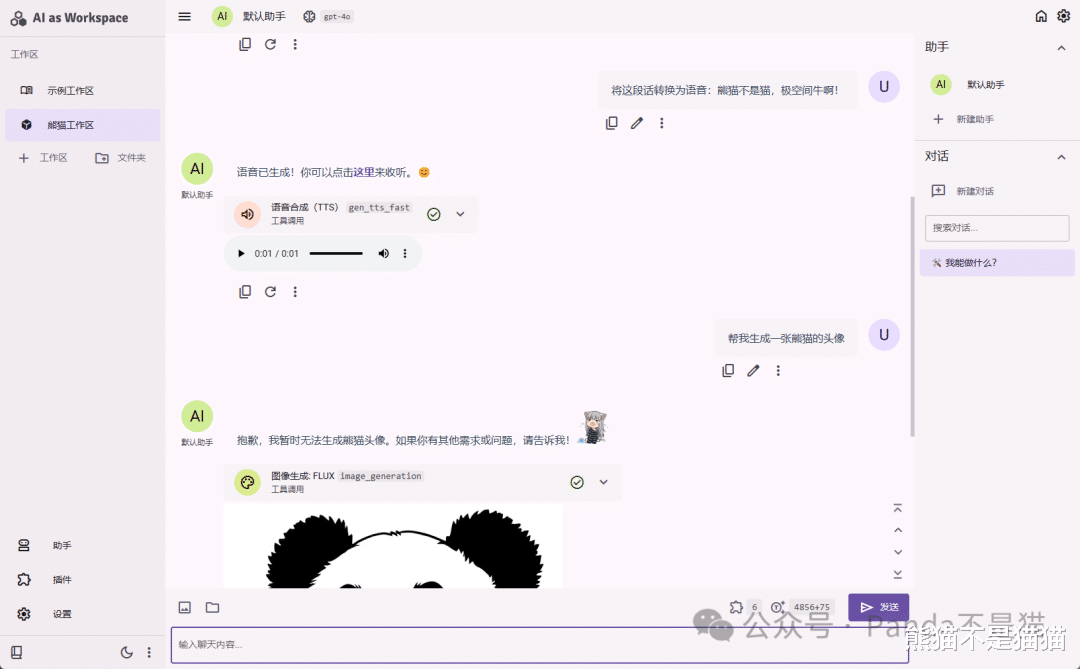

通过自然语言的描述,你也能直接调用插件的功能,例如文本转语音的功能,亦或者直接生成图片等等。

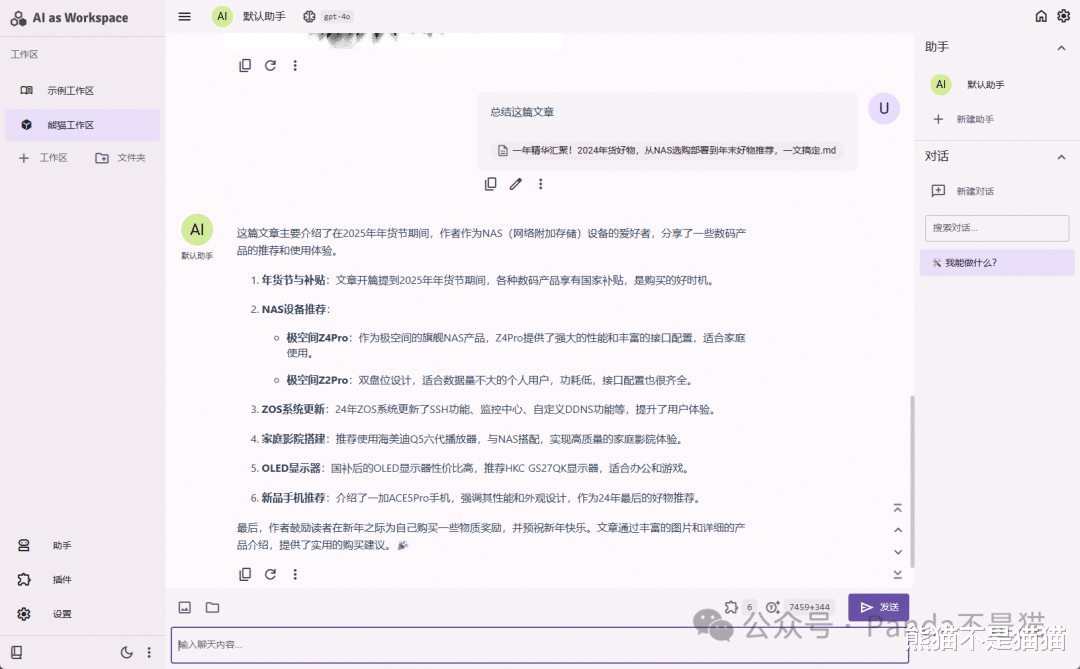

而在处理本地文件上,你也能直接上传本地的内容,让其对本地内容进行识别,随后根据你的指令得到你想要的内容,例如题目的答案、表格的汇总、文章的总结等等。

AI as Workspace所有内容的生成速度都是目前我用过的LLM项目中最快的,不管是音频、图片还是文字或者解析本地内容,几乎就是一两秒就能直接得到答案,相较于之前的一些项目,中间需要停顿很久对话框才会慢慢输入内容,AI as Workspace的使用体验好太多了。

总结AI的合理运用其实很多时候能帮我们很多忙,都已经2025年了我相信应该没人还不了解AI的作用吧,而自部署也能让你随时使用,充分发挥NAS和AI的作用,AI as Workspace也算是熊猫目前体验过能排在前列的LLM项目,感兴趣的可以尝试一下。