几个月前,豆包大模型团队悄然推出了Seedream2.0,在最新的豆包和即梦中已经可以用上这款兼具中英双语理解与精准文字渲染的图像生成模型。今天,这款产品的技术细节终于在arXiv上正式公开,为业内人士和爱好者揭示了其背后的技术秘密。

相比起Midjourney等主流模型,Seedream2.0最大的优势在于双语解析与文字渲染,即可以直接使用中文提示词进行渲染,也可以直接输出汉字和英语等。下表是针对几个主流文生图模型的测试,可以看Seedream 2.0在多个维度上优于当前最先进的文生图模型,涵盖人类和自动化评估。它在中英文提示下均取得优异成果,尤其在中文文化细节和文本渲染方面表现卓越。

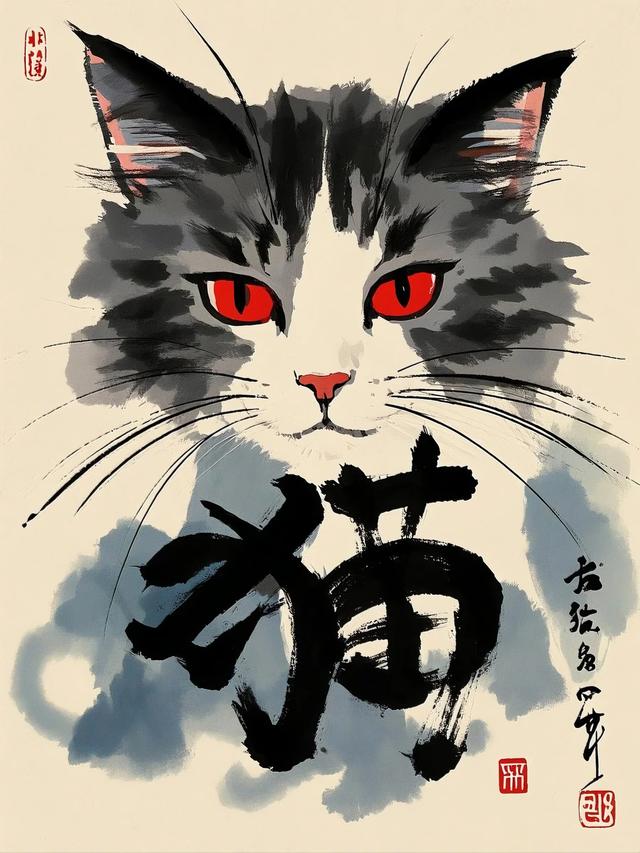

我们来看几个例子

以上这张照片使用了以下中文Prompt:摄影,特写,一只橙色虎斑猫,猫咪抬起前爪,眼神好奇,仿佛正准备行动。背景是蓝天白云与耀眼阳光,前景是绿色草地, 太阳逆光效果, 高对比度, 超写实风格, 自然摄影, 景深效果, 背景轻微动态模糊。

我们可以看到Seedream2.0对于提示词的理解是非常到位的,肢体动作、神态都完全符合描述,毛发、草地、太阳等这些细节都处理得很好,整体看起来比较自然。唯一露馅的可能就是天空中云朵缺少景深。

以上为使用Seedream2.0渲染的汉字“猫”,并且加上了毛笔字的效果,虽说在起笔、收笔和连笔上不太符合书写逻辑,但起码看得出是一个“猫”字,国风水墨画的氛围感是给足了。

为了实现如此出色的图片渲染效果,Seedream 2.0模型在训练和推理过程中,采用了扩散式Transformer架构(Diffusion Transformer)。每个Transformer模块包含一个自注意力层,能够同时处理图像和文本信息。

针对图像和文本的不同特性,模型使用了不同的多层感知机(MLP)进行处理,并通过自适应层归一化来调节每个注意力和MLP层。

在文本编码方面,模型通过将文本和图像配对的数据用于微调大型语言模型(LLM),从而增强其双语处理能力和理解复杂指令的能力。

此外,考虑到双语文本字形的复杂性,模型采用了ByT5字形对齐模型来准确编码渲染文本的字形内容,确保与文本提示的一致性。

Seedream 2.0团队在模型后期训练过程中,采用了多阶段的方法:

继续训练(CT)和监督微调(SFT):这些阶段显著提升了模型的美学效果。

人类反馈对齐(RLHF):通过自研的奖励模型和反馈学习算法,显著改善了模型在各方面的整体表现。

提示工程(PE):利用精调的大型语言模型(LLM),进一步提高了模型在美学和多样性方面的表现。

精修模型:开发了精修模型,以提高基础模型生成图像的分辨率,并修正一些细微的结构性错误。

在RLHF阶段,团队引入了专为扩散模型设计的优化过程,包括偏好数据、奖励模型和反馈学习算法,如上图所示。这一阶段在提升模型的图文一致性、美学效果、结构正确性和文本渲染等方面发挥了关键作用。

自Seedream2.0发布以来,用户在实际应用中普遍反映该模型在中英双语解析、图像细节呈现和文字渲染方面表现突出。技术细节的公开,进一步验证了其在数据处理和训练优化上的先进性,为用户提供了更多信心。

最后还得真心夸一句,作为一款能用中文提示词,并且能生成中文汉字的国产大模型,Seedream2.0对于广大中文用户来说,可比Midjourney好用太多了。