就在 DeepSeek v3 发布一个月后,老牌霸主阿里云通义千问团队放出了 Qwen2.5 系列的最强旗舰模型——Qwen2.5-Max,在难以作弊的 Arena 榜单上,超越 DeepSeek V3。

这里多扯一嘴,Arena 这个榜单可不是学术测试集,模型不仅无法提前知道题目,甚至参与测试的人员都无法提前知道在测的是哪个模型。

Arena 榜单采用匿名方式将大模型两两组队,交给用户进行盲测,用户根据真实对话体验对 模型能力进行投票。因此,Chatbot Arena LLM Leaderboard 成为业界公认的最公正、最权 威榜单之一,也是全球顶级大模型的最重要竞技场。

不止是 Arena 榜单,包括 LiveBench、LiveCodeBench、GPQA-Diamond 及 MMLU-Pro 在内的一众基准测试,Qwen2.5-Max 都全面的超越了 DeepSeek-V3。

好家伙,DeepSeek V3 的王座还没坐热乎呢,仅仅一个月就被通义的新旗舰端了吗??

我注意到,这两天咱们的各个 Family 群里也陆续有家人发现这个 Qwen2.5-Max 有点牛逼了——

就连外网都出现了大量百万阅读量的讨论帖:

还有老哥干脆跟 ChatGPT 去"Say Goodbye"了——

根据阿里云官方的说法,这个 Qwen2.5-Max 模型最牛逼的是在于数学和编程,还有一个不太常见的名词“硬提示(Hard Prompts)”——

这个硬提示是 Arena 中的一项能力测试,你可以简单理解成,考察模型对于一些模糊、抽象、开放、需要创造力的用户指令,是否能很好的处理。

比如 “写一首关于夏天的诗”,或者 “宇智波斑能打得过贝吉塔吗”,这种 case 就非常考验模型自身的知识储备、创造力(脑洞)甚至推理能力。

最近特别火的 DeepSeek 的一个回答——

满满的家国情怀。

同样的问题,我问了 Qwen2.5-Max——

好理科脑,又好奇地追问了第二伟大是什么:

一个预料之外的答案,Qwen2.5-Max 我愿称你为理科狂魔...

你俩真的是一个理科脑,一个文科脑,我好想给 Qwen 和 DeepSeek 磕 CP 啊

当然,在这种考察 AI 脑洞的问题上,主要考察的是提问者的脑洞。所以,你可以在评论区秀出你和 Qwen2.5-Max 的脑洞。

差点忘了给你们贴 Qwen2.5-Max 的传送门:

网页端:https://chat.qwenlm.ai/

API 调用:

在阿里云百炼平台上可以直接调用 API 服务

这里必须要提一嘴,打开官网后,你能看到下面这个“Artifacts”功能。如果你准备跑一些在线运行的编程类问题,一定要勾选这个。

要我说,这次 Qwen2.5-Max 能打败 DeepSeek-V3,不仅在于榜单和效果上全面超越,这个能实时渲染前端代码的 Artifacts 功能也是加了大分。

Qwen2.5-Max 强大的编程能力搭配上 Artifacts,玩法瞬间打开了,即使你完全不懂编程。

比如你可以直接让 Qwen2.5-Max 给你在线写代码放烟花——

提示词:今年过年七彩祥云的烟花特别火,我想要一个电子版的七彩祥云烟花动画

这不妥妥的来自程序员的浪漫嘛,哪个女生不心动!

如果觉得放烟花不过瘾,想有更多参与感,你甚至可以让他为你做一个更浪漫的交互式艺术作品——

提示词:编写一个程序,生成一幅动态艺术画。画布上随机生成多个点,这些点会按照一定的规则移动(如随机游走、相互排斥、跟随鼠标等),并留下轨迹。最终生成一幅随时间变化的动态艺术作品。

你们注意看,我的鼠标移动到哪儿,这些五彩斑斓的小蝌蚪就跟到哪里,突然感受到了一股情绪价值...

我甚至隐隐的觉得,如果有一天 AI 足够强大,这类交互式的艺术作品可能演变为一种新的内容载体。

当然,上面这种轻应用只是好玩,实测让 Qwen2.5-Max 写功能性的应用也完全没问题。

比如让它生成一个记录 TODO 列表的小应用。

提示词:Help me create a to-do list app in JavaScript.

功能演示——

甚至你可以让他直接写一个国际象棋游戏——

提示词: 制作一个中国象棋游戏

这个提示词真的没法更简单了。

看下效果——

实测了一下,象棋规则完整的实现为了正确代码,一个双人对战象棋游戏就这样一次过了。

好了,你可以卸载掉电脑上的联众世界了。

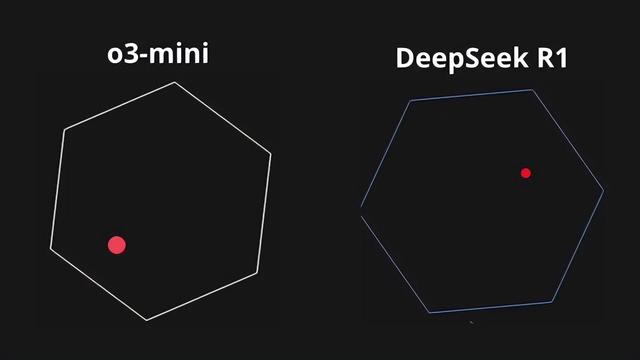

大火的物理模拟实测众所周知,前些天,推特上这条物理模拟的帖子引发了将近 400 万围观。我准备拿来测一下 Qwen2.5-Max。

提示词:写一个程序,展示一个球在旋转六边形里边弹跳。球应受重力和摩擦的影响,它必须实际上从旋转的墙壁上弹起

这道编程题的目标是,实现让一个球在旋转的六边形内弹跳,小球跳动的过程中要遵循重力和摩擦力的影响,是一个逼真的物理模拟 case。下面这个视频是网友跑的 o3-mini 和 DeepSeek R1 的表现:

我加测了一下 Qwen2.5-Max——

哈,竟然翻车了。

不过,在经过人工提醒和一次修正后,它成功了!

效果如下:

小球成功的 duangduang 弹跳、碰撞起来了。

我实测下来,写的应用项目越复杂,越需要优化提示词,并配合“人工反馈 + 抽卡大法”。这一点像文生图/文生视频赛道的特点了。

随着大模型编程能力提升和 Artifacts 渲染边界扩展,可能“人人都是程序员”的时代不远了。

文学测试虽然根据官方的宣传和实测体感,Qwen2.5-Max 的理科能力非常强。但当我顺手跑了一下文学题目后,发现它的回答同样兼具温度和智慧。

比如你们看这个——

有被感动到!它居然在写信之前,告诉我们“每个人都有选择自己生活的权利,包括生育”。而且,整封信都在用温柔且开放的语气,最后还提出建议调整标题。

我只能说:真的不是人,它一点也不刻薄!

压轴:AI 专用变态测试系列当然,文科理科并不能代表 AI 能力的全部。

既然你是个 AI,那一定少不了《AI 专用变态测试系列》题目。

比如这道 Family 群里一位家人提出的倒装句测试题,已经难崩了包括 DeepSeek、Gemini 等在内的一众 AI——

我丢给 Qwen2.5-Max 后——

竟然真做对了!

这个还是蛮神奇的。虽然不是每句话的倒装都能对,但我发现 Qwen2.5-Max 这方面的“抗压能力”确实更胜一筹。

你如果质疑它看不懂倒装句,还会收获一条充满情绪价值的回答——

最难的草莓测试

最难的草莓测试写本文的时候,咱们刚好推送了 Gemini 2.0 全家桶发布的文章,评论区逮到一个评论 ⬇️

好啊,两年过去了,草莓测试还是这么难吗?

刚刚发布的 Gemini 2.0 Pro 在这道题上也是翻车了——

草莓这道题,就好像大模型头上的一个痦子,那么小,又那么碍眼。

虽说我三岁的小侄子都能数对,但是对于 2 岁(从 ChatGPT22 年 11 月算起)的大模型来说还是很难。

有专业的粉丝指出,带反思的推理模型才能解的好。

但我顺手丢给 Qwen2.5-Max 后——

竟然对了!

但要注意,我实测下来发现,不是每个单词都能这样一句话做对。但是,如果你在提示词后面加一句“一个一个的数”,Qwen2.5-Max 数字母会非常稳。比如这道题——

但我发现,这个提示词技巧,对大部分其他国产模型是不生效的,不得不说 Qwen2.5-Max 的指令遵循和综合能力确实强,大家可以实测一下。

结语在对 Qwen2.5-Max 深度评测后,我想到了一句话——

有人逐日,有人摘星。

DeepSeek V3 的发布和爆火,让我们看到了 MoE 模型的潜力,让世界看到中国 AI 的锋芒。

探索 AGI 的路上并不孤单,DeepSeek 和 Qwen 都是中国 AI 大模型的代表力量,当然还有很多优秀国产代表。

说个冷知识,DeepSeek 将 R1 蒸馏出的 6 个小尺寸模型,有 4 个用的是 Qwen 开源模型,李飞飞最新发布的 S1,也是用 Qwen2.5-32B 作为基座模型。

Qwen 在研发超大规模的 MoE 模型上一直在持续努力,2024 年 6 月 Qwen 就开源过一个 57B 的 MoE 模型,这次使用超过 20 万亿 token 的预训练数据及精心设计的后训练方案进行训练,祭出了 Qwen2.5-Max 这个新的王炸。

为同一个 AGI 的目标努力,我们都是一家人。

逐日与摘星, 东方星空会更加璀璨。