最近Deepseek这个AI大模型非常火爆,能力也非常强大,用它来写代码十分不错,但是在IDEA系列开发工具中,并没有Deepseek官方的插件,只能自己通过现有工具实现来集成Deepseek R1编程助手了。

IDEA系列开发工具,即Jetbrains全家桶IDEA、PyCharm、Webstorm、Goland、Rider、RustRover、CLion、PHPstorm、RubyMine、Datagrip都是兼容此方法的。

关于IDEA系列工具使用AI编程助手,以及如何本地部署AI大模型此前已有发表过的文章,可以参考:

如何本地部署Deepseek R1大模型以及如何在IDEA系列工具中使用,方法如下:

使用LM-Studio本地部署AI大模型

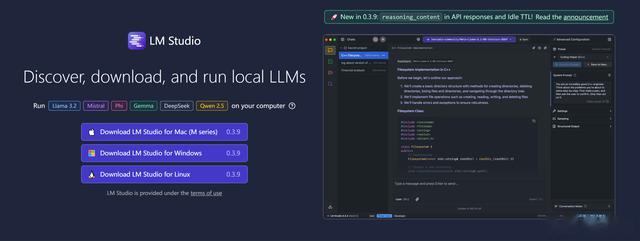

下载安装LM-Studio软件,下载为https://lmstudio.ai/,当然也可以使用Ollama,不过Ollama没有可视化窗口界面,本文只讲最简单的方法,如果只是本地开发调用那么也推荐Ollama,因为它也是被同样被支持的。

具体安装方式可以查看上面的引用的文章链接,特别是AMD显卡,需要下载锐龙RyzenAI专用的版本。

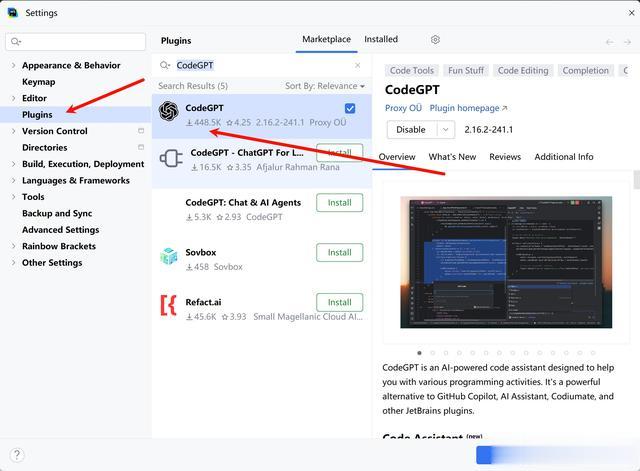

IDEA安装CodeGPT插件在IDEA系列软件中,打开设置,打开插件,在插件市场搜索并下载安装CodeGPT插件。

开启API接口服务,插件配置服务

开启API接口服务,插件配置服务本地部署完成Deepseek R1大模型,以及在插件中安装完成CodeGPT以后,就需要进行配置,使插件能调用大模型的服务,来实现AI编程的功能。

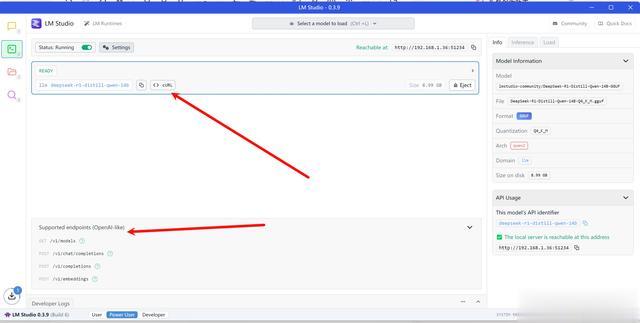

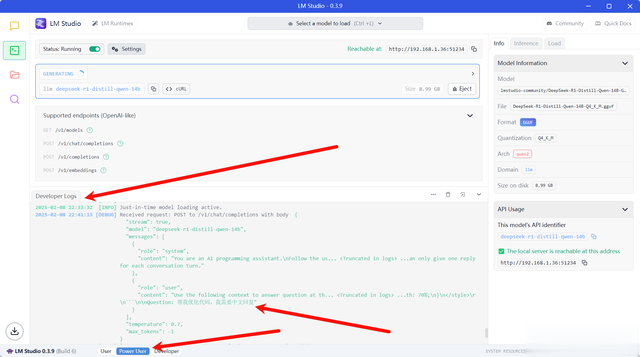

首先,在LM-Studio软件中,打开Developer选项卡菜单,然后点设置修改端口号,端口号可以改的大一些,但不能大于65535,只因小一些的端口号容易被Windows11系统保留占用,避免某次开机以后就不能启动。

修改端口号,并给所有选项切换为开启状态,然后在上方选项选择需要启动的大模型,然后点设置左边的启动按钮来启动api服务。

这里我选择Deepseek R1 14B的大模型,启动成功后的界面如下,此时会有一个本地HTTP后端已被启动,且api接口是和OpenAI一样的,只不过接口地址是本地,且不需要API Key。

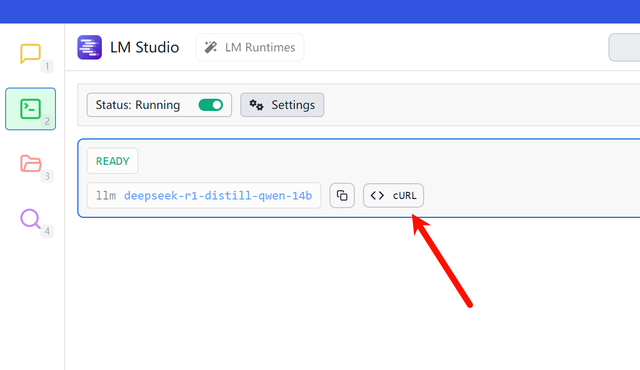

点击已经启动的大模型的CURL按钮,可以获取请求所需要的信息。

可以把复制的CURL信息粘贴到一个代码或文本编辑器中,查看请求信息。

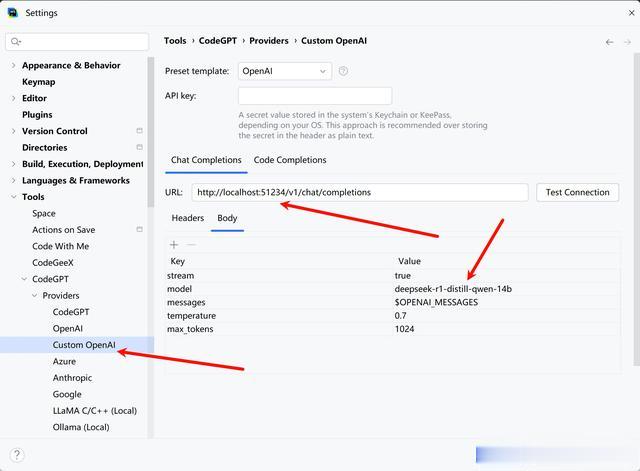

下一步就是在CodeGPT插件中进行配置,你需要记住CURL中的请求参数信息。打开IDEA系列工具的设置,在Tools选项里找到CodeGPT的设置选项,并在Provides找到Custom OpenAI选项,如前文所说,LM-Studio启动的api服务接口和OpenAI接口类似,所以可以当作OpenAI自定义接口地址来使用,如果你是使用Deepseek官方的API调用也是同样的方法,Deepseek官方的API接口格式也是和OpenAI一样,这样兼容OpenAI的工具也就可以被Deepseek兼容了。

在Chat Completions和Code Completions中,修改地址为本地localhost:自定义端口号。其它还有Body信息需要修改,此时需要查看刚才CURL命令复制下来的信息,修改model参数为复制的参数,还有temperature改为复制的参数,max_tokens也可以修改,其它不用修改。

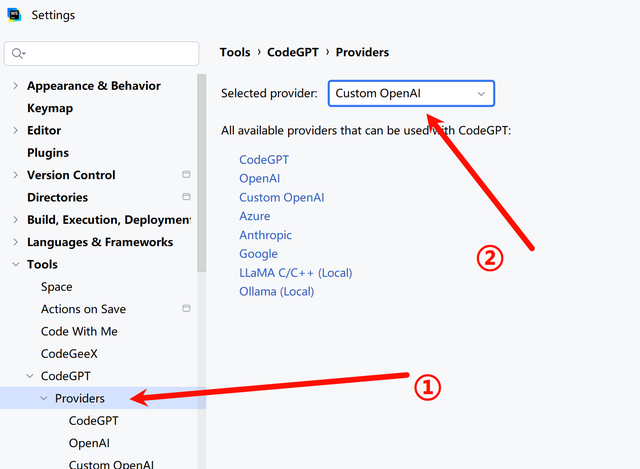

配置好自定义api接口地址以后,选择默认的服务为配置的自定义接口,方法为点Provides并选择服务为自定义OpenAI选项,这样就默认使用自定义的本地大模型接口为默认服务。

配置完成以后,就可以使用IDEA工具来调用Deepseek R1大模型进行AI编程了,打开CodeGPT菜单即可对话,对话左下角也可以切换大模型。

当然,CodeGPT也提供付费或者免费的大模型远程调用能力,其中Deepseek Coder V2是免费的,也可以使用此接口实现,不过本文讨论的范围是本地部署的Deepseek R1,只有R1带有推理能力。

在编程插件中,可以选择代码,让Deepseek R1帮你干活了,比如优化代码,生成文档注释等。

当在IDEA中调用大模型服务时,LM-Studio那里会有正在生成的状态,说明已调用成功,可以查看日志输出获取大模型运行状态,比如api调用方传入的数据。

但是本地电脑计算能力有限,速度很慢,或者大模型参数不高都会影响体验,没有必要的话还是使用免费的国产大模型官方插件替代,参考文章前面提到的链接。