聊天机器人——从客服代理到ChatGPT、Gemini等AI助手——已成为我们日常生活的一部分。虽然它们都提供便利,但训练方式不尽相同。许多用户并未意识到自己可能无意中泄露了多少敏感信息。

有些风险显而易见(比如切勿分享信用卡号或银行信息),但有些则更为隐蔽。

以下是需要三思而后言的深层原因 在我最近关于Gemini Canvas的专题报道中,曾提到这个聊天机器人如何帮助完善我的书籍第一章。有读者担心:向聊天机器人分享作品意味着内容会被用于AI训练。

值得庆幸的是,主流平台并非如此。OpenAI和谷歌明确声明不会使用用户输入内容训练模型。但有个微妙区别需要注意:即使数据不被用于训练,仍可能保存在账户记录中。这意味着任何能访问你账户的人——在极端情况下包括黑客——理论上都可能获取这些信息。概率虽低但并非为零,这也正是我下次会谨慎对待的原因。

更大的风险在于:不同聊天机器人数据处理政策差异显著。虽然ChatGPT和Gemini避免使用用户输入训练模型,但人工审核仍可能标记滥用或有害内容。你未完成的小说或许无妨,但威胁性言论就可能引发关注。

而如DeepSeek等机器人确实会直接使用用户数据训练。这意味着你输入的任何内容都可能用于改进未来模型——这正是需要保持警惕的关键原因。

因此,无论使用哪种聊天机器人,以下七类信息绝对不要分享——是的,即使是不用你数据训练的机器人也不例外。

1. 个人身份信息 在拥挤场所用手机输入密码的人

切勿分享全名、住址、社会安全号(或等效证件)、护照或驾照详情。若聊天机器人数据泄露,黑客可能盗用身份。

若使用聊天机器人修改简历或求职,绝对不要在初始指令中包含这些信息。应在最终润色阶段手动添加。

2. 财务信息 金融人士用手机分析加密货币走势

分享信用卡、银行账户详情和加密货币私钥显然不明智。但用户可能在总结银行对账单时不慎包含这些信息。

或许你想获取税务建议而求助聊天机器人,但请记住:无需透露真实信息也能获得答案。可用类似场景代替真实数据。

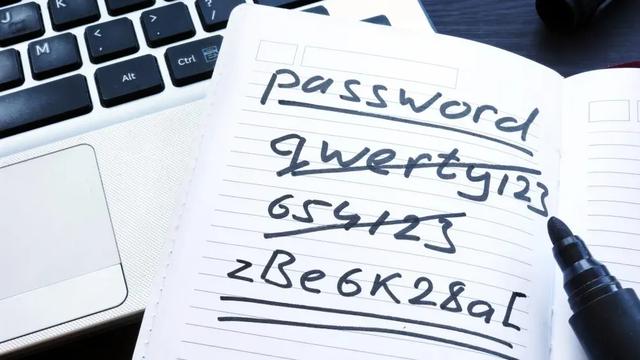

3. 密码 笔记本上记录的密码

在企业官网与机器人对话时,切勿分享邮箱密码或双重认证码。正规服务绝不会通过聊天索要这些信息。

由于ChatGPT等知名机器人会记忆对话内容,这些信息可能被潜在入侵者利用。诸如"母亲婚前姓"或"童年宠物名"等密码提示也不应出现。

4. 高度敏感或令人难堪的秘密 使用笔记本电脑和加密手机的女性

如果你迫切想坦白参与非法活动,或倾诉极度私密的往事,聊天机器人绝非理想对象。

健康隐私同样不可分享——某些机器人会记录对话用于训练,或据此"优化"与你的互动。

5. 公司机密 手机安全锁屏界面

产品原型、机密会议记录、CEO行程等,都是用户易疏忽却绝不能输入的内容。

用聊天机器人处理机密原型看似聪明,实则是危险之举。

6. 暴力或有害内容 手机旁地面的人形轮廓与ChatGPT标志

血腥暴力、威胁言论和仇恨言论不应出现在对话中。

即使是玩笑(如"如何藏尸"),某些AI系统也会向当局举报此类内容。

7. 医疗信息 连接医疗设备的中年住院男子

尽管不能替代专业医疗建议,确有ChatGPT用户用它辅助判断症状。这类使用者需特别注意筛查提示词。

切勿输入处方药信息或医疗图表。建议采用"25-30岁贫血女性适合哪些增肌运动?"等泛化表述。

终极建议 AI聊天机器人是强大工具——但它们不是日记本、心理医师或保险箱。尽管谷歌和OpenAI设有防护机制,谨慎选择分享内容仍是明智之举。

了解不同机器人的数据抓取和处理机制,是保护隐私的第一步。如有疑虑,请让敏感信息远离聊天窗口——最好完全离线。

谨记:如果你不希望某件事被复述、审查或将来重现,它就不该出现在聊天机器人的对话框里。