随着AI算力需求的持续扩张,先进AI服务器电源的重要性也迅速提升。

摘要

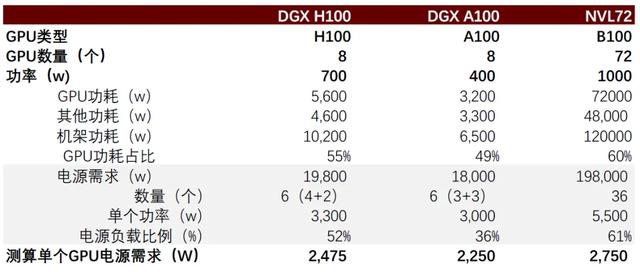

服务器电源是数据中心供电系统建设的核心,随着AI算力提升,先进AI服务器电源的重要性持续升级。先进GPU也对AI服务器电源功率和功率密度提出了更高要求,例如功率约为10.2kw的H100服务器机架需配置19.8kw电源,而功率约为120kw的NVL72机架需配置198kw电源。但服务器电源本身需在有限空间实现功率扩容,传统服务器电源功率密度大多不到50w/立方英寸,而AI服务器电源功率密度可达100 w/立方英寸。这同步对服务器电源拓扑结构设计、元器件应用等提出了更高要求,我们认为未来先进AI电源需求有望持续升级。

AI服务器电源主要分为AC/DC和DC/DC两部分。从电网传输到芯片的过程中,电压要从1-3万伏特降低至0.5~1伏特,在这个过程中数据中心电源架构主要分为保障电路UPS、机架电源AC/DC、芯片电源DC/DC三个层级。AC/DC的输入是PDU输入的交流电,经过降压、整流两个过程输出直流电;DC/DC则进一步将电压调降至芯片可用电压。其中AC/DC电源难点在于有限体积内提升功率密度,而DC/DC则在于如何尽量压降板路损耗。

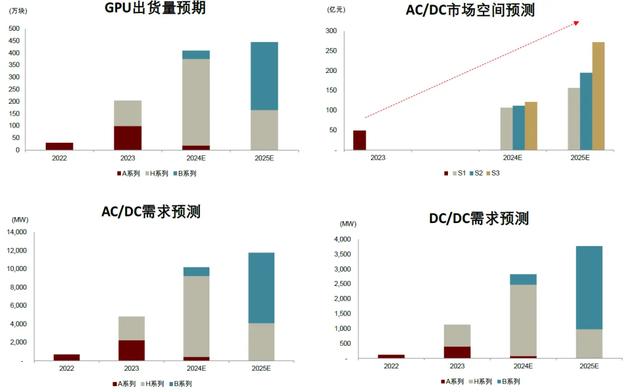

我们预计2024/25年AI电源(AC/DC)需求有望达到10.2GW/11.8GW,AI电源(DC/DC)需求有望达到3GW/4GW,我们预计其中AC/DC的市场规模到2025年有望达到156~272亿元。服务器电源大多采用冗余设计,有效负载往往介于50-60%,既保障安全供应,也使得电源在最高效率的状态下工作。同时由于CPU等其他部件的功率使得机架功率也大于GPU总功率。我们结合不同类型的GPU出货量预计AI电源的相关需求,详见下文。

台系厂商主导AI电源市场,我们同样看好本土厂商的后续表现。目前来看,台达、光宝占据AI服务器电源AC/DC的主要份额,DC/DC来看台达、MPS、Vicor等则为核心厂商。但同时麦格米特、欧陆通等国产品牌也在持续加码AI服务器电源,我们认为随着产品端的推陈出新和升级迭代,国产品牌有望在AI服务器电源领域实现进一步的突破升级。

风险

AI服务器电源需求不及预期,行业竞争加剧

正文

AI发展导致用电量大幅提升,高效电源重要性持续升级

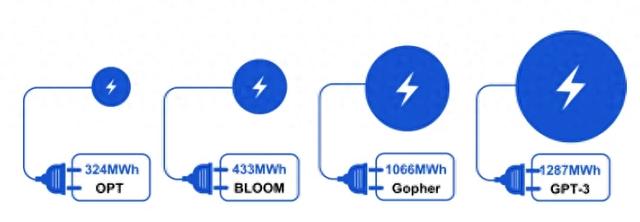

AI带来用电需求的急剧上升。萨姆·奥特曼在2024年初的达沃斯论坛上表示“AI技术消耗的电力超出人们预期”[1]。根据Artificial Intelligence Index Report 2023其中Deepmind Gopher、Hugging Face BLOOM、OpenAI GPT-3、Meta OPT一次训练需要消耗的电力约为1066MWh、433MWh、1287MWh、324MWh。根据IEA的数据,2023年英伟达的芯片消耗电力7.3TWh,而到2026年AI带来的电力消耗有望达到2023年的10倍。

图表1:不同大模型训练一次的耗电量(2022)

资料来源:Artificial Intelligence Index Report 2023, Stanford University,中金公司研究部

图表2:2026年的AI电力需求有望达到2023年的10倍

资料来源:IEA Electricity 2024,中金公司研究部

用电量大幅攀升的情况下,高效的服务器电源重要性持续升级。我们认为影响AI用电需求主要影响因素在于算力规模和算力能效,在面对如此规模的AI用电需求其核心在于提高能效。就算力能效而言GPU的持续升级以及转化效率的提升构成能效提升的关键,但这也都指向高效电源的需求。一方面需要利用高效率的电源来减少电能制式转换过程中的损耗(例如传统服务器的电源转化效率较高的多为96%,但AI服务器电源的转化效率需要达到97.5%~98%),另一方面GPU在升级的过程中本身也需要更高功率密度的电源支持。

AI电力消耗主要集中于服务器和冷却系统。生成式人工智能需要部署大规模的数据中心进行训练和推理,而由于大模型大规模的参数量级因此也带来庞大的计算需求,进而消耗较高的能量。根据IEA的统计,数据中心的电力消耗40%来源于数据计算,40%来源于冷却系统,剩余20%则主要系相关的IT设备等消耗。

图表3:数据中心电力消耗分布(2023)

资料来源:IEA Electricity 2024,中金公司研究部

先进GPU的算力能耗更低。英伟达 GPU 从 P100 到 B100 芯片的八年间的单位算力能耗平均每年下降了 40%[2]。在GTC大会上英伟达给了更直观的对比,同样训练一次GPT-MoE-1.8T需要2000块GB2000训练90天共计消耗4MW的电力,相当于8000块Hopper GPU用电量的1/4。

图表4:英伟达 GPU 算力能效提升趋势

资料来源:英伟达官网,《第七章 AI 的能耗焦虑:增长极限与绿 色困境》,中金研究院,中金公司研究部 (注:图中算力采用芯片 FP16 精度稀疏算力)

图表5:英伟达训练GPT-MoE-1.8T的耗电对比

资料来源:英伟达GTC,中金公司研究部

越来越强大的GPU也对AI服务器电源的功率和功率密度的演进提出了更高的要求。一方面AI服务器电源的功率持续匹配服务器需求,例如功率约为10.2kw的H100服务器机架需要配置19.8kw的电源模组,而功率约为120kw的NVL72机架需要配置198kw的电源模组;另一方面服务器电源需要在有限空间内实现功率提升,功率密度也在持续升级,对比来看普通服务器电源的功率密度大多在50W/立方英寸左右,但AI服务器电源的功率密度达到100W/立方英寸,这对拓扑结构、元器件选择等均提出了更高的要求。

整体而言,我们认为在AI需求持续升级的情况下,不论是算力、能效的演进方向来看,高性能的AI服务器电源都是未来的需求重点。也正由于AI服务器比传统服务器耗能和耗电高出较多,进而带动了整个电源管理的快速发展。

图表6:AI功率发展趋势(2024)

资料来源:Delta,ComputeX,中金公司研究部

#1 AI服务器电源的基础架构如何?

整体来看,AI电源的架构从供电次序的角度来看主要分为三级:UPS—AC/DC—DC/DC。在数据中心的电力从电网传输到加速器芯片的过程中,电压要从1-3万伏特降低至0.5~1伏特,在这个过程中数据中心电源的架构主要分为保障电路UPS、机架电源AC/DC、芯片电源模组DC/DC三个层级。

► UPS(不间断电源):UPS是将蓄电池和主机连接,通过逆变电路等模块将直流电转化为市电的系统装置,在市电正常时对电压、频率进行在线控制进而为负载提供稳定电压、频率的优质交流电并给蓄电池充电;但当市电故障(断电、过/欠压)的时候,逆变电路则将蓄电池的直流电转化为电压、频率稳定的交流电给负载供电,以维持负载的正常工作防止数据丢失。

► AC/DC:由于AI服务器功率更高需要更多的电力,为了减少电力的损耗,电压输出从传统的12V提升至50V,此后再经过层层降压以达到芯片的工作电压。AC/DC环节的输入是PDU输入的交流电,经过降压、整流两个过程最终输出50V直流电。

► DC/DC:DC/DC环节则进一步将电压调降至芯片可用电压,一般而言分为两步进行,第一步是50V降至12V,第二步是12V降至0.8V。

图表7:数据中心电源架构

资料来源:Delta,GTC,中金公司研究部

AC/DC(power shelf)

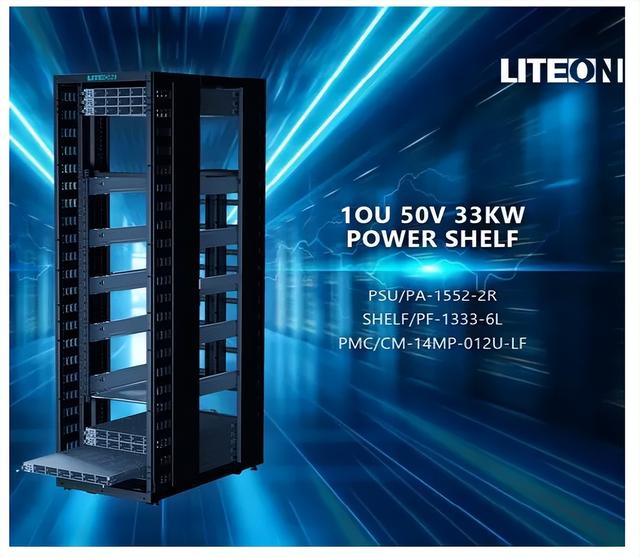

Powershelf主要由电源模块(PSU)和电源管理控制器(PMC)组成,我们预计一组NVL72数据中心机架的电源需求约为198kw(6x33kw)。1组power shelf由6个电源插槽模块和一个电源控制器组成。以英伟达NVL72为例,根据华硕电脑、光宝的资料,我们可以看到一个数据中心机架需要6组 power shelf,每组由6个电源模块组成;一般在机架顶部放置3组,在底部放置3 组,单组 power shelf功率约为33kw,整体机架功率约为198kw;如果是NVL 36则电源的需求减半。

图表8:Power shelf的结构

资料来源:Advanced Energy,Delta,中金公司研究部

图表9:NVL72的电源架构(华硕)

资料来源:华硕电脑官网,中金公司研究部

图表10:NVL72的电源架构(光宝)

资料来源:光宝科技官网,中金公司研究部

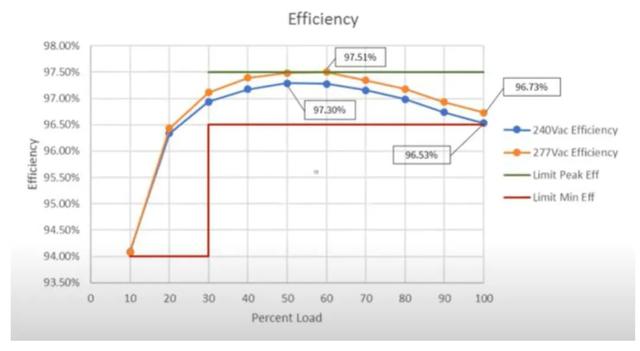

服务器电源往往进行冗余配置以保障稳定运行同时达到较高效率状态。一般而言,服务器电源需要进行冗余设计,仍以NVL72为例,电源需求约为198kw,但NVL72的机架功耗约为120kw。从此前台达电公布的ORV3标准下的3000w服务器电源效率测试中可以看到,在负载50-60%的区间内电源的效率达到最高,在240V和277V的状态下分别达到97.3%和97.5%的效率。这也意味着,服务器电源进行冗余配置一方面保障了整体的供应安全,另一方面也有效地提升了电源的效率。

图表11:ORV3 3KW服务器电源的效率测试(2020)

资料来源:Delta., ORV3 Power shelf development update,中金公司研究部

DC/DC

DC/DC是集成于基板上的电源模块,典型的工况环境是小电压、大电流,要求小巧灵活且靠近负载。先进的GPU通用采用7nm甚至更先进的制程,因此节点的额定电压通常在不到1V的水平,而高功率下为了达到额定性能往往电流超过1000A,甚至目前2000A的峰值电流也越来越普遍。在处理器的封装中,电流主要被中间的芯片消耗,即便DC/DC部署在封装边缘,大电流到达内核仍然需要一段较长的距离,随之而来的问题在于主板的损耗以及带来额外的大量热量,根据焦耳定律(Q=I^2Rt)损耗的增加与电流增加的平方成正比。因此为了最大限度的降低供电网络的损耗,DC/DC必须尽量小巧且靠近负载装置。此外分比式技术,将DC/DC的功能分解为稳压和降压,进而使得电源模块的布置更加灵活且整体更为小巧。

图表12:芯片峰值电流需求的趋势

资料来源:Vicor官网,中金公司研究部

图表13:DC/DC电源示意图

资料来源:Vicor官网,中金公司研究部

纵向供电网络有效解决基板的固有损耗。以往来看,大电流的传输主要是通过布置在主板或处理器基板上的模块化电源来实现,虽然可以大幅降低供电网络的损耗,且减少基板引脚数量但仍然存在“最后一英寸”的固有损耗问题。为了解决这一问题,将DC/DC的降压模块放置于处理器的背面的纵向供电网络有效改善电路功率损耗的问题。

图表14:DC/DC的横向供电到纵向供电

资料来源:Delta, GTC,中金公司研究部

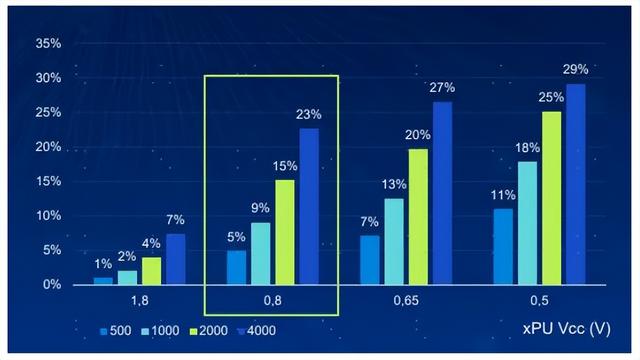

纵向供电网络带来的效率改善较为直观。根据台达电ComputeX大会上的数据,由于铜的电阻以及PCB上的走线长度,水平供电网络的整体电阻可能仍然达到100μΩ,我们假设若电流达到1000~1500A则板间电路的功率损耗就达到100~150w。但纵向供电网络下整体电阻有望减少至30μΩ,损耗功率则直接下降至30~45w左右。此外根据英伟达GTC大会上,台达电的数据,在不同电压、功率的情况下,纵向供电网络相较于水平供电网络有更好的效率提升,且随着电压的下降和功率的提升,效率提升的幅度也更明显,其中在4000w、0.8V的情况下纵向供电相较于水平供电能够提升23%的效率。

图表15:不同功率、电压下纵向供电相较于水平供电模式的效率提升

资料来源:Delta,GTC,中金公司研究部

图表16:纵向供电网络相较于水平供电网络的性能提升

资料来源:Delta,Compute X,中金公司研究部

#2 AI服务器电源的差异性在哪里?

AI服务器电源相较于其他开关电源而言主要的差异在于功率密度和效率。服务器电源本质属于开关电源,我们对比同样隶属于开关电源的充电桩、PC电源、医疗电源等可以看到多数产品的功率相对较低,多数在单机几百瓦到2kw左右,普通的服务器电源也大多数介于1-2kw的功率段,其中仅充电桩、工业导轨电源的功率相对较高。但如果比较功率密度来看,充电桩功率密度约为16-60W/立方英寸,工业导轨电源约为24W/立方英寸与通用服务器电源的功率密度接近,但是对比高端的AI服务器电源来讲仍有一定的差距。此外在电源效率的角度来看,多数服务器电源等都满足80plus的钛金级别(96%)但对于大功率的AI服务器电源来讲效率的进一步提升则更为困难,根据台达官网,其发布的ORV3的3kw和5.5kw电源PSU的效率达到97.5%[3]。

图表17:AI服务器电源与其他类型电源的对比

资料来源:优优绿能招股书,台达电官网,光宝科技官网,动力源官网,中远通招股书,欧陆通募集说明书,AE官网,中金公司研究部

注:效率96%为80plus的钛金级别,94%是铂金级电源

对于AI服务器电源而言,功率密度升级是核心的难点。AI服务器电源在使用中需要插入标准机架中,留给机架的体积是一定的,但随着算力需求的提升电源的功率也对应持续提升,但更大的难点在于功率密度的提升。根据Navitas的数据,当前来看2023~2025期间AC/DC电源的功率密度或有望达到100W/立方英寸,远期或有望达到180W/立方英寸。我们认为功率密度的进一步升级则主要有赖于拓扑结构的设计改进以及电子元器件的升级。此前英飞凌发布power shelf的升级路线图,从3kw到12kw的电源功率进阶过程中我们看到功率密度从32W/立方英寸提升至100W/立方英寸,且功率器件也从Si进一步丰富至Si、SiC、GaN。根据台达2023年股东会议记录,其采用GaN的3200w钛金级服务器电源CRPS相较于MOSFET的产品在相同体积下可以提升25%的功率密度并将转化效率从94%提升至96%。

图表18:AI电源功率密度提升曲线

资料来源:Navitas Semiconductor,中金公司研究部

图表19:Power-shelf的单模块功率持续升级

资料来源:英飞凌,中金公司研究部

高功率服务器同步需要高效散热装置。从散热的配置角度来看,主要分为芯片侧、机柜侧。由于水的比热容达到4182J/kg远大于气体的1000J/kg,因此随着功率的升级也更容易逼近风冷散热的极限,根据ComputeX大会,台达电预计当GPU功耗在800-1000w以上,将主要采用液冷方案。英伟达GB200配置液冷板,进而使得其输入、输出温度分别为25°和45°,达到良好的温控效果。同样由于随着芯片功耗的升级整体机架功耗也持续提升,维谛技术预计在机架功耗达到20kw以上时液冷将超越风冷散热极限。

图表20:不同液冷类型的PUE

资料来源:Delta,ComputeX,中金公司研究部

图表21:AI电源(AC/DC)功率需求量测算

资料来源:维谛技术官网,中金公司研究部

#3 AI服务器电源的市场空间和竞争格局如何?

我们预计AI服务器电源需求仍远大于其服务器的GPU功率需求,其一在于CPU等其他功耗占比,其二在于电源的冗余设计。服务器电源往往采用冗余设计,如前文台达电的测试数据所示,负载比例在50-60%的区间内电源具有最好的效率表现,我们测算DGX H100、NVL72等先进AI服务器的电源负载比例也大多在50-60%。此外考虑到CPU、传输等其他的损耗,GPU功耗占机架整体功耗我们预计约为50-60%。

► 以DGX H100为例:整体采用8个H100 GPU,单个功率约为700w,整体GPU功率约为5.6kw,此外考虑到CPU及其他 DGX H100的整体机架功率约为10.2kw。其电源需求约为6个3.3kw的电源模组,电源功率约为19.8kw,因此对应电源负载比例约为52%

► 以NVL72为例:整机的功率约为120kw,其电源需求约为6组33kw的powershelf,对应的负载比例约为61%。

图表22:不同类型AI服务器的电源需求

资料来源:英伟达官网,GTC大会,中金公司研究部

我们预计到2024/25年AI电源(AC/DC)的需求有望达到10.2GW和11.8GW,DC/DC的需求有望达到3GW/4GW。我们结合不同类型的GPU出货量以及对应的电源负载比例和GPU功率与机架功耗比例综合测算2024/25年AI服务器的AC/DC电源需求分别为10.2GW/11.8GW,其中B系列的电源需求约为0.96GW/7.7GW,A和H系列的电源需求约为9.2GW/4.1GW。此外考虑到DC/DC电源模块主要是布置于芯片基板,因此整体功率与GPU工作功率接近,但结合此前台达在ComputeX大会上给出的基板损耗,我们假设损耗因数约为5-15%,我们测算到2024/25年DC/DC的电源需求约为3GW/4GW。

我们预计其中AC/DC部分的市场规模到2025年有望达到156~272亿元。对比来看,由于5.5kw的电源相较于3kw和3.3kw的电源功率密度更大因此价格也会更高,参考国内高功率服务器电源价格定价,我们假设3kw和3.3kw的电源价格在0.8-1元/w,5.5kw的电源由于目前出货较少价格尚不明确,但考虑到其功率密度更高和拓扑结构更加复杂,我们假设其价格是3-3.3kw电源的1.5-3倍,分三种情况假设讨论(S1:价格约为1.5元/w,S2:价格约为2元/w,S3:价格约为3元/w),我们预计到2025年AI服务器电源(AC/DC)的市场规模有望达到156~272亿元。

图表23:电源需求预测

资料来源:英伟达官网,GTC大会,中金公司研究部

AI服务器电源市场仍然以台系厂商为主,台达、光宝等占据主要市场份额。从AI电源的类型来看,其中AC/DC主要仍然以台系厂商为主,其中台达、光宝位列行业第一梯队,同时台系的群电、康舒也积极布局AI服务器电源,但大多以AC/DC为主。本土厂商来看,欧陆通、麦格米特、奥海科技等持续发力AI服务器电源。DC/DC的产品形态主要是嵌入基板的电源模组,主要以MPS、Vicor、台达电等厂商为主。从收入规模来看,台达、光宝仍然占据领先地位,我们测算2023年台达AI服务器电源收入约为18~19亿元[4],光宝AI服务器电源收入约为8~10亿元[5]。

我们看好本土厂商的AI服务器电源的市场突破。相较于普通服务器而言,AI服务器电源的产品要求高,因此认证规格较高且时间较长,客户往往需要考察供应商在质量控制、交付能力、成本控制能力等维度,因此要成为下游客户的正式供应商往往需要经过较长的认证周期。一方面,从国产厂商来看,大多都已建立起完善的供应体系和质量标准体系,且产品不断推陈出新、升级迭代,具备向上突破的基础;另一方面,随着需求端的持续扩张,终端客户也同样具有引入多元供应商来保障供应的需求,因此我们看好本土品牌在AI服务器电源中的突破升级。

风险提示

AI电源需求不及预期:由于 AIGC 趋势,市场对可以用于模型训练和模型推理的 GPU 芯片的需求显著提升,若后续 AIGC 需求放缓,算力硬件资本开支投入及应用落地不及预期,可能影响AI服务器电源需求扩张。

AI电源行业竞争加剧:目前来看AI电源仍然以台达、光宝等台系厂商为主,但目前电源与液冷两类供应商也逐步出现相互渗透竞争的趋势,一方面台达、光宝等电源厂商积极布局液冷散热产品,另一方面维谛技术等原有的AI散热供应商也积极布局电源市场。需求的持续扩张可能引致行业的竞争加剧,进而影响原有行业的盈利中枢。

[1]https://finance.sina.com.cn/jjxw/2024-01-17/doc-inacwefw2535065.shtml

[2]《第七章 AI 的能耗焦虑:增长极限与绿 色困境》

[3]https://www.deltaww.com/en-US/products/orv3-server-power/ORV3-33kW-Power-System

[4]根据台达电4Q23业绩交流会,2023年AI服务器电源占台达收入比例约为2%,我们测算2023年公司AI服务器电源收入约为18~19亿元,1Q24区间占比约为4-5%对应8.3~10.4亿元AI服务器电源收入。

[5]根据光宝科技4Q23业绩交流会,2023年其AI电源占云端科技板块收入占比例约7-8%,我们测算2023年公司的AI服务器电源收入约为8.5~9.8亿元。

文章来源

本文摘自:2024年7月4日已经发布的《高端电源观察(一):如何看待AI浪潮下的服务器电源?》

江鹏 分析员 电力设备新能源 SAC 执证编号:S0080523080006

黄天擎 分析员 科技硬件 SAC 执证编号:S0080523060005 SFC CE Ref:BTL932

王颖东 分析员 电力设备新能源 SAC 执证编号:S0080522090002

曾韬 分析员 电力设备新能源 SAC 执证编号:S0080518040001 SFC CE Ref:BRQ196

法律声明