引 言

机器人即将走进千家万户的时代已到来,它们如何真正理解为人类递一杯温水、帮老人稳稳起身、为孩子盖上踢落的毛毯,需要的不仅是算法,更是对“人类本能”的深度解码,将数万年进化出的生物行为智慧(多模态数据指纹)转化为可编程的温暖代码,而当这些代码注入机器人的“血液”,我们终将见证科技的温度,始于对人类每一个细微动作的敬畏与复刻。

01 多模态数据集触发机器人三重进化,驱动产业革命

具身机器人正逼近规模化应用的关键节点,正经历从技术突破到价值创造的跨越式发展,根据Gartner技术成熟度曲线,当前行业处于“创新启蒙”向“产业深耕”的战略转折期,开始聚焦可扩展的商业化落地应用,其核心引擎底层推力,正是数据驱动的效能革命,它需要超大规模多模态数据集(运动学、力学、环境交互)的支撑。高精度动作数据的系统性采集与物理语义标注,是将数据驱动的AI训练从数字空间定向锚定到物理空间约束,这构成了具身智能系统实现从感知-行动-认知闭环的关键基础,随着真实的数据注入AI训练管线后,将触发机器人“算法泛化增强、能耗效率优化、安全边际拓展”等三重进化,数据不再是算法的附庸,而是重构机器行为模式的基础底座。

采摘机器人能否像老农一样温柔从草莓丛中摘取成熟果实时,这是藏在指尖的手感秘诀。不仅仅是靠预设程序与仿真数据,虽能构建机械逻辑,但无法传递指尖力道的轻重缓急、遭遇阻力时的肌肉微调和感知温度后的条件反射。行业专家强调“必须让机器人‘理解’人类动作的温度,这需要成千上万次真实动作的数据沉淀。” 具身智能机器人的载体已经由低自由度单臂向高自由度的双臂人形机器人演进,全球多家机构已发布了多个高质量的具身智能数据集:

智元机器人AgiBot World:24年12月开源百万条真机数据;

腾讯Robotics X:25年Q2开源百万条场景交互操作数据;

阿里达摩院:25年Q2开源百万条场景交互操作数据;

北京国地:25年3月开源10万条场景交互操作数据;

傅里叶FourierActionNet:25年3月开源3万条真机数据;

宇树G1灵巧手和夹爪:24年开源640条真机数据;

清华RDT大模型和数据集:24年10月开源6000条真机数据;

谷歌Deepmind Open X-Embodiment:24年6月开源100万条机器人轨迹和527项技能(160,266项任务)。

叠加人形机器人训练场建设如火如荼,双臂+末端执行器/灵巧手完成精细化操作,数据驱动的多模态学习是提升机器人泛化能力的主流路径,动作捕捉技术正在突破机器人"泛化困境"的关键领域,这项技术不仅为机器人学习提供海量训练数据,更是可以通过模拟人类自然运动,让机器人更顺畅地适应日常生活场景。

02 动作捕捉技术,成破解”泛化困境“突破

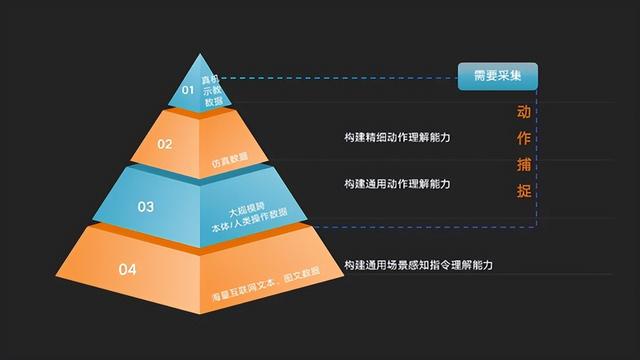

具身智能数据集按数据生成方式和规模大小形成一个金字塔结构:最底层是来自互联网的海量文本、图片、视频数据,用于构建通用场景感知和指令理解能力;中层是基于动作捕捉采集的真实人体数据构建的大规模跨本体/人类操作数据,用于构建通用动作理解能力;中上层是基于真实数据的仿真和合成数据,实现场景的泛化;最顶层是基于本体完成动作任务的真机示教数据,用于构建精细动作理解能力。“动作捕捉技术”通过赋能基础数据采集和高精度遥操作数据,成为了具身智能数据采集破局的关键手段,业界部分企业已经将动作数据采集方案覆盖机器人全流程研发及开发应用阶段,目前全球训练数据集的生产主要有四种方式:基于真实本体/人体/虚拟本体/合成数据的数据集生产,而动作捕捉技术可以支撑“真实人体、真实本体和虚拟本体”的数据生产环节中,为人机交互和数据积累提供了重要基础。

动作捕捉设备的质量决定了采集机器人的数据是否精准,有助于海量真实行为数据的搜集与标注。一套优秀的动捕设备可以捕捉更多的关节,更灵巧复杂的动作,更精准的位姿,相比需要算法IK逆向解算的其他动作采集方式,更为高效便利,更为稳定,信息的裕量也更好,为机器人动作技能学习提供了低偏差、高维度的训练样本,更便于构筑大规模数据工厂,让机器人真正掌握人类的动作语言,须经过海量高保真动作数据的持续喂养,好比婴儿通过观察父母学会抓握与行走,机器人的成长同样需要从人类动作中提取真实行为的底层密码,如何获取高效高质量多模态数据,元客视界三种虚实融合的数据采集解决方案或是最佳路径。

01「人体数据采集 - 真人动捕采集,脱离对本体依赖」

采集真人在劳动过程中的时空连续数据,构建跨模态迁移学习框架,为具身智能系统提供物理实体空间的动作表征与泛化能力训练基准。通过高精度的FZMotion和先进的算法,实时捕捉、分析人的动作,并在此基础上进行动作的模拟和反馈。核心优势在于其高效、精准的动作捕捉能力,能够实时捕捉到上千个点位信息,保证数据的真实性与可信度。此外,动捕技术还具备良好的适应性,能够根据不同的应用场景和需求进行自我优化。在人形机器人领域,动作捕捉技术可以实现更自然的人机交互,提升机器人在家庭和商业环境中的工作能力。

1)采集真人任务执行过程,在真实环境中完成抓取、传递、组装等任务(如装配精密仪器),生成毫米级精度运动数据,脱离对本体的依赖,可同时批量多对象采集,采集效率高,单条数据采集成本性价比高;

2)专用数据采集软件整合数据,导出主流协议格式,适配AI训练需求。

02「本体/灵巧手 遥操作采集 - 高精度、低延时、高连续性,最贴近现实的动作母本」

同步采集真人运动数据与本体机器人执行状态,构建人机双向运动表征映射,为具身智能系统提供物理空间的行为泛化训练范式与动态适应基准,模拟人类的行为和认知过程,使收集到的数据更自然、连贯和平滑。

遥操作数据采集通常用于创建高质量的机器人数据集,这些数据集可以用于训练和优化机器人的智能行为,如抓取、放置、推拉等基础操作,更能支撑复杂行为训练,如精密器械组装、柔性材料焊接、医疗器械操控、衣物折叠熨烫、易碎品包装等精细化作业。

1)与机器人响应毫秒级同步,一台或多机器人并行采集,同步记录人体动作数据(关节角度、运动轨迹)与机器执行数据(身体/手指骨骼角度、电机控制、视觉/点云/IMU等)构建多模态关联;

2)覆盖灵巧手手部完整运动,输出丰富的全自由度的位姿信息;

3)支持市面多种构型机器人,低成本快速批量产出数据,成本低于行业平均值;

4)支持人体骨骼数据与机器人构型自动匹配重定位,无需二次开发;

03「虚拟仿真采集--虚实交互,低成本具身智能训场」

仿真数据则可以在虚拟环境中进行数据收集,避免了实际操作中的风险和成本,可以模拟各种不同场景,收集更加全面和多样化的数据。

有助于解决现有机器人操作数据集局限于实验室、场景和任务多样性有限的问题,实现“即插即用”的机器人应用场景。

1)将人体的动作映射到机器人本体模型,打造一个“零成本、零风险、无限想象力场景”的智能训练场;

2)适配多品牌本体机器人,可兼容多款国内外虚拟仿真平台Isaac Sim、Mujoco、OrcaStudio平台;

3)适用于极限场景模拟、客户预研、低成本项目验证与采集。

04「大规模、高效率、低成本具身机器人训练场」

基于光学动捕FZMotion数据采集方案,已在具身人形机器人数据采集中得到充分验证和应用,可同时采集人体骨骼、机器人电机以及视觉控制、点云信息,其捕捉精度达到亚毫米级(0.1mm绝对位置精度),包括人手指、手臂、腿、脚等进行的灵巧运动,甚至是5指20多个自由度的手指精细运动,让机器人模仿相应的灵巧动作,对于敏捷机器人,特别是双足、灵巧手的人形机器人来说是必要的数据采集基础工具。

同时研发了多传感器多模态稳健捕捉技术,弥补了传统光学采集中抗遮挡不易被采集的劣势,支持国内外主流仿真平台应用,降低硬件依赖,满足单人或者最高50人同场并行采集,具身机器人训练场可将动捕数据解析为带物理标注的训练样本,使效率提升百倍。

与此同时,各地正在积极构建具身机器人训练场,通过多模态数据采集技术,包括遥操作、动作捕捉、便携式末端和仿真合成等方式,在多个可重构的应用场景,支持不同型号机器人在复杂环境中的训练,训练场可降低具身智能技术发展成本,解决基础设施重复建设问题,并有望成为虚实结合具身智能技术平台。

动作捕捉技术正在重新定义人与机器协作的基本方式,面对多维度复杂场景应用,从工业4.0柔性产线的动态适配到服务机器人的人机共生演进,正驱动技术研发范式发生根本转型,从实验室导向的技术突破转向需求锚定型创新,通过深度解耦场景交互,逐步构建起具身智能系统感知环境-理解意图-动态适配的全链路应变能力。