“你听说过 DeepSeek 和 Kimi 的新模型吗?他们又在搞什么厉害的东西了。”隔壁的小张一大早就激动地跑来和我分享他的发现。

这个问题在科技圈引发了不少讨论,尤其是当谈到大模型注意力机制的改进时,大家的兴趣都被勾起来了。

毕竟,人工智能的发展是当前最热的话题之一,任何新的进展都会引起一波涟漪。

注意力机制的起源与发展其实,注意力机制的概念最早是在2017年被提出的,当时是为了提升大语言模型的性能。

简单来说,这个机制帮助模型在处理长文本时,更好地理解上下文关系。

最著名的论文题目是《Attention Is All You Need》。

这标志着一个重要的转折点。

之前的大模型,比如RNN(循环神经网络),由于其“记忆”能力有限,往往会在处理长文本时出现问题。

比如,当模型处理一篇长文章时,前面的内容往往会被“遗忘”,导致后续的理解出现偏差。

而注意力机制通过将过去所有词的关系存储起来,解决了这个问题。

但科技总是不停进步,长文本处理的需求越来越大。

一个新的挑战随之而来——如何让注意力机制变得更高效,更适应长文本输入。

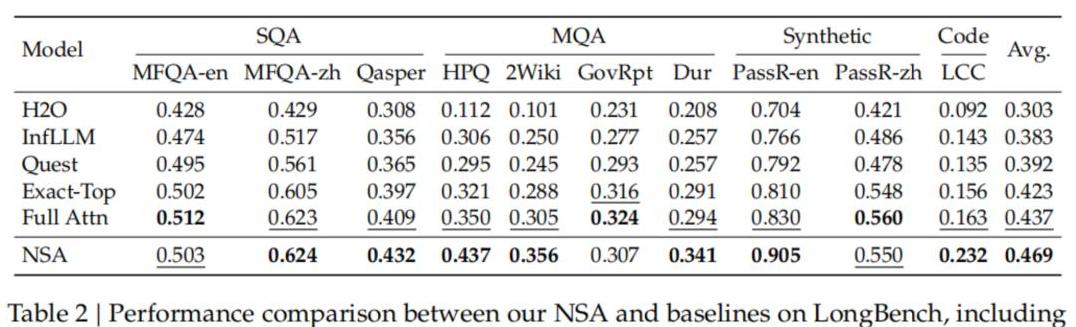

DeepSeek 和 Kimi 的新突破最近,DeepSeek 和 Kimi 分别推出了他们的新改进,叫NSA和MoBA。

这两个新架构都聚焦在注意力机制的优化上。

他们的主要创新点在于,将稀疏注意力引入了预训练阶段。

这是一个大突破,之前的很多工作只能在推理阶段引入稀疏注意力,而预训练中依旧是稠密的。

这种改变,有助于提升整个模型的效率。

肖朝军博士和傅天予博士是这次改进的主要研究者。

他们分别在清华大学的计算机系和电子系工作,多年来一直专注于大模型和注意力机制的研究。

据傅天予介绍,要让大模型在应对巨大输入时保持高效,其实并不容易。

特别是当输入内容越来越长,模型要做到既快又准,是非常具有挑战性的。

长文本处理的挑战与解决方案长文本处理有哪些难题呢?

首先是显存开销的问题。

如果文本很长,所有的词元都需要存储在显存中,这对显存的要求非常高。

其次是计算复杂度的问题。

每处理一个新词,都要和之前所有的词做相关性计算,这是一个计算量非常大的过程。

DeepSeek 和 Kimi 提供的解决方案之一是稀疏注意力机制。

简单理解,稀疏注意力机制不需要每次计算所有词的相关性,而是只选取其中最重要的部分。

这在一定程度上减少了计算量,提升了模型的效率。

傅天予还特别提到,他们在设计NSA和MoBA时,结合了硬件层的优化。

这意味着,他们不仅在算法上做了改进,还在系统底层编写了专门的算子。

这使得模型在处理长文本时,能够更好地利用显存和计算资源,从而达到优化效果。

技术应用与未来展望技术永远服务于应用。

那么这些新的注意力机制在实际生活中可以有怎样的应用呢?

我们可以想象一下未来的场景。

比如,有一天,你可以输入一整本书到一个大模型中,不仅希望它能读懂每一段文字,还能分析出书中的深层意义,甚至帮你总结出主要观点。

这对于科研人员、作家和学生来说,无疑是一个极大的福音。

此外,肖朝军和傅天予也指出,长思维链的生成是大模型未来发展的一大方向。

这不仅仅是让模型能处理长文本的问题,更重要的是让它能在处理复杂任务时,保持思维的连贯性和逻辑性。

对于多模态的未来,傅天予表达了他的见解。

将来的大模型不仅仅处理文字,还能处理音频、视频等多种输入。

这意味着模型不仅能够理解语言,还能理解更广泛的多模态信息,这将带来更加智能的应用。

结尾回到我们最初的引子,人工智能的进步总是让人无比期待。

DeepSeek 和 Kimi 的新突破,展示了大模型注意力机制的无限可能。

稀疏注意力的引入,不仅提升了效率,也为处理复杂任务提供了更强大的工具。

未来,大模型的应用将不仅仅停留在文字处理上,它们将成为多模态的信息处理“专家”。

这种进步不仅仅是技术上的,也是人类对智能的深刻追求。

肖朝军博士的那句话耐人寻味:“未来一定是超越现在的限制,带来更多智慧的时代。”让我们共同期待,这一切的到来。