作者|贾桂鹏

当下,AI大模型的参数已升级至万亿级别,各个大模型庞大的训练任务需要由大量GPU服务器组成的算力集群来协作完成。同时算力的提升对网络提出了超大规模、超高带宽、超强可靠性的需求,为AI模型训练提供强有力的支持。

面对AI浪潮,各个行业纷纷抢滩布局,热度急剧升温,同时在我国“新基建”“东数西算”等工程的加持下,算力网络这条全新赛道涌进越来越多的参与者。据Dell'Oro Group最新报告显示,到2027年20%的以太网数据中心交换机端口将连接到加速服务器,以支持AI的工作负载。

随着新的生成式AI应用的兴起,预计推动数据中心网络市场未来五年销量累计收入超过1000亿美元。算力基础设施和网络基础设施的整体布局与技术架构迎来革命性变化,“算”“网”基础设施成为算力产业发展的关键所在,其迭代演进亟须加速。

在此背景下,元宇宙新声有机会采访到锐捷网络数据中心网络事业群DCN BU总经理黄米青,与他一起探讨了AIGC技术发展为企业带来了怎样的改变,锐捷网络智算中心如何赋能企业数字化发展。

(锐捷网络数据中心网络事业群DCN BU总经理 黄米青)

为什么是锐捷网络

成立于2003年的锐捷网络,跟随着数字经济持续加速发展驭风而行,深耕网络设备、网络安全产品及云桌面解决方案三大领域,凭借强大的研发创新实力、贴近用户的产品方案以及专业快捷的服务能力,现已发展成为ICT及云计算基础设施龙头企业。根据IDC中国以太网交换机市场跟踪报告2023Q3数据分析显示,锐捷网络数据中心交换机在互联网行业市场份额排名第一。

而在AI时代,我们也看到锐捷网络继续秉承着创新发展的路径,凭借敏锐的行业洞察与深厚的技术积淀,进一步推动行业发展,行稳而致远。

生成式AI如何改变企业发展

目前,许多企业数字化转型已进入“深水区”,数字技术与传统行业的简单叠加,已不能满足传统垂直行业的发展需求,企业在各自领域面临新机遇和新挑战,急需向广度和深度进发。

生成式AI作为当前新兴的人工智能技术发展趋势,是企业加速数字化转型的重要选择之一。部分行业代表性企业已在生产运营中部署应用生成式AI,取得了初步成效。

黄米青认为:“AI技术对于企业发展来说是非常重要的机会。”

首先,这些技术能够帮助企业实现自动化和智能化,提高生产效率、降低成本;其次,这些技术还能为企业带来更丰富、更个性化的用户体验。

黄米青表示:“AI的普及和深化将可能从以下几个方面深刻改变人类生活:智能家居、健康医疗、智能交通、工作助手、虚拟娱乐、人类增强等等。这些都将让我们的生活更加便利和舒适。进而,还将影响到社会的方方面面,包括经济结构、劳动力市场、城市规划、法律法规乃至伦理道德观念。”

那么,对于更多希望加快数字化转型步伐的企业而言,下一步应该如何用上、用好生成式人工智能呢?

首先要做到价值认同。要让数字化转型成为企业管理者与企业员工的共识,要充分认识、认可生成式人工智能。生成式AI能够在客户服务、销售市场、知识管理以及辅助决策方面助力企业实现大幅降本增效、降低商业试错成本。

在AI商业繁荣的大趋势下,生成式人工智能正变得更加普惠,企业使用成本持续降低,企业员工学习门槛持续降低。

其次要找到“正确路径”。对于企业而言,选择使用大模型和生成式AI来提升数字化能力,需要遵循科学的理论方法。企业需要根据自身的行业特点和专业知识,与基础大模型合作,将特定场景的专业数据加入基础大模型进行再训练和微调,研发出专属大模型或场景大模型。

再次要防范风险。生成式AI作为一种新兴的技术,在赋能产业高质量发展的同时,也存在许多风险,如隐私保护、结果失控、数据泄露等。

另外,元宇宙新声认为,上述一切的发展前提是算力的发展,我们要考量算力是否能够满足人工智能的需求,因此,如何在AI服务这个业务模式中保持强有力的竞争力,提升集群的GPU效率变得尤为关键。

AI发展势如破竹,但算力仍是其根基

随着生成式AI的发展,以及大模型参数量的提升,对算力的消耗也在明显增加。大模型训练对于算力的需求也符合类似“摩尔定律”的特征,从每3-4个月算力消耗翻倍到每2个月算力消耗翻倍。随着模型迭代速度越来越快,对算力的需求也越发紧迫。

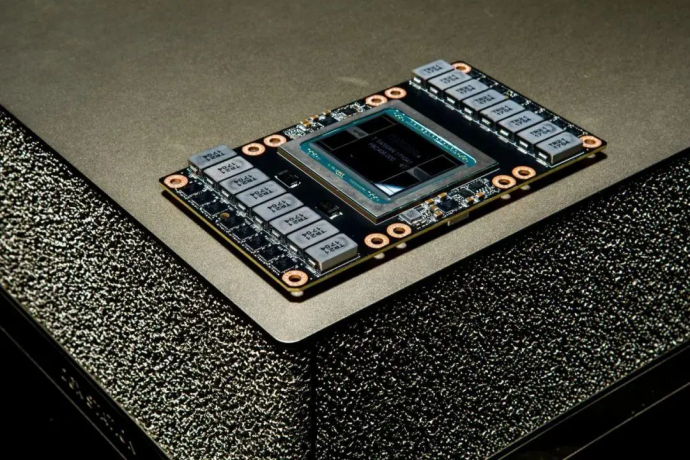

以ChatGPT为例,从OpenAI的官方声明可以看出,ChatGPT4的规模远远超过了ChatGPT3,并且使用更强大的硬件GPU(H100)。这意味着ChatGPT4的训练时间和计算成本都非常高,需要更多的时间和资源来完成。

可以看出影响一个模型的训练时长主要因素在于GPU的利用率,以及GPU集群处理能力,而这些关键指标又与网络效率密切相关。网络效率是影响AI集群中GPU利用率的一个重要因素。

在AI集群中,GPU通常是计算节点的核心资源,因为它们可以高效地处理大规模的深度学习任务。然而,GPU的利用率受到多个因素的影响,其中网络效率是一个关键因素。

众所周知,AI集群通常由多个计算节点和存储节点组成,这些节点需要频繁地进行通信和数据交换,如果网络效率低下,这些节点之间的通信将会变得缓慢,这将直接影响到AI集群的算力。

黄米青表示:“企业要将更多资源投入到提升算力使用效率上,其中包括模型及并行通信算法的研发以及高效算力网络的构建。”

但是,我们看到影响网络通信效率的因素抛开硬件性能的限制,针对端处理时延、内部排队时延和丢包重传时延三大动态因素优化网络拥塞和时延,则成为提升AI集群网络通信性能最具成本效益的方法。基于这些思考,锐捷网络致力于提升通信带宽利用率,降低动态时延以及实现无损的网络传输,以提升AI集群网络通信性能。

在此背景下,锐捷网络面向下一代AI云服务的智算中心网络建设,推出了锐捷网络AI-FlexiForce智算中心网络解决方案。那么它又有怎样的价值呢?

智算中心的价值几何

锐捷网络发布的AI-FlexiForce智算中心网络解决方案,采用NCP+NCF为基础模块横向扩展的三级网络架构,并基于高性能芯片技术,通过将数据流切分成等长的Cell并负载到所有链路,提升网络带宽利用率;基于VOQ+Credit的端到端流控机制实现与业务无关的无损自闭环网络,助力业务算力提升。

从规模上来看,AI-FlexiForce智算中心网络解决方案采用三级组网,可支持17k到32k个400G的端口。锐捷网络在国内首发了400G的NCP和NCF设备,以支持AIGC网络的大接入带宽。NCP设备RG-S6930-18QC40F1,支持18口400G的业务口,并支持40口200G的Fabric内联口,用于和NCP之间的互联。NCF设备RG-X56-96F1,支持96口200G的Fabric内联口。我们可以看到,该解决方案可满足不同业务需求,具有可扩展性和灵活性。

黄米青表示:“锐捷AI-FlexiForce智算中心网络解决方案通过创新性地应用链路负载和拥塞控制技术,根本性解决网络中的拥塞冲突问题,提升GPU之间通信效率,进而提升GPU计算效率,加速企业大模型应用的推出。”

而且,在研发AI-FlexiForce智算中心网络解决方案的同时,锐捷网络还打造了分布式OS,旨在简化部署,提高系统可靠性。传统的DDC(Distributed Disaggregated Chassis,分布式分散式机箱)由于控制面集中,一旦NCC(Network Cloud Controller网络云控制器)失联,就会影响整个网络,从而影响整个业务流程。另外,由于版本不兼容,如果部分设备需要升级,就会面临巨大的运维难题。

锐捷网络AI-FlexiForce智算中心网络解决方案采用去中心化的分布式OS,实现了控制面与管理面解耦。即使管理平台出现问题,也不会影响整个网络的运行。与此同时,它还解决了兼容性问题,设备可以独立升级,大幅降低了运维难度。

黄米青解释道:“我们在研发AI-FlexiForce智算中心网络解决方案时,打造了分布式OS,意在实现分布式方案架构的统一管理基础上,最大程度降低系统性风险,提升AI训练网络的长期稳定运行。”

而在谈到锐捷智算中心最大的优势时,黄米青表示:“锐捷拥有独有的RALB、AILB等网络负载均衡技术,在智算网络方案中提供最优性能。”

可以预见,未来,随着AI对于算力需求持续增加,锐捷将持续精进AI Fabric智算中心网络解决方案,在降低时延、提高在网计算性能、实现端网融合等方面持续突破,打造高速互联、弹性可扩展、绿色节能的下一代AI云服务智算中心网络。

可以预见,在全球互联网流量不断增长和数据应用需求日益多样化的背景下,锐捷将持续精进AI-FlexiForce智算中心网络解决方案,在降低时延、提高在网计算性能、实现端网融合等方面持续突破。未来,锐捷网络还将通过持续的技术研发和产品创新,继续为全球的数据中心提供更高效网络解决方案,在AI时代助力各行业实现快速发展。

采访小记

这是我们第一次与黄总交流,而且还是线上形式,多少会显得有一些仓促,但我们还是在沟通的过程中明显感受到他在专业领域上的积累,比如他对于AI在企业端价值的体现、算力在AI发展过程中的重要性等都有着非常独到的看法和解读,也为我们提供了很多不同角度来观察科技的发展,这也是我们在交流过程中最大的收获。

在采访最后,当黄总在谈到锐捷网络在未来AI时代的赋能时,我们也感受到了他对于AI发展的期待和对锐捷网络产品和解决方案的信心。我们也希望,未来锐捷网络也能像黄总展露出的信心一样勇往直前,利用自己技术赋能千行百业。