夜幕低垂的一个周六晚上,小明在家中摆弄着他的电脑,他最近迷上了AI模型训练。

小明一直以来都有一个疑问:那些大模型真的有那么不可战胜吗?

他隐隐觉得,也许有一天,小模型也能出现在AI推理的顶峰。

GRPO助力小模型推理逆袭让我们回到几个月前,科学家们在研究如何让小模型也具备强大的推理能力。

他们发现了GRPO。

这是什么?

简单来说,GRPO是一种通过强化学习来优化模型的方法。

它不像传统的PPO等方法复杂,简化了很多步骤,但同样强大,最关键的是能够显著提高小模型的推理能力。

你可能会想,一个小小的调整能产生这么大的效果吗?

答案是肯定的。

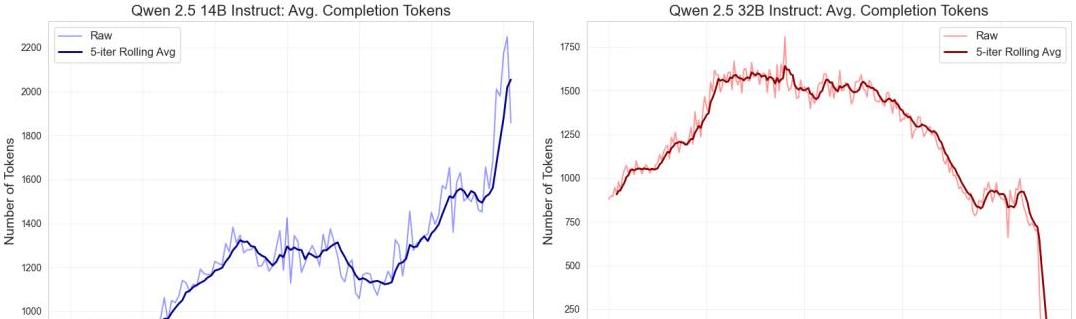

通过使用GRPO,科学家们让一个相对较小的32B模型,在面对复杂的时间线索推理题时,表现出了强大的推理能力。

而且,这不仅是理论上的提升,他们在实验中确确实实地看到了显著的性能提升。

挑战高难度时间线索谜题这次实验中,科学家们选用了一款名为“时间线索”的逻辑谜题。

这并不是一个简单的谜题,而是脱胎于经典桌游Clue,并加入了when和why的全新维度。

这些增加的维度,几乎使得这个逻辑推理游戏成为了推理界的珠穆朗玛峰。

我们知道,大模型在推理任务中往往表现优异,但这次挑战不仅考验了模型的基本推理能力,更揭示了它们在面临复杂任务时的软肋。

小模型Qwen 32B经过GRPO强化学习的魔鬼训练,面对这些难题却表现出超乎寻常的实力。

特别是当这些小模型对抗过去那些被认为表现最好的顶尖大模型时,胜负逆转,出人意料。

成本大降,性能大涨的秘诀那么,问题来了,这些小模型怎么在性能突飞猛进的同时,还把训练成本大幅降低呢?

这听上去有些不可思议。

其实,奥秘就在于训练过程的优化。

科学家们通过细致的设计和调整,在训练环节加入了一些极具创新的策略。

比如,他们通过逐个生成多个模型响应,并不断引导和强化那些正确的推理路径,同时惩罚那些偏离正确方向的推理路径,这种方法使得小模型越来越聪明。

不仅如此,他们还发现在应对一些特定的逻辑谜题时,微调后的模型所需的计算资源大大减少了。

这就意味着,用更少的资源和成本,得到了性能相当,甚至超越了大模型的效果。

这对于那些预算有限的研究团队和个人开发者来说,无疑是一个巨大的福音。

与顶尖模型的终极对决

在一场公开测试中,Qwen 32B和其他顶尖模型如DeepSeek-R1、o1、o3-mini等,进行了严格的对决。

结果令人震惊,Qwen 32B不仅轻松击败这些对手,还在一些复杂推理任务上追平了昂贵的Claude 3.7 Sonnet。

在这一过程中,Qwen 32B展示了其强大的计算能力和极低的错误率。

这些结果不仅让AI研究界为之震动,也再次引发了关于人工智能发展方向的讨论。

是不是我们一直以来都忽略了小模型的潜能?

传统观点认为,只有那些参数量庞大的模型才能称霸AI领域。

这次实验结果明确地向我们证明,即便是小而精的模型,在采用了巧妙的优化策略后,也能站上巅峰。

最终,通过这些系列实验和真实对决,Qwen 32B不仅赢得了胜利,还为整个AI研究界带来了新的方向和希望。

或许,在未来,小模型的表现将不再被低估,它们完全可能在更多场景中崭露头角,并且更加高效、更加成本友好。

通篇读下来,这个故事不仅揭示了小模型的潜在价值,也让我们看到了创造力和智慧的重要性。

最重要的是,这些创新带给我们的思考:在不断探索未知的过程中,每一个小的改进和尝试,都可能带来意想不到的巨大变化。

未来的AI世界,或许将因为这些“小而大”的改变,变得更加多彩和多元。