3月1日,有科技媒体报道称,在OpenAI发布的一段关于GPT-4.5模型的介绍视频中,无意间透露了有关GPT-6训练所需GPU数量的信息。这可能意味着GPT-6的训练规模将远超现有水平。

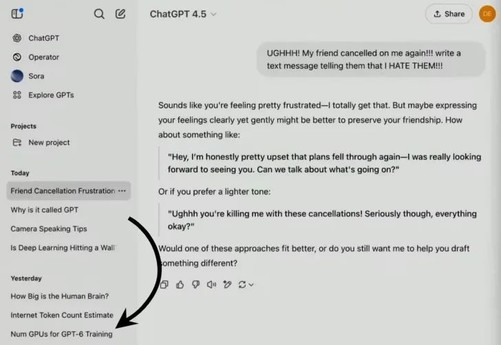

据观察,在这段视频的2分26秒处,展示了一段关于GPT-4.5功能的聊天记录,其中出现了“NumGPUsforGPT6Training”(GPT-6训练所需的GPU数量)的字样。尽管视频中并未对这一内容作出任何解释,但“Num”可能暗示一个非常庞大的数字。有分析推测,这一数量可能高达10万块GPU。

此前的数据显示,OpenAI在训练GPT-3时使用了大约1万块GPU,随着模型的不断升级,对计算资源的需求也在持续增加。GPT-4.5的内部代号为“Orion”,这款新模型在自然度以及减少生成内容中的“幻觉”方面取得了显著进步,其参数量可能超过3万亿至4万亿。据估计,GPT-4.5的训练使用了3万到5万块NVIDIAH100GPU,训练成本约为7.5亿到15亿美元(约合人民币54.69亿到109.37亿元)。

如此甚好

美国有钱,中国有才。