[LG]《Multi-head Transformers Provably Learn Symbolic Multi-step Reasoning via Gradient Descent》T Yang, Y Huang, Y Liang, Y Chi [CMU & UPenn & OSU] (2025)

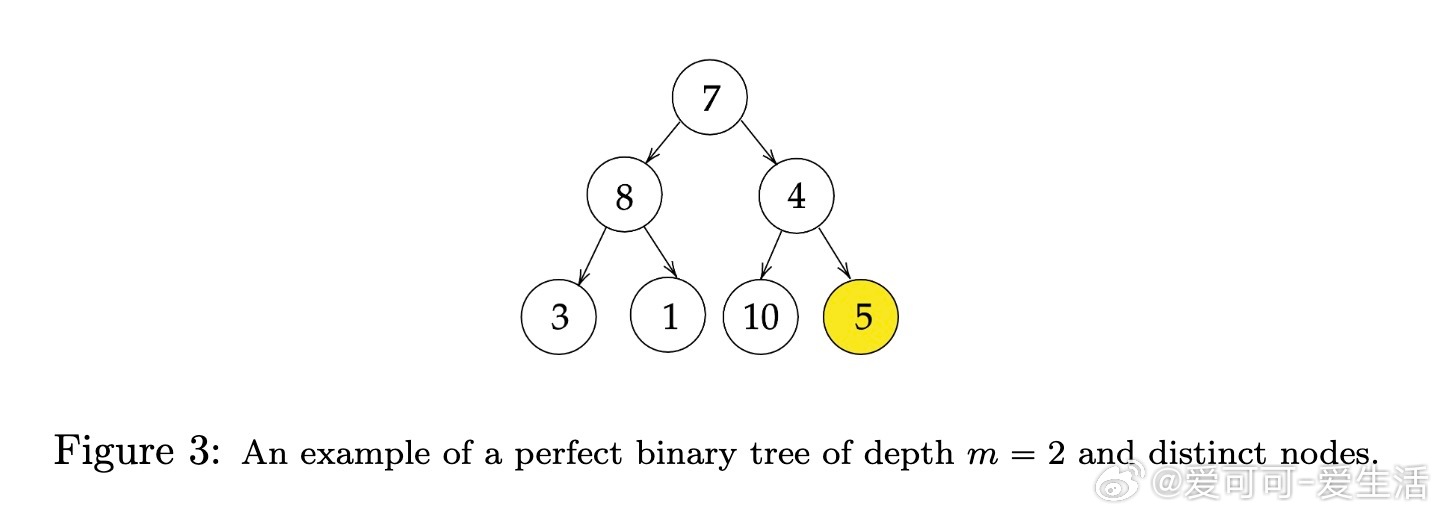

多头Transformer通过梯度下降可证明学习符号化多步推理机制

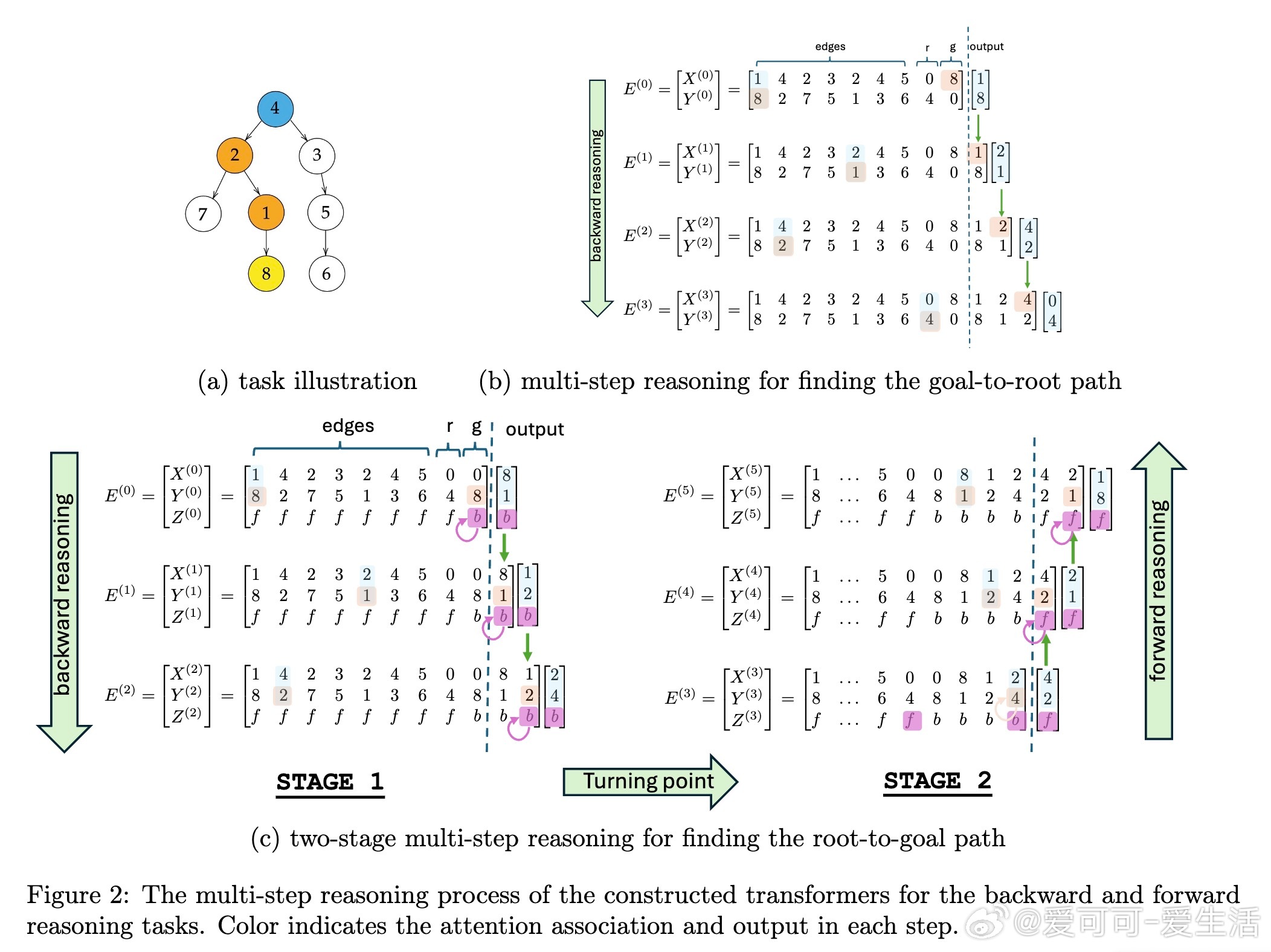

• 本文首次从理论角度揭示一层多头Transformer如何通过思维链(Chain-of-Thought)机制,成功学习树结构上的路径查找问题,实现符号化多步推理。

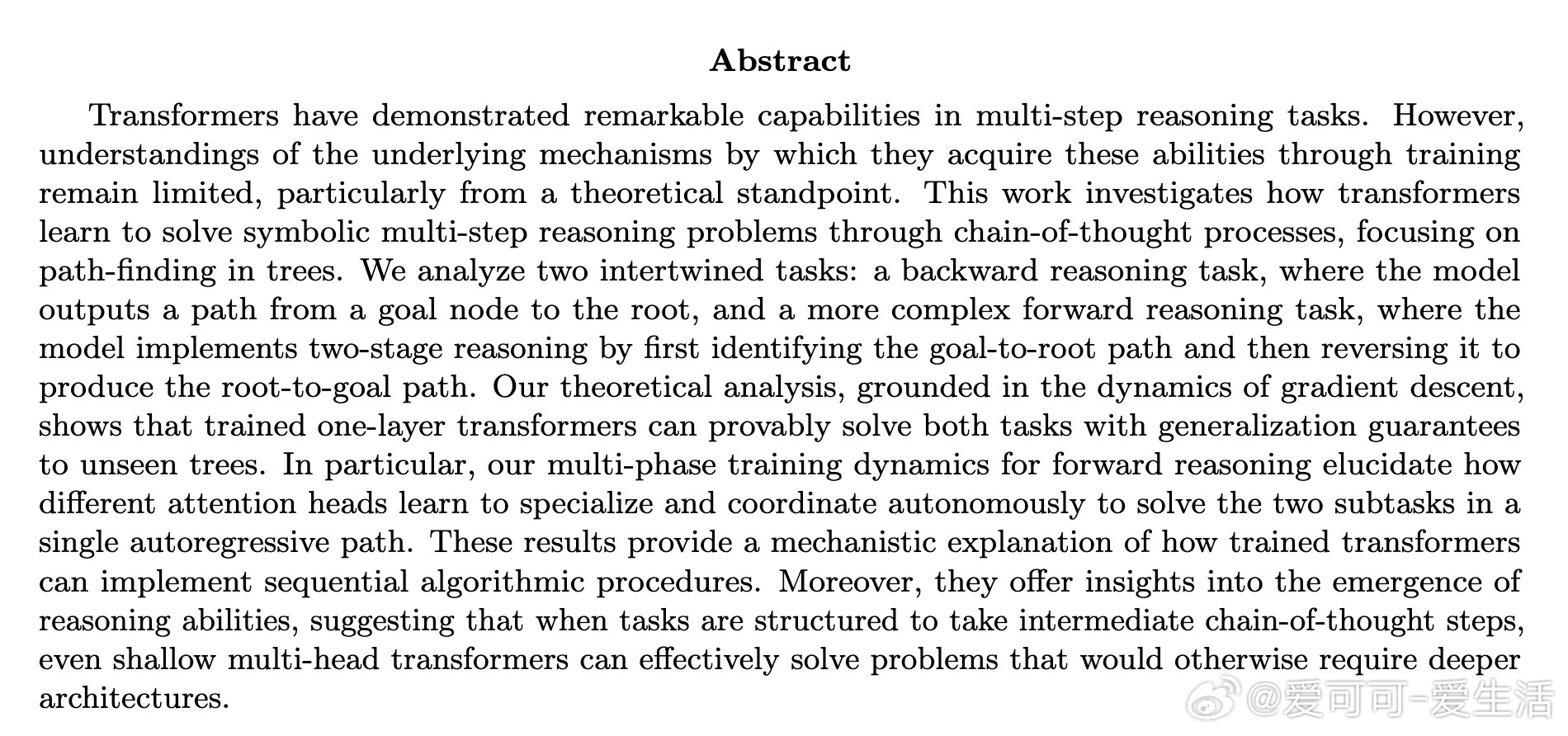

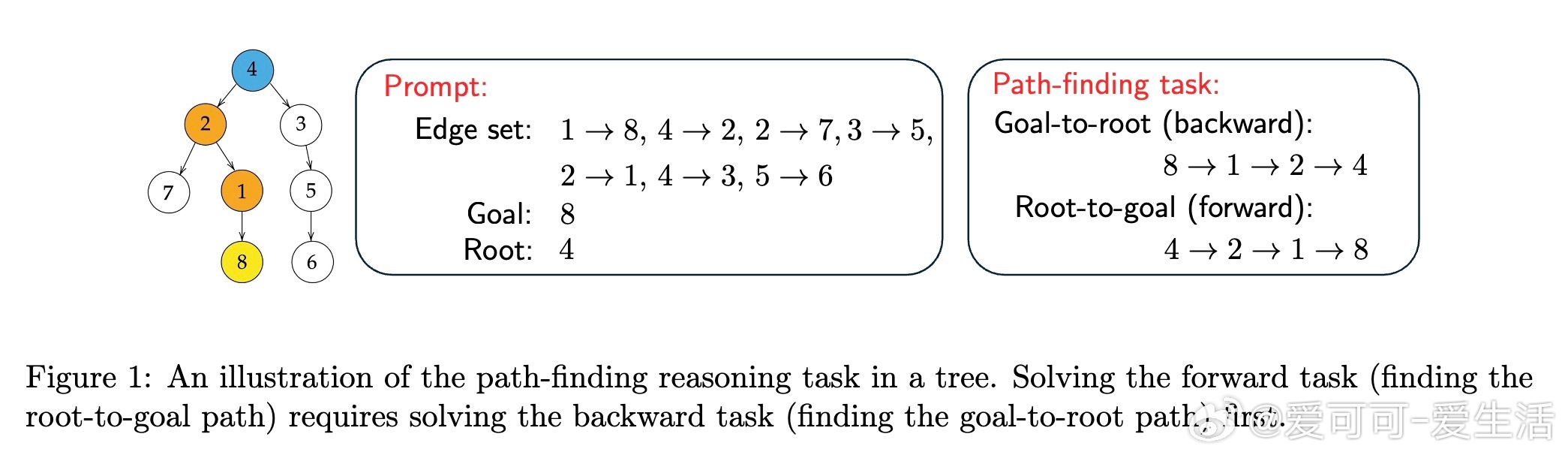

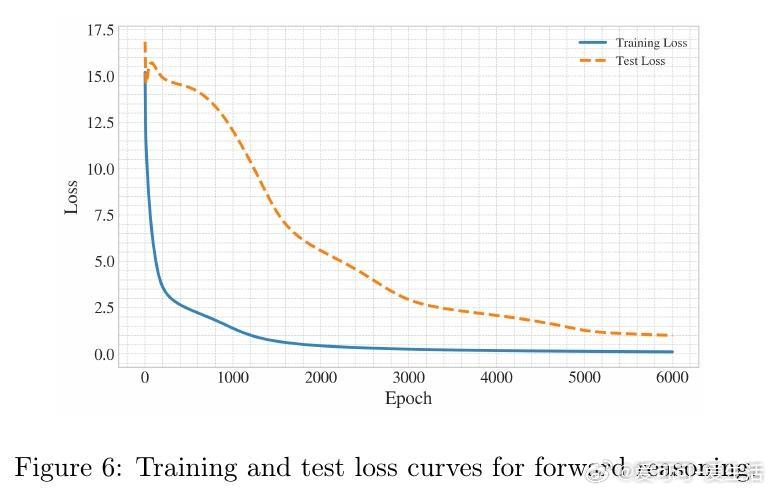

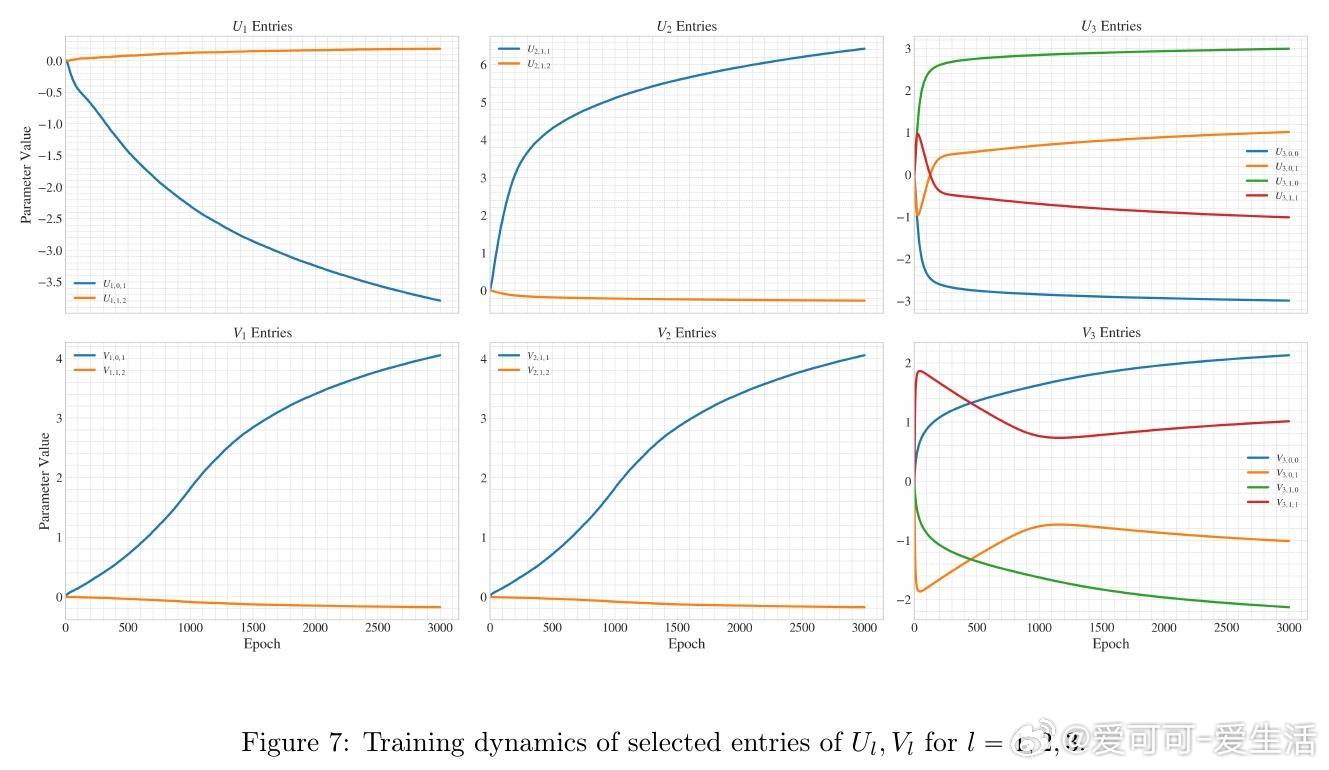

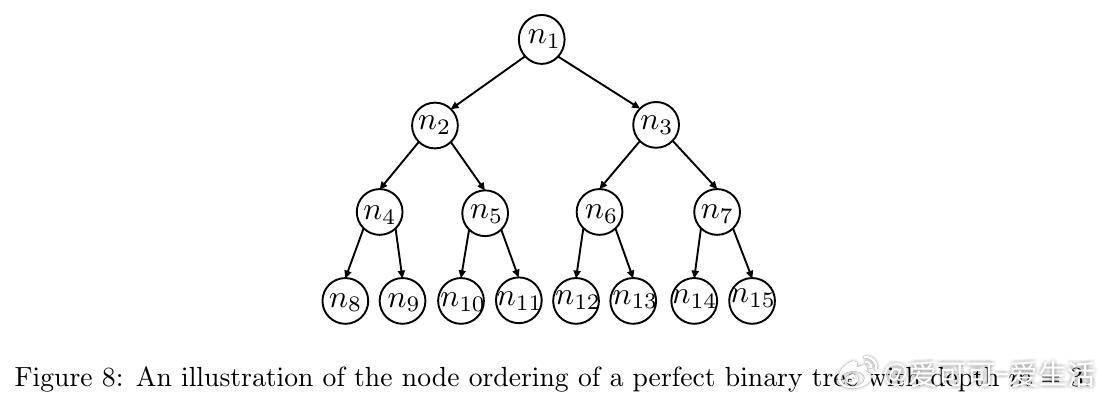

• 针对两类核心任务:逆向推理(goal-to-root路径)与更复杂的正向推理(root-to-goal路径,需先完成逆向再翻转路径),构建了明确的Transformer参数设置与注意力头分工方案,分别专注路径追踪与阶段控制。

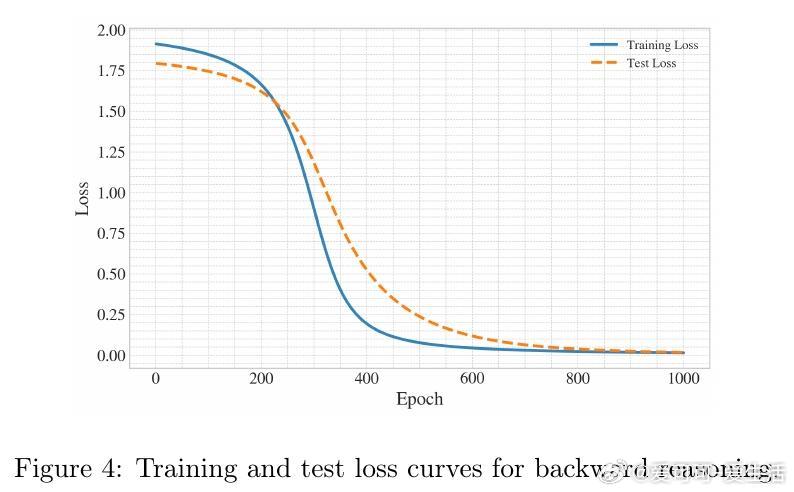

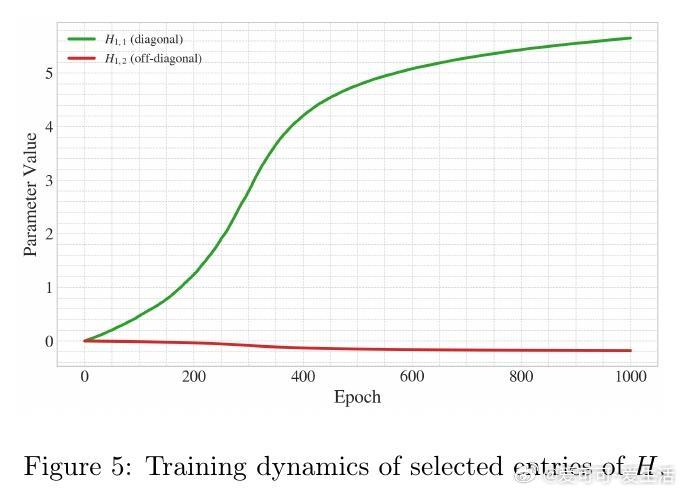

• 训练动态分析表明,梯度下降能够有效引导模型参数收敛至理论构造的最优解,注意力头自发分化协作,完成两阶段推理任务,且在未见树结构上具备强泛化能力。

• 该研究为浅层Transformer实现复杂多阶段算法流程提供了机制性解释,突破以往需深层模型实现多步推理的认知,强调通过延长推理步骤可替代模型深度。

• 实验验证了训练收敛性和泛化性,进一步巩固了理论成果的实用价值,对于理解大型语言模型中推理能力的涌现现象具有重要启示作用。

详细阅读👉 arxiv.org/abs/2508.08222

Transformer链式思维多步推理梯度下降理论分析