“大模型只是客户需求的其中一个部分,但远远不是所有,客户还需要更广泛的基础能力。亚马逊云科技推出自研芯片、生成式AI服务Bedrock以及大模型Titan,都在致力于推动AIGC技术的普惠化,够降AIGC的技术门槛和资金门槛,让更多的人更容易的、更具性价比地去使用AIGC。”

近日,亚马逊云科技大中华区产品部总经理陈晓建在一次媒体沟通会上这样表示。

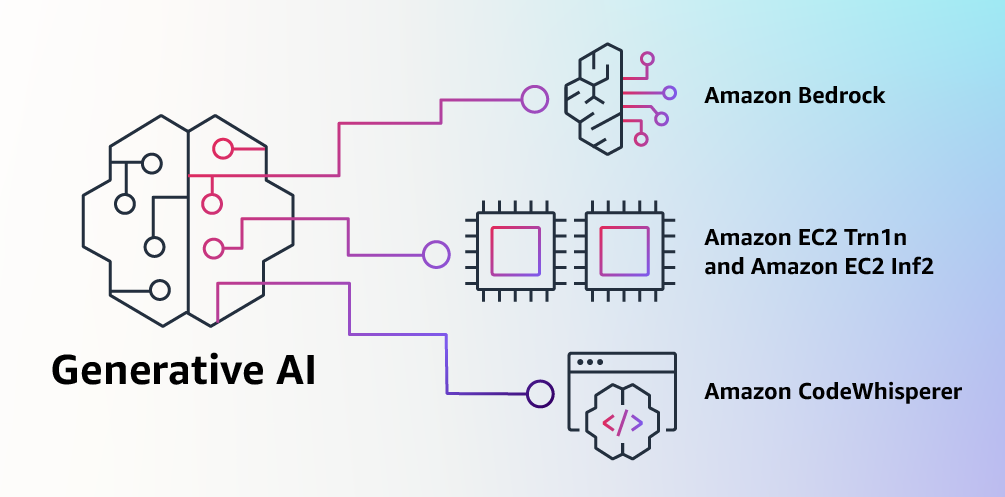

4月13日,亚马逊云科技正式入局AIGC,推出AIGC服务Bedrock和自有基础模型Titan,以及AI编程助手Amazon CodeWhisperer,并宣布基于自研训练和推理AI芯片的最新实例正式可用。

在AIGC领域,亚马逊云科技绝对有实力做基础大模型和大语言模型,但更聚焦在如何打造强大的AIGC云底座,推动AIGC技术普惠化。

近期亚马逊云科技在AIGC领域的四项技术创新

在云上,完全托管和轻松定制AIGC服务面对爆发式增长的AIGC技术,企业客户的核心需求有哪些?此前,亚马逊云科技数据库、数据分析和机器学习全球副总裁Swami Sivasubramanian在署名文章中表示:

“客户向我们讲述了他们现在的主要需求:第一、直接找到并访问高性能基础模型;第二、无缝与应用程序集成,且无需管理大量基础设施集群,也不会增加过高的成本。第三、能够轻松上手,基于基础模型,利用自己的数据(可多可少)构建差异化的应用程序。”

亚马逊云科技在AIGC领域的布局正是围绕这些核心需求展开。

AIGC服务Bedrock是一项全托管的服务,用户可以通过API访问当前主流的AIGC大模型,包括来自AI21 Labs、Anthropic、Stability AI的基础模型,以及亚马逊自有的基础模型Titan。

Amazon Bedrock目前支持的基础模型

“完全托管和轻松定制是Bedrock独特的优势。用户无需担心实例类型、网络拓扑和端点等基础设施细节。同时用户只要在Amazon S3中提供少量(低至20个)带标签的示例,就可以轻松定制Bedrock的基础模型,用于其特定用例。”陈晓建表示。

基础模型Titan包括了两个全新的大语言模型。其中,Titan Text专注于生成式NLP任务,比如写总结、创作博客、文字分类、对话和信息提取等;Titan Embeddings用于搜索和个性化等,可将文本输入翻译成包含语义的嵌入编码能够让搜索结果更相关和符合上下文语境,目前Amazon.com的产品搜索中已经用上了类似的文本嵌入模型。

AI编程助手CodeWhisperer现已面向所有个人开发者免费开放, 适用 Python、Java、JavaScript、TypeScript 和 C#之外,新增支持Go、Kotlin、Rust、PHP 和 SQL等10 种开发语言。CodeWhisperer可显著提高开发者的生产力,在预览期间可提高57%的任务完成速度和27%的任务成功率。

“我们相信生成式AI将改变开发者的游戏规则,因此希望它能为尽可能多的人所用。”Swami表示。

“开发者可以通过注释的方式与CodeWhisperer交互。一般写代码的时候我们都会给自代码加注释,在注释写 “请帮我生成一段上传图片到云端的代码”,它就会给出这一段代码的建议,如果我们都接受的话,就只需要按一下Tab键,就相当于接受了建议。这样的交互体验使得CodeWhisperer更像是开发者的智能助手。”亚马逊云科技大中华区数据技术专家团队总监王晓野表示。

AIGC发展的瓶颈在于算力已经成为业界共识,而更具性价比的算力是AIGC高速发展的基础。

此次,亚马逊云科技进一步升级了算力性价比。目前,基于Amazon Trainium芯片的新型Trn1n和基于Amazon Inferentia2芯片的Amazon EC2 Inf2实例正式可用。

由Trainium支持的Trn1计算实例与其他任何EC2实例相比,都可以节省高达50%的训练成本。以一个具备万亿级参数的大模型进行两周训练为例,GPU服务器P3dn需要600个实例,最新一代GPU实例P4d需要128个实例,但Trn1只需要用96个实例。

由Amazon Inferentia2支持的Inf2实例,是唯一一个专门为大型Transformer模型分布式推理建立的实例。与上一代实例相比,Inf2实例提供高达4倍的吞吐量,降低多达10倍的延迟。与基于GPU的实例相比,每瓦性能提升高达45%,同时也支持诸如GPT类型的大型复杂模型,并且可以用单实例实现1750亿参数模型的推理。

目前,众多领先的AIGC企业都在基于亚马逊云科技的基础设施进行创新。

在AI绘画领域,推出开源AI模型Stable Diffusion的AIGC独角兽Stability AI,就在利用亚马逊云科技上的大规模GPU集群和Amazon Trainium机器学习训练芯片组成的高性能计算集群来训练其生成式AI基础模型,并通过云上模型训练的弹性来优化成本,最终将其使用的GPT-NeoX等开源语言模型的训练时间和成本减少58%。

“今天,基础模型花费的时间和金钱主要用于训练,这是因为许多客户才刚刚开始将基础模型部署到生产中。但是,未来当基础模型进入大规模部署时,大部分成本将用于运行模型和进行推理。” 谈到未来训练和推理对于算力资源的需求时,Swami如此表示。

写在最后谈到亚马逊云科技在AIGC领域的独特优势,陈晓建表示主要有三点:

第一, 降低客户在大规模训练和部署方面的难度,降低AI创新的门槛;

第二, 提供多样化的模型选择,包括第三方模型和自己研发的模型;

第三, 强大的安全能力,确保客户在训练和部署定制化模型时的数据安全。

亚马逊云科技认为,目前生成式AI模型主要集中在文本和图片生成,正在逐步渗透到音频和视频内容生成,未来将出现越来越多的跨模态/多模态内容生成。

“我们正处在一个令人激动的机器学习被大规模采用的转折点上,我们也相信生成式AI将会重塑大量客户体验和应用程序。” Swami总结道。

文中图片来自摄图网

END

本文为「智能进化论」原创作品。