本文陈述所有内容皆有可靠信息来源赘述在文章结尾

文/慧心引力佳

编辑/慧心引力佳

现在市面上的诈骗手段越来越多,什么杀猪盘、兼职刷单、求职招聘诈骗等方法层出不穷,但是这些诈骗手段都需要一些时间和复杂的步骤。

但是现在有近些年又一种新的诈骗手段出现,能够在10分钟内诈骗到430万元,并且这样的诈骗手段的成功率几乎是100% ,究竟是什么方式成功率能够达到这么高呢?

10分钟 被骗430万

去年年初,一个热搜引爆了网络,一家公司的法人代表郭先生竟然在10分钟内被骗了430万元,先不说时间的问题,能够成立公司的人,对于用“人精”来形容简直不为过,竟然就能被骗到。

事情是这样的,郭先生在办公的时候,自己的手机突然响起来,他一看是自己朋友的视频,就赶紧接了起来。

本来以为是要找他唠嗑,但是对方看起来非常的着急,说自己在外地竞标,需要430万的保证金,为了让郭先生安心,表示要对公账,就是借郭先生公司账户走账。

这个朋友是郭先生非常信任的朋友,听对方这么说,他肯定愿意帮助他,于是就分开两笔钱转给了朋友。

转完钱之后郭先生就想打电话问一下朋友那边的进展,没想到当电话打过去之后,他才发现自己被骗了。

而给他视频的那个人根本就不是自己的朋友,而是一些不法分子拿AI换脸生成的,并且还通过拟声技术模仿了郭先生的声音。

而像这样的事情还有很多,大家之前都认为,AI换脸诈骗这些只会出现在公众人物身上,所以就对此诈骗手段警惕心不够。

但是这样的诈骗确实会出现在各行各业和各类人群当中,之前有个大学生,同学给他打了几秒的视频就挂了,后面又说借钱,于是他就上当了,给对方转过去了3000块钱。

没想到过了几天,钱还没还,对方用同样的手段问其借钱,这名大学生也是感受到了不对劲,也是拨通对方电话之后才发现自己被骗的。

而这种诈骗方式最常见的还是在老人的身上,因为老人对于这些电子产品不是非常了解,就算是有些异样,对方也是察觉不出来的。

AI换脸模仿声音技术很简单

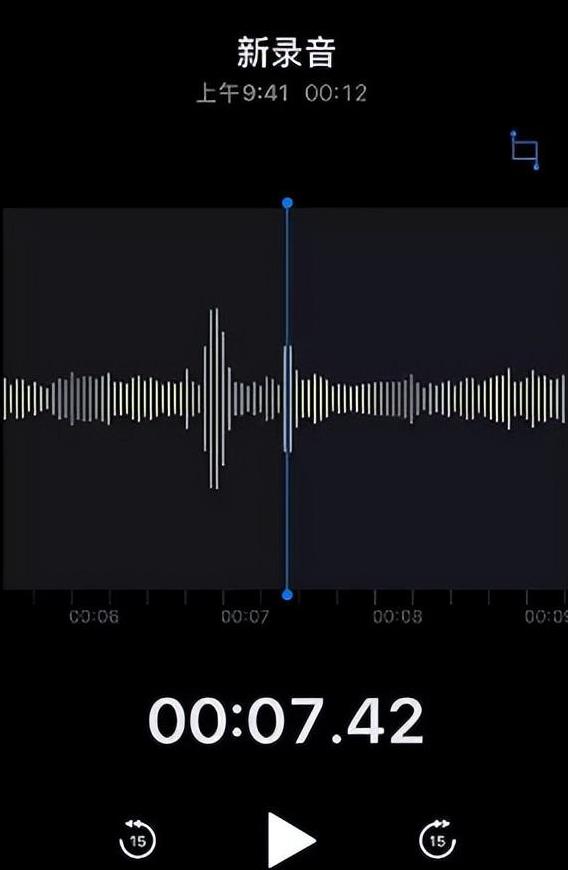

我们先来说声音合成,那些骗子会通过骚扰电话录音等提取大家的声音,之后再经过后期合成,这样的方式合成的声音与本人十分的相像。

但是现在随着科技的进步,他们并不需要很多的素材就能够以别人的声音合成他们想要说的话,不止是骗子有这样的技术,我们在网络上也随处可见。

只需要一个app就能够进行声音克隆,有些可能收费高一些,可有些直接能够低至9.8元,那有人就会说生成的不会非常假吗?

之前有记者做过一个实验,用几款AI合成一段语音,让10位老人辨别,但是最后竟然没有一个人成功辨别出来。

接着就是换脸,有些可能是在网络上找一些喜欢分享的人的视频照片等,将这些合成视频,而现在也是只需要一款app就能够实现一键换脸。

虽然有些视频看起来一眼假,但是对于一些不熟悉电子产品的老人分辨不出来,可能对方只是一句自己加了美颜,就直接糊弄过去了。

其实不止是骗子一对一进行诈骗,还有些直接在网络上用AI技术合成视频来圈钱,他们在网络上用AI合成一段看起来十分诡异,不符合常理的视频,来博取流量。

可能有些合成的视频会传播正能量,但是有些可能就利用这些散播谣言,封建迷信等东西,然而这类视频却十分的有人气。

还有人用别人的脸运营自己的账号,就比如说下面这个“俄罗斯娜塔莎”,有人在网络上经常刷到她,明明是同一张脸,但是刷到的账号都不是同一个。

没想到这些全部都不是真人,这些人利用一名乌克兰的网红的脸生成视频发布,有些可能只是单纯的发一些鸡汤。

但是有些人会利用外国人的脸发表一些非常有争议的事情,甚至有可能引导网友对一个国家的印象,甚至破坏两国友好关系。

怎么才能够不被骗呢?

首先我们要保护好自己的信息,不要在网络上暴露过多,不要过度分享一些动图和视频。

在我们遇到有人借钱的时候,一定要多方面验证对方的身份,比如说对方打电话,那么我们可以通过微信视频再验证一下,不要轻信对方。

如果经过多方验证确定是自己信任的人,我们在转钱的时候,可以设置称“2小时到账”,或者“24小时到账”,如果发现问题,大家也能及时挽回损失。

最后我们知道,上当受骗的人群大多数都是老年人,希望大家平常可以多关心一下老人,并且多为他们普及一些知识。

参考资料

京报网【2024年4月8日】《调查|不法分子盯上老年人,“AI换脸换声”难以辨别》

中国法院网【2024年7月18日】《当个人视频成为“AI换脸”软件模板后 法院:侵犯个人信息权益》

光明网【2023年5月24日】《AI诈骗在全国爆发!诈骗成功率接近100%》