自去年ChatGPT面世开始,AI就成了整个科技行业的热点,它在改进用户体验的同时,也为厂商带来了新的增长点。因此,各种大模型层出不穷,应用范围也变得越来越广泛。特别是国产手机厂商,比如vivo的蓝心小V,荣耀的魔法大模型,华为的盘古大模型等等。

相较之下,苹果在这方面表现得相对保守,尽管之前一直很少强调“AI”,更多的是用“机器学习”这样的专业词汇来介绍自家的智能功能,其功能大多集中在识别文字和图片这样的场景,而不是现在如日中天的生成式AI……直到WWDC24,苹果也终于在生成式AI方面有了自己的布局。

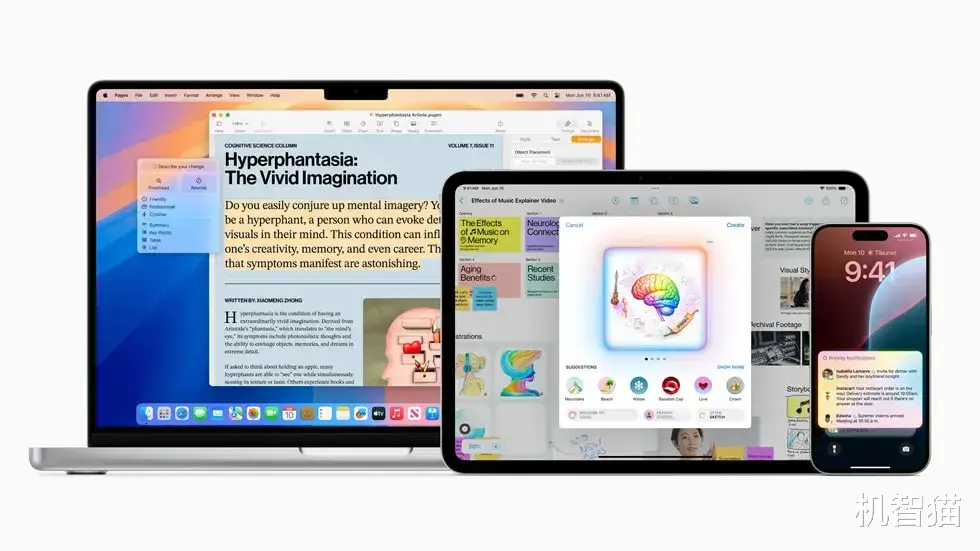

和往年一样,今年我们也在现场,亲眼见证了苹果在AI赛场交出的答卷——Apple Intelligence(苹果智能),这对于苹果以及整个科技行业,无疑又是一个历史性的时刻。

什么是Apple Intelligence

这串英文看着很长,但它并不是什么抽象的概念,就是字面意思上的“苹果智能”。

通俗意义上大家理解的AI都是Artificial Intelligence(人工智能)的简称。苹果这里玩了一个“谐音梗”,把自己的AI称作Apple Intelligence。别人的AI是人工智能,苹果的AI叫“苹果智能”,也算是“偷换概念”了。

所谓Apple Intelligence,其实是基于iPhone、iPad及Mac等苹果设备而生的一套个人智能化系统,它能够基于用户的个人场景提供生成式大模型功能,具有强大的语言/图像理解能力以及创作能力,同时还能进行多种跨设备操作,帮助用户更好地使用苹果产品。

对于Apple Intelligence,苹果总结了它的五个特点:强大、易用、深度整合、个人化、私人化。苹果希望AI能融入到生活中的方方面面,甚至比用户更了解自己。

库克在WWDC24表示,“它(AI)必须了解你,并基于你的个人背景,比如你的日常生活、你的人际关系、你的沟通等等,所有这一切都超出了人工智能的范围。这是个人智能,也是苹果公司的下一个重大举措。”

Apple Intelligence是一个非常个人化的AI,注重于“我能帮你做什么”,理解用户的个人情景,就像苹果演示的那样,预估你可能会用到哪些App,调用哪些信息,帮你润色文字,总结全文等。

它的大模型参数量也确实很小,在iPhone、iPad、Mac等终端侧运行的规模只有30亿。作为对比,国内手机厂商的端侧大模型参数量基本在70亿到130亿之间。

参数量越大自然“性能”越强,但是功耗也就越高,随着使用时间的拉长,参数量会不断增长,对硬件的要求也会水涨船高。

那么问题来了,如果用参数量更小的大模型,就能达到相同的效率和结果,会不会对手机、平板、PC这样的移动设备更有意义呢?

当然,苹果也整合了ChatGPT,但它只是作为“外挂”存在,只有用户需要一些更垂直和专业的大模型时才会调用,Apple Intelligence依旧是主体,这才是苹果AI体验最重要的核心。

“苹果智能”和“人工智能”有何不同对比其他AI,Apple Intelligence最大的不同我觉得是个性化。

一般AI的使用场景是什么样的?是不是需要用户提出一个问题或者需求,AI给出一个答案或者结果?Apple Intelligence的逻辑就不一样了,在库克演讲时有一个场景让我印象特别深刻:问iPhone“下午我有个会议延后几个小时,开完后还能不能赶上女儿的演出?”

这时候,Apple Intelligence会识别联系人以及TA与机主的对话,从中提取出演出的时间和地点,自动调出用户的日程,然后地图App查询前往演出的路线,进而判断是否能赶上。

显然,Apple Intelligence的不同就是能够获取设备上的本地资源,然后根据用户的个人情况给出针对性的反馈,而其他AI产品即使拥有不错的自然语言理解能力,也只是针对问题本身进行一问一答,这就是Apple Intelligence最大的亮点。

再比如,苹果在WWDC24上演示了这样一个场景:直接唤醒Siri询问“明天A地天气怎么样?哦不,是B地”。Siri会正确反馈出B地的天气情况,接下来继续发出指令“明天下午3点去那里爬山”,Siri就联系上下文,将“去B地爬山”记入备忘录,整个过程迅速且准确——看到这里,现场响起了激烈的掌声,无不为之叫好。

是的,Apple Intelligence能基于用户的个性化、私人化数据理解上下文,同时“看懂”用户设备内的文字、图片、视频,然后根据用户的指令主动调用设备上的各种数据,实现跨应用快速操作,而这一点,是目前其他手机厂商的端侧大模型都不具备的。

这种基于个人数据完成的操作,影响的恐怕不止是用户的使用习惯,还有应用形态。如果以前繁琐的操作都可以由Apple Intelligence代劳,让它负责调用设备上的各种资源,那么我们未来还需要这么多App吗?这是否意味着未来的设备也可以是另一种形态?

Apple Intelligence的另外一个不同,在于它的隐私保护逻辑。这的确是个让人担心的问题,过去苹果所有与AI相关的功能,都是依靠本地的机器学习能力实现的,数据量非常小,完全不需要上传云端。

但Apple Intelligence是一个基于用户个人化的大模型,这意味着只有获取的数据越多,它才会越懂你。这就引出了另外一个问题:要不要让渡个人数据?让渡后,苹果该如何保护这些数据?对此,苹果也在WWDC24上也做出了回应。

首先,Apple Intelligence调用数据时,只会调用需要用到的数据或App,调用到的数据也会进行加密。其次,数据只要能在本地处理的,就在本地处理,只有遇到无法处理的数据才会上传到云端。而上传云端的数据,会进行端对端加密,用苹果的话来说,就是连他们自己都无法查看。

再次,苹果的隐私和加密,包括Siri接入的ChatGPT,用户的IP地址都会被隐藏,所有的数据请求都不准被记录。按照苹果的设定,调用ChatGPT时需要征求用户同意后才能继续使用,反之则不行。

iPhone、iPad、Mac使用体验与效率的飞跃既然Apple Intelligence和其他AI相比,在特性、隐私、逻辑上有这么多不同,那么部署到iOS、iPadOS、macOS上之后,会给iPhone、iPad、Mac带来哪些体验上的飞跃呢?

首先当然是几乎所有苹果设备上都能使用的Siri。这个曾经引领行业的语音助手,坦白说在AI时代已经略显有些落后了,而这次苹果在WWDC24上演示的多项功能,都是基于Siri来实现的, Apple Intelligence赋能的Siri,无疑迎来了新生。

除了前面提到的自然语言理解能力以及跨应用协同,Siri还能识别屏幕上显示的内容,比如朋友发来的电话号码和联系地址,可以通过语音指令直接将这些信息写进通讯录;再比如在填写表格时,从相册中提取自己的驾照号码并填入对应的空格……

那个曾经只能用来“调戏”玩乐的Siri,终于要摇身一变成为真正的个人助理了。

而在iPad平台,苹果同样有大招,比如有生之年系列之计算器App。

苹果现场做完功能演示后,所有人都在“哇”,因为除了常规的各种计算功能,Apple Intelligence加持后,它完全变成了一张能够自动演算的“草稿纸”,用户只需要在上面写下各种算式,就能迅速得出结果,并且随时做出任何修改,也能根据新的算式实时运算新的结果。

不仅如此,在演算过程中,计算器App还能根据公式生成图表,其中的变量也能根据用户的需求进行更改,功能体验远超目前市面上所有同类产品。

它甚至还会通过Smart Script功能,模仿用户的笔迹,自动生成相似的手写风格,同时还会智能优化笔迹,甚至还能在手写笔记中自由地增/删文字,重新排列段落,让界面看起来更加自然、整洁。并且这个功能在笔记、备忘录等任何支持手写的原生应用中都可以使用,喜欢用Apple Pencil的小伙伴有福了。

对于生成式AI核心的图片生成功能,苹果也有一套自己的打法——Image Playground。用户随手画下的草图,系统会自动识别图片内容生成美观的图片,甚至还会结合周围的文字信息。

如果在聊天时提到对方即将过生日,系统也会自动根据对方的头像或者照片,生成一副庆祝生日的图片。至于效果,Apple Intelligence自然会更复合用户需求,是真正体现个性化定制的生成式AI。

在更常用的文字生成层面,备忘录、聊天、邮件等几乎任何需要文字录入的场景,都可以调用Writing Tools工具,它会帮助用户根据不同的语言风格重写、校对文本,或者快速阅读文章、邮件的主要内容,并给出归纳总结。

也许你会说,这些功能其他生成式AI工具也能实现啊?

的确如此,但是Apple Intelligence能够做到在当前界面完成所有操作,而不用跳转到其他App,也没有额外的学习成本,实现这些功能不需要独立的入口,但又无处不在,刚从发布会现场回到酒店奋笔疾书的我,已经开始期待未来它能够根据我刚刚记下的笔记、拍下的照片/视频以及备忘录里写下的观点,直接生成一篇深度报道了。

目前尚存的疑问与行业意义基于个性化的长句/前后文自然语言理解能力、首屈一指的软硬件结合,不同系统/设备之间的资源读取和调用……Apple Intelligence似乎都远超其他AI产品,并且它还拥有很高的隐私安全等级,这么说,苹果再一次“后来居上”了?

是,但也不完全是。

比如前面提到的大模型参数量,Apple Intelligence的端侧参数量只有30亿,而其他很多大模型则已经达到了百亿级别。当然,大模型的能力并非只取决于参数量,还要看数据的质量和运行效率。

举个例子,微软自制模型Phi-2,参数量也只有27亿,但它的质量足够高,即使手机的计算能力有限,也能确保模型生成准确的结果。

Phi-2在Big Bench Hard(BBH)、常识推理、语言理解、数学和编码基准测试中,其平均性能得分已经超过了70亿、130亿参数量的Mistral和Llama 2,在部分基准测试中也超过了拥有32亿参数规模的谷歌Gemini Nano 2。

所以虽然Apple Intelligence的大模型参数量是落后的,但现在也不能下结论它就一定比参数量大的模型差,最终体验怎么样还是要等真正体验之后才能下结论。

苹果表示,Apple Intelligence的大部分功能将在今年秋天正式开放,并且初期只能使用英文语言,整合的云端大模型技术也是来自于ChatGPT。

后续开放其他语言支持后,ChatGPT大概率没办法在国内直接使用,此前就有消息称国内的合作厂商应该会在文心一言、通义千问、混元之间进行选择,具体花落谁家,暂时还没有确切答案。

综合目前的信息,我觉得最有可能的还是文心一言。作为百度旗下的大模型技术,它在数据基础及搜索效率上有着很大的优势。再加上文心一言的中文理解能力在世界范围内都是拔尖的,苹果选择它也算是强强联合,唯一的问题是,两家公司的价值观可能需要磨合。

除此之外,Apple Intelligence最大的问题,或者说门槛就是仅支持A17 Pro或者是搭载M系列芯片的苹果产品。

虽然M系列芯片在iPad和Mac上已经使用了两三年以上,但是这两个系列产品的生命周期相对较长,目前仍然有很多使用老款产品的用户。而iPhone更是只有iPhone 15 Pro及以后的机型才能使用,那么庞大的存量用户怎么办呢?

现在看来,端侧Apple Intelligence应该是用不上了,苹果可能只会开放少数功能给老用户,毕竟有些功能对于本地算力要求较高,硬件跟不上反而会造成异常卡顿,影响使用体验。

对于用户而言,如果你目前正在使用iPhone 14系列以前的手机,以及非M芯片的iPad/Mac,同时又比较看重AI对于生产力和效率的提升,那么Apple Intelligence更新推送时,就是换机的好时机。

而对于苹果来说,近几年用户换机周期延长,部分产品销量下滑的局面,可能也会因为Apple Intelligence的到来,而出现转机。

回顾之前的每次系统版本更新,苹果都是为其加入一些新功能,让设备变得更加好用。而近几年的几大系统升级,也因为已经迭代了十几个版本,出现了“后劲不足”,AI相关的布局一直没有落地。

直到WWDC24,苹果发布了Apple Intelligence,虽然目前还没有正式上线,但从苹果现场演示的效果来看,有相当一部分功能已经实现了“后来居上”。

和Apple Intelligence相比, iOS、iPadOS、macOS等操作系统的更新,显然成为了今年的“配菜”。但也正因为有了Apple Intelligence,让它们有了翻天覆地的变化,用户使用设备的逻辑和效率都会得到质的提升,甚至说是重生也并不为过。

和其他AI不同的是,Apple Intelligence在拥有图/文生成功能的同时,还拥有强大的个性化定制能力,所以它能更懂用户,并且给出的反馈也更符合人们的需求。

再加上绝大部分功能都是在端侧运行,用户隐私能够得到最大程度的保护,这肯定也会成为未来的行业趋势——不过,短时间内也许仍然只有苹果能够做到,毕竟A17 Pro和M系列芯片的机器学习能力是其他平台暂时难以企及的。

苹果一直都领先于行业的生态系统,也让Apple Intelligence天生就能很好地调用软硬件资源,实现跨应用、跨设备的一站式交互。可以预料的是,在未来Siri也许会接管大部分操作系统的职责,用户也能通过一句话实现更多的复杂操作,彻底改变用户的交互方式。

主流媒体如何看待Apple Intelligence关于Apple Intelligence,我们在WWDC24现场也采访到了几位媒体朋友和博主,来看看他们如何看待Apple Intelligence,以及它未来对于整个行业会产生什么样的影响。

腾讯数码 吴彬

尽管还没有看到Apple Intelligence的庐山真面目,但是苹果其实已经创造了一些历史。对于苹果来说,它最大的优势在于凭借出色的硬件生态壁垒,在消费电子领域首次实现了AI的全面接入和打通,这对于其他竞争对手需要跨平台,势必会将端侧AI的体验更进一步。

另外,苹果和OpenAI的合作,其实算是开启了在“AI时代”苹果数据交换的一个先河,将OpenAI更智能的外脑引入到苹果的生态体系中,苹果可以将用户的数据做“脱敏”处理,保证隐私安全,这对于消费电子厂商做端云结合的AI,提供了一条可参考和复制的路线。

网易数码 陈功

Apple Intelligence是属于系统级的产品,这也决定了它在苹果公司的战略地位,放弃造车,转向AI,是苹果现阶段来看最正确的一步。但“把自己的智能生态,放在了人家的AI底座上”,这一点是我比较存疑的地方,虽然在沟通中苹果表示了不做大参数量模型,但我依然认为以苹果的能力,大参数量模型一定会做,但不一定现在要公之于众,或许在未来的某个节点,我们就会看到。

影视飓风 潘天鸿

我觉得Apple Intelligence其实是一个一开始觉得没什么意思,但是仔细一想,它影响会非常深远的一套AI系统,因为本质上它最核心的一点是解决了目前AI端到端、跨端的应用体验。你会发现过去的各种AI模型,即便在手机端也许凑合能用,但是当你回到手表,或者说到了电脑上,它所有的体验都是割裂的,但是Apple Intelligence却能够解决掉端之间的交互。

比如说我可以在Mac上迅速调取信息,然后在iPhone上面仍然可以进行对应的信息抓取,目前它好像还没有跨端的这个文件和App之间的信息抓取功能,但是我相信将来肯定可以做到。所以我觉得Apple Intelligence就是一个大家可能不会觉得特别震撼,但是等到它真正上市,应该都会想用,而且会特别喜欢用的这么一个生态。

极客湾 褚云飞

苹果拿出Apple Intelligence说实话算是意料之中,生成式AI已经火了两年,苹果一直都想结合进移动生态里,这倒不意外。

我比较欣赏的一点是苹果在生态上的凝聚力,它可以设计统一的AI接口标准,第三方开发者基于统一接口做开发,这样苹果AI就能汇聚整合各大应用中的零散信息,来实现跨应用的AI操作。尤其在国内,互联网大厂互相都不愿开放信息的情况下,正需要苹果来做这个“中间人”,这对于实现用户无感的AI体验很关键。

小白测评 王迥

作为苹果自己的“AI”,比较有看点的是各App内部内容的关联协同,比如提到的你修改日程,它会智能协调建议下一个日程的最佳交通方式,这需要比较强大的本地算力,端侧肯定是更安全的,同时我比较关心的是,这些功能的功耗问题,如果频繁调用会不会产生大量电耗。

不过目前遗憾的还是更新比较晚,可能秋季才能体验到,完全落地更新要到明年都说不定,这同时也说明了苹果的急迫,提前这么久画饼——我最期待的还是打通App内部信息的壁垒。

爱否科技 彭林

苹果这次全面拥抱生成式AI还是非常大胆的,因为即使是今天,生成式AI还处于随机不可控状态,很容易放大一些错误观念和负面情绪。如果仅和其他硬件厂商相比,苹果把AI放在了系统全局级入口的位置,已经是最为激进的AI应用了。

Apple Intelligence的结构很聪明,它相当于在手机本地部署了一个30亿参数量的端侧模型,来判断用户的需求指令,再决定启用哪些大模型。其中所有需要用户隐私数据的AI功能,苹果全都自己来做。

而一些超纲问题的需求,苹果巧妙的对接第三方ChatGPT这类的大模型,并且通知用户。这种结构,苹果不仅保障了AI功能的基础体验,也对外接大模型拥有了控制权,随时可以替换,为进入中国市场铺平了道路。

siri的阅读理解智商还不如一个3岁小孩,十年了都学的啥

他们一年花一年换手机可怜什么

不用期待,咱们是牛逼的文心一言

说穿了,一定有某个功能是16P才会实现,这才是刀法

哪里来的隐私?间谍手机,俄罗斯是最好的例子,[doge][doge][doge]用苹果手机直接被定位,被间谍搞死🙄🙄🙄

马斯克都说了通过open ai的[捂脸哭]

“这样的才华是真实存在的吗?”

空间照片那🉐牛成啥样啊[红脸笑]

以后手机卷的就不是硬件了,而是AI功能。

“小孩子才做选择,大人全部都要”

我确实挺希望华为搞一搞个人化ai的

苹果拿chatgpt当自己的AI元年?[大笑]

其实是OpenAI的AI [大笑][大笑][大笑]

开发者自己设计的广告和苹果有啥关系?

用安卓系统的或者用ios的,也得逮捕

我双持,ios 的快捷指令真的好用,安卓真的没那

不应该是iPhone 16pro吗?秋季还玩iPhone 15lro

你安心用你的安卓。人家咋样跟你没关系。

第三方app都有广告,很多还自带跳转

不出意外的话国行用的是文心一言,还是继续使用浏览器使用GPTbiz吧,千问也行啊,真是服了

史诗级更新不知道吗?

你的下一台电脑还得是电脑