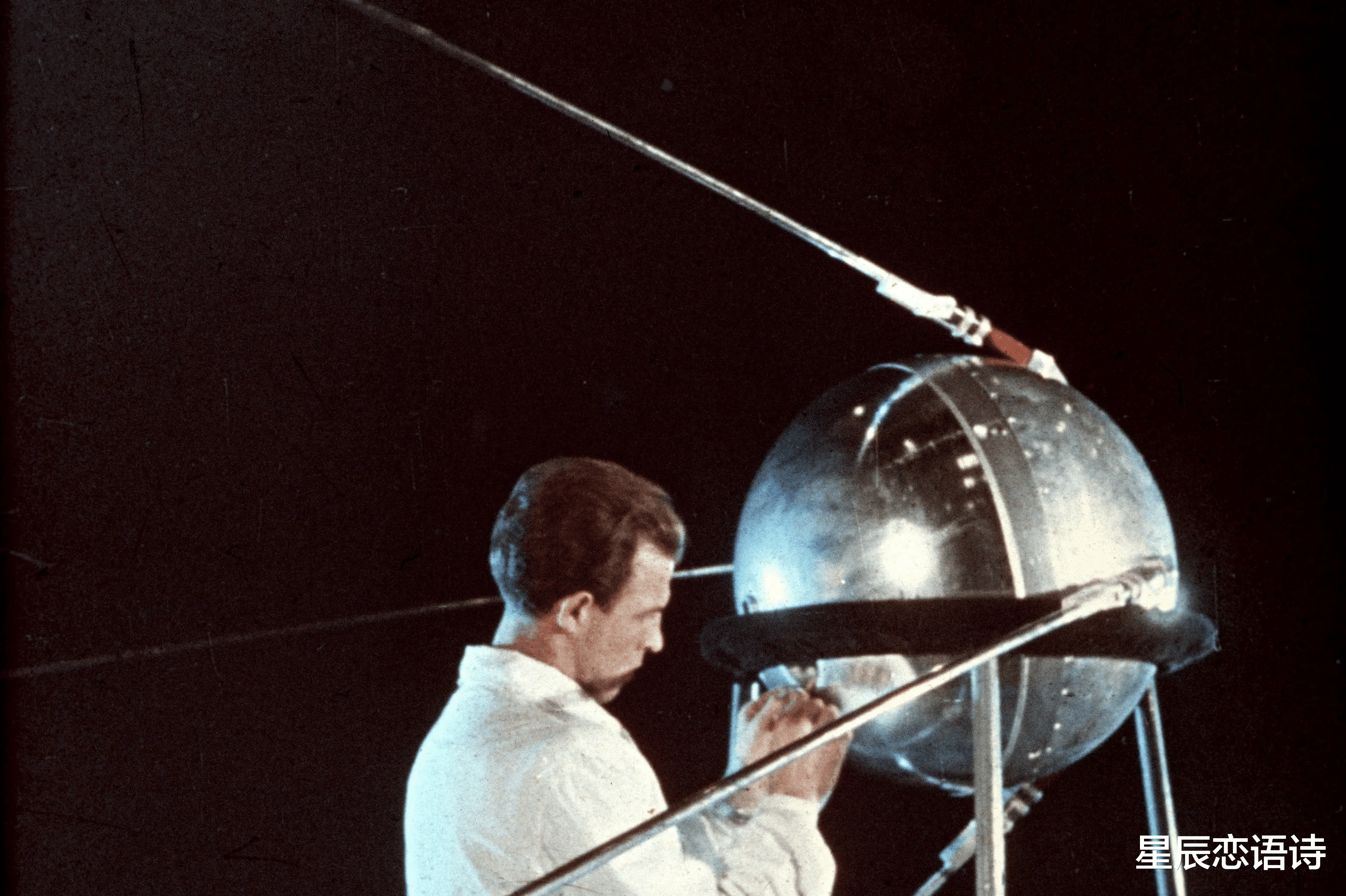

哎,最近DeepSeek火得一塌糊涂,它到底凭啥?据说跟ChatGPT-4有的一拼,甚至某些方面还更强!这可把硅谷和华尔街都吓坏了,不少人直呼这是AI界的“斯普特尼克时刻”!这到底是怎么一回事呢?咱们来扒一扒。

DeepSeek这小子,厉害就厉害在它又快又省!训练成本比OpenAI那些大佬低了20到50倍,用到的计算资源也少得多。想想看,这就像是用同样的材料,却造出了更精巧更便宜的产品,这谁顶得住?它这效率,让很多中小企业也能用得起AI,可不是只有谷歌、微软这些巨头才能玩了。更绝的是,它还开源!白送给你用,还能改!这简直就是AI界的“大放送”嘛!你说,谁还愿意花大价钱买那些闭源的?这等于直接降低了AI技术的门槛,逼着那些老牌公司也得跟着降价,甚至得改改他们的赚钱模式。效率高、开源,这两个就是DeepSeek的秘密武器!

那它到底是怎么做到这么高效的呢?其实啊,这得从AI模型的原理说起。像ChatGPT,它核心就是一个“大语言模型”,简单来说,就是个超级强大的“猜词机”。它看过无数的文本,知道哪些词经常一起出现,你输入“今天天气很”,它就能猜出接下来可能是“热”或“冷”。这“猜词”的本事,就是通过深度学习练出来的。 深度学习就像教一个小孩玩填空游戏,反复训练,它就能学会语言的规律,甚至自己写文章。除了基础训练,还得让人“手把手”教,不断优化。DeepSeek的R1模型,在这基础上又往前走了一步。它用了一种叫“早期推理模型”的办法,把复杂问题拆成小块,一个个解决。这就像盖房子,先做好一个个零件,再组装起来,省时省力。传统方法做这些,算力消耗会很大,但DeepSeek通过优化算法和训练流程,用更少的算力,达到了同样的效果。

美国不是卡我们脖子吗?DeepSeek是怎么绕过去的?这其中妙招还真不少。它用的是英伟达的H800芯片,这芯片就是为了绕过出口限制而设计的。它还用上了亚洲最大的AI芯片集群之一,还有很多云端的计算资源。这些资源,让它能做大量实验,找到更高效的训练方法。而且,它还用“合成数据”来训练模型,减少了对外部数据的依赖,既省钱又灵活。再加上国家对AI的大力支持,以及国内巨大的市场需求,DeepSeek才能这么快发展起来。美国那些AI公司,技术虽然领先,但成本太高,竞争也激烈,这差距,可不就出来了嘛!

DeepSeek的出现,说明中美AI竞争进入新阶段了。虽然还不能完全“干翻”美国,但已经打破了“美国AI不可超越”的神话。 它的开源策略和低成本,很可能会逼着美国公司调整策略,甚至引发价格战。但这把双刃剑,既能加速技术创新,也可能让一些公司倒霉。

未来中美AI竞争,大概率会是这么个情况:技术上,会是“双轨制”,美国在高端芯片和基础研究上领先,中国在应用场景和成本控制上发力;开源和闭源会继续博弈;地缘政治的影响也会一直存在;AI应用会走向全球化。DeepSeek的开源模型,不仅服务中国,还能惠及全球用户。

所以说,DeepSeek这事儿,还真挺让人激动。它让我们看到了中国AI的潜力,也让我们意识到,中美AI竞争,最终比拼的还是创新和合作,让AI更好地服务全人类。 这年头,不管是斯普特尼克还是DeepSeek,最终都是为了推动人类科技进步,而不是制造对抗。